基本思路

看来很多逻辑回归的教程,很难理解,自己想梳理一下知识点。

逻辑回归虽然带有“回归”的字样,实际上是一种分类算法,但是使用了回归的思想来解决分类问题。既然是分类,也就是使得X的取值不同,Y取值0或者是1。但是逻辑回归如何通过X的取值来判断Y是0还是1,具体分类的思路可以这么理解:

我们重新先了解设置一个函数,使得:

这个函数就叫做Sigmoid函数,该函数的图像如下:

在图中sigmoid函数取值在(0,1),而且关于(0,0.5)中心对称,如果把它看成概率,我们就想,如果设置一个函数使得:

而且在z取值不同的时候,Y的对应关系为:

所以X和Y的关系结果就是这么的出来的:

让z=wx+b,再根据f(z)的不同取值和0.5比大小来确定Y是为1还是为0.

关键点是w如何确定,因为w确定了自然预测模型就定了,那么如何确定w的取值好坏,我们确定w最终是为了得到预测模型,所以转而变成寻找确定预测模型的好坏的指标,在这里使用逻辑回归的损失函数来确定。

损失函数

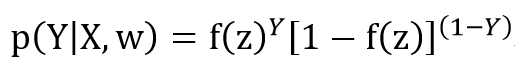

我们根据上文可知如下关系:

现在将两个式子统一成如下形式:

我们使用最大似然估计发来得出参数w,变成如下的式子:

一般连乘的式子我们选择对其求 对数进行变型,最后两边求对数,变成 了如下的式子:

其实我们是未来找到使得L(w)最大的式子,也就是找使得ln(L(w))最大的w,我们希望找到的损失函数应该是求最小值,所以令J(w)=-ln(L(w))就是,所以最终求得的损失函数目标函数值为:

我们希望找到一个w使得J(w)最小即可

如何更新w

对于如何快速找到想要的w,使得J(w)的最小值赶快出现,我们使用梯度下降法。梯度可以理解为函数的导数,也就说函数下降最快的方向就是梯度的负方向,这个很好证明,不再详述。

所以,如果一开始寻找的w不合适,如何确定下一个w?如下方法:

其中α是决定w沿着梯度下降的程度,也是更新w的关键,所以在使用梯度下降法的时候α的确定是关键,因为导数有如下关系:

所以更新权重的式子如下:

当找到合适的w,我们的逻辑回归模型也就确定了,自然就可以利用这个模型根据给定的x值来预测Y的取值了