迁移学习之物体定位与检测下

目标检测

当输入一张图片,图片包含几个类别的几个对象,需要找到每个对象的边界框。如下图:

能否将目标检测当成回归问题?对于不同的图片输出的多个对象的边界框,可能输出4个边界框也可能输出8个边界框,输出的数量不固定,所以无法当成是回归问题。

将其当做分类问题:把图片的一部分输入到CNN中,对其进行分类和定位。比如

输入的大小是怎么确定的?将其从小到大全部试一遍。显然这样的方法是很耗时的,于是提出了Region proposal,即输入一张图像,给出目标可能在的全部区域。Region proposal的一种是selective search,该方法是从像素触发,把具有相似颜色和纹理的相邻像素合并,最终得到几个边界框。

R-CNN

思想:通过selective search的方法得到一个图片的几个框,然后将这些框调整成固定的大小输入的cnn中,cnn连接到一个svm分类和一个定位网络中。结构如下图:

训练过程

训练过程比较复杂。

- 训练或者下载一个好的分类模型

- 对分类模型进行微调,使得它可以用于检测。因为原分类网络是对1000类图像分类,而检测包含许多不同的类别,而且图像的统计特性也不一样,需要在网络后面加上新的几层来处理类别。

- 提取特征:对于每一种图像运用selective search算法提取出区域,然后存起来。

- 训练SVM,让它可以对提出来的区域进行正确分类。这里训练的是二分类SVM,判断区域中是否包含对象,注意是对不同的类别训练不同的分类。

- 对边界框进行回归:有时候region proposal得到的区域框可能有些问题,我们希望从存储的region proposal的区域框回推到正确的区域框。如下图region proposal得到的区域框存在一些问题,我们希望将其更正。

目标检测的数据集

评估方法:

- 平均准确率(0-100)

- 得到的边界框与正确的边界框去查不超过0.5

上图是R-CNN的结果,相比于DPM和Regionlets,R-CNN效果有提升,加上bbox reg的R-CNN又有提升,将AlexNet换成VGG后效果又有很大提升。

但R-CNN有很多问题:

- 测试时效果很慢:每个区域都要运行一次R-CNN

- SVM和回归都是离线训练的,R-CNN没有办法按照响应的网络的目的进行升级。

- 训练流程有些混乱

fast R-CNN

思想:将整个图像输入到卷积层,得到卷积映射,对卷积映射使用region proposal方法的区域,然后在经过ROI pooling层,在放入全连接层。流程如下图:

这里解决了R-CNN测试很慢的问题,因为fast R-CNN对不同的区域都共享了一个卷积层,如下图:

fast R-CNN也解决了R-CNN中训练过程混乱的问题,因为fast R-CN是可以整个网络一起训练的。

fast R-CNN的特殊技术:regionof interest pooling

将整个图像输入到卷积层得到高分辨率卷积特征,但是全连接层希望得到低分辨率卷积特征,于是提出了以下解决办法。

(1)将给出的边界框从输入图像投影到卷积特征中去。

然后把目标框投影过去的卷积特征分割成h*w小块,对每一个小块进行max pooling

对比R-CNN和fast R-CNN:

fast R-CNN速度更快平均准确率更高。

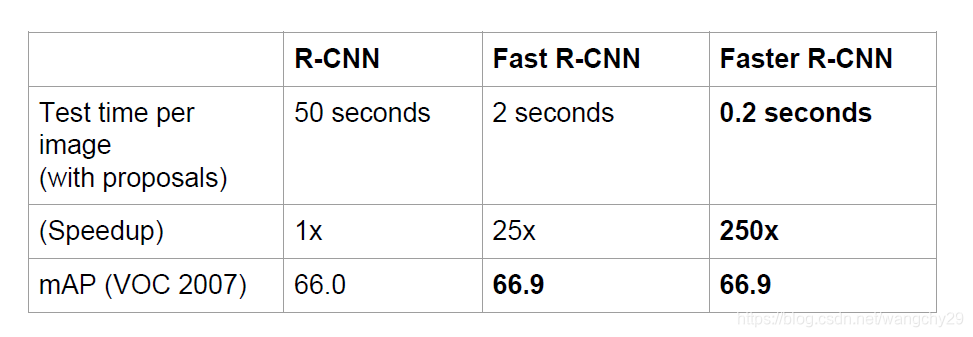

但是fast R-CNN测试时间没有包含region proposal的时间。考虑到region proposal的时间:

速度优势就不是特别明显了,只提升了25倍。

为了解决这个问题,人们就提出卷积神经网络既然可以分类和定位,为什么不能用卷积神经网络来完成region proposal?于是突出了faster R-CNN。

faster R-CNN的过程与fast R-CNN类似,只是用一个区域推荐网络代替了rgion proposal算法。

faster R-CNN的区域推荐网络

首先对特征映射采用滑动窗口的方法进行卷积,然后输入到两个网络一个用于区分当前区域是否包含目标对象,给出包含目标对象的概率,另一个网络用于回归语气的四个参数。 其滑动窗口的大小和形状如下,有n个窗口,所以分类网络会得到n个分数,回归网络会给出4n个参数。

整个faster R-CNN的网络结构:

训练方法:论文给出的是先训练区域推荐网络在训练整个faster R-CNN,实际上是整个网络同时训练,损失函数包含四部分:区域推荐网络的分类损失和回归损失,faster R-CNN的分了损失和回归损失。

结果如下图: