这是一门关于计算机视觉的课程,基于一种专用的模型架构,叫做神经网络(更细一点说,是卷积神经网络CNN)。计算机视觉是人工智能领域中发展最为迅猛的一个分支,是一个与很多领域紧密关联的学科。

视觉信息,或者叫像素信息是最难被利用的信息,可以把它称之为“互联网中的暗物质”。

我们现在面对的问题:非常大量的数据,以及这些“暗物质”的挑战。我们面对的问题,我们使用的建模(方式)也是跨学科的

卷积神经网络结构是为了解决识别问题的需要而出现的,之后,识别问题又促进了深度学习的进化,如此反复。

基础视觉区的神经元是按一列一列的组织起来,每一列神经元只“喜欢”某一种特定的形状,某种简单的线条组合。

1966年是计算机视觉的诞生年。

视觉处理流程的第一步,是对简单的形状结构处理,边缘排列。

边缘决定了结构。

DavidMarr写了一本非常有影响力的书,视觉是分层的,第一层应该是边缘层;接下来一层为2.5D,这里你将2D的图像信息调整为包含真实世界的3D信息。以对简单的形状结构处理开始,但是没有告诉我们告诉我们以那个结束。

计算机视觉领域非常核心的问题:我们会有遮挡问题。

感知分组是视觉领域最为重要的问题,如此基础的问题并没有完全的被解决。

ImageNet有5000万张图片,全部都是人工清洗过得,标注了超过2万个分类。

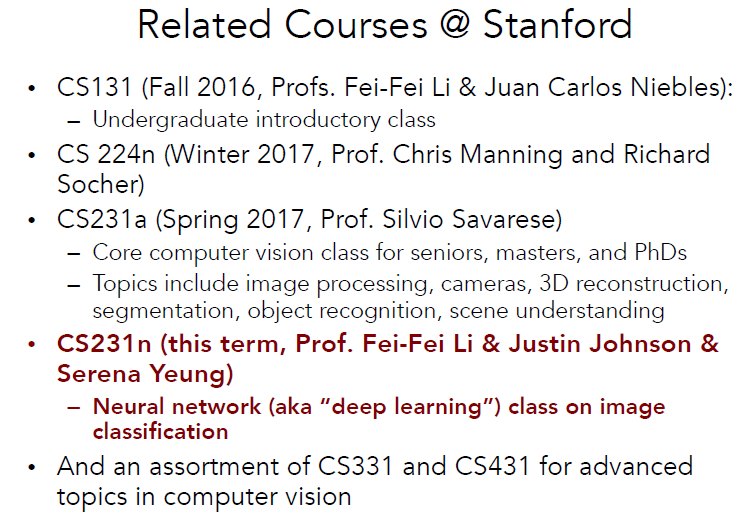

CS231n将聚焦于视觉识别问题,图像分类关注的是大图整体;物体检测告诉你东西具体出现在图片的哪里以及物体之间的联系是什么之类的。

CNN是深度学习架构的一种,2012年之前的imageNet,都是特征+支持向量机的,也是分层结构,但没有端到端的特征;

KunihikoFukushima提出了一个模型,称为Neocognitron,是神经网络架构的开端。

数据本身并没有什么意义,但是在深度学习架构中,数据成了高性能架构的驱动力,来执行端到端的训练,帮助解决过拟合问题,只要有足量的数据。

愿景:给电脑一张图片,电脑可以输出描述性文字(一句话之类的)。

卷积神经网络(CNN)也叫做convnets

ImageNet中算法的更新历史:

2011年 Lin:层次化,特征——>局部不变特征——>池化——>多层处理——>线性SVM (还是检测边缘)

2012年Hinton :7层卷积神经网络(AlexNet)

2015年:Google的GoogleNet和牛津大学的VGG网络(19层),微软亚洲研究院的残差网络512层

卷积神经网络最早是Yann LeCun等90年代在Bell实验室提出来的,98年利用网络进行数字识别,支票、邮编,这个网络与2012年的Alexnet相似。90年代为什么没有流行起来,是因为关键技术的突破:

计算能力的大幅提升(GPU)

大量标记好的数据集

大数据的处理能力