版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/Solo95/article/details/86514357

整理并翻译自吴恩达深度学习系列视频:序列模型第一周,有所详略。

Recurrent Neural Network

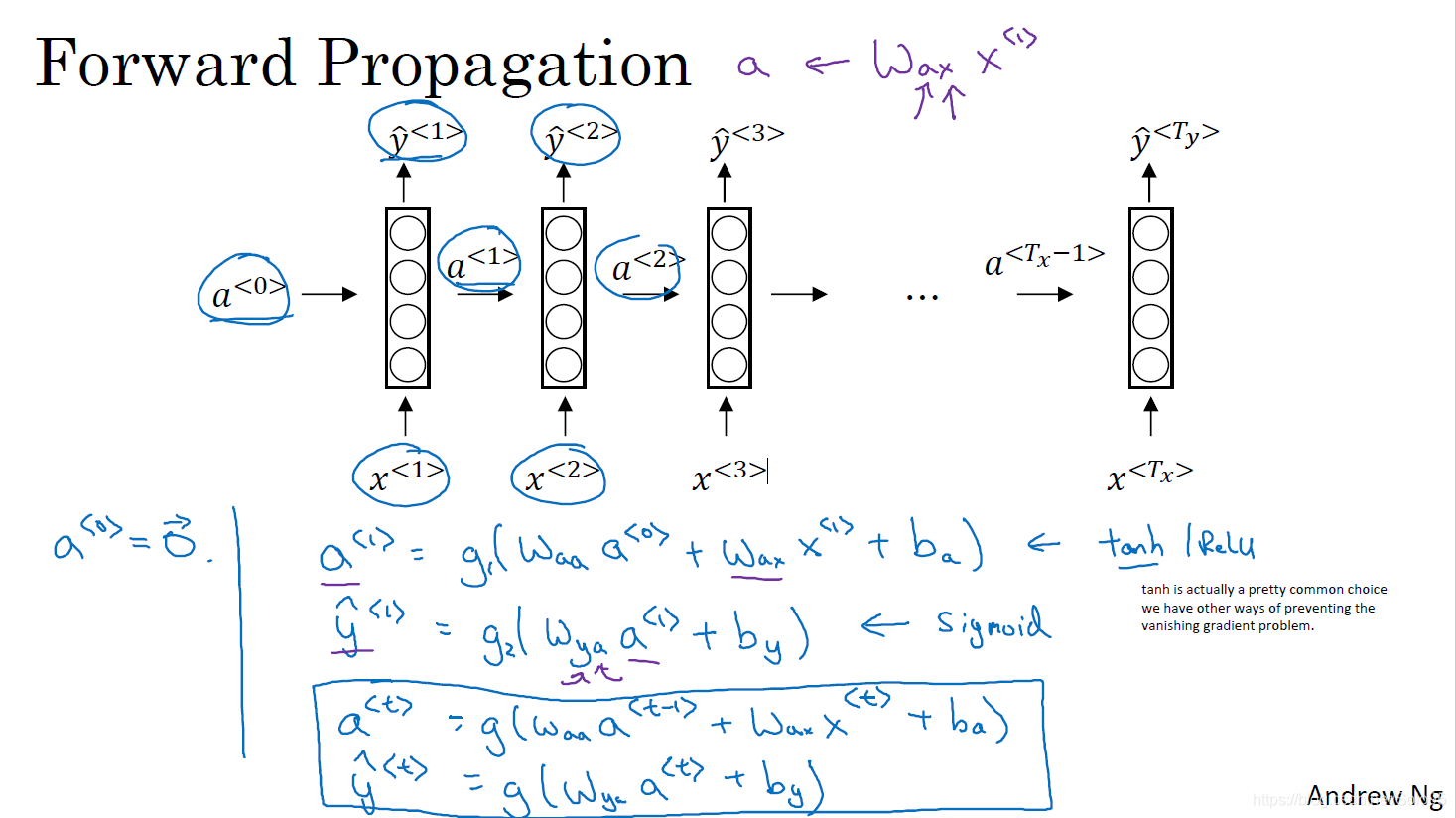

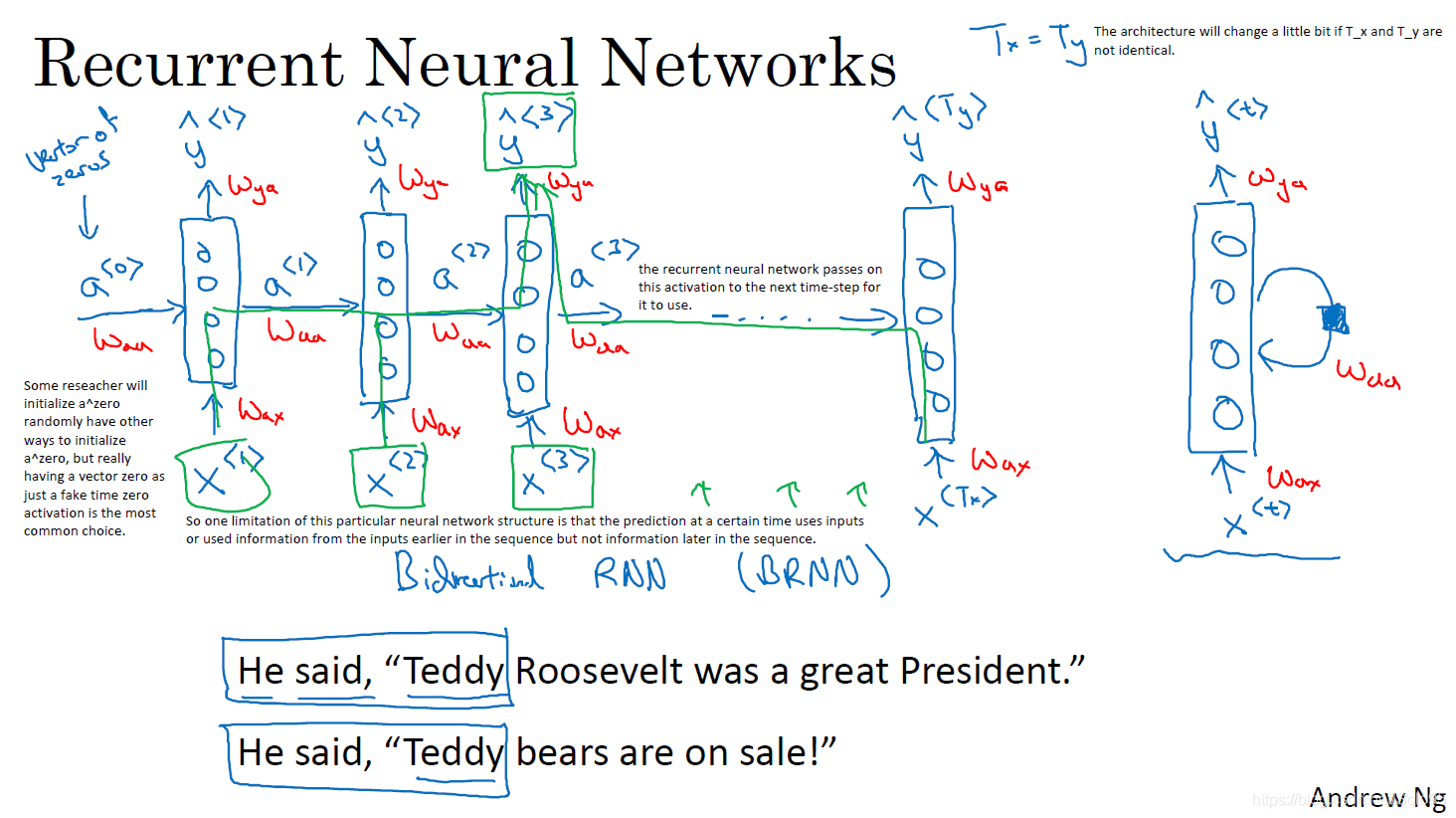

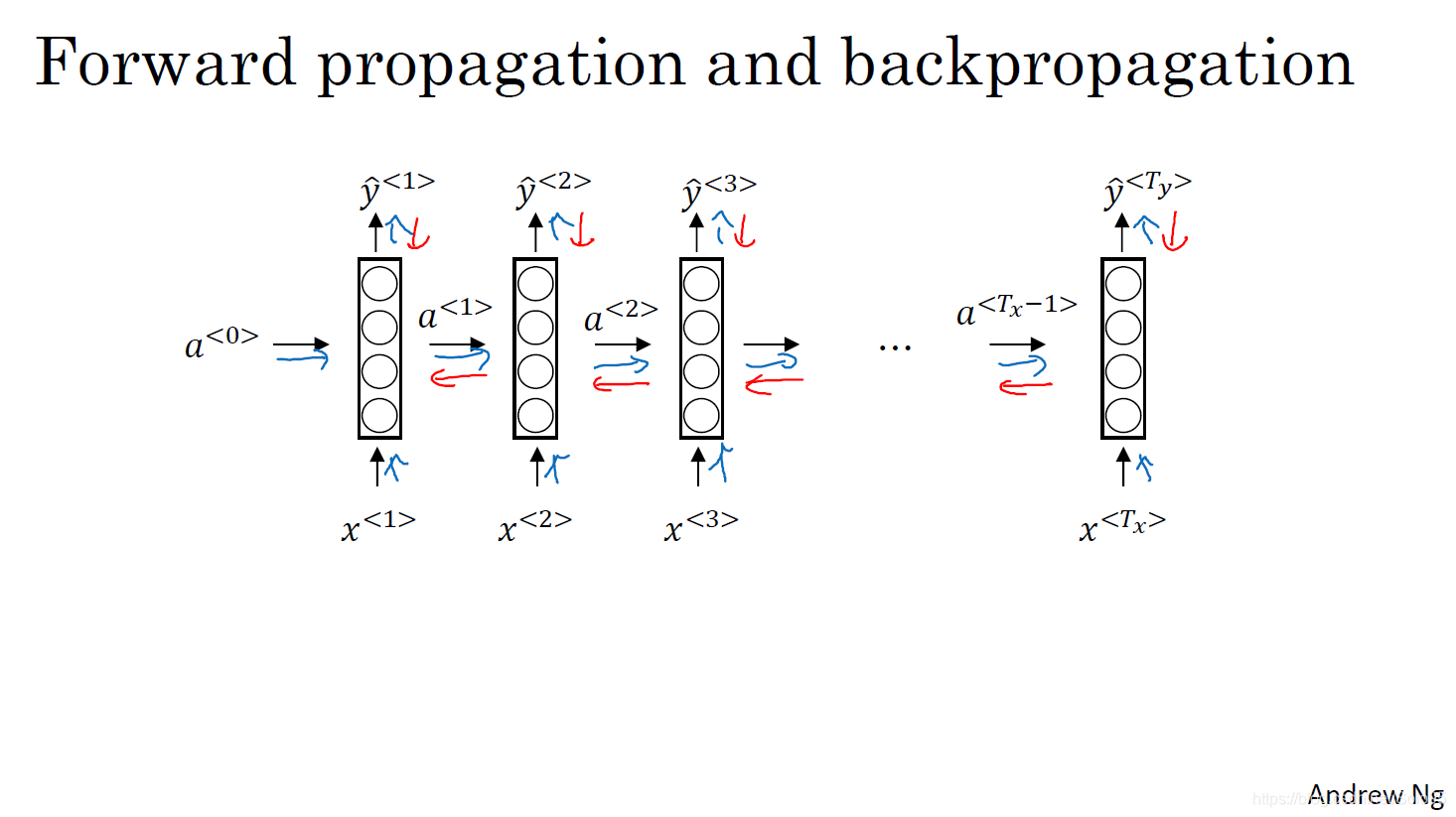

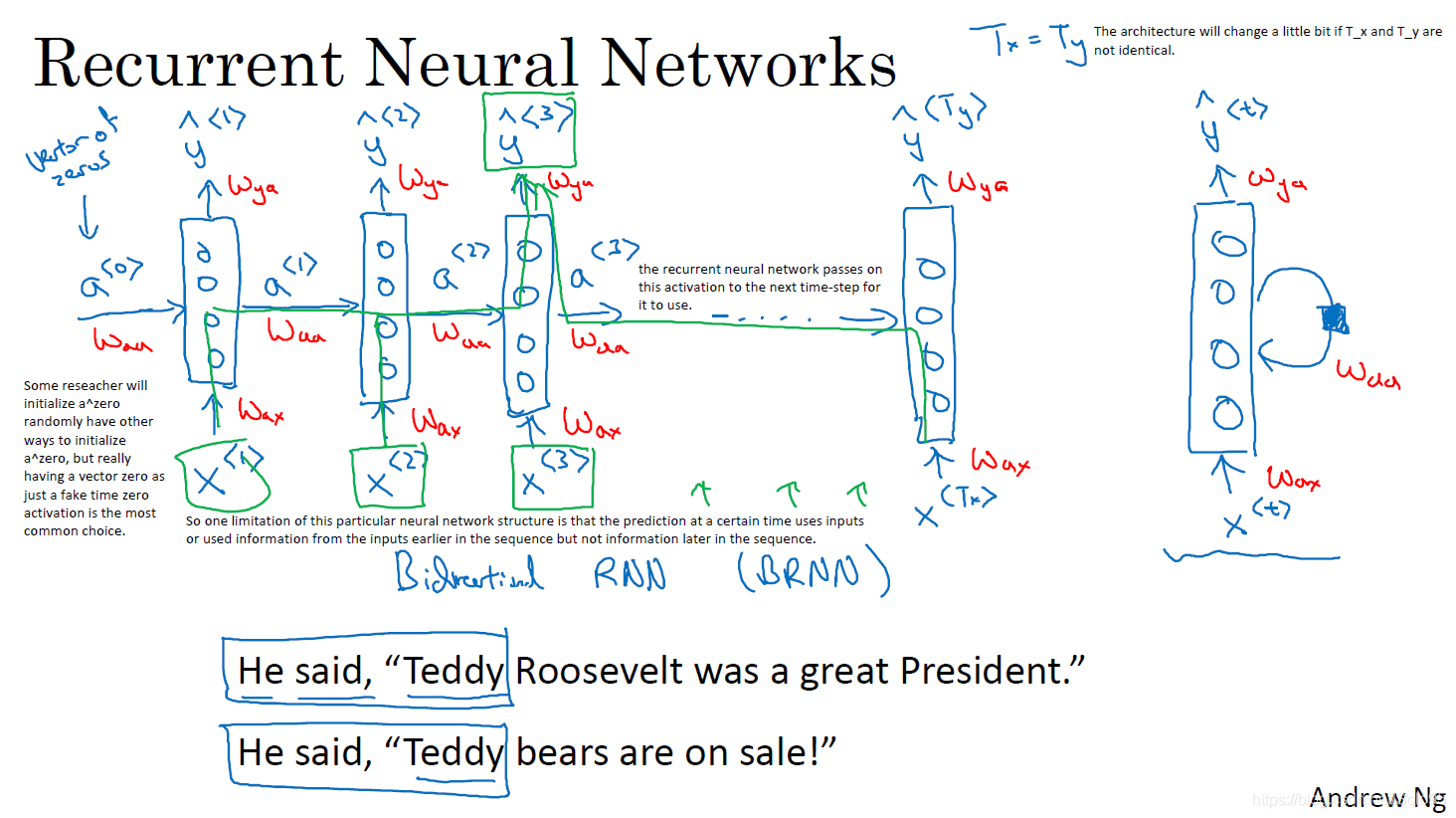

一个标准的循环神经网络如图所示,在网络的每一个时间步

t,它接受前一层的激活函数值

a<t−1>和输入

x<t>, 使用权值矩阵使用

Waa和

Wax计算

a<t>,使用结果

a<t>和权值矩阵

Wya计算

y^<t>,计算方法如第二小节。

一个标准的循环神经网络如图所示,在网络的每一个时间步

t,它接受前一层的激活函数值

a<t−1>和输入

x<t>, 使用权值矩阵使用

Waa和

Wax计算

a<t>,使用结果

a<t>和权值矩阵

Wya计算

y^<t>,计算方法如第二小节。

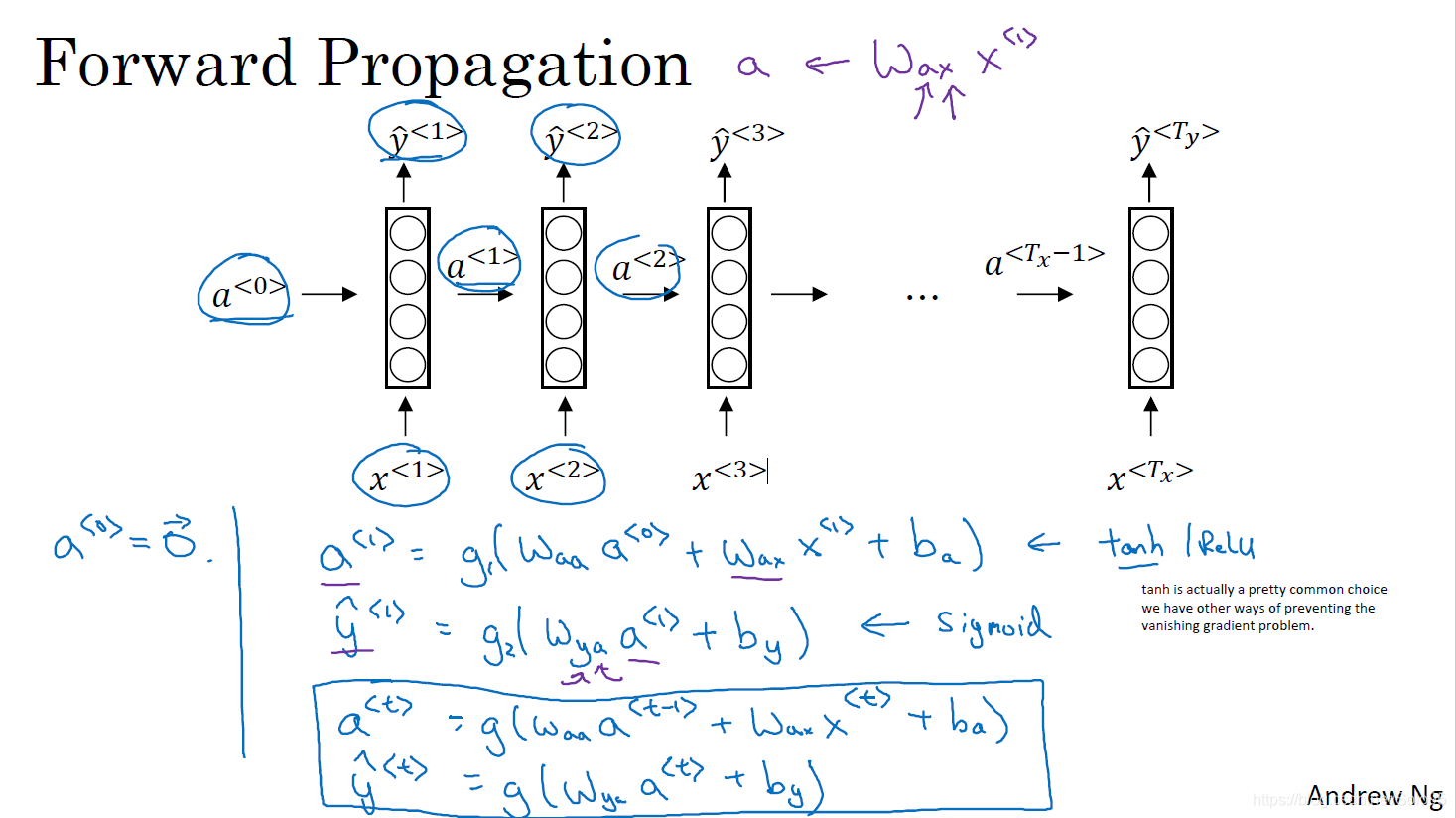

Forward Propagation

可总结为以下:

a<t>=g1(Waaa<t−1>+Waxx<t>+ba)

y^<t>=g2(Wyaa<t>+by)

g1可以使用

tanh、

ReLu,

g2可以使用

sigmoid。

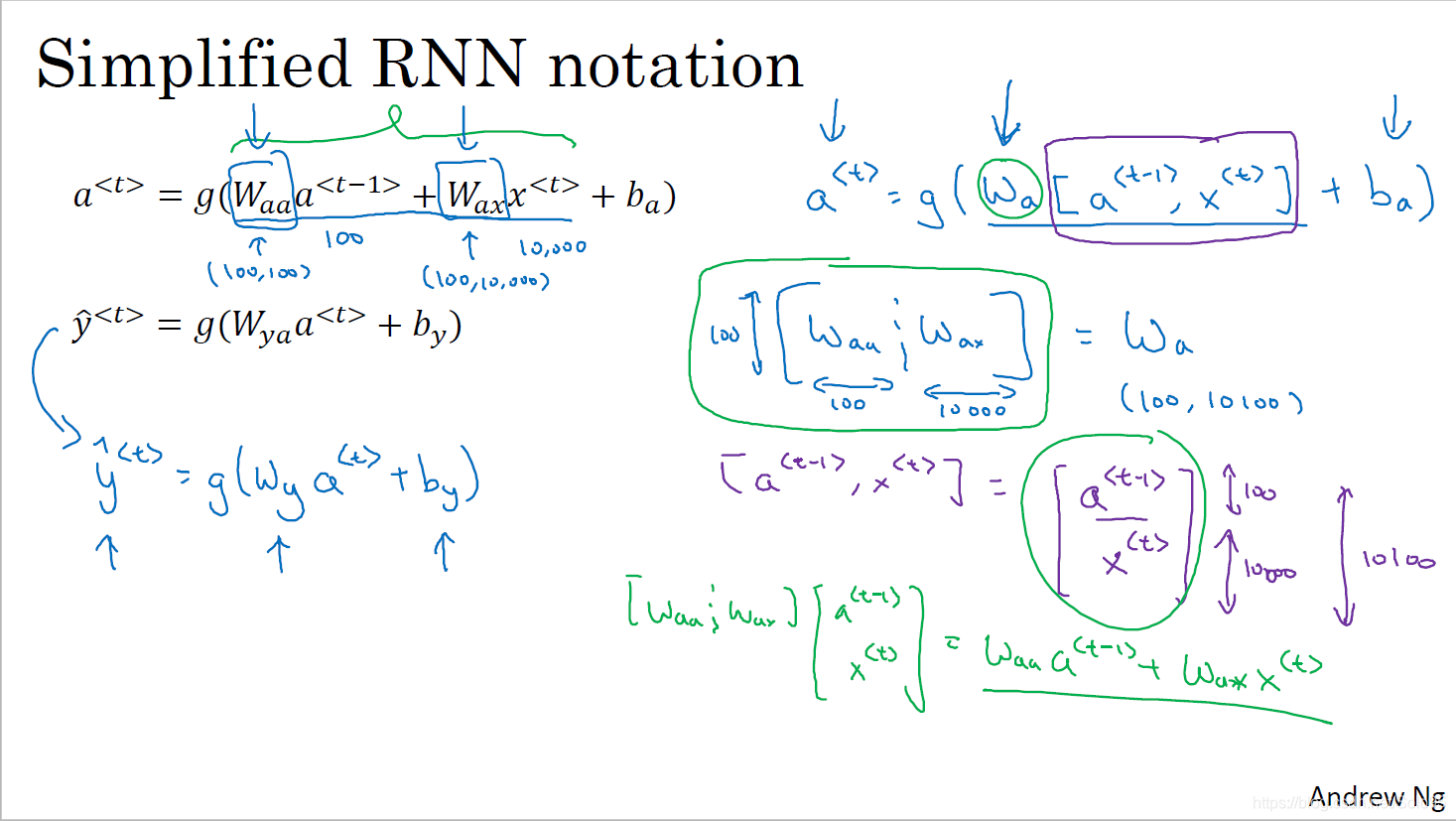

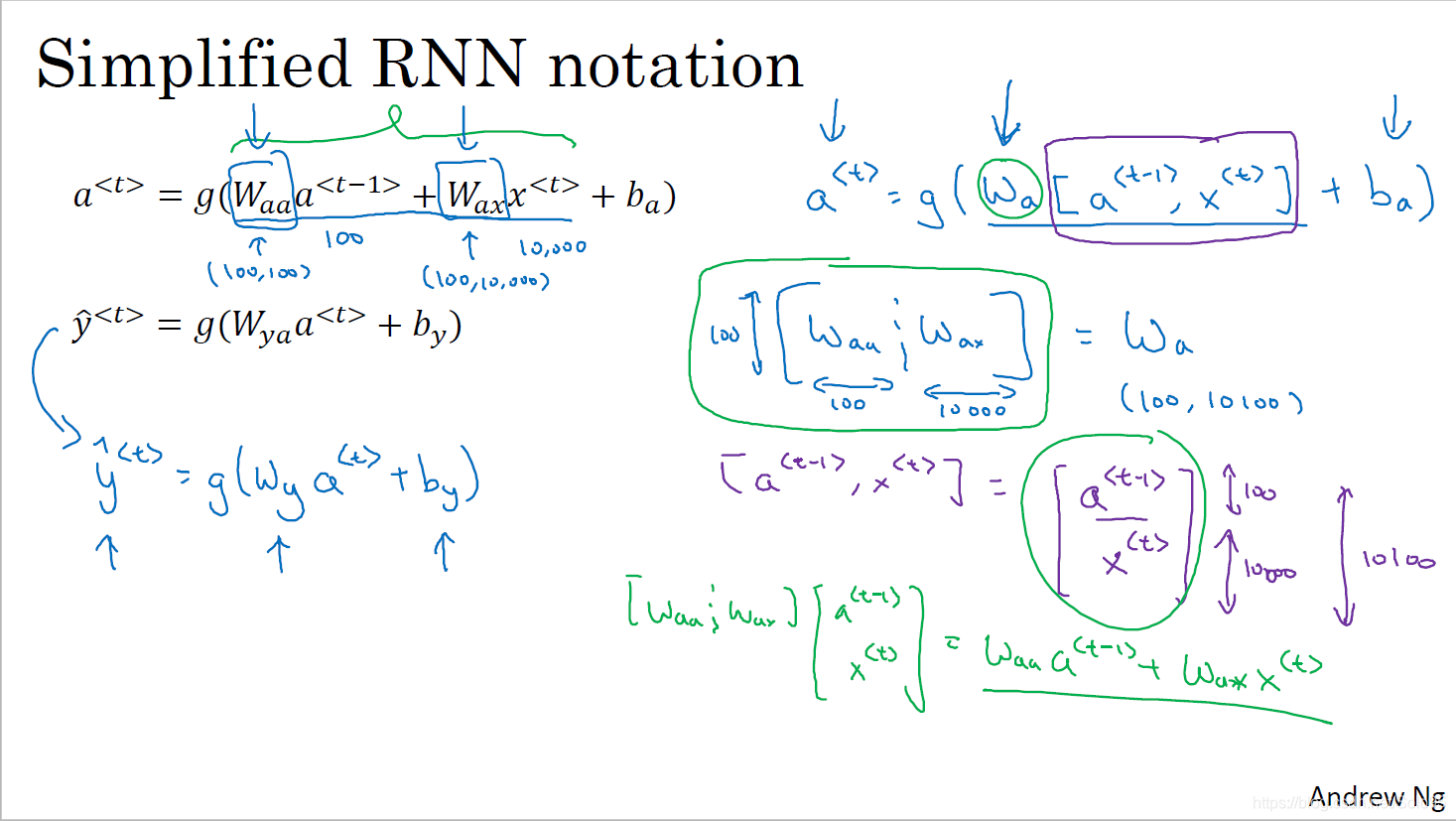

上图右边是向量化版本的实现,它将两个参数矩阵横向堆砌成

[Waa∣Wax]构成

Wa,将两个输入纵向堆砌成

[x<t>a<t−1>](横线表示分隔符不是除法)。

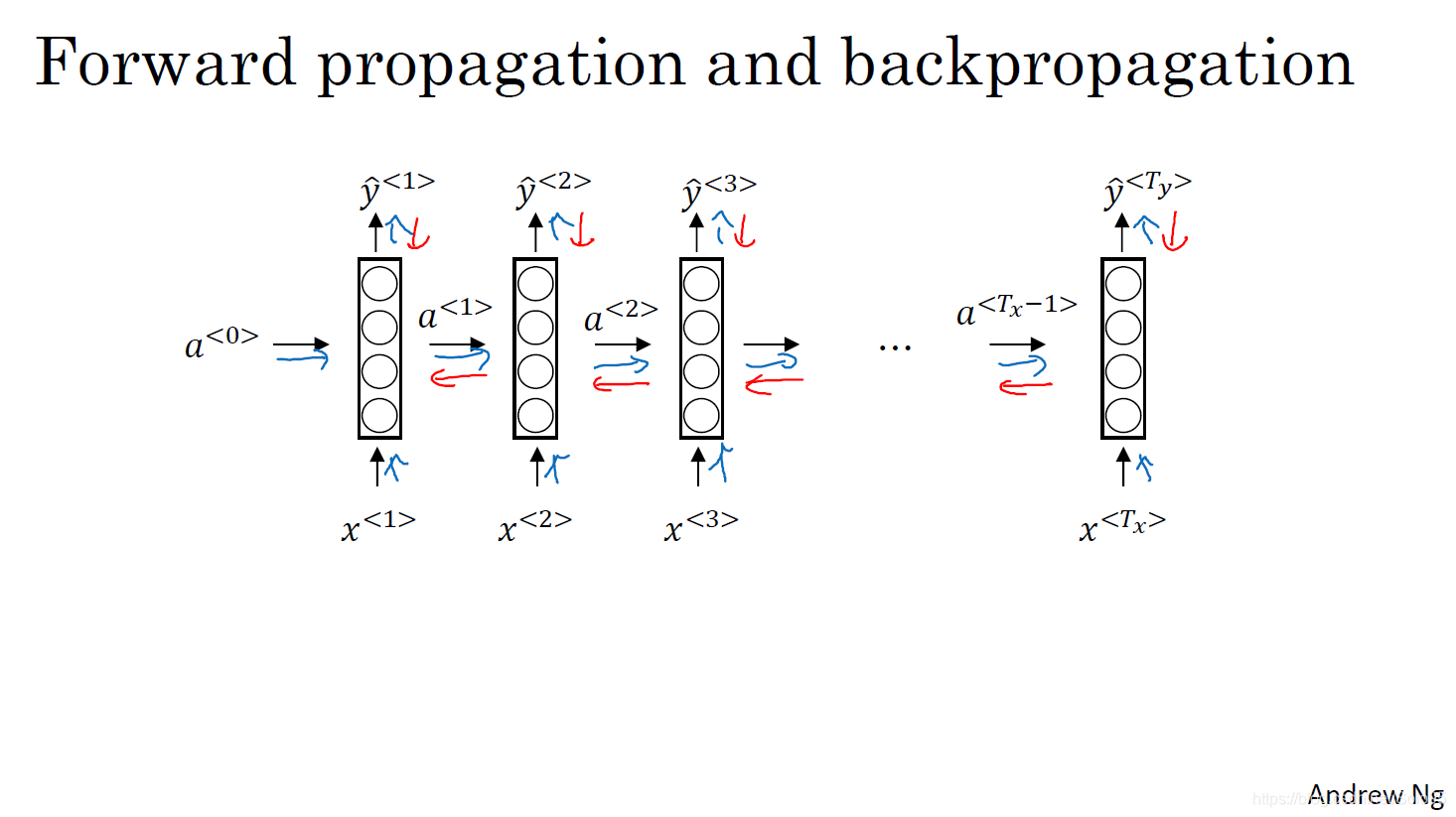

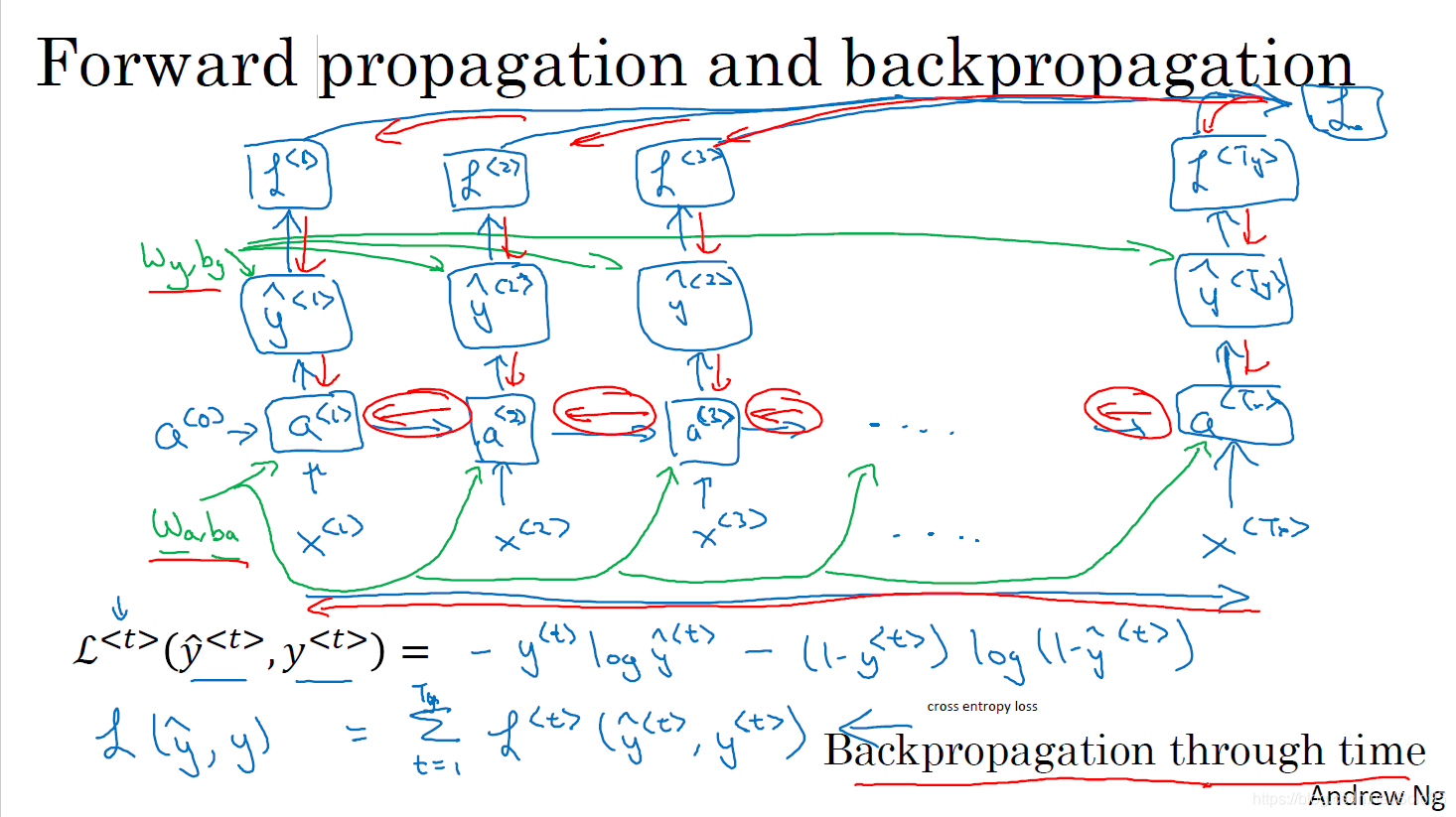

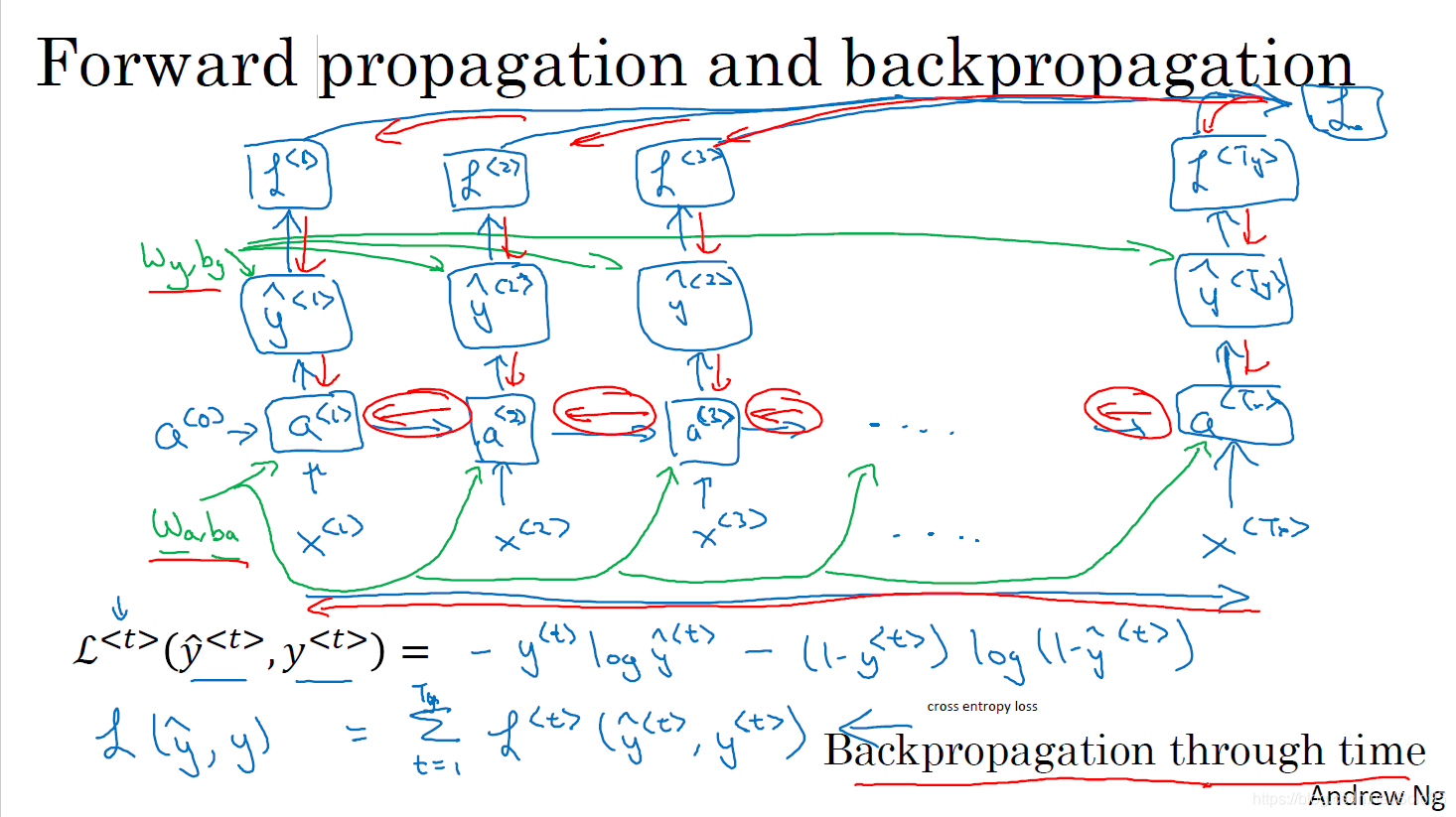

Backward Propagation

循环神经网络的反向传播同其他网络一致,按反方向计算导数,编程时框架会自动帮我们处理反向传播,但了解其基本原理也是有助益的。

如上图所示,需注意,每一个横向上的参数矩阵是共享的,

Wy、by用于每次计算

y<t>^,

Wa、ba也用于每次计算

x<t>。

其损失函数使用的是交叉熵(cross entropy loss)。

L<t>(y^<t>,y<t>)=−y<t>logy^<t>−(1−y<t>)log(1−y^<t>))

L(y^<t>,y)=t=1∑TL<t>(y^<t>,y<t>)

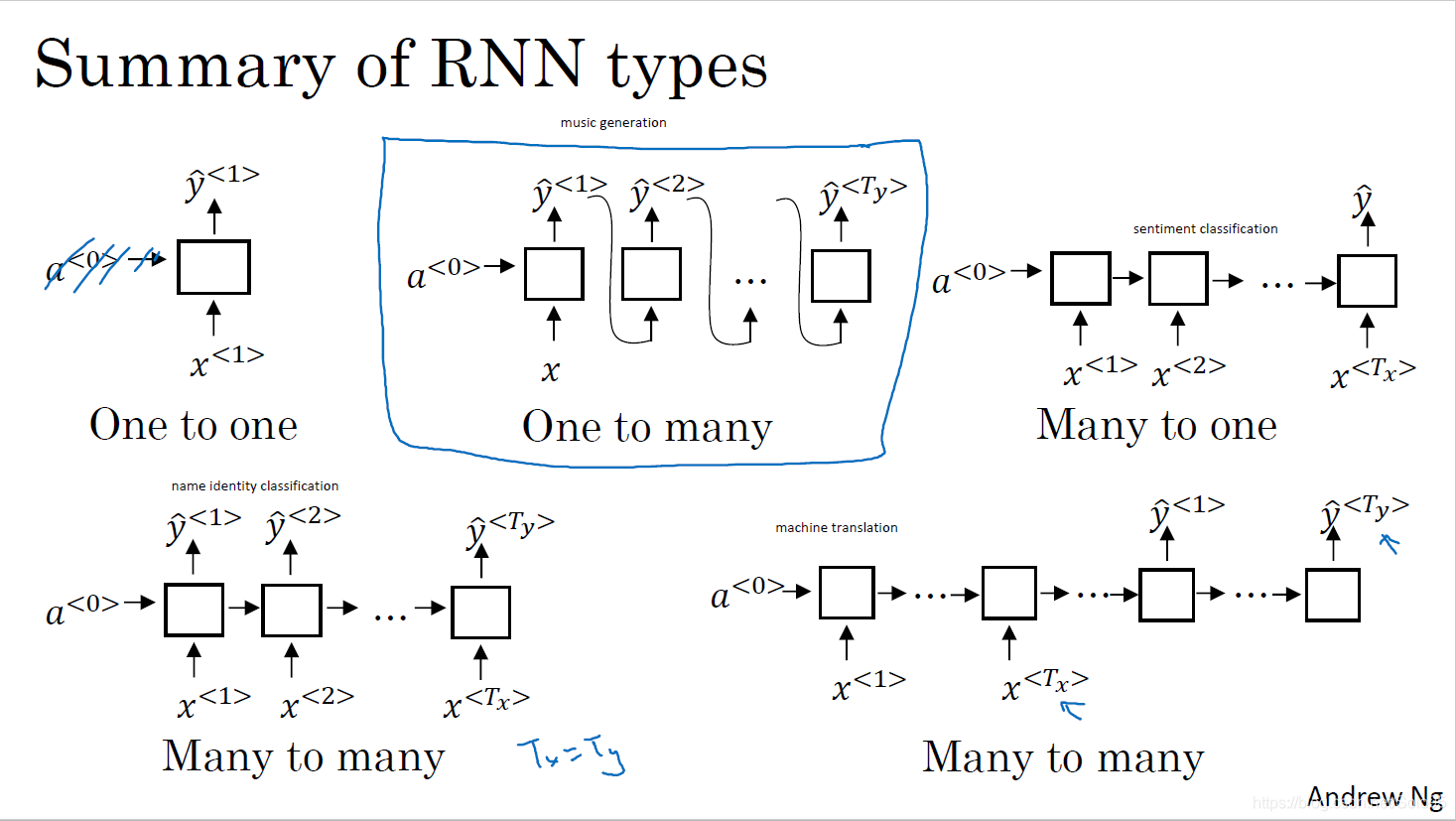

其他种类的RNN

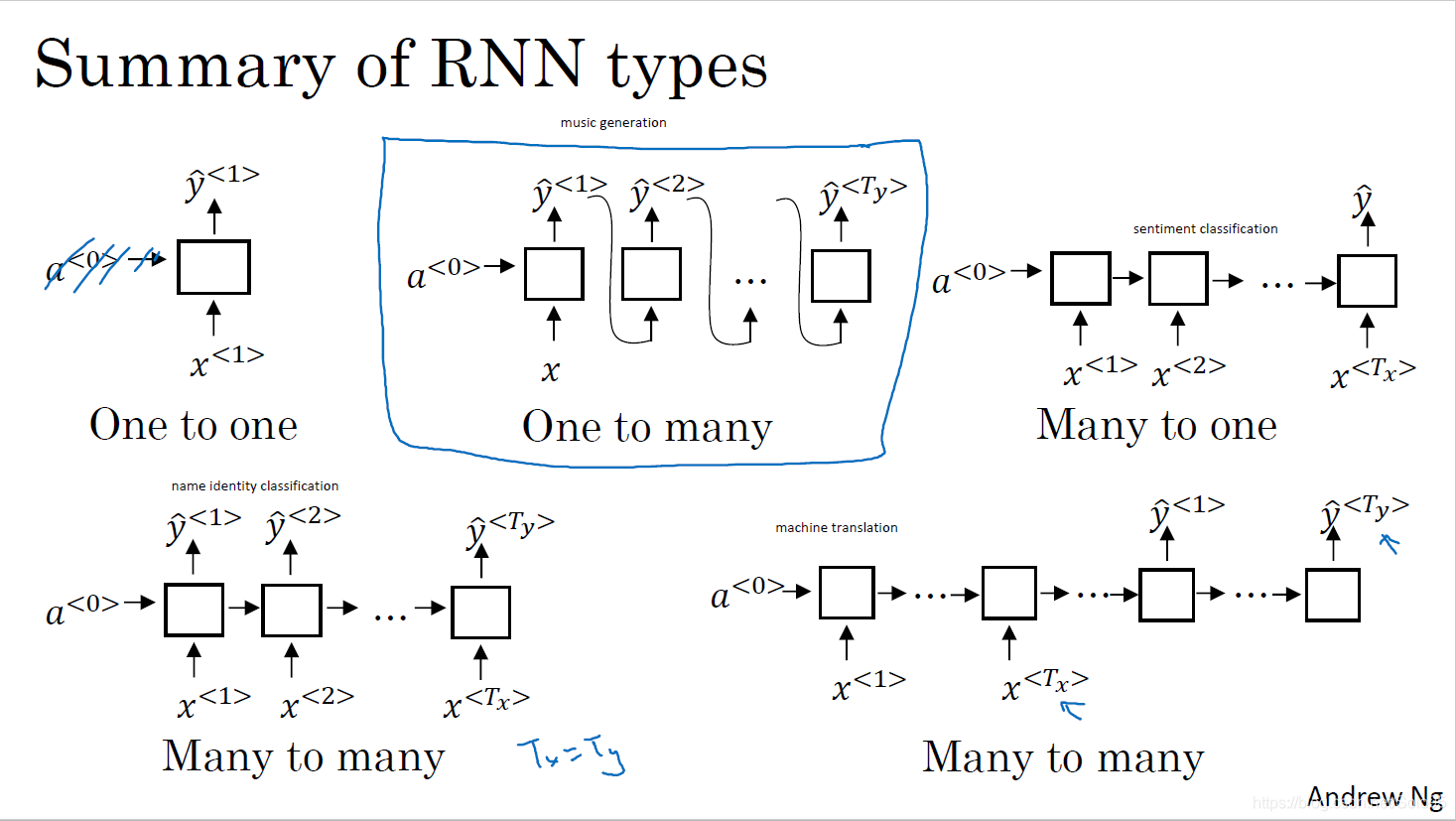

根据输入和输出的对应关系,RNN有图示几种结构,即一对一、一对多、多对一、多堆多。

一个标准的循环神经网络如图所示,在网络的每一个时间步

,它接受前一层的激活函数值

和输入

, 使用权值矩阵使用

和

计算

,使用结果

和权值矩阵

计算

,计算方法如第二小节。

一个标准的循环神经网络如图所示,在网络的每一个时间步

,它接受前一层的激活函数值

和输入

, 使用权值矩阵使用

和

计算

,使用结果

和权值矩阵

计算

,计算方法如第二小节。