感知机介绍

感知机是一个二类分类的线性分类器,是支持向量机和神经网络的基础。感知机假设数据是线性可分的,目标是通过梯度下降法,极小化损失函数,最后找到一个分割超平面,可以将数据划分成两个类别。

使用感知机一个最大的前提,就是数据是线性可分的。这严重限制了感知机的使用场景。它的分类竞争对手在面对不可分的情况时,比如支持向量机可以通过核技巧来让数据在高维可分,神经网络可以通过激活函数和增加隐藏层来让数据可分。

感知机模型的函数

如果我们有m个样本,每个样本对应于n维特征和一个二元的类别输出:

x(i)=(x1(i),x2(i),…,xn(i)),y(i)∈[−1,+1](i=1,2,…,m)

我们的目标是找到这样一个超平面(向量形式):

w⋅x+b=0

这个超平面将特征空间划分为两个部分:

对于

y(i)=−1的样本,

w⋅x(i)+b<0;

对于

y(i)=+1的样本,

w⋅x(i)+b>0。

如何实现上面的分类呢?

定义一个函数:

f(x)=sign(w⋅x+b)

其中

sign(x)是符号函数,

sign(x)={−11x<0x≥0

上面的

f(x)函数就是感知机模型函数。一旦学习到了w和b的值,我们就可以利用

f(x(i))来判断新的样本属于哪一类别。

使得其中一个类别的样本都满足

θ0+θ1x1+…+θnxn>0,另一个类别的样本都满足

θ0+θ1x1+…+θnxn<0。

感知机模型的损失函数

为了训练感知机模型函数的参数w和b,我们需要定义损失函数并将损失函数最小化。

如何选择损失函数?

我们首先想到的是最小化误分类点的总数。误分类点就是真实分类与其通过感知机模型函数得到的分类不一致的点。但是这样的损失函数不是参数w,b的连续可导函数,难以优化。

另一种思路就是最小化误分类点到超平面的总距离,这就是感知机模型所采用的损失函数。

空间上一点

x(i)到超平面

w⋅x+b=0的距离公式为:

∥w∥2∣w⋅x(i)+b∣

其中分母

∣∣w∣∣2即

w的L2范数(每个

wi的平方和加起来再求平方根)。

对于误分类点

(x(i),y(i)),总有

−y(i)f(x(i))>0。

这是因为假如点的正确分类为+1,而感知机将其误分类为-1时, 有

f(x(i))<0,那么再乘以

−y(i)就有

−y(i)f(x(i))>0;

而假如点的正确分类为-1,而感知机将其误分类为+1时,有

f(x(i))>0,那么再乘以

−y(i)就有

−y(i)f(x(i))>0。

因此一个误分类点到超平面的距离为:

∥w∥2−y(i)(w⋅x(i)+b)

所有误分类点到超平面的总距离为:

−∥w∥21∑x(i)∈My(i)(w⋅x(i)+b)

我们可以发现分子和分母都含有w,当分子的w扩大N倍时,分母的w的L2范数也会扩大N倍。也就是说,分子和分母有固定的倍数关系。因此我们令分母

∥w∥2=1,这样可以简化我们的损失函数。

最终感知机模型的损失函数为:

L(w,b)=−∑x(i)∈My(i)(w⋅x(i)+b)

感知机模型函数的优化算法

对于上面的损失函数,我们可以用梯度下降的方法来优化。但是用普通的基于所有样本的梯度和均值的批量梯度下降法(BGD)是行不通的,原因在于我们的损失函数里面有限定,只有误分类的点集合里面的样本才能参与损失函数的优化。

所以我们不能用最普通的批量梯度下降,只能采用随机梯度下降(SGD)或者小批量梯度下降(MBGD)。感知机模型选择的是采用随机梯度下降,这意味着我们每次只使用一个误分类的点来更新梯度。

给定训练集T,感知机学习的目标是最小化损失函数:

minw,bL(w,b)=−∑x(i)∈My(i)(w⋅x(i)+b)

其中M是误分类点的集合。

损失函数的梯度为:

∇wkL(w,b)=−∑x(i)∈My(i)xk(i)

∇bL(w,b)=−∑x(i)∈My(i)

因为采用随机梯度下降,所以每次仅采用一个误分类的样本点

(x(i),y(i))来计算梯度对w,b进行更新:

w=w−η∇wL(w,b)=w+ηy(i)x(i)

b=b−η∇bL(w,b)=b+ηy(i)

其中

η为学习率。每次调整都使超平面向误分类点的一侧移动,以减小改误分类点与超平面间的距离,直到超平面越过该点使其被正确分类。

感知机模型的算法步骤

输入m个样本,每个样本对应于n维特征和一个二元类别输出1或者-1,如下:

(x(0),y(0)),(x(1),y(1)),…(x(m),y(m))

输出为超平面的参数w和b。

步骤如下:

- 定义所有w和b的处置,设置初始学习率。

- 在训练集中任意抽取一个数据点

(x(i),y(i)),判断它用现有的感知机模型分类是否是误分类点,如果是,执行下一步;如果不是,则放回再抽取一个点,再判断是否是误分类点。如果所有数据点都判断过且无误分类点,则直接结束算法。

- 使用上一步得到的误分类点对w和b进行一次随机梯度下降,更新w和b的参数,再重新执行上一步。

感知机模型的算法对偶形式

对偶就是从一个不同的角度去解答相似问题,但是问题的解是相通的,甚至是一样一样的。

上面的计算方式是感知机模型的原始形式,而使用对偶形式可以显著地减小计算量(特征维度越高越明显)。

在原始形式中,我们的参数w和b的更新是完全基于样本点的。如果我们将参数w和b表示为样本点的线性组合,我们可以记录各个样本点在参数更新中分别被使用了多少次。

假设初始值

w0,b0均为0,然后使用随机梯度下降调整w,b,设现在迭代n次,

w,b关于点

(x(i),y(i))的增量分别是

αiy(i)x(i)和

αiy(i),那么最后学习到的

w,b可以表示为:

w=∑i=1nαiy(i)x(i)

b=∑i=1nαiy(i)

其中

αi=niη,

ni表示第i个个样本点由于误分类而进行更新的次数。

样本点更新次数越多,意味着它距离分离超平面就越近,也就越难正确分类。换句话说,这样的样本点对学习结果影响最大。

这样每次判断误分类点的条件就变为:

y(i)(∑j=1nαiy(j)x(j)⋅x(i)+b)≤0

这种形式有一个好处,就是在训练过程中,训练样本仅以内积

x(j)⋅x(i)的形式出现。而且这个内积计算的结果在下面的迭代次数中可以重用。

如果我们事先用矩阵运算计算出所有的样本之间的内积,那么在算法运行时, 仅仅一次矩阵内积运算比多次循环计算省时。 这就节省了很多计算时间。

这个样本内积矩阵也就是所谓的Gram矩阵:

G=[x(i)⋅y(j)]N×N

在原始形式中我们利用

y(i)(w⋅x(i)+b)≤0判断点是否是误分类点,因为每次w都有变化,所以每次都需要计算特征向量

x(i)和w的乘积。在对偶形式中我们利用

y(i)(∑j=1nαiy(j)x(j)⋅x(i)+b)≤0来判断,而只要事先计算好Gram矩阵,通过查找Gram矩阵就能得到样本内积

x(j)⋅x(i),这比原始形式每次迭代都需要计算

w⋅x(i)节省了大量的计算时间。

另外,内积形式很方便我们引入支持向量机的核方法,用来解决数据集线性不可分时的情况。

总结:

感知机的对偶形式本质上就是用样本

x(i)和

y(i)的线性组合去表达原始形式中的w,b。这种形式的表达可以引入样本内积,减少计算量。

这种形式下要更新的模型参数只有一个

αi=niη,我们每次用一个误分类样本

x(i)对参数进行更新,只需要将相应的

ni加1,即:

αi=η(ni+1)=αi+η

注意对偶形式的参数初始化时,

αi被初始化为0(因为

ni一开始都为0)。

感知机计算实例

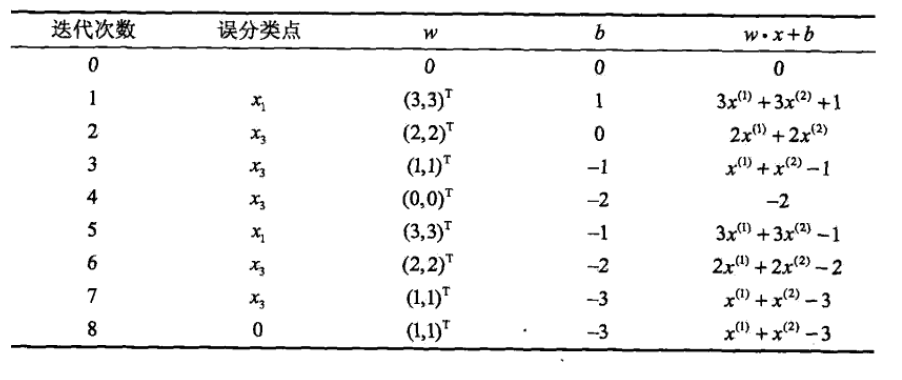

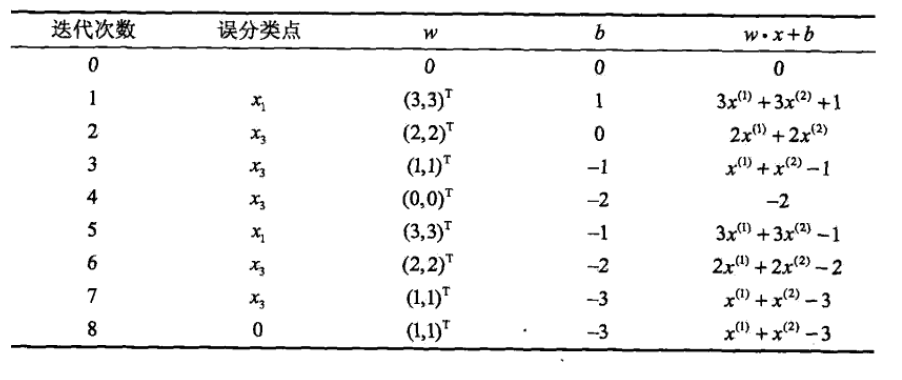

这是《统计学习方法》第29页的例2.1。

对正实例点

x1=(3,3)T,

x2=(4,3)T,负实例点

x3=(1,1)T,用感知机学习算法的原始形式求感知机模型

f(x)=sign(w⋅x+b)。

构建最优化问题:

minw,bL(w,b)=−∑xi∈Myi(w⋅x+b)

令

η=1,取初值

w0=0,b0=0。

对

x1=(3,3)T,

y1(w0⋅x1+b0)=0,未正确分类,更新w、b:

w1=w0+y1x1=(3,3)T,b1=b0+y1=1

得到更新后的模型:

w1⋅x+b1=3x(1)+3x(2)+1

对

x1和

x2,

yi(w1⋅xi+b1)>0,分类正确,不更新w、b。

对

x3=(1,1)T,

y3(w1⋅x3+b1)<0,分类错误,更新w、b:

w2=w1+y3x3=(2,2)T,b2=b1+y3=0

得到更新后的模型:

w2⋅x+b2=2x(1)+2x(2)

继续下去,得到:

w7=(1,1)T,b7=−3

w7⋅x+b7=x(1)+x(2)−3

此时,对于所有数据点都有

yi(w7⋅xi+b7)>0,没有误分类点,损失函数达到极小值。

则感知机模型函数为:

f(x)=sign(x(1)+x(2)−3)

详细计算过程: