一、逻辑回归简述:

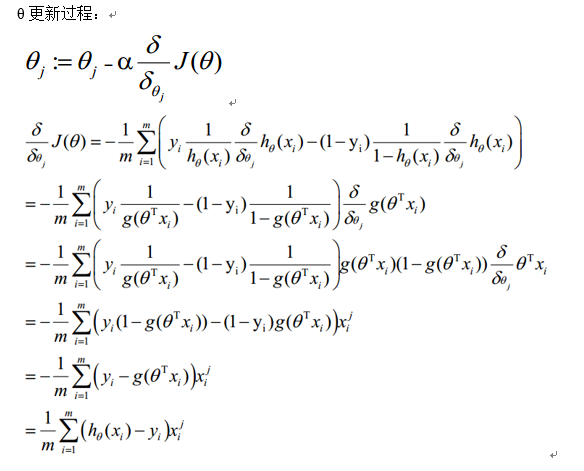

回顾线性回归算法,对于给定的一些n维特征(x1,x2,x3,......xn),我们想通过对这些特征进行加权求和汇总的方法来描绘出事物的最终运算结果。从而衍生出我们线性回归的计算公式:

![]()

向量化表达式:

这一系列W值(w1,w2,w3....wn)和截距b就是拟合了我们这些特征对应于结果f(x)的线性关系,当我们给出新的一些特征x的是时候,可以根据这些W值特征x进行内积加截距b来预测出给定的新特征x对应的结果f(x)。

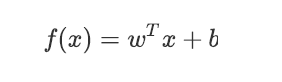

然而在采用回归模型分析实际问题中,我们想得出的结果不单纯是一个结果f(x)值,我们需要得出一个分类结果。比如我们给定一些指标年龄、性别、体质指数、平均血压、疾病指数,来判断就一个人是否患有糖尿病(Y=0表示未患病,Y=1表示患病),我们想要的结果f(x)不是一个连续变量,而是一个二分类变量(0-1)。这个时候单纯的线性回归得出的f(x)就不是我们想要的结果,我们需要对得出的线性回归结果f(x)通过一个sigmoid函数转换成我们的逻辑回归模型,从而得出我们想要的结果。从中我们可以总结:线性回归模型通常是处理因变量是连续变量的问题,如果因变量是定性变量,线性回归模型就不在适用,需要采取逻辑回归模型进行求解。也就引出我们逻辑回归的公式:

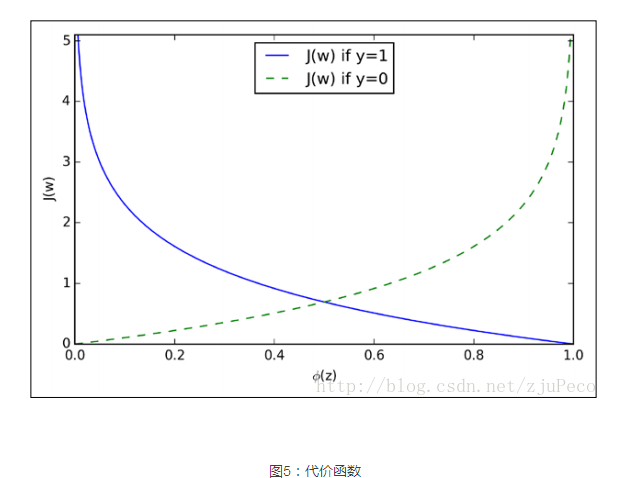

逻辑回归(Logistic Regression)是用于处理因变量为分类变量的回归问题,常见的是二分类或二项分布问题,也可以处理多分类问题。线性回归通过sigmoid函数转换得出一个概率值,y值的取值范围[0,1],我们根据sigmoid函数的特性,在(0,0.5)这个点上随着x的变化呈现出不同的变化趋势,如图所示:

从图中可以得出以下信息:我们线性回归得出的f(x)即图中的Z取值范围(-∞,+∞),我们为了的解决二分类问题,我们对得出的结果Z通过sigmoid函数转换使我们的结果取值在[0,1]之间。通俗的说就是如果有了一个测试点x,那么就可以用Sigmoid 函数算出来的结果来当做该点x属于类别1和0的概率大小。 当我们的Z>0时得出Z值越大我们将其划分为1的概率越大,反之,得出的Z<0,Z越小我们将其划分为0的概率越大。

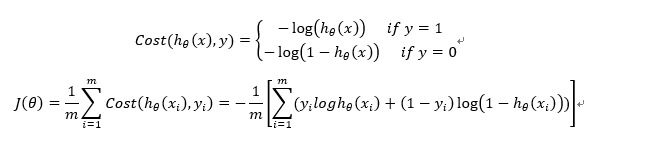

二、逻辑回归损失函数:(注:由于很多公式不好用键盘敲出,本人截取了很多别的博主的公式,导致通篇公式不一致)

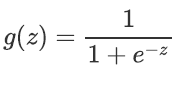

基于当y取1的时候,我们的h(x)越趋近于1 要求我们的损失函数越小,当y=0时我们的h(x)越趋近于0要求我们的损失函数越小,我们需要对得出的h(x)取对数才能贴合我们的损失函数要求,故得出损失函数如下:

有了损失函数,我们可以通过梯度上升法对我们的损失函数进行求解,得出Θ的最佳参数。