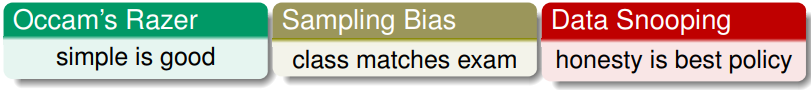

机器学习基石 Lecture16: Three Learning Foundations

Occam’s Razor

奥卡姆剃刀原则:如无必要勿增实体。

对这个原则的理解相当于是说,在机器学习里最简单的能够解释数据的模型就是最合理的模型。但是有两个问题,怎么知道一个模型是比较简单的?以及,怎么确定更简单的模型就是更好的?

一个简单的假设函数h看起来比较简单,一般是意味着有比较少的参数。而一个模型比较简单意味着它包含的假设函数的数量比较小。这两个事情之间有着一定的联系,因为模型包含更少的假设意味着假设函数可以用更少的bit来表示,因此更小的模型复杂度会带来更简单的假设函数。

而证明更简单的模型会更好是一个直觉上的说明。当我们能够使用更简单的模型就能够解释好一组数据时,说明这个数据可能确实是这么发生的。因为对于复杂的模型而言,对于各种数据都可能能够得到一个解释,而不是针对当前的数据。也就是说简单模型的解释更具有显著性。

Sampling Bias

下面说明的是采样偏差的问题。1948年美国总统大选的时候,杜鲁门和杜威之间的选举,在投票结束之后媒体通过电话抽样调查投票结果。抽样显示杜威会获胜,但实际上最后获胜的是杜鲁门。

事后调查原因,既不是因为编辑的失误,也不是抽样的结果没有代表性。而是因为当时的电话很贵,抽样人群是一个特定的群体而不能代表所有的人。从理论上讲,如果数据通过有偏的方式采样得到的,那么学习的结果也是有偏的。这是因为VC bound的不等式是建立在训练数据与测试数据是独立同分布的假设上的,如果这个假设不满足VC bound也就不成立。

林老师自己在参与2010年Netflix比赛的时候也遇到了这个问题,在验证集上提升的效果超过了目标的10%,但是实际上在测试集上结果折半了。这是因为比赛中的数据是有一定先后顺序的,前面的数据被用来做训练,而靠后面的数据被拿来做测试。

如何解决这个有偏采样的问题呢?一个实际的方向就是让训练数据或者是验证的时候尽可能的靠近最终测试的场景。

以及给用户发放信用卡时,银行有的数据都是以前发放了信用卡的用户的情况,而没有不被发放信用卡的用户的情况,本身也是有偏的。

Data Snooping

之前也讲过关于偷看数据的问题。当我们观察数据时,脑海里的思考会帮助我们进行模型的选择,这会导致附加了一些复杂度到训练过程中去。因此最好在训练时在看了数据之后再进行特征工作或者思考模型。

但是这样做是非常困难的,一不注意就导致了偷看的发生。比如使用了8年的股票数据,前6年的被用来做训练而后两年的作为测试。如果是进行数据归一化的动作,只使用前6年的数据进行归一化和使用了整个8年的数据进行归一化就会导致结果完全不同。

而对于数据的重复使用也会导致这个问题。比如对一个公开数据集的连续使用进而选择模型,无形中会存在一个联合的过程,也就导致了最终的模型复杂度会很大。也就是说一直用一个数据会导致效果可能会很好,但不一定能代表真实情况。

为了解决这个问题,需要做到以下的几点:

但完全避免是非常难做到的。因此需要自身把握一个平衡。

Power of Three

最后做一些总结。本门课讲了好多跟3有关的东西,第一个就是三个相关的学科:

三个理论上限:

三种线性模型:

三种训练模型的关键技术:

三个学习的准则:

下面的技法课程中也有三种更多可能等着我们:

基石完结,技法再会。