文章目录

HDFS概述及设计目标

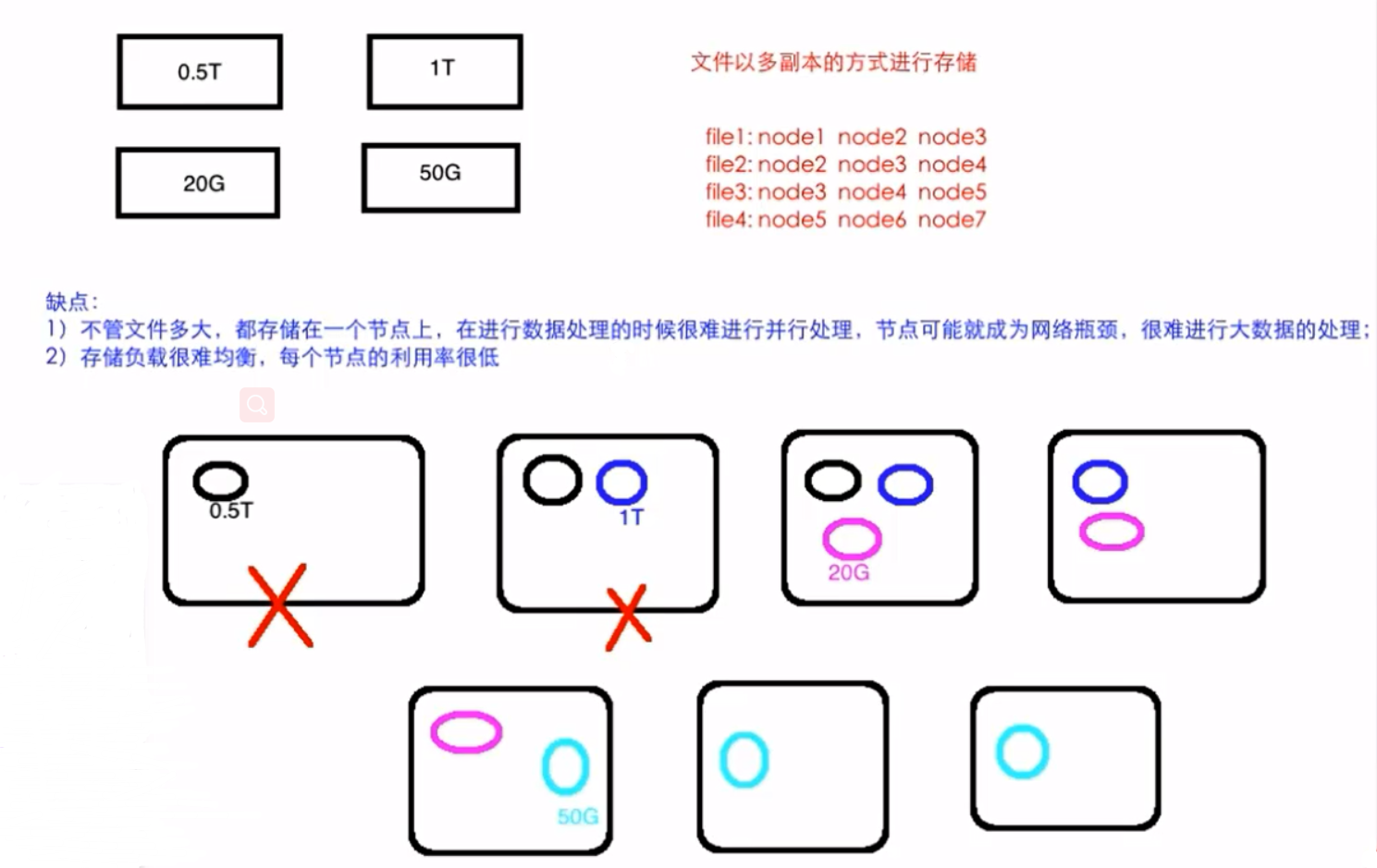

如果让我们自己来设计一个分布式文件系统,咋办?

下图是普通分布式文件系统

什么是HDFS

- Hadoop实现了一个分布式文件系统( Hadoop Distributed File System) ,简称HDFS

- 源自Google的GFS论文

- 发表于2003年,HDFS是GFS的克隆版

HDFS的设计目标

- 非常巨大的分布式文件系统

- 运行在普通廉价的硬件上

- 易扩展、为用户提供性能不错的文件存储服务

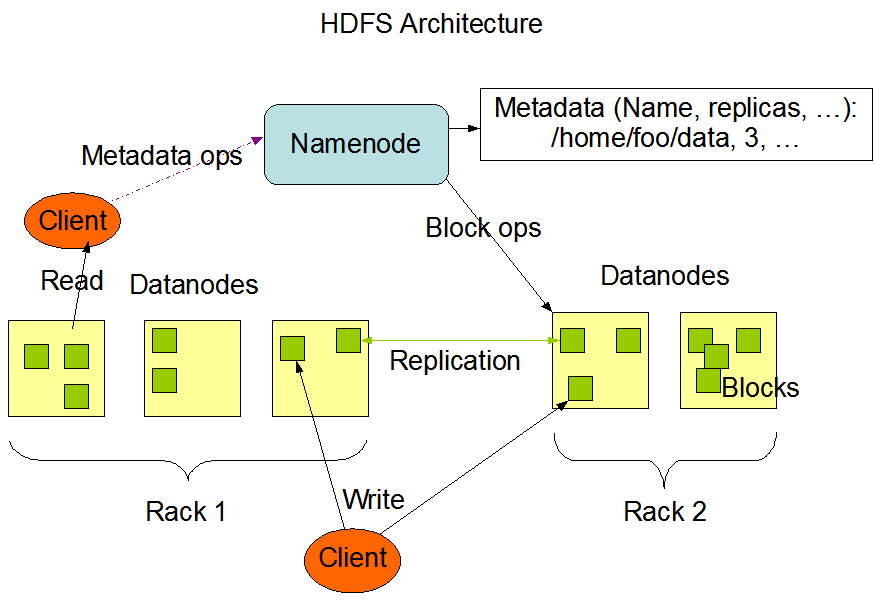

HDFS架构

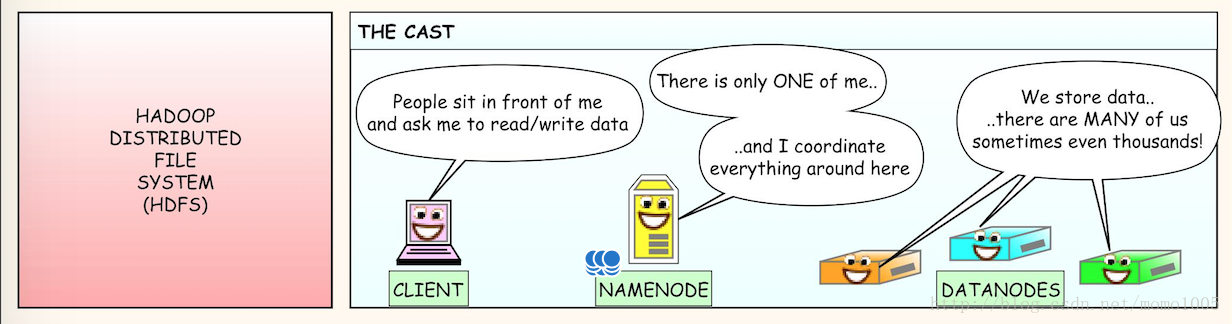

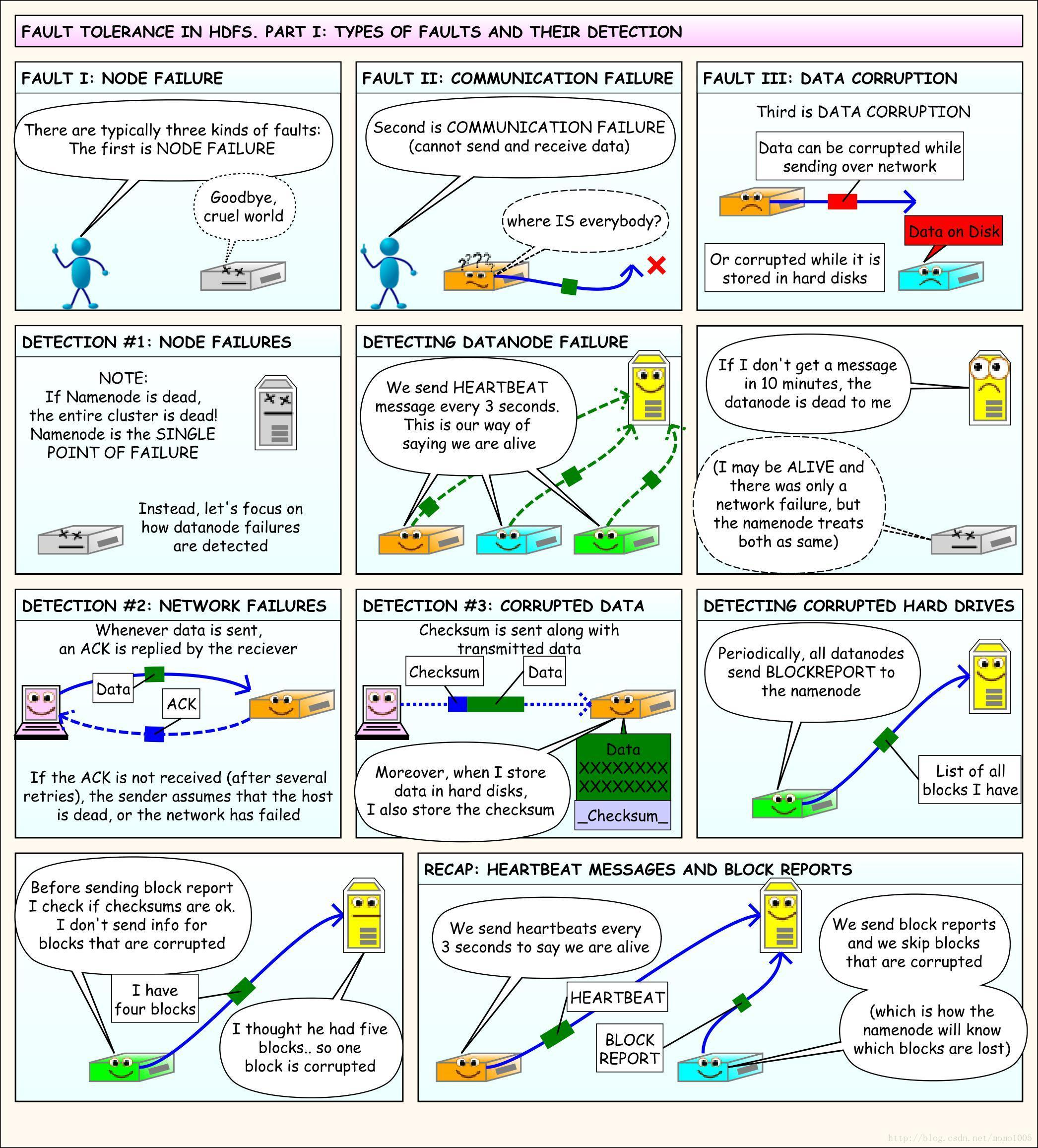

HDFS有主从架构。HDFS集群由一个NameNode组成,它是一个主服务器,管理文件系统名称空间并管理客户机对文件的访问。此外,还有许多datanode,通常每个节点一个,管理连接到它们运行的节点的存储。HDFS公开一个文件系统名称空间,并允许用户数据存储在文件中。在内部,文件被分割成一个或多个块,这些块存储在一组数据节点(datanode)中。NameNode执行文件系统操作,如打开、关闭和重命名文件和目录。它还确定块到datanode的映射。datanode负责服务来自文件系统客户端的读写请求。根据NameNode的指令,datanode还执行块的创建、删除和复制。

上图中

- 1 个Master(NameNode/NN) 带 N个Slaves(DataNode/DN)

HDFS/YARN/HBase其实都是一样的 - 1个文件会被拆分成多个Block理解为:

blocksize:128M

130M ==> 2个Block: 128M 和 2M

NN:

1)负责客户端请求的响应

2)负责元数据(文件的名称、副本系数、Block存放的DN)的管理DN:

1)存储用户的文件对应的数据块(Block)

2)要定期向NN发送心跳信息,汇报本身及其所有的block信息,健康状况

一个典型的部署是一台机器运行一个namenade,集群中的其他机器都运行一个DataNode。该体系结构不排除在同一台机器上运行多个DataNode

但在实际部署中却很少出现这种情况。

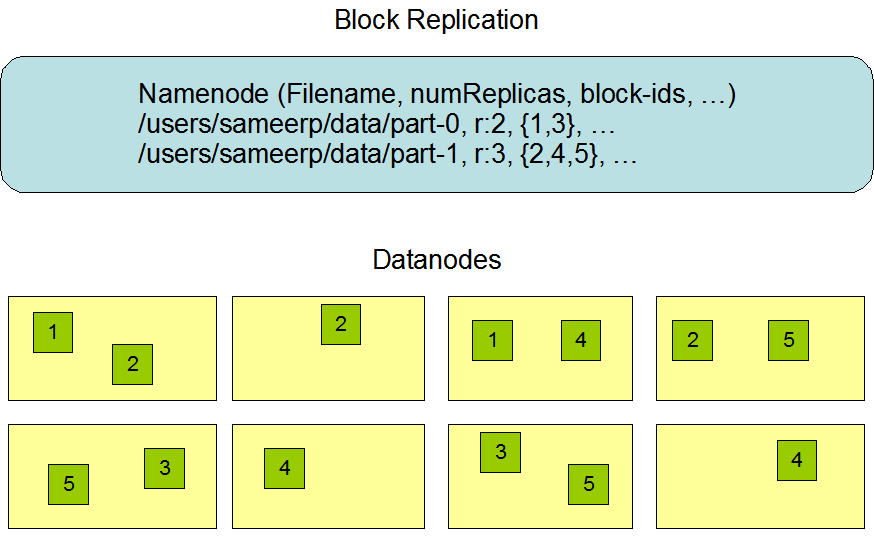

HDFS副本机制

HDFS支持传统的分层文件组织。用户或应用程序可以在这些目录中创建目录并存储文件。文件系统名称空间层次结构与大多数现有文件系统相似;可以创建和删除文件,将文件从一个目录移动到另一个目录,或者重命名文件。

NameNode维护文件系统名称空间。对文件系统名称空间或其属性的任何更改都由NameNode记录。应用程序可以指定由HDFS维护的文件的副本数量。一个文件的副本数量称为该文件的副本因子。这些信息由NameNode存储。

数据副本

HDFS被设计为在大型集群中的机器之间可靠地存储非常大的文件。它以块序列的形式存储每个文件。为了容错,复制文件的块。每个文件的块大小和复制因子都是可配置的。

除了最后一个块之外,文件中的所有块大小都相同。

应用程序可以指定文件的副本数量。副本因子可以在文件创建时指定,以后可以更改。HDFS中的文件只写一次(除了追加和截断之外),并且在任何时候都有一个写入者。

NameNode就块的复制做出所有决定。它定期从集群中的每个datanode接收心跳和数据块报告。接收到心跳表示DataNode正常工作。块报表包含datanode上所有块的列表。

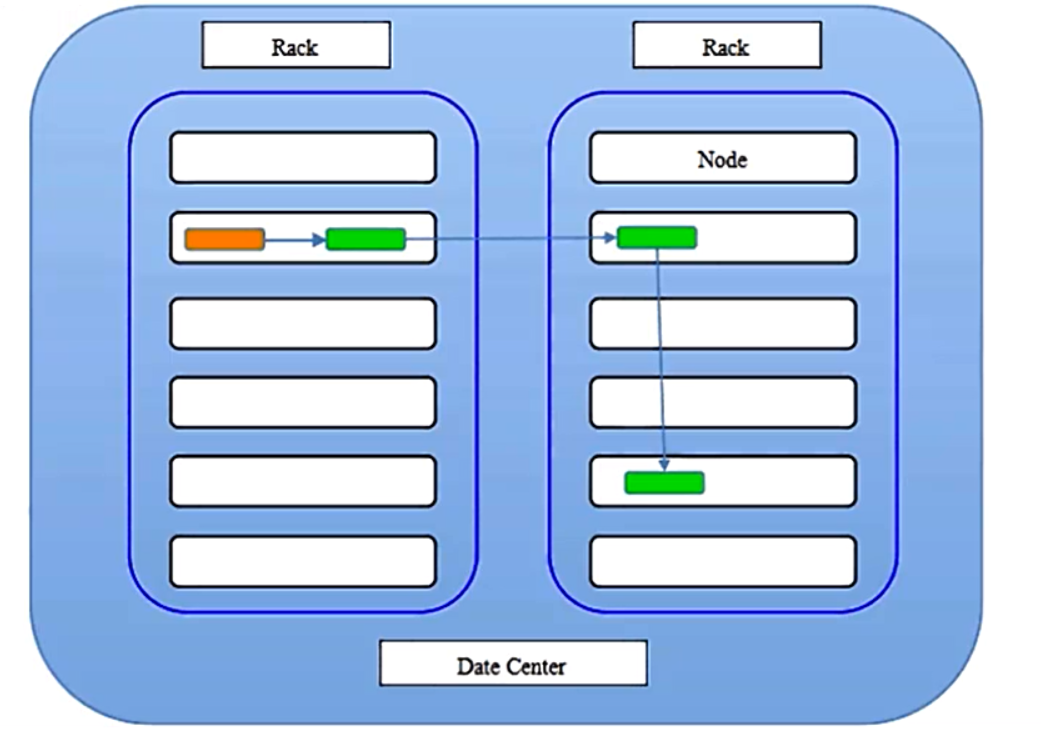

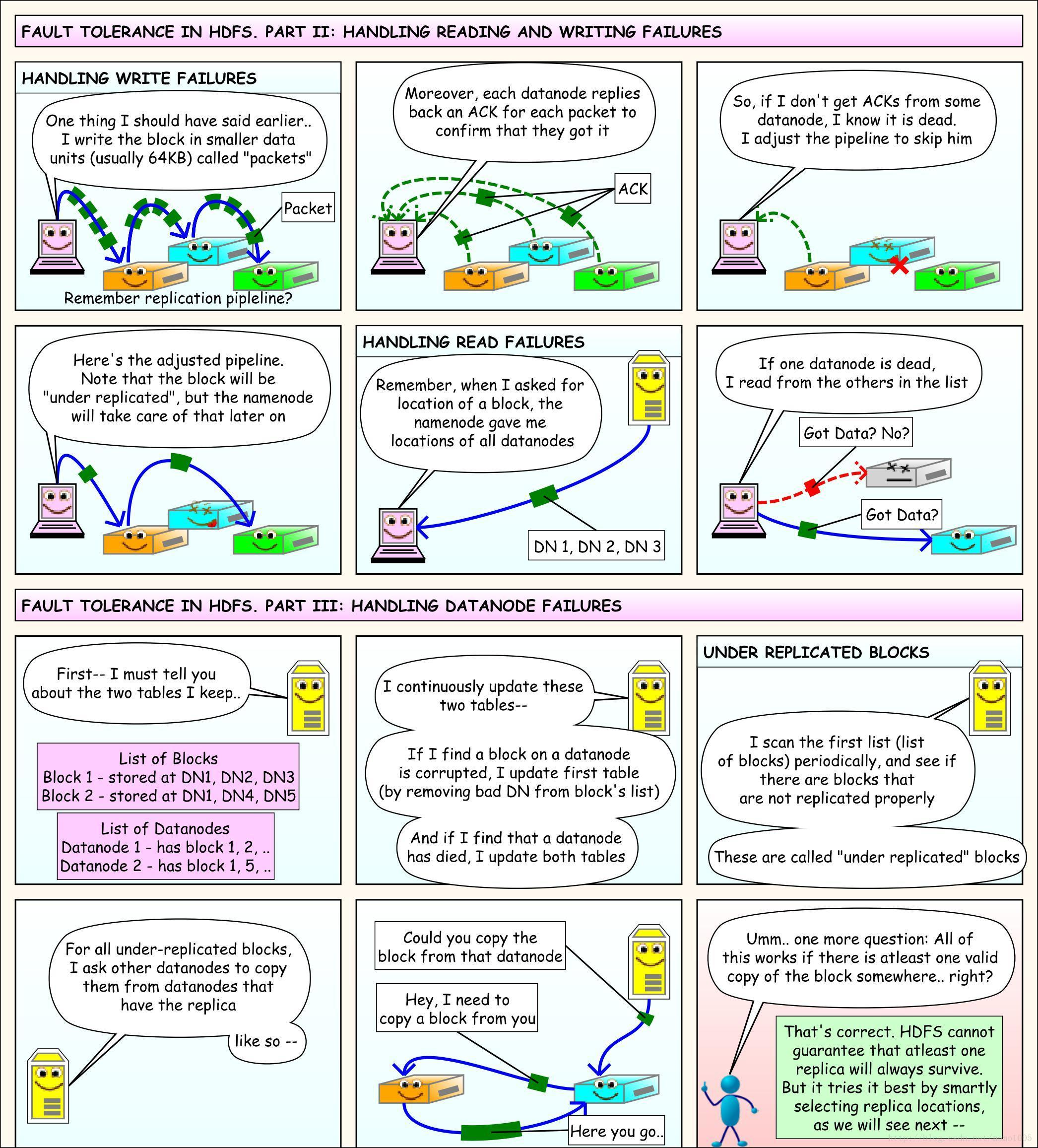

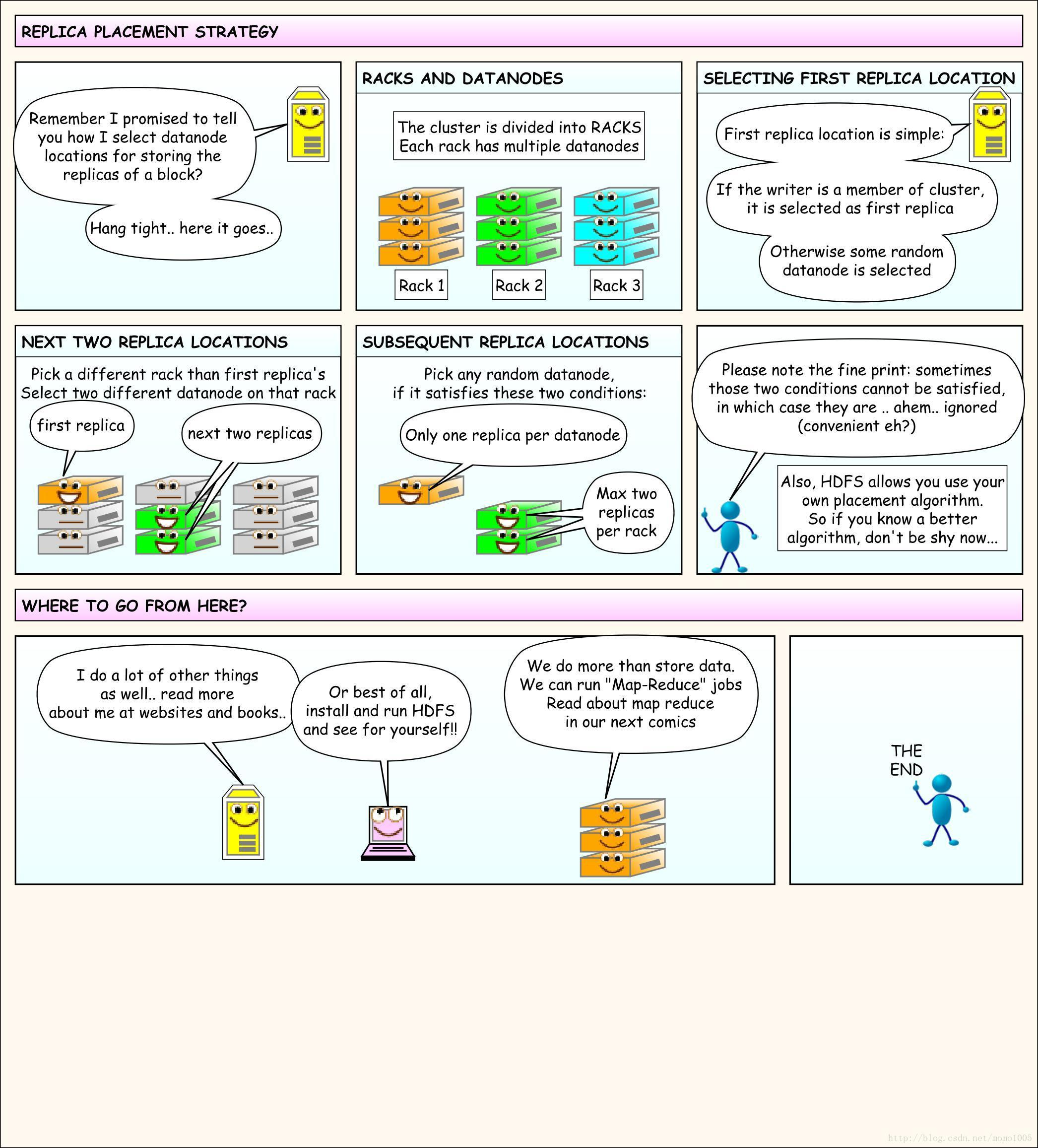

副本存放策略

上图代表数据中心,两个机架,黄色代表客户端所在的节点(默认三个副本)

第一个副本存放在同client的节点上面;

第二个副本存放在不同第一个副本机架的随意一个节点;

第三个副本存放在与第二个副本相同机架的另一个节点上;

如果只有一个机架,则在不同节点存储;如果高于三个副本则高于三的随意挑选机架和节点。

HDFS环境搭建

官网安装文档

Hadoop伪分布式安装步骤

http://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-common/SingleCluster.html

-

jdk安装

解压:tar -zxvf jdk-7u79-linux-x64.tar.gz -C ~/app

添加到系统环境变量: ~/.bash_profile

export JAVA_HOME=/home/hadoop/app/jdk1.7.0_79

export PATH= PATH

使得环境变量生效: source ~/.bash_profile

验证java是否配置成功: java -v -

安装ssh

sudo yum install ssh

ssh-keygen -t rsa

cp ~/.ssh/id_rsa.pub ~/.ssh/authorized_keys -

下载并解压hadoop

下载:直接去cdh网站下载

解压:tar -zxvf hadoop-2.6.0-cdh5.7.0.tar.gz -C ~/app -

hadoop配置文件的修改(hadoop_home/etc/hadoop)

hadoop-env.sh

export JAVA_HOME=/home/hadoop/app/jdk1.7.0_79

core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop000:8020</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/app/tmp</value>

</property>

hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

-

启动hdfs

格式化文件系统(仅第一次执行即可,不要重复执行):hdfs/hadoop namenode -format

启动hdfs: sbin/start-dfs.sh

验证是否启动成功:

jps

DataNode

SecondaryNameNode

NameNode浏览器访问方式: http://hadoop000:50070 -

停止hdfs

sbin/stop-dfs.sh

HDFS shell

HDFS shell常用命令的使用

官网文档参考

http://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-hdfs/HDFSCommands.html#dfs

hdfs dfs等于hadoop fs

Is

[root@hadoop data]# hdfs dfs -ls /

18/11/09 21:40:49 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

Found 1 items

drwxr-xr-x - root supergroup 0 2018-09-02 08:37 /hbase

get

[root@hadoop data]# hdfs dfs -get /hell.txt

mkdir

[root@hadoop data]# hdfs dfs -mkdir -p /text/a/b

18/11/09 21:44:57 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

[root@hadoop data]# hdfs dfs -ls -R /text

18/11/09 21:46:25 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

drwxr-xr-x - root supergroup 0 2018-11-09 21:44 /text/a

drwxr-xr-x - root supergroup 0 2018-11-09 21:44 /text/a/b

rm

[root@hadoop data]# hdfs dfs -rm -R /text/a/b

put

[root@hadoop data]# hdfs dfs -put hell.txt /

18/11/09 21:43:16 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

[root@hadoop data]# hdfs dfs -ls /

18/11/09 21:43:25 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

Found 2 items

drwxr-xr-x - root supergroup 0 2018-09-02 08:37 /hbase

-rw-r--r-- 1 root supergroup 13 2018-11-09 21:43 /hell.txt

Java API操作

package com.imooc.hadoop.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.*;

import org.apache.hadoop.io.IOUtils;

import org.apache.hadoop.util.Progressable;

import org.junit.After;

import org.junit.Before;

import org.junit.Test;

import java.io.BufferedInputStream;

import java.io.File;

import java.io.FileInputStream;

import java.io.InputStream;

import java.net.URI;

/**

* Hadoop HDFS Java API 操作

*/

public class HDFSApp {

public static final String HDFS_PATH = "hdfs://hadoop000:8020";

FileSystem fileSystem = null;

Configuration configuration = null;

/**

* 创建HDFS目录

*/

@Test

public void mkdir() throws Exception {

fileSystem.mkdirs(new Path("/hdfsapi/test"));

}

/**

* 创建文件

*/

@Test

public void create() throws Exception {

FSDataOutputStream output = fileSystem.create(new Path("/hdfsapi/test/a.txt"));

output.write("hello hadoop".getBytes());

output.flush();

output.close();

}

/**

* 查看HDFS文件的内容

*/

@Test

public void cat() throws Exception {

FSDataInputStream in = fileSystem.open(new Path("/hdfsapi/test/a.txt"));

IOUtils.copyBytes(in, System.out, 1024);

in.close();

}

/**

* 重命名

*/

@Test

public void rename() throws Exception {

Path oldPath = new Path("/hdfsapi/test/a.txt");

Path newPath = new Path("/hdfsapi/test/b.txt");

fileSystem.rename(oldPath, newPath);

}

/**

* 上传文件到HDFS

*

* @throws Exception

*/

@Test

public void copyFromLocalFile() throws Exception {

Path localPath = new Path("/Users/rocky/data/hello.txt");

Path hdfsPath = new Path("/hdfsapi/test");

fileSystem.copyFromLocalFile(localPath, hdfsPath);

}

/**

* 上传文件到HDFS

*/

@Test

public void copyFromLocalFileWithProgress() throws Exception {

InputStream in = new BufferedInputStream(

new FileInputStream(

new File("/Users/rocky/source/spark-1.6.1/spark-1.6.1-bin-2.6.0-cdh5.5.0.tgz")));

FSDataOutputStream output = fileSystem.create(new Path("/hdfsapi/test/spark-1.6.1.tgz"),

new Progressable() {

public void progress() {

System.out.print("."); //带进度提醒信息

}

});

IOUtils.copyBytes(in, output, 4096);

}

/**

* 下载HDFS文件

*/

@Test

public void copyToLocalFile() throws Exception {

Path localPath = new Path("/Users/rocky/tmp/h.txt");

Path hdfsPath = new Path("/hdfsapi/test/hello.txt");

fileSystem.copyToLocalFile(hdfsPath, localPath);

}

/**

* 查看某个目录下的所有文件

*/

@Test

public void listFiles() throws Exception {

FileStatus[] fileStatuses = fileSystem.listStatus(new Path("/"));

for(FileStatus fileStatus : fileStatuses) {

String isDir = fileStatus.isDirectory() ? "文件夹" : "文件";

short replication = fileStatus.getReplication();

long len = fileStatus.getLen();

String path = fileStatus.getPath().toString();

System.out.println(isDir + "\t" + replication + "\t" + len + "\t" + path);

}

}

/**

* 删除

*/

@Test

public void delete() throws Exception{

fileSystem.delete(new Path("/"), true);

}

@Before

public void setUp() throws Exception {

System.out.println("HDFSApp.setUp");

configuration = new Configuration();

fileSystem = FileSystem.get(new URI(HDFS_PATH), configuration, "hadoop");

}

@After

public void tearDown() throws Exception {

configuration = null;

fileSystem = null;

System.out.println("HDFSApp.tearDown");

}

}

HDFS文件读写流程

首先看看出场的角色,第一个是client客户端,用来发起读写请求,读取HDFS上的文件或往HDFS中写文件;第二个是Namenode,唯一的一个,会协调所有客户端发起的请求;第三个是DataNode,负责数据存储,跟Namenode不一样,DataNode有很多个,有时候能达到数以千计。

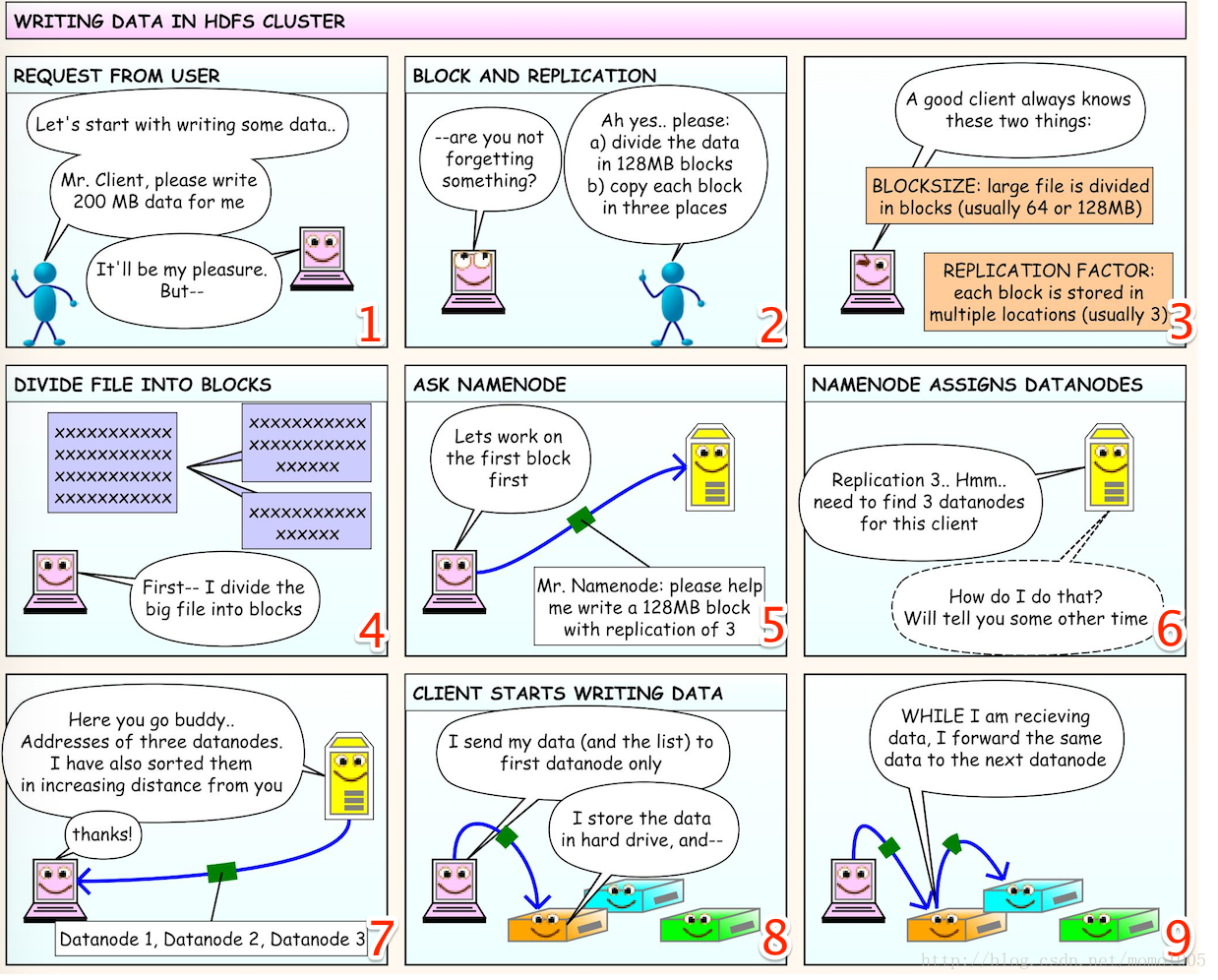

文件写流程图解

往HDFS中写数据的流程如下:

- 第1幅图:我们跟客户端说,你帮我写一个200M的数据吧,客户端说没问题啊,但是…

- 第2幅图:客户端不知道我们对数据有没有其他的要求啊,问我们是不是忘了什么东西呢?我们想起来我们还是有要求的,第一我们要把数据分成若干块,并且每块的大小是128M,第二,每个数据块应该复制3份。其实这就是我们说的HDFS的文件分块和多副本,如果你不说的话客户端怎么知道到底怎么分,复制多少份呢?

- 第3幅图:由上面的对话我们发现,如果对于每个文件客户端都要这么问一下,是不是太麻烦了?所以说一个好的客户端应该是,用户就算不说你也要知道有这两个属性:块的大小,一个文件应该按照怎样的大小切分(通常是64M或128M);复制因子,每个块应该复制多少份(通常是3份),也就是说如果用户不主动提供这些属性,那么就按照默认的来。

- 第4幅图:现在客户端已经知道了每个块的大小了,那么把200M的文件分成128M和72M两个块,一个长一个短。

- 第5幅图:切分后客户端就开始工作了,既然有两个块,那先上传第一个块,于是客户端请求Namenode帮它写一个128M的块,并且要复制3份。

- 第6幅图:Namenode接受到客户端的请求后,既然需要3个副本,那么就需要找到3个DataNode,Namenode就会想怎么去找到这3个DataNode呢?我该告诉客户端哪些信息呢?于是它就去它管理的DataNode中找一些满足要求的空闲节点。

- 第7幅图:Namenode找到了3个节点,现在把找到的节点发给客户端,表示:兄弟,你不是要我帮你写数据嘛,我给你找到了这3个合适的DataNode,并且已经按距离远近给你排过序了,第一个是最近的,你把数据给他们让他们帮你写吧。

- 第8幅图:客户端收到3个DataNode地址后,直接把数据发送到第一个节点(DataNode1)上,然后DataNode1开始把数据写到他的硬盘中。

- 第9、10、11幅图:DataNode1在接受数据的同时,会把刚刚收到的数据发送到第二个DataNode2上,同理DataNode2也是,接收的同时把数据立马发给DataNode3,到了DataNode3已经是最后一个DataNode了。整个过程跟流水线一样,接收一点就发一点。(个人感觉跟计算机网络中令牌环网的工作原理有些类似)

第12幅图:Namenode是所有DataNode的老大,所以DataNode在存完数据后要跟老大汇报,告诉他说,我第一个块的数据已经写完了。 - 第13幅图:3个DataNode都报告完成后,好,这样第一个数据块就写完了,下面对第二个块重复这个步骤。

- 第14幅图:所有的块都写完了之后,客户端关闭跟Namenode的连接。这时Namenode已经存储了文件的元数据,也就是文件被拆成了几块,复制了几份,每块分别存储在哪个DataNode上。

- 最后一幅图说明了每个角色在写数据过程中的作用:

Client:切分文件成数据块。

Namenode:对于每个数据块,找到存储的DataNode地址。

DataNode:多副本方式存储数据。

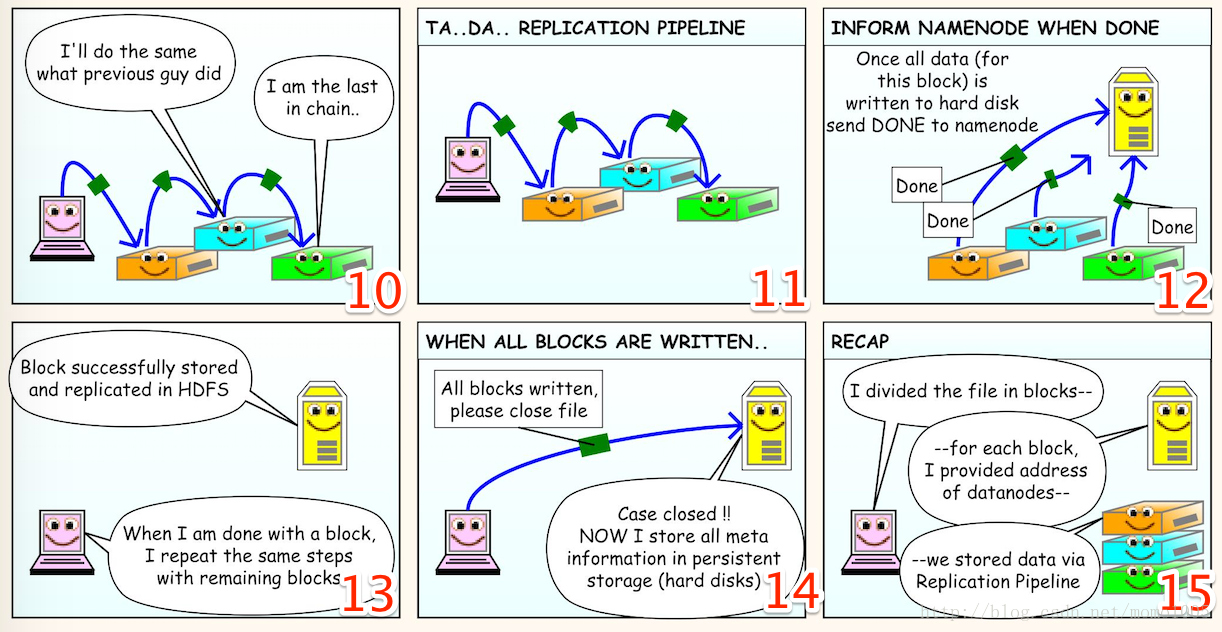

文件读流程图解

- 第1幅图:写文件已经搞定了,那么怎么读文件呢?我们先跟客户端说,嘿兄弟!帮我读个文件呗!

- 第2幅图:客户端跟Namenode发了个请求,把文件名发送给Namenode,表示我想要这个这个文件的信息。

- 第3幅图:Namenode找了找,然后找到了一个结果,结果包含这个文件被拆成了多少块,每个块存储在哪些DataNode上的信息,并且DataNode同样是按照距离排序的。然后把这个结果发送给客户端,说,嘿兄弟!你要的文件在这些DataNode上,你去找吧。

- 第4幅图:现在客户端知道了文件的存储情况,所以就一个个去DataNode上访问就好了。

- 最后提出了一个问题:如果这个过程中DataNode挂了,或者数据在传输中出了问题怎么办?事实上HDFS对于这些问题都是能够完美解决的。

HDFS错误处理机制

HDFS优缺点

优点:

- 数据冗余、硬件容错

- 处理流式的数据访问

- 适合存储大文件

- 可构建在廉价机器上

缺点:

- 低延迟的数据访问

- 不适合小文件存储