第一步:

①准备三台虚拟机 使用 VMware Workstation工具

配置过程 参考 https://blog.csdn.net/pucao_cug/article/details/71229416

配置好使用工具CRT 连接

②更改主机名

192.168.220.128 s1

192.168.220.128 s2

192.168.220.128 s3

---------------三台都改---------------------

[root@s1 ~]# hostname //查看主机名

sss

[root@s1 ~]# hostname s1 //修改主机名

[root@s1 ~]# hostname

s1修改这3台机器的/etc/hosts文件,在文件中添加以下内容

192.168.220.128 s1

192.168.220.128 s2

192.168.220.128 s3

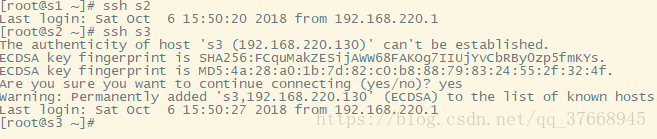

③将这三台虚拟机配置设置免密登陆

#在192.168.220.128上生产一对钥匙

ssh-keygen -t rsa

#将公钥拷贝到其他节点,包括自己

ssh-copy-id 192.168.220.128

ssh-copy-id 192.168.220.129

ssh-copy-id 192.168.220.130我这里只这在 192.168.220.128 节点上 免密登陆 另外两台节点

配置好后输入 ssh 命令 如下 第一次登陆会进行一次交互 输入 yes即可

退出 输 exit 命令

第二步:

①给三台机器安装配置jdk 我用jdk8 参考此链接

http://blog.csdn.net/pucao_cug/article/details/68948639

②安装hadoop

下载地址 :http://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-2.8.0/hadoop-2.8.0.tar.gz

3台机器上都需要下面所讲的步骤。

*****在opt目录下新建一个名为hadoop的目录,并将下载得到的hadoop-2.8.0.tar上传到该目录下

使用 下面命令解压

tar -zxvf ************tar.gz********在/root目录下新建几个目录,复制粘贴执行下面的命令:

mkdir /root/hadoop

mkdir /root/hadoop/tmp

mkdir /root/hadoop/var

mkdir /root/hadoop/dfs

mkdir /root/hadoop/dfs/name

mkdir /root/hadoop/dfs/data

********修改配置文件 /opt/hadoop/hadoop-2.8.0/etc/hadoop 目录下的

修改core-site.xml

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>/root/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.default.name</name>

<value>hdfs://s1:9000</value>

</property>

</configuration>

修改 hadoop-env.sh

export JAVA_HOME= ${JAVA_HOME

将${JAVA_HOME} 修改成自己jdk路径

我这里是

export JAVA_HOME=/opt/java/jdk1.8.0_60

修改 hdfs-site.xml

<configuration>

<property>

<name>dfs.name.dir</name>

<value>/root/hadoop/dfs/name</value>

<description>Path on the local filesystem where theNameNode stores the namespace and transactions logs persistently.</description>

</property>

<property>

<name>dfs.data.dir</name>

<value>/root/hadoop/dfs/data</value>

<description>Comma separated list of paths on the localfilesystem of a DataNode where it should store its blocks.</description>

</property>

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

</configuration>修改mapred-site.xml

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>s1:49001</value>

</property>

<property>

<name>mapred.local.dir</name>

<value>/root/hadoop/var</value>

</property>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>修改slaves 将localhost删除

s2

s3修改yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>s1</value>

</property>

<property>

<description>The address of the applications manager interface in the RM.</description>

<name>yarn.resourcemanager.address</name>

<value>${yarn.resourcemanager.hostname}:8032</value>

</property>

<property>

<description>The address of the scheduler interface.</description>

<name>yarn.resourcemanager.scheduler.address</name>

<value>${yarn.resourcemanager.hostname}:8030</value>

</property>

<property>

<description>The http address of the RM web application.</description>

<name>yarn.resourcemanager.webapp.address</name>

<value>${yarn.resourcemanager.hostname}:8088</value>

</property>

<property>

<description>The https adddress of the RM web application.</description>

<name>yarn.resourcemanager.webapp.https.address</name>

<value>${yarn.resourcemanager.hostname}:8090</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>${yarn.resourcemanager.hostname}:8031</value>

</property>

<property>

<description>The address of the RM admin interface.</description>

<name>yarn.resourcemanager.admin.address</name>

<value>${yarn.resourcemanager.hostname}:8033</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.scheduler.maximum-allocation-mb</name>

<value>2048</value>

<discription>每个节点可用内存,单位MB,默认8182MB</discription>

</property>

<property>

<name>yarn.nodemanager.vmem-pmem-ratio</name>

<value>2.1</value>

</property>

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>4096</value>

</property>

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

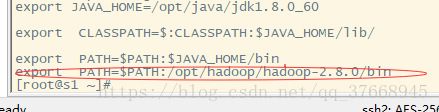

</configuration>第三步:启动hadoop

启动之前 配置一下 etc/profile 文件

将配置一下环境变量

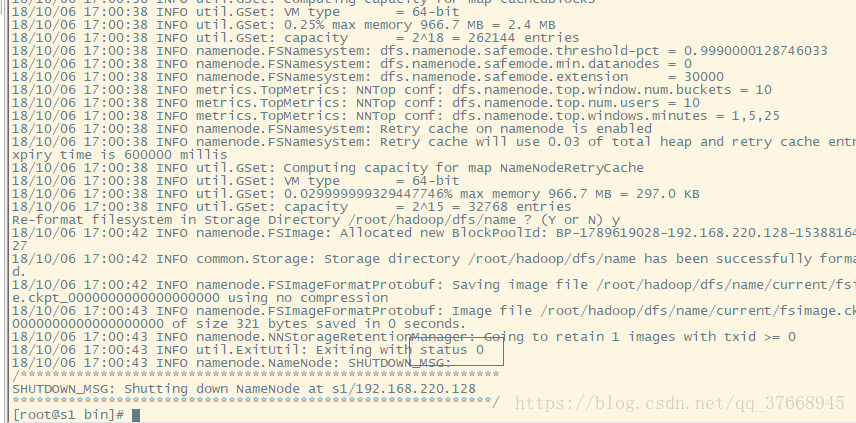

进入 Hadoop的bin目录 cd /opt/hadoop/hadoop-2.8.0/bin

格式化节点 ./hadoop namenode -format

格式化成功成功

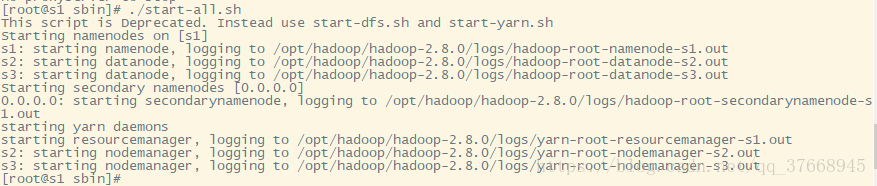

进入 Hadoop的sbin目录 cd /opt/hadoop/hadoop-2.8.0/sbin

启动 ./start-all.sh

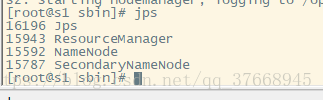

输入 jps 查看启动状态

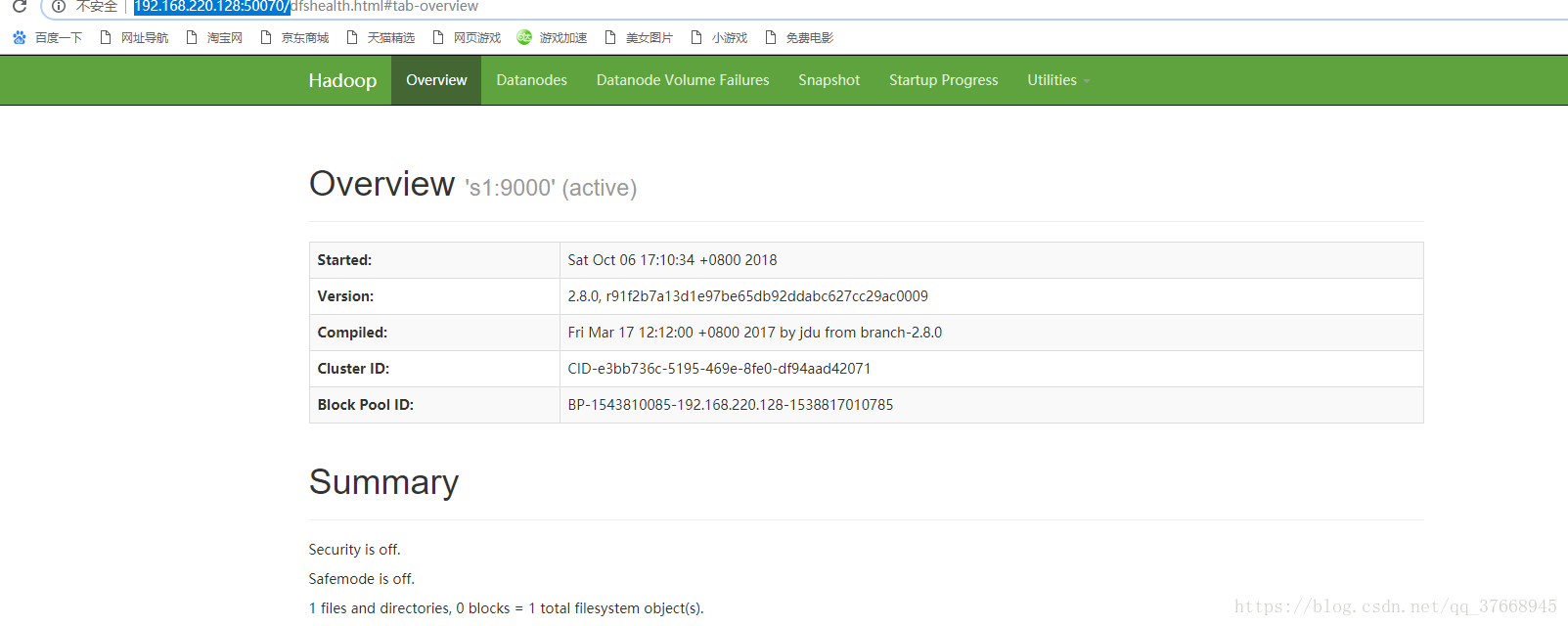

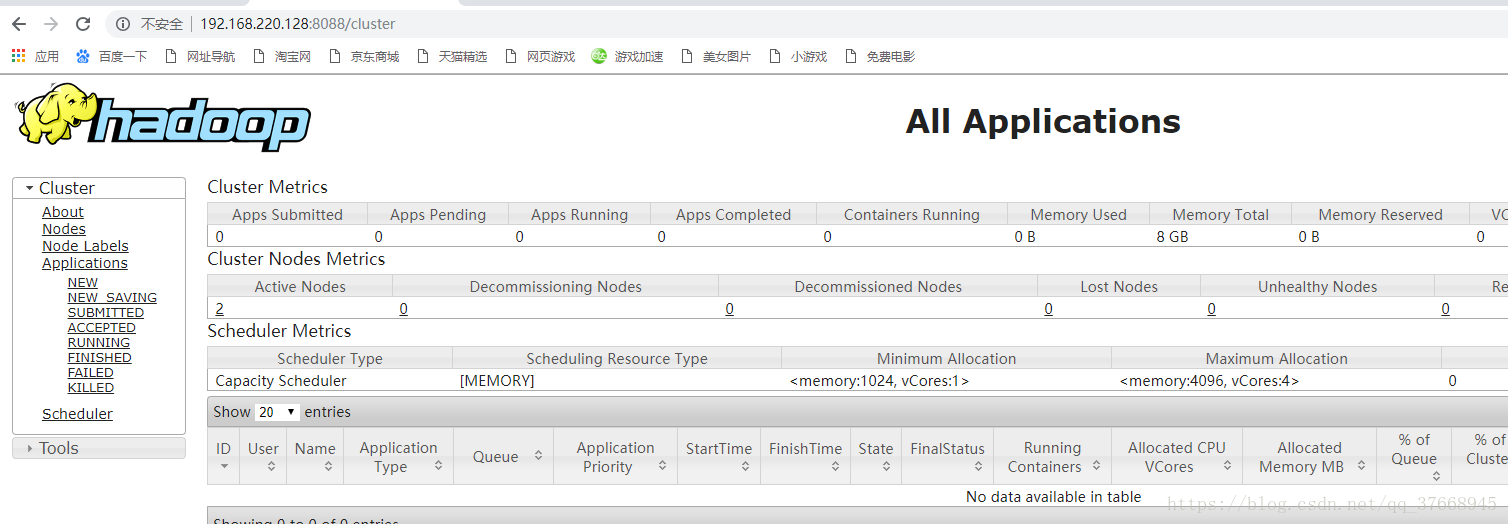

亦可访问网页 http://192.168.220.128:50070/

先关执行命令,关闭防火墙,CentOS7下,命令是:

systemctl stop firewalld.service

关闭 ./stop-all.sh

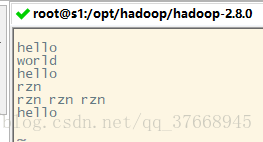

第四步:wordcount测试

在hadoop目录下新建一个data.txt

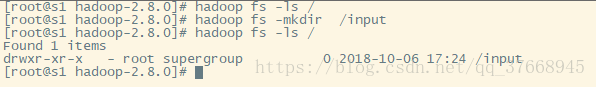

查看下hadoop文件目录系统

hadoop fs -ls /

没有创建一个

hadoop fs -mkdir /input

将文件上传上去

hadoop fs -put /input

运行wordcount示例

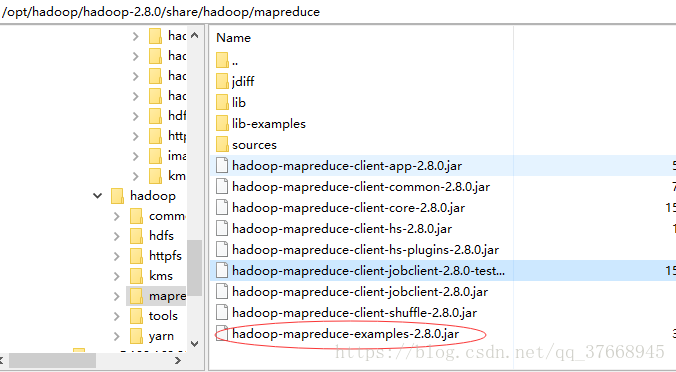

找到 示例 我的位置在

进入这个目录

cd /opt/hadoop/hadoop-2.8.0/share/hadoop/mapreduce

执行命令

hadoop jar hadoop-mapreduce-examples-2.8.0.jar wordcount /input /out

说明 /input 是放文件的目录 /out在文件系统目录中不能存在

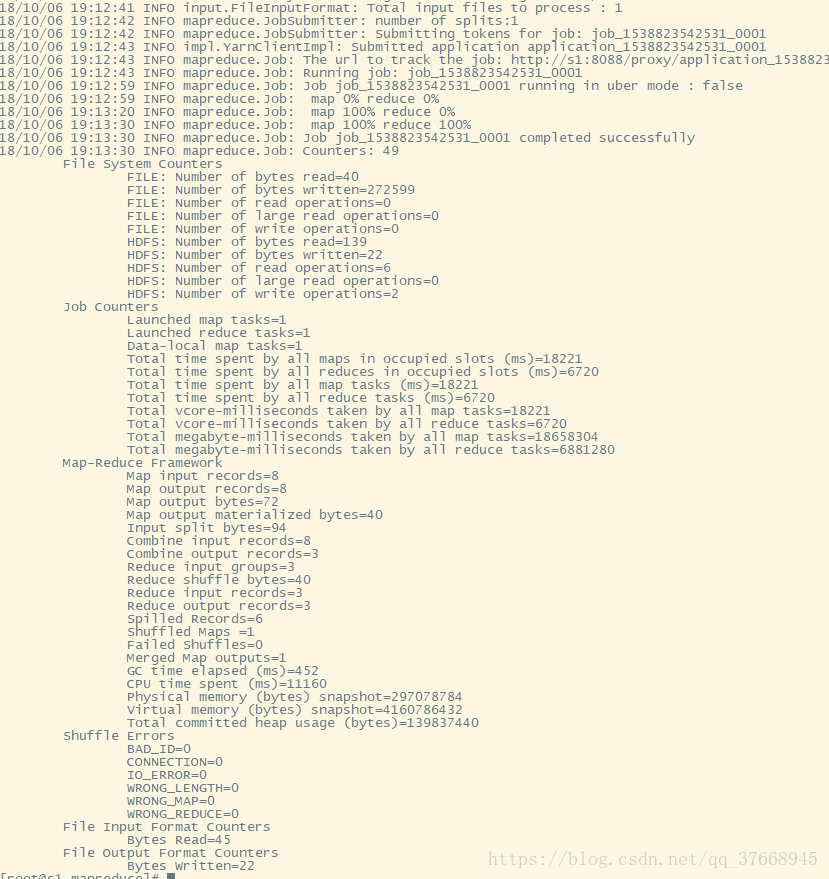

执行成功

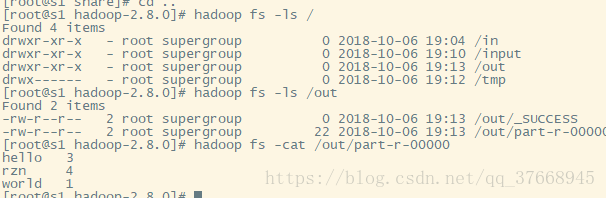

查看结果

hadoop fs -cat /out/part-r-00000