BRISK算法是2011年ICCV上《BRISK:Binary Robust Invariant Scalable Keypoints》文章中,提出来的一种特征提取算法,也是一种二进制的特征描述算子。

它具有较好的旋转不变性、尺度不变性,较好的鲁棒性等。在图像配准应用中,速度比较:SIFT<SURF<BRISK<FREAK<ORB,在对有较大模糊的图像配准时,BRISK算法在其中表现最为出色。

BRISK算法

特征点检测

BRISK算法主要利用FAST9-16进行特征点检测(为什么是主要?因为用到一次FAST5-8),可参见博客:FAST特征点检测算法。要解决尺度不变性,就必须在尺度空间进行特征点检测,于是BRISK算法中构造了图像金字塔进行多尺度表达。

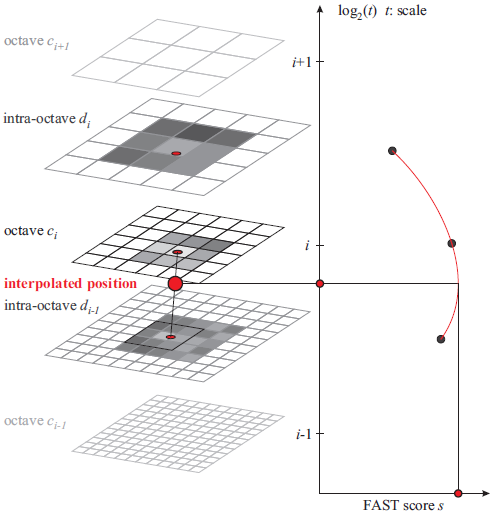

建立尺度空间

构造n个octave层(用ci表示)和n个intra-octave层(用di表示),文章中n=4,i={0,1,...,n-1}。假设有图像img,octave层的产生:c0层就是img原图像,c1层是c0层的2倍下采样,c2层是c1层的2倍下采样,以此类推。intra-octave层的产生:d0层是img的1.5倍下采样,d1层是d0层的2倍下采样(即img的2*1.5倍下采样),d2层是d1层的2倍下采样,以此类推。

特征点检测

对这8张图进行FAST9-16角点检测,得到具有角点信息的8张图,对原图像img进行一次FAST5-8角点检测(当做d(-1)层,虚拟层),总共会得到9幅有角点信息的图像。

非极大值抑制

对这9幅图像,进行空间上的非极大值抑制(同SIFT算法的非极大值抑制):特征点在位置空间(8邻域点)和尺度空间(上下层2x9个点),共26个邻域点的FAST的得分值要最大,否则不能当做特征点;此时得到的极值点还比较粗糙,需要进一步精确定位。

亚像素插值

进过上面步骤,得到了图像特征点的位置和尺度,在极值点所在层及其上下层所对应的位置,对FAST得分值(共3个)进行二维二次函数插值(x、y方向),得到真正意义上的得分极值点及其精确的坐标位置(作为特征点位置);再对尺度方向进行一维插值,得到极值点所对应的尺度(作为特征点尺度)。

特征点描述

高斯滤波

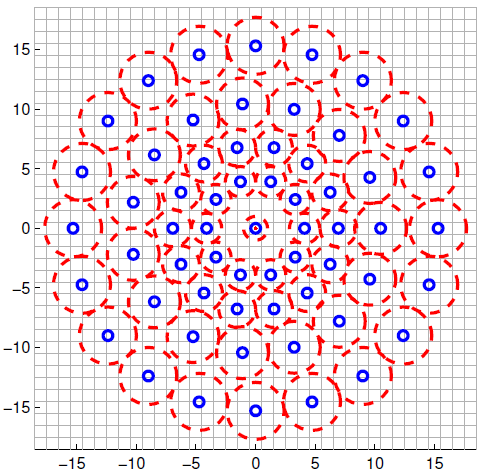

现在,我们得到了特征点的位置和尺度(t)后,要对特征点赋予其描述符。均匀采样模式:以特征点为中心,构建不同半径的同心圆,在每个圆上获取一定数目的等间隔采样点(所有采样点包括特征点,一共N个),由于这种邻域采样模式会引起混叠效应,所以需要对同心圆上的采样点进行高斯滤波。

采样模式如下图,蓝圈表示;以采样点为中心,

#include<opencv2\opencv.hpp>

#include<opencv2\xfeatures2d.hpp>

using namespace cv;

using namespace xfeatures2d;

using namespace std;

int main(int arc, char** argv) {

Mat src1 = imread("1.png",IMREAD_GRAYSCALE);

Mat src2 = imread("2.png",IMREAD_GRAYSCALE);

namedWindow("input", CV_WINDOW_AUTOSIZE);

imshow("input", src1);

Ptr<BRISK> brisk = BRISK::create();

vector<KeyPoint>keypoints1, keypoints2;

Mat descriptors1, descriptors2;

brisk->detectAndCompute(src1, Mat(), keypoints1, descriptors1);

brisk->detectAndCompute(src2, Mat(), keypoints2, descriptors2);

/*Mat dst1;

drawKeypoints(src1, keypoints1, dst1);

imshow("output1", dst1);*/

BFMatcher matcher;

vector<DMatch>matches;

matcher.match(descriptors1, descriptors2, matches);

Mat match_img;

drawMatches(src1, keypoints1, src2, keypoints2, matches, match_img);

imshow("match_img", match_img);

double minDist = 1000;

for (int i = 0; i < descriptors1.rows; i++)

{

double dist = matches[i].distance;

if (dist < minDist)

{

minDist = dist;

}

}

printf("min distance is:%f\n", minDist);

vector<DMatch>goodMatches;

for (int i = 0; i < descriptors1.rows; i++)

{

double dist = matches[i].distance;

if (dist < max( 1.8*minDist, 0.02))

{

goodMatches.push_back(matches[i]);

}

}

Mat good_match_img;

drawMatches(src1, keypoints1, src2, keypoints2, goodMatches, good_match_img, Scalar::all(-1), Scalar::all(-1), vector<char>(), 2);

imshow("goodMatch", good_match_img);

vector<Point2f>src1GoodPoints, src2GoodPoints;

for (int i = 0; i < goodMatches.size(); i++)

{

src1GoodPoints.push_back(keypoints1[goodMatches[i].queryIdx].pt);

src2GoodPoints.push_back(keypoints2[goodMatches[i].trainIdx].pt);

}

Mat P = findHomography(src1GoodPoints, src2GoodPoints, RANSAC);

vector<Point2f> src1corner(4);

vector<Point2f> src2corner(4);

src1corner[0] = Point(0, 0);

src1corner[1] = Point(src1.cols, 0);

src1corner[2] = Point(src1.cols, src1.rows);

src1corner[3] = Point(0, src1.rows);

perspectiveTransform(src1corner, src2corner, P);

line(good_match_img, src2corner[0] + Point2f(src1.cols, 0), src2corner[1] + Point2f(src1.cols, 0), Scalar(0, 0, 255), 2);

line(good_match_img, src2corner[1] + Point2f(src1.cols, 0), src2corner[2] + Point2f(src1.cols, 0), Scalar(0, 0, 255), 2);

line(good_match_img, src2corner[2] + Point2f(src1.cols, 0), src2corner[3] + Point2f(src1.cols, 0), Scalar(0, 0, 255), 2);

line(good_match_img, src2corner[3] + Point2f(src1.cols, 0), src2corner[0] + Point2f(src1.cols, 0), Scalar(0, 0, 255), 2);

imshow("result", good_match_img);

waitKey(0);

return 0;

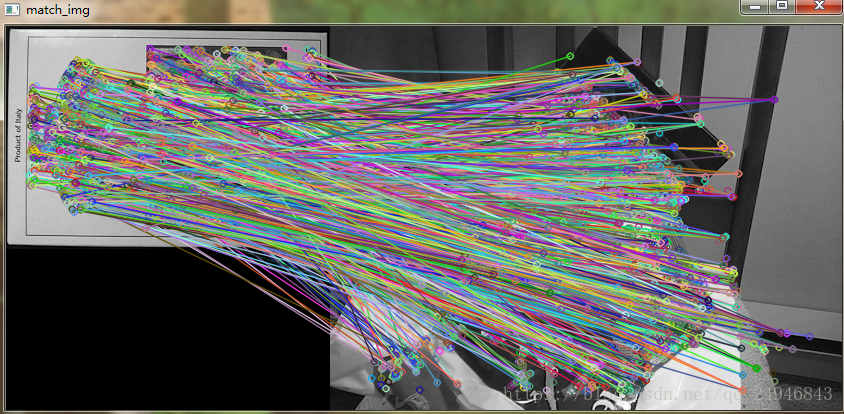

}Bruteforce匹配结果:

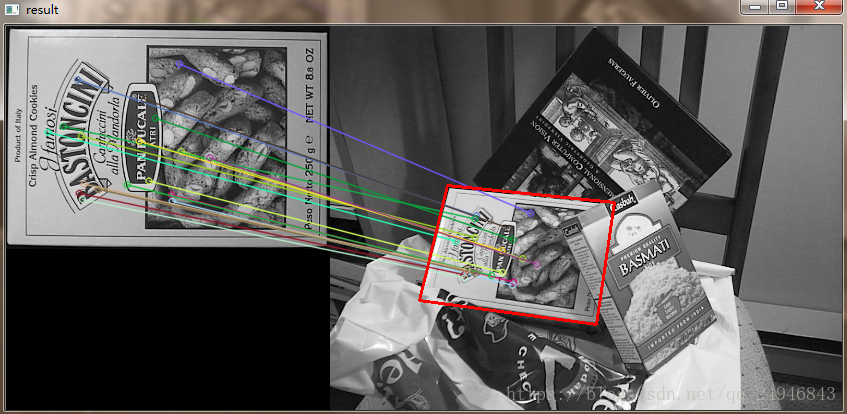

优良匹配结果:

透视变换检测 结果:

参考文献:https://blog.csdn.net/hujingshuang/article/details/47045497