1.Dual Support Vector Machine::Motivation of Dual SVM

上一节我们知道要如下求SVM的解,但是二次规划有一个问题那就是当w的系数很多即d很大时,二次规划将很难求解,这样就限制了我们的边界不能是很复杂的边界。

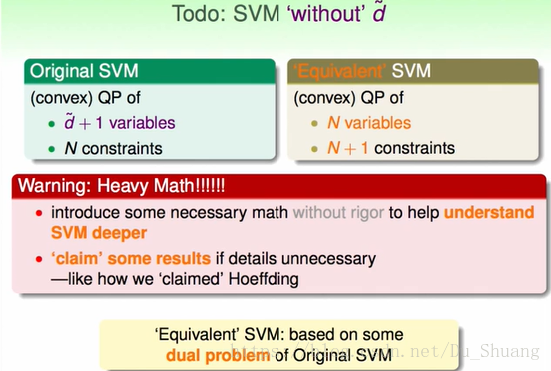

这里我们将标准问题转换为对偶问题,对偶问题的结果与标准问题一样,但是对偶问题的变量数和限制条件数将只和数据量有关系而和d无关。

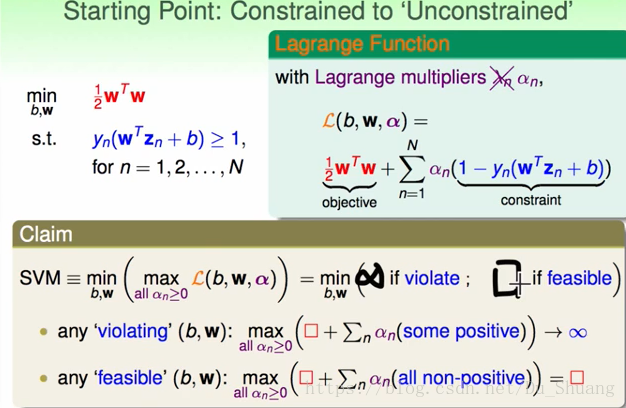

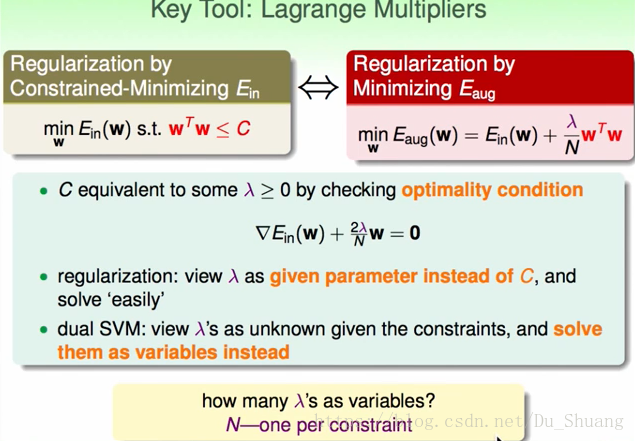

我们的目标是通过将条件写入式子将条件消除就像之前的正则化一样,不同的是正则化的λ是C的代替,而SVM的λ是我们要求解的未知数。

我们将标准式子写成下图右上角的拉格朗日函数,这样我们就将条件全部消除掉了。

然后我们对式子求

这时我们带入一对(w,b)进入式子,进行求解。当(w,b)不满足标准式子的条件时,我们发现式子的结果将是无穷大,当(w,b)满足标准式子的条件时,结果就是

.结果与我们的标准式子一模一样。所以尽管我们把条件去除了,计算拉格朗日函数的结果仍然与标准式子一样。

2.Largange Dual SVM

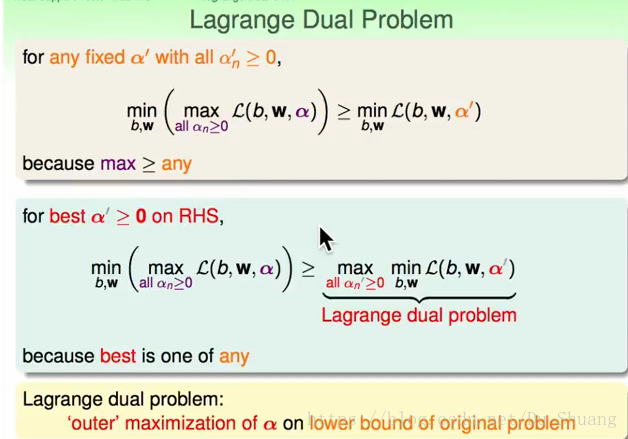

对拉格朗日函数式,我们发现有如下性质:

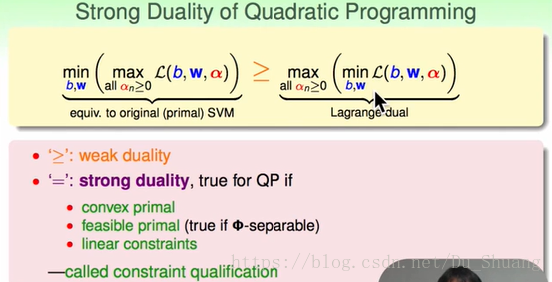

当中间为不等式时,我们称左边的式子和右边的式子为弱对偶关系,当为等式时为强对偶关系。

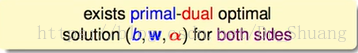

然后人们发现当左边的优化问题为凸的,有解且条件是线型的那个若对偶关系可以转换为强对偶关系。那么我们就能通过解右边的式子得到左边式子的解。

那么解右边的式子有什么好处呢?右边的式子在解(b,w)的时候是没有条件的,这就会充分降低我们求解的难度。

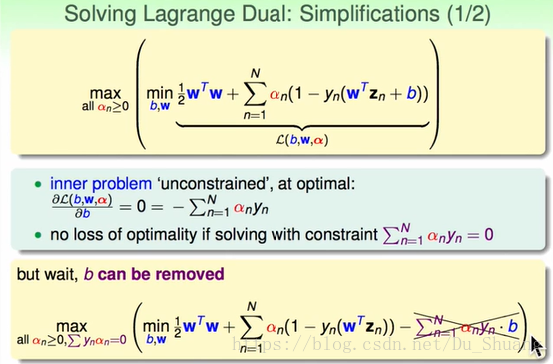

然后我们对右边的方程式进行求解:

首先对b求导,得到一个关系,然后将该关系带入原式,得到如下的式子:

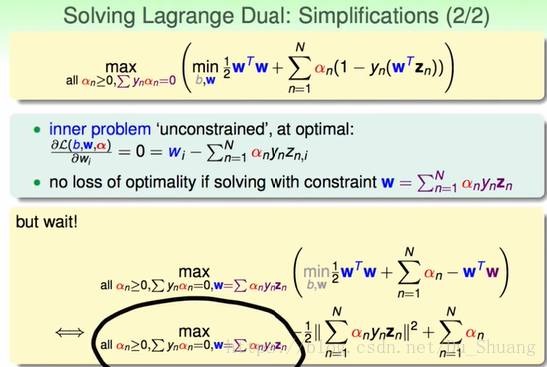

然后再对w求导我们得到另一个关系,然后将该关系带入原式,得到如下的式子:

式子最后只剩下α,极大的方便了我们最后求

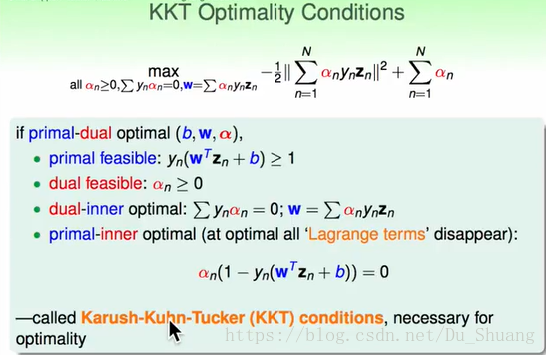

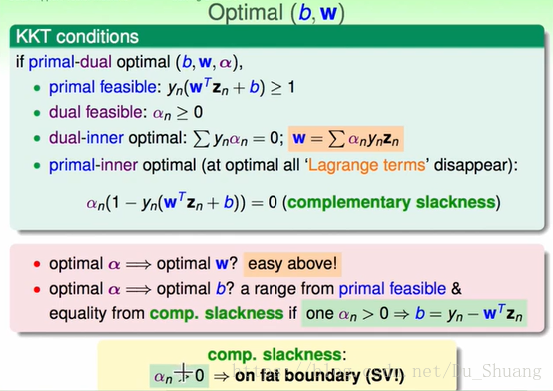

对上述进行总结,人们发现了最终解(b,w,α)所满足的一些条件:

1.w,b满足原来式子的条件(废话)

2.

(拉格朗日函数的条件)

3.要满足两个求导所得到的关系式(废话)

4.

(当”1”成立时第”4”一定会成立)

人们发现上述四个条件不仅是方程式解的必要条件,同时也是充分条件,于是我们能通过这些条件来求解(b,w,α).

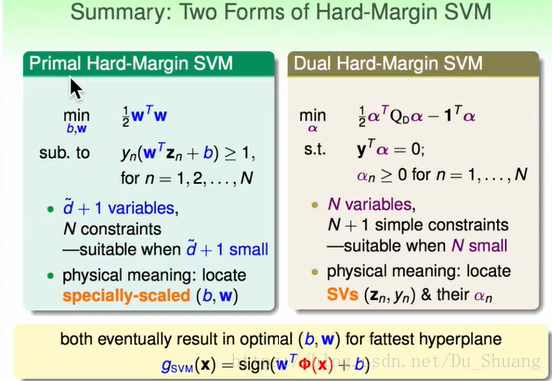

3.Solving Dual SVM

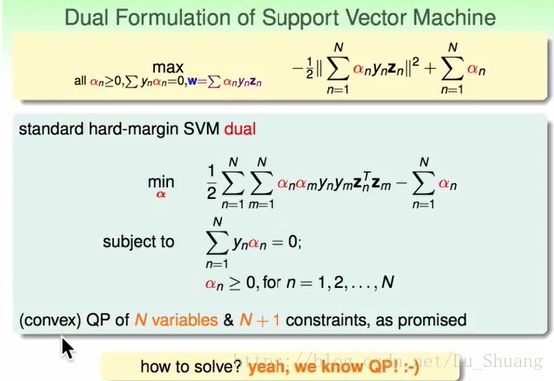

我们接下来将求解之前的对偶问题,首先将之前的对偶问题展开,本来有三个条件但是我们只写了两个条件,因为第三个条件是w和α的关系与求解α无关,我们暂时忽略掉。

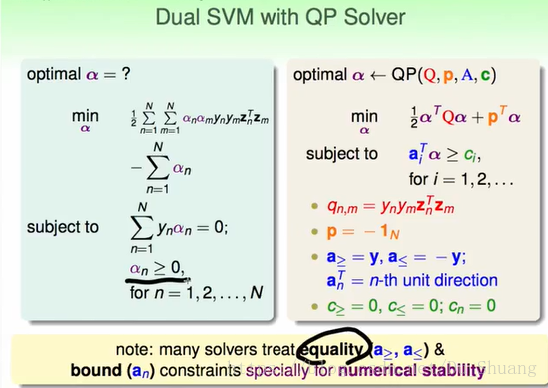

由上我们得到了新的二次规划式,然后我们求得其系数并带入求解即可得到我们需要的α。在求解系数的过程中,我们用大于等于0,和小于等于0两个条件来等价等于0这个条件。

但是我们发现上述的q矩阵是个非稀疏的矩阵,当N很大时q将无比之大我们该怎么来存储这个矩阵呢?不过还好有专门为解决SVM的QP公式求解准备的求解工具,我们建议使用专门工具求解。

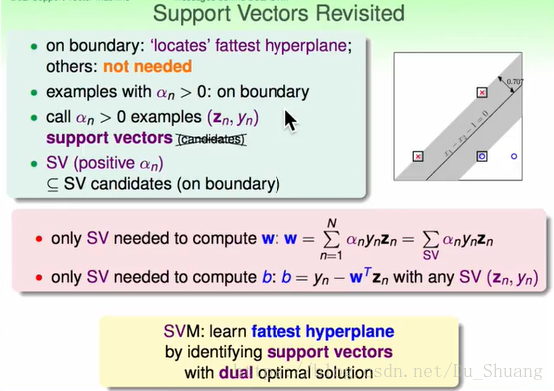

求出α后我们在利用KKT条件求出(w,b):我们发现只有当

大于0的点才能求解出(w,b)而这些点恰好是在胖线的边界上的点。

4.Messages behind Dual SVM

我们发现不管是计算w还是b我们只需要α大于0的点,我们称α大于0对应的点为支持向量,这个支持向量一定是边界上的点,但是不是边界上的点一定是支持向量。

所以对偶问题可以解释成寻找支持向量的过程。

我们将SVM和PLA进行对比发现他们的w都能够被数据所线型表示,PLA的W是犯错的向量

与犯错次数

的乘积之和,而SVM的w是支持向量

与

的乘积之和。

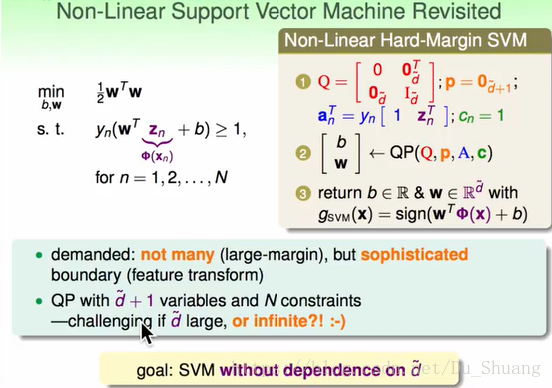

我们将对偶问题与原始问题进行对比,原始问题当我们将x映射到高维空间时,我们要求的w数量可能会是无穷大,这样我们是无法求解的,所以这限制我们不能够使用d+1很大的线型进行分割。

而对偶问题,我们的求解变量α最多只有N个所以当数据量不大时我们能够很方便的求出我们想要的结果。

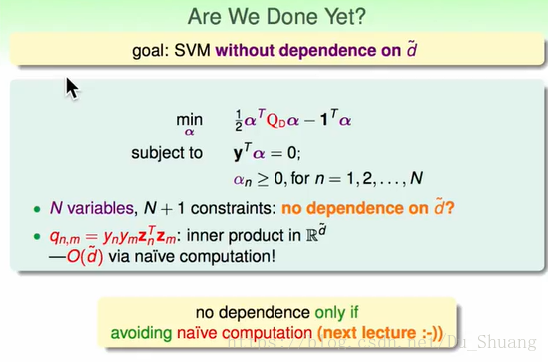

但是实际上我们真的能够通过对偶问题计算无限高维的空间的w吗?实际上是不能!

1.数据量的大小与d有关,当d很大时要想学到东西N也必须得很大。

2.如下图所示,在求解二次规划问题时,对偶问题的q系数要求计算输入空间数据z的内积,这时d很大我们依然不能进行计算。

所以原始问题的计算问题只是转移到对偶问题的q矩阵里面而已,并没有消失。

那么我们干嘛还有费力的转换成对偶问题呢?

请听下回。