一、逻辑回归介绍

Logistic 回归,虽然名字叫逻辑回归,但是它并不是一个回归模型,而是分类模型。利用逻辑回归进行分类的主要思想是: 根据现有数据对分类边界线建立回归公式。介绍它的真正原理之前,我们要介绍一下回归的概念,那么什么是回归呢?假设我们现在有一堆数据点,我们用一条直线对这些点进行拟合,这个拟合的过程就叫做回归,而这条直线呢,我们就称为最佳拟合直线。

正如上面所说的,我们利用logistic 回归进行分类,要建立回归公式,那么我们需要找到最佳的回归系数,也就是下面我们即将介绍到的最优化方法—梯度上升法,来求最佳回归系数。

二、 Sigmoid 函数(单位越阶函数)

首先,我们要知道逻辑回归主要处理的是标称型数据,即我们希望当我接受输入后,能直接预测出类别。 而Sigmoid函数就提供了这么一个性质,即可以输出0或1。

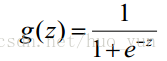

sigmoid 函数的公式:

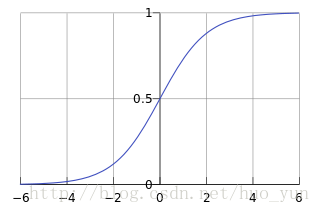

下面是这个公式对应的线性曲线图:

从上图以及公式我们可以得出:

Sigmoid函数是随着z自变量的增大而增大,并且取值范围是在0~1之间,当z = 0 时,sigmoid(z) = 0.5。 所以0.5 是我们 的分界线,当sigmoid(z) > 0.5 的数据被分为1类,反之被归为0类。

因此为了实现logistic 回归分类器,我们可以在每个特征上都乘以一个回归系数,然后求总和,即z 带入到sigmoid函数中,则可以进行分类。 由此,我们可以得到求z的公式:

z=w_0 x_0+w_1 x_1+w_2 x_2+…w_n x_n=W^(T ) X

其中向量X 是分类器的输入数据,向量W就是我们要找的最佳参数(系数)。下面我们采用梯度上升法,求最佳回归系数。

三、梯度上升法

基本思想:找到函数的最大值,在数学上可以理解为对函数求偏导,即沿X轴方向移动

沿y的方向移动:

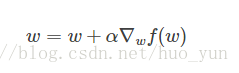

上面只是确定了函数增长的方向,但是并没有提到移动量的大小。该量值称为步长,即α。梯度上升算法的迭代公式如下:

四、代码实现:

- 加载样本数据集

def loadDataSet():

dataMat = [];

labelMat = []

fr = open('testSet.txt')

for line in fr.readlines():

lineArr = line.strip().split()

dataMat.append([1.0, float(lineArr[0]), float(lineArr[1])])

labelMat.append(int(lineArr[2]))

return dataMat, labelMat- sigmoid 函数公式

def sigmoid(inX):

return 1.0 / (1 + exp(-inX))- 梯度上升算法

def gradAscent(dataMatIn, classLables):

dataMatrix = mat(dataMatIn)

labelMat = mat(classLables).transpose()

m, n = shape(dataMatrix)

alpha = 0.001

maxCycles = 500

weights = ones((n, 1))

# print "w:", weights

for k in range(maxCycles):

h = sigmoid(dataMatrix * weights)

# print "h:", h

error = (labelMat - h)

# print "error:", error

weights = weights + alpha * dataMatrix.transpose() * error

# print "weights:", weights

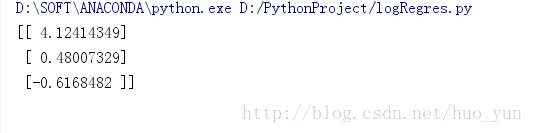

return weights运行结果如下:

以上函数返回了一组回归系数,它确定了不同类别数据之间的分割线,有了这组回归系数,利用上面的线性回归方程,即可以画出最佳拟合线,下面的函数是绘画最佳拟合线:

def plotBestFit(weights):

import matplotlib.pyplotasplt

dataMat,labelMat=loadDataSet()

dataArr=array(dataMat)

n=shape(dataArr)[0]

xcord1=[];

ycord1=[]

xcord2=[];

ycord2=[]

foriinrange(n):

ifint(labelMat[i])==1:

xcord1.append(dataArr[i,1]);

ycord1.append(dataArr[i,2])

else:

xcord2.append(dataArr[i,1]);

ycord2.append(dataArr[i,2]);

fig=plt.figure()

ax=fig.add_subplot(111)

ax.scatter(xcord1,ycord1,s=30,c='red',marker='s')

ax.scatter(xcord2,ycord2,s=30,c='green')

x=arange(-3.0,3.0,0.1)

y=(-weights[0]-weights[1]*x)/weights[2]

ax.plot(x,y)

plt.xlabel('X1');

plt.ylabel('X2')

plt.show()main 方法运行:

if __name__ == '__main__':

dataArr, labelMat = loadDataSet()

weights0 = gradAscent(dataArr, labelMat)

print weights0

plotBestFit(weights0.getA())