0.概述

线性回归不仅可以做回归问题的处理,也可以通过与阈值的比较转化为分类的处理,但是其假设函数的输出范围没有限制,这样很大的输出被分类为1,较少的数也被分为1,这样就很奇怪。而逻辑回归的假设函数的输出范围是0~1。

当数据集中含有误差点时,使用线性回归相应的误差也会很大。

逻辑回归其实是分类算法,但是由于历史原因被称为逻辑回归。

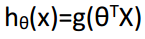

逻辑回归的假设函数以线性回归的假设函数为基础,通过S形函数进行复合形成的复合函数。

虽然逻辑回归的代价函数和线性回归的代价函数在形式上是一样的,但是假设函数不一样,因而实际上是不一样的。

逻辑回归是一种非常强大,甚至可能世界上使用最为广泛的一种分类算法。

1.分类问题

逻辑回归是一种分类算法

在分类问题中,要预测的变量y是离散的值

逻辑回归是目前最流行使用最广泛的一种学习算法

2.假说表示

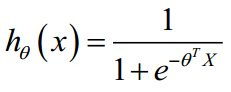

假设函数的要求:由于逻辑回归这种分类器要求的输出值在0和1之间,因此需要想出一个满足预测值在0到1之间的假设函数

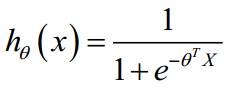

逻辑回归的假设模型:

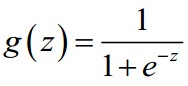

其中,X代表特征向量,g代表逻辑函数(logistic function)是一个常用的逻辑函数为S形函数(Sigmoid function)。

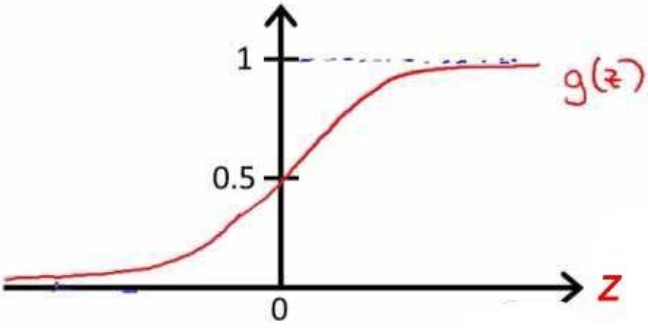

S形函数(Sigmoid function):

该函数的图像为:

合起来,我们得到逻辑回归模型的假设:

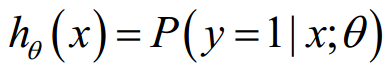

hθ(x)的作用是,对于给定的输入变量,根据选择的参数计算输出变量=1 的可能性(estimated probablity)即

假设函数的值为0.7,则表示有70%的几率y为正向类。

3.决策边界

决策边界(decision boundary)由假设函数决定,理论上可以为任意曲线。

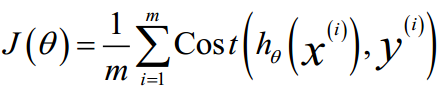

4.代价函数

对于线性回归模型,代价函数是所有模型误差的平方和。但是在逻辑回归中,假设函数带入到误差平方和模型中,假设函数将会是一个非凸函数(non-convex function),这样有许多局部最小值,这将影响梯度下降算法寻找全局最小值。

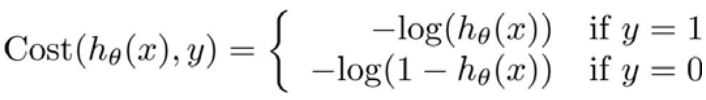

逻辑回归的代价函数:

,其中

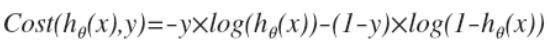

将构建的 Cost(hθ(x),y)简化如下:

逻辑回归的代价函数是关于输入变量theta 0、theta 1、…、theta n的一个函数。

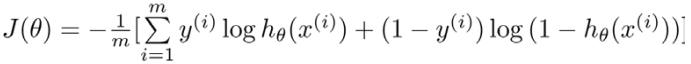

带入代价函数得到:

在得到这样一个代价函数以后,我们便可以用梯度下降算法来求得能使代价函数最小的参数了。

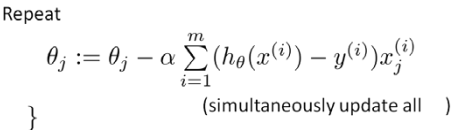

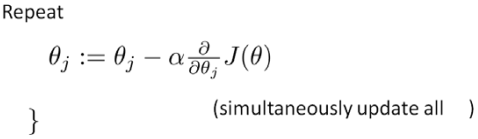

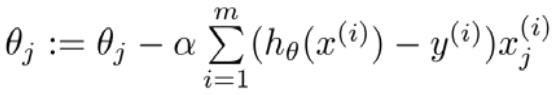

梯度下降:

求导后得到:

5.简化的代价函数和梯度下降

逻辑回归和线性回归的梯度下降公式看上去一样,都是:

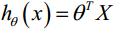

但是其假设函数不一样

线性回归假设函数:

逻辑回归假设函数:

6.高级优化

除了梯度下降法,还有共轭梯度法、BFGS(变尺度法)和L-BFGS(限制变尺度法),这三种算法的优点是不需要手动选择学习率,比梯度下降法快,缺点是更加复杂。

7.多类别分类:一对多

我们将谈到如何使用逻辑回归 (logistic regression)来解决多类别分类问题,具体来说,可以通过一个叫做”一对多” (one-vs-all) 的分类算法。

假设一个训练集有三个类别,可以转化为三个两元分类的问题。

最后,在我们需要做预测时,我们将所有的分类机都运行一遍,然后对每一个输入变量,都选择最高可能性的输出变量。

各种可能性的概率之和为1。

原文来自:https://blog.csdn.net/u010837794/article/details/70991434