一句话概括逻辑回归:

逻辑回归假设数据服从伯努利分布,通过极大化似然函数的方法,运用梯度下降来求解参数,达到将数据二分类的目的。

原理:

有一组特征变量:

一组参数:

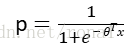

将值域归到0~1之间,则可以符合概率的值域:

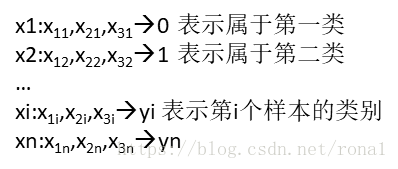

现有一组样本:

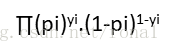

极大似然函数:

扫描二维码关注公众号,回复:

1695227 查看本文章

极大似然函数再取对数,变成对数损失函数,对数损失函数是连续可导的凸函数,可以用梯度下降求解。

特点:

很多特征高度相关,不会影响效果,但去掉高相关特征可解释性更强,还可提高训练速度。

优点:形式简单,可解释性强,训练快,内存小。

缺点:复杂的数据分布、非线性、多分类、数据不平衡效果都不好