Lightweight and High-Fidelity End-to-End Text-to-Speech with Multi-Band Generation and Inverse Short

企业开发

2023-09-19 00:25:54

阅读次数: 0

abstract

- motivation:VITS的质量很好,本文工作旨在用更小的模型、更快的推理速度实现高质量合成。

- contribution:

- 最耗时的是decoder(HFG)生成波形的模块,用iSTFTNet取代,完成频域到时域的转化;

- multi-band生成:each iSTFT module generates sub-band signals, summed to generate the full-band target waveform.

- multi-stream生成:use a trainable synthesis filter for the sub-band signals,

- result

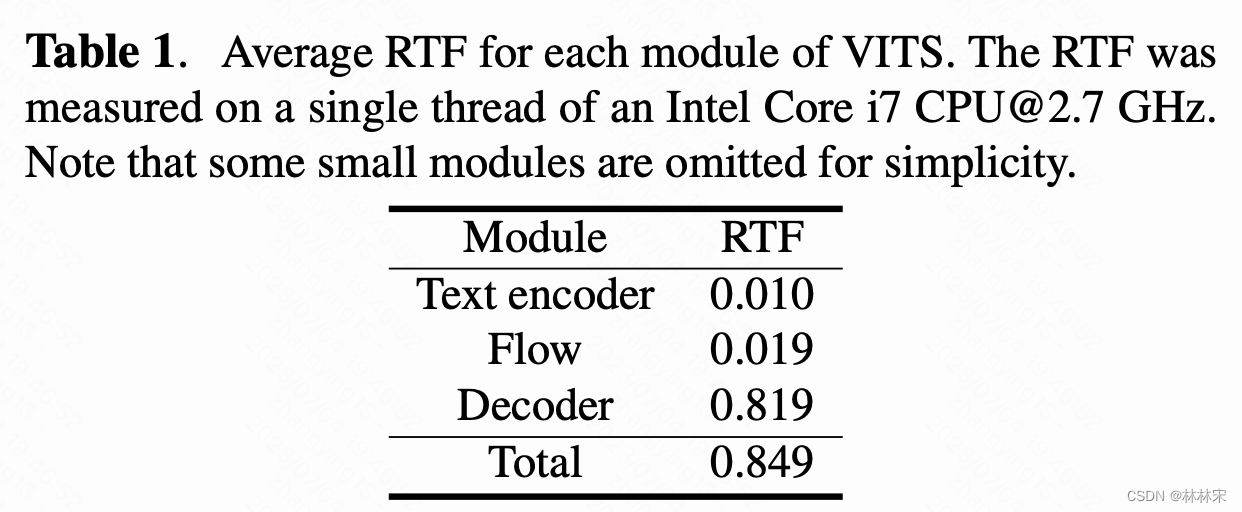

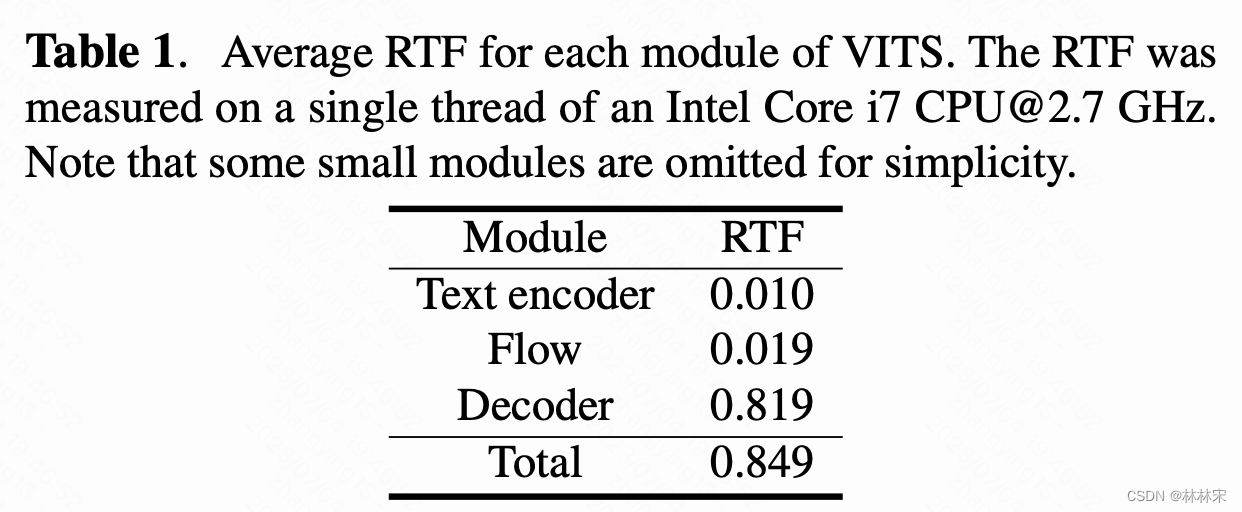

- 0.066 on an Intel Core i7 CPU, 比VITS快4.1x

- 相比于蒸馏模型(Nix-TTS,teacher-student,模型尺寸更小),当使用同样的model size时生成质量更好,因为end2end的结构比蒸馏的损失更小。

method

- VITS的decoder是HFG的结构,通过将z上采样到采样点(多次卷积上采样),消耗比较大的计算量;

- 受启发于iSTFTNet,将这一过程用逆傅立叶变换取代;

转载自blog.csdn.net/qq_40168949/article/details/131529688