MMPreTrain算法库介绍

1. 算法库与任务组成

MMPretrain是一个全新升级(MMPretrain originates from MMClassification and MMSelfSup )的预训练开源算法框架,旨在提供各种强大的预训练主干网络,并支持了不同的预训练策略。

主要功能:

(1)丰富的模型:包括主干模型、自监督学习算法、多模态学习算法

(2)数据集支持:COCO、ImageNet等常见数据集

(3)训练技巧与策略:优化器与学习率策略、数据增强策略

(4)不断提高的易用性:大量预置配置文件、预训练模型、模型训练工具、模型参数计算工具、CAM可解释性分析、各种可视化工具、部署工具等

2. 框架概览

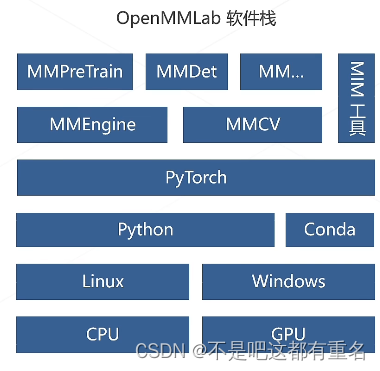

2.1 OpenMMLab软件栈

2.2 MMPreTrain安装步骤

基础安装:

conda create -n open-mmlab python=3.8 pytorch==1.10.1 torchvision==0.11.2 cudatoolkit=11.3 -c pytorch -y# 创建环境

conda activate open-mmlab # 激活环境

pip install openmim #安装mim工具

git clone https://github.com/open-mmlab/mmpretrain.git # 下载mmpretrain

cd mmpretrain #进入目录

mim install -e . #安装

多模态依赖:(使用多模态相关内容时安装)

mim install -e ".[multimodal]"

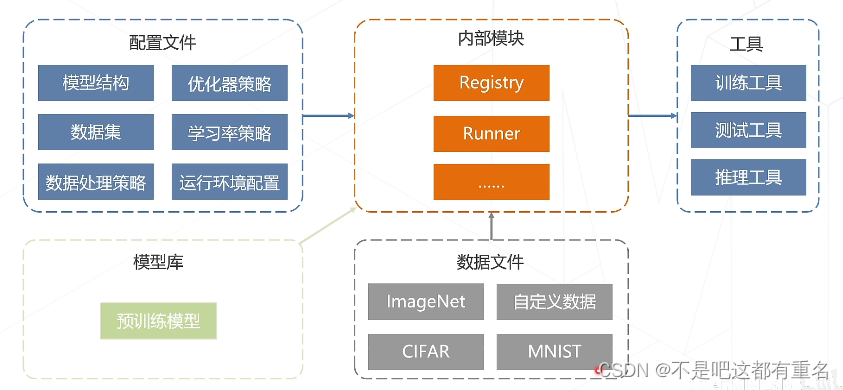

2.3 重要概念——配置文件

可以在配置文件下调整以下内容,实现自己的想法。深度学习模型的训练涉及几个方面:

(1)模型结构:模型有几层、每层多少通道等

(2)数据:数据集划分、数据文件路径、批大小、数据增强策略等

(3)训练优化:梯度下降算法、学习率参数、训练总轮次、学习率变化策略等

(4)运行时:GPU、分布式环境配置等

(5)辅助功能:打印日志、定时保存权重文件

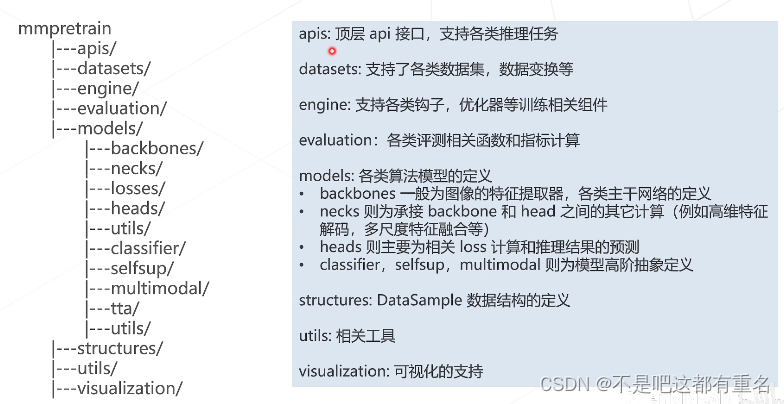

2.4 代码框架

2.5 数据流

2.6 配置文件的运作方式

经典主干网络

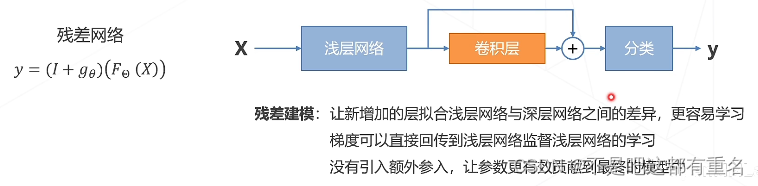

1.ResNet

反直觉的问题:卷积退化为恒等映射时,深层网络与浅层网络相同,所以,深层网络应具备不差于浅层网络的分类精度,但是实际效果却是深层网络表现的更差了。

猜想:虽然深层网络有潜力达到更高的精度,但常规的优化算法难以找到这个更优的模型,即,让新增加的卷积层拟合一个近似恒等映射,恰好可以让浅层网络变好一点。

残差学习的基本思路:

ResNet的成就和影响力:

深度学习领域影响力最大、使用最广泛的模型结构之一,获得CVPR2016最佳论文奖。残差结构也一直被广泛应用至今,不论是计算机视觉中的如今的各类视觉Transformer或者是ConvNeXt这类卷积神经网络,亦或是GPT及各类大语言模型中都有残差结构

2.Vision Transformer

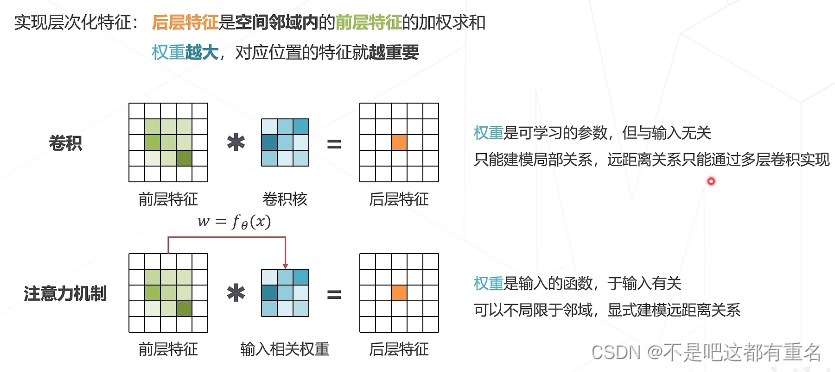

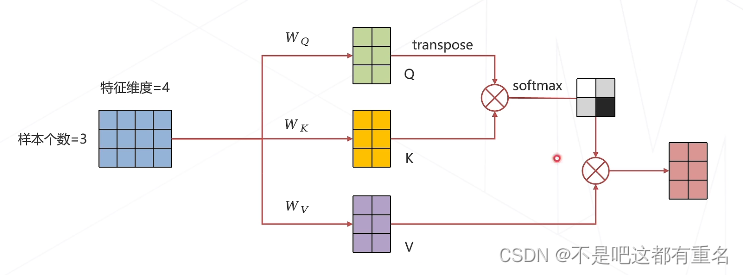

2.1 注意力机制

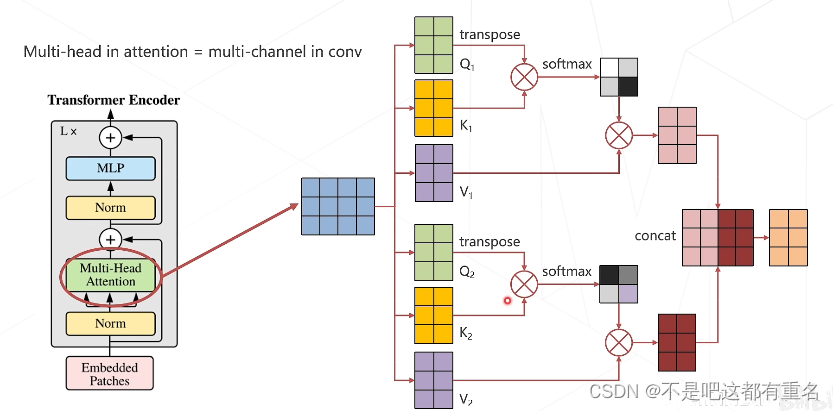

2.2 多头注意力机制

好处:计算过程中不同头的注意力可以对不同的特征分别提取,从而提升网络的性能

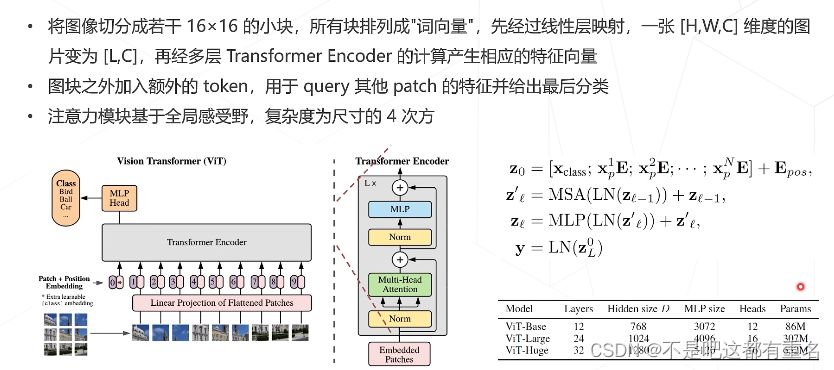

2.3 Vision Transformer

自监督学习

海量数据,标注数据少,为了利用海量数据而不依赖标注,让网络从数据本身学到对应的特征表达。

常见类型:

1.基于各种代理任务,例如图像上色等

2.基于对比学习

3.基于掩码学习

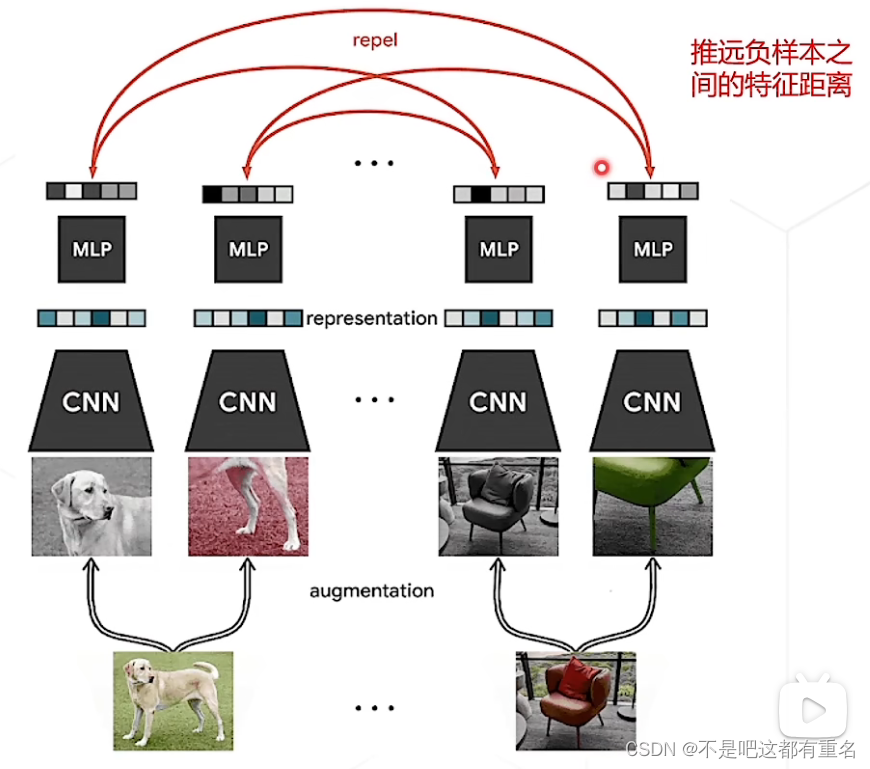

1. SimCLR

对比学习基本假设:如果模型能够很好地提取图片内容的本质,那么无论图片经过什么样的数据增强操作,提取出来的特征都应该极为相似。

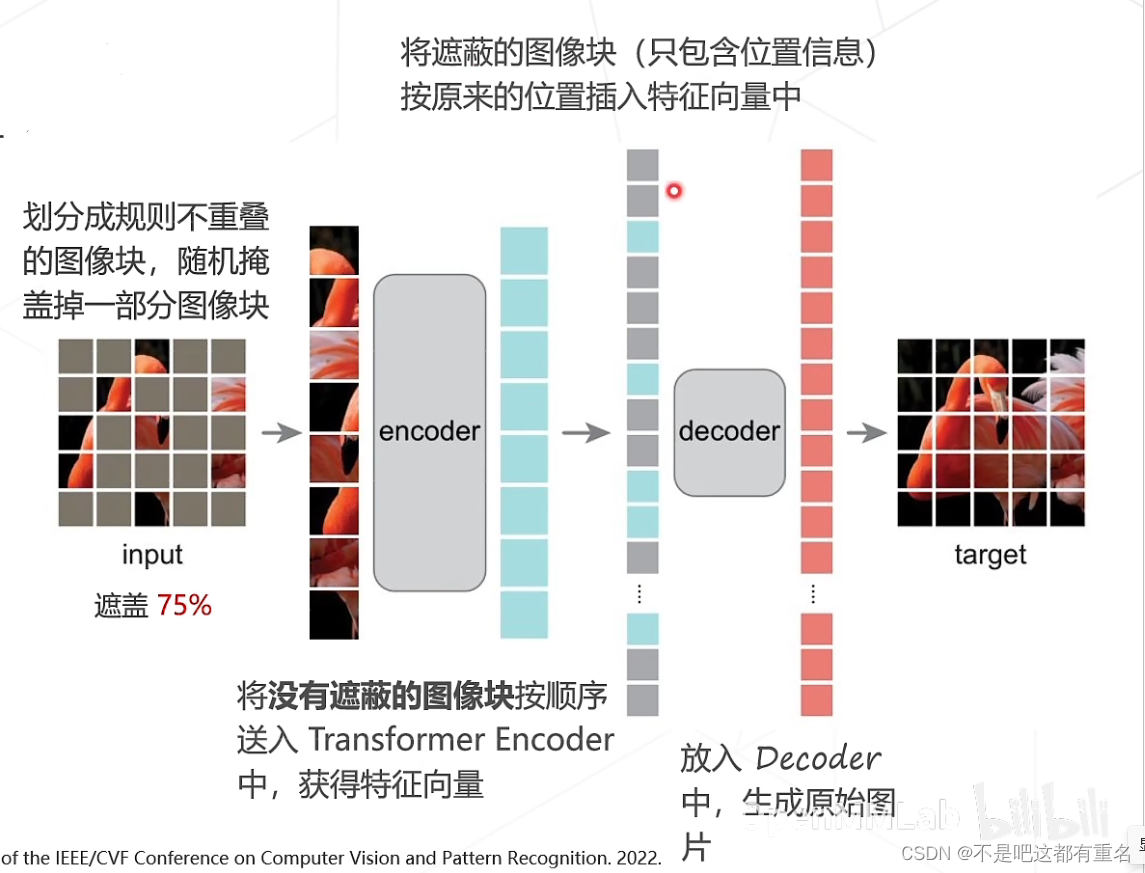

2.MAE

基本假设:模型只有理解图片内容、掌握图片的上下文信息,才能恢复出图片中被随机遮挡的内容。

多模态算法

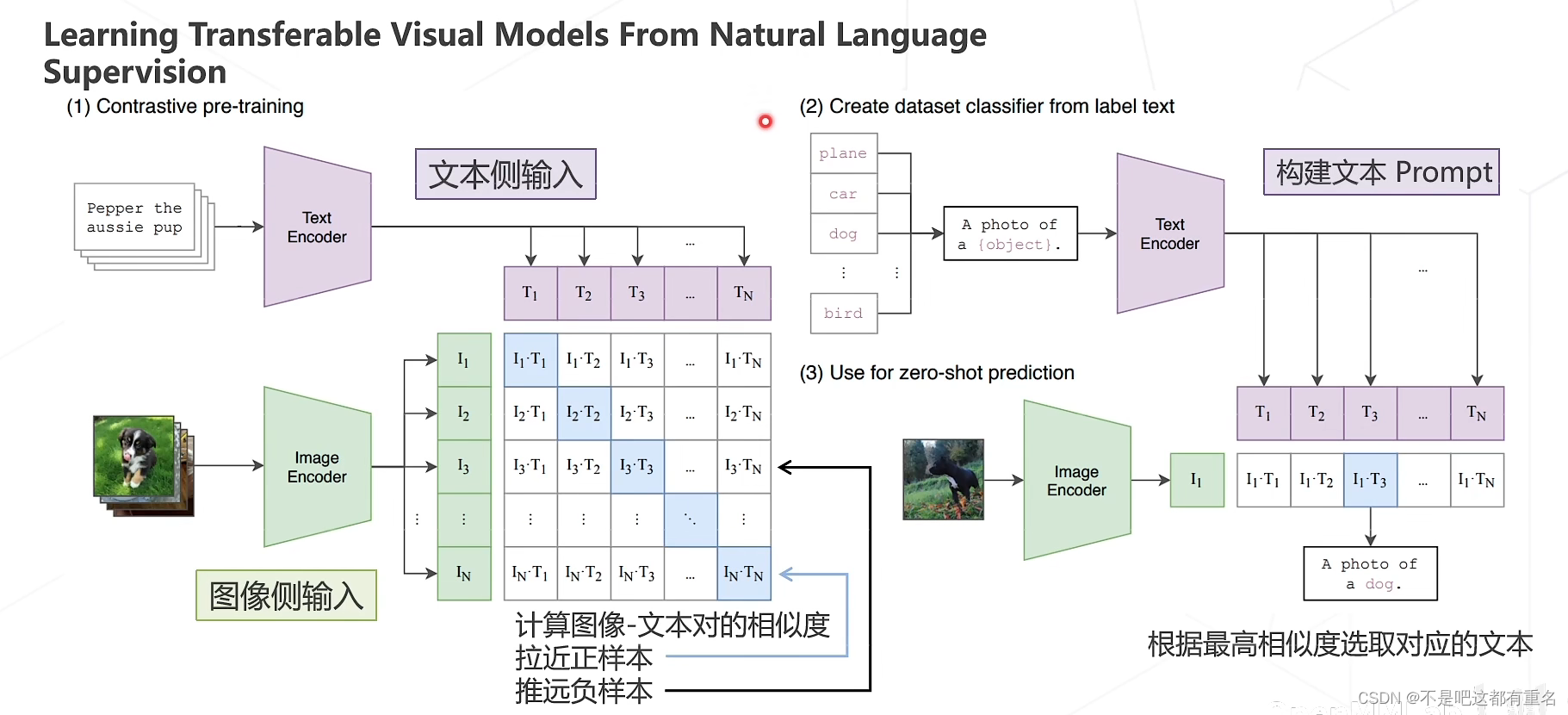

1.CLIP(ICML 2021)

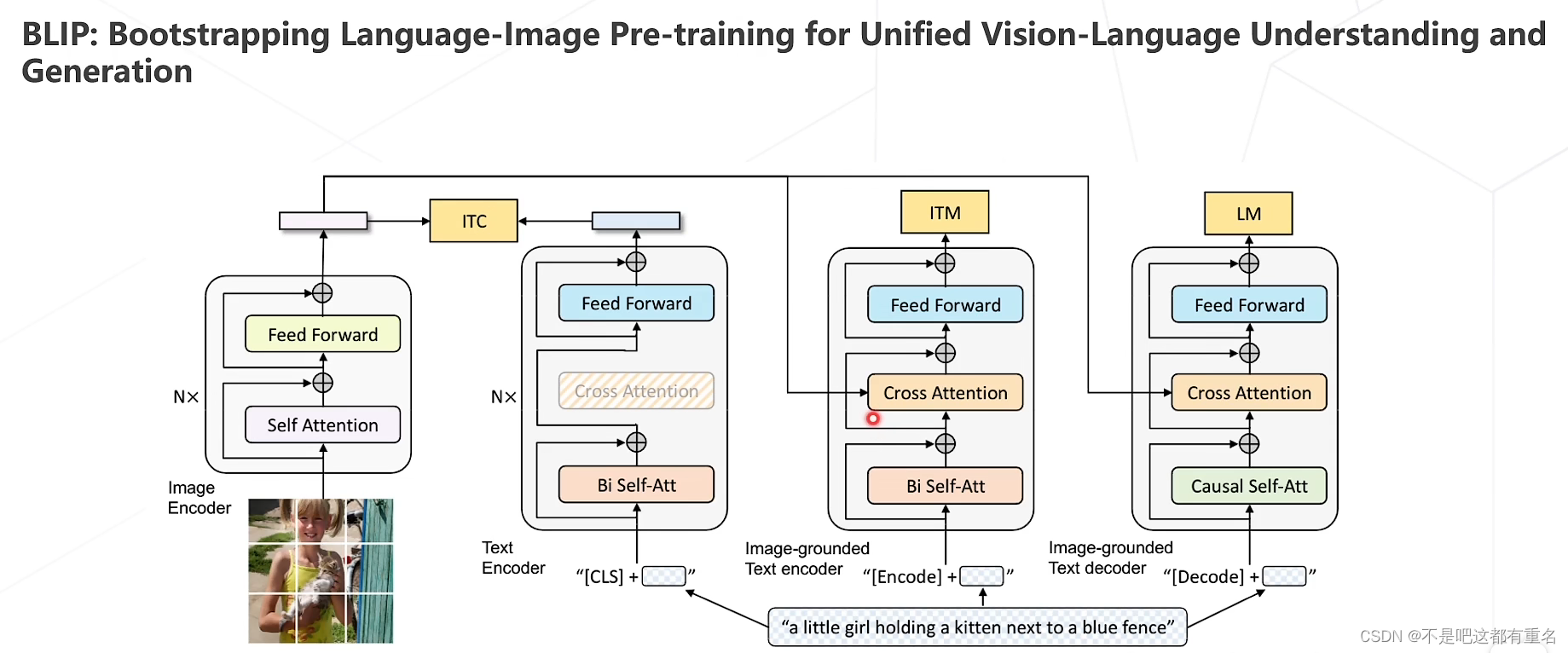

2.BLIP

ITC——Image-Text Contrastive Loss 特征区分

ITM——Image-Text Matching Loss特征匹配

LM——Language Modeling Loss文字生成

BLIP对三种loss进行了结合,以此构建了新的Vision Language Pre-training 框架,并且可以完成各类下游任务,如,图像检索,图像描述生成、视觉问答

其他多模态算法:BLIP-2、Flamingo、Kosmos-1、LLaVA