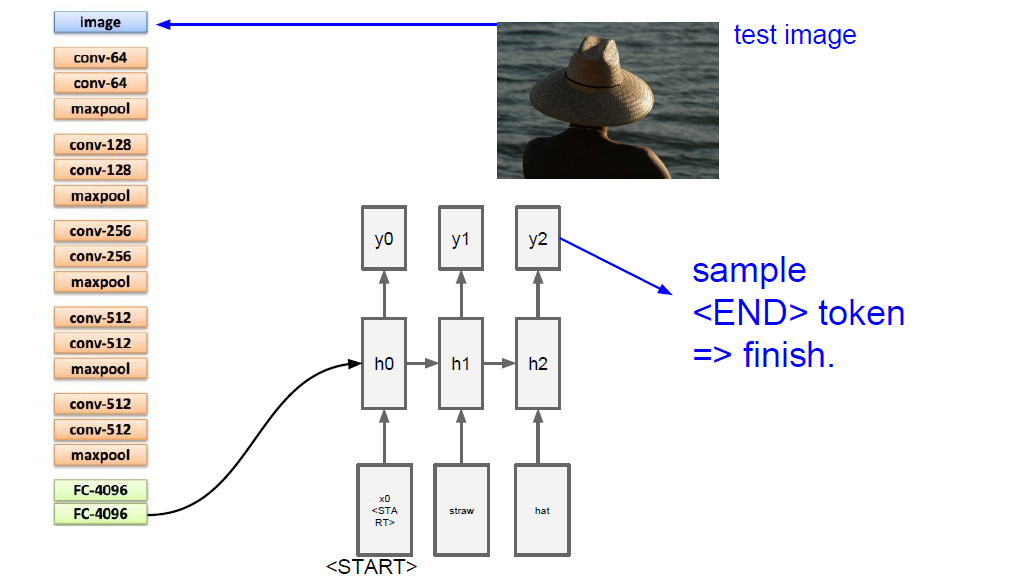

image captioning 是由CNN和RNN连接起来的网络

----------------------------------------------------------------------------------------------------------------------------

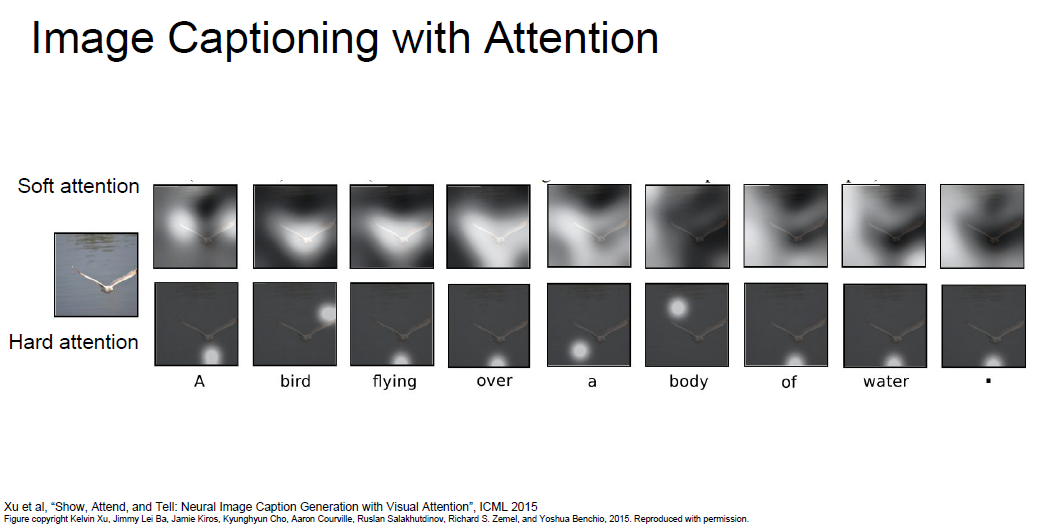

Image captioning with Attention

CNN处理图形后不再产生一个向量,而是对图片的每个位置各产生一个向量,即输入到RNN的是一个向量组

soft attention & hard attention

hard attention 不可微分,需要高级bp算法(增强学习中会介绍)

--------------------------------------------------------------------------------------------------------------------------------

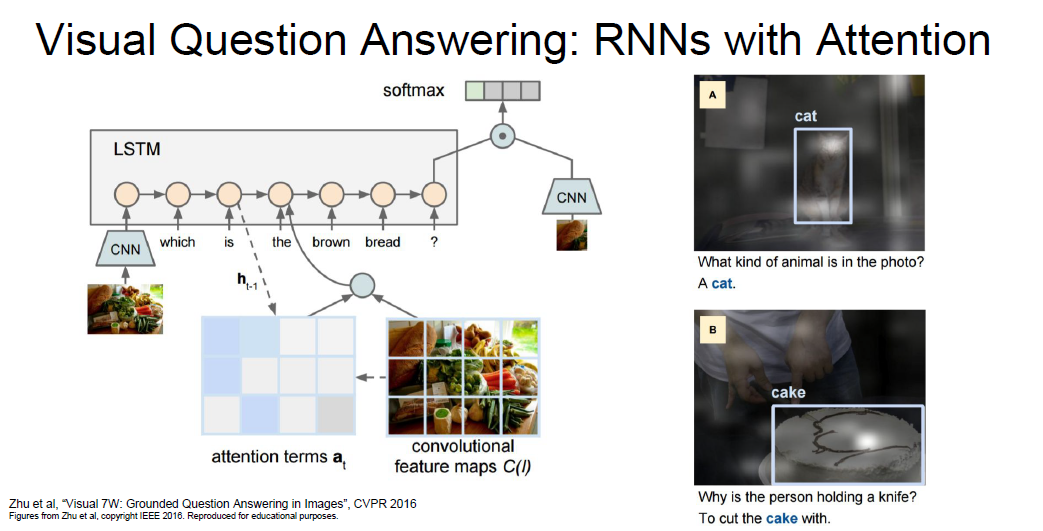

visual question answering

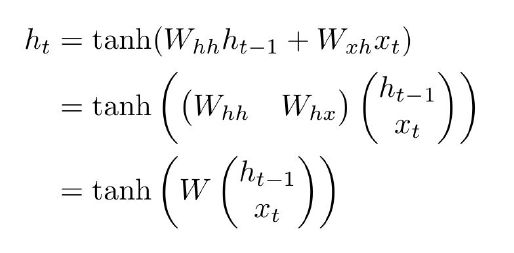

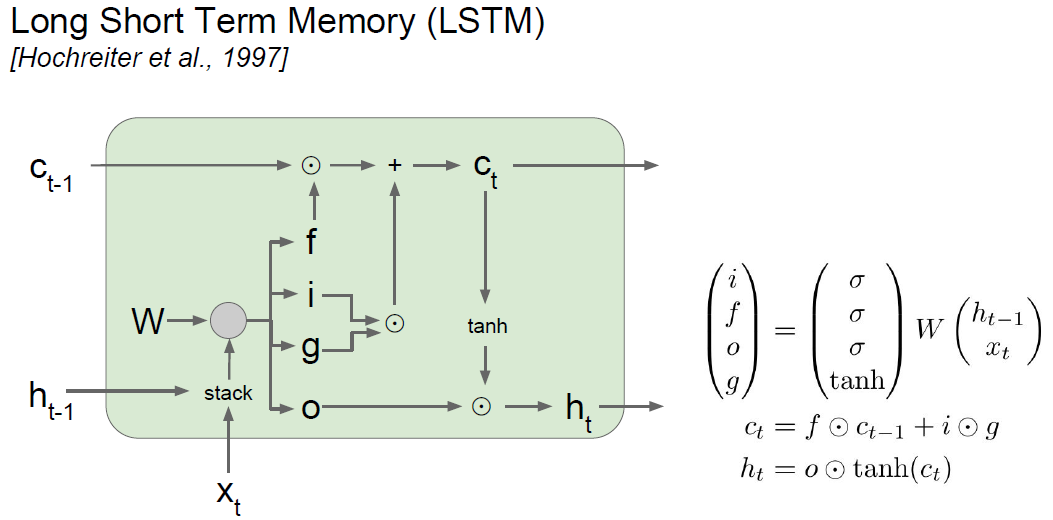

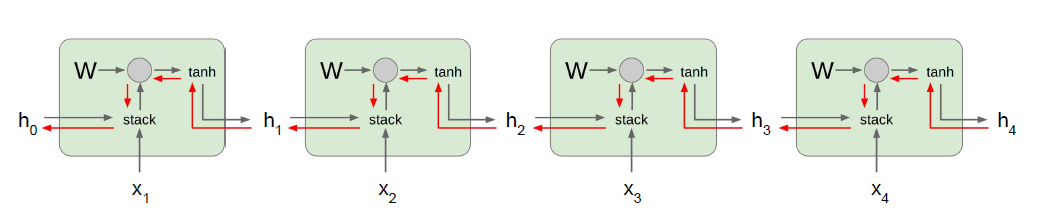

将RNN单元缩写

Whh,Whx两个矩阵横着摆放

ht-1和xt竖着摆

由于RNN序列很长,会出现梯度消失和梯度爆炸问题

梯度爆炸使用gradient clipping解决

梯度消失使用LSTM

具体的反向传播过程如下:

vanilla RNN

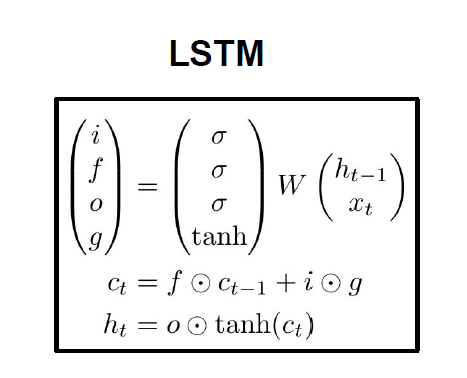

LSTM

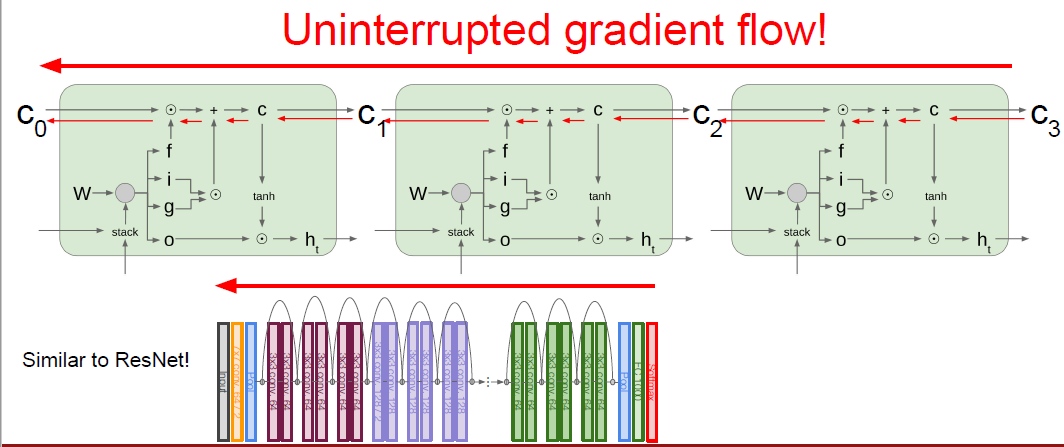

通过ct,可以传回梯度(ct能传回来梯度,对应单元的W也就有了梯度)

乘的不再是矩阵,而是f,每次乘的f不一样,所有消失的慢。而且不经过tanh

f门的偏置可以初始为较大的值,以使得激活后不为0

LSTM和GRU改变一点都会效果变差,无法改进。。。

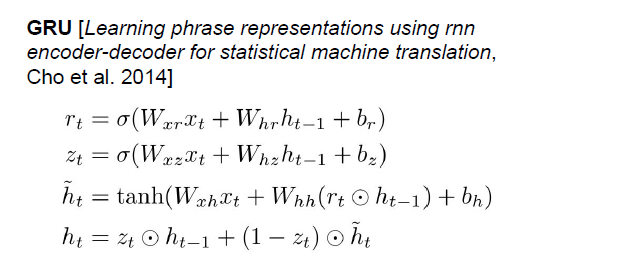

GRU如下图