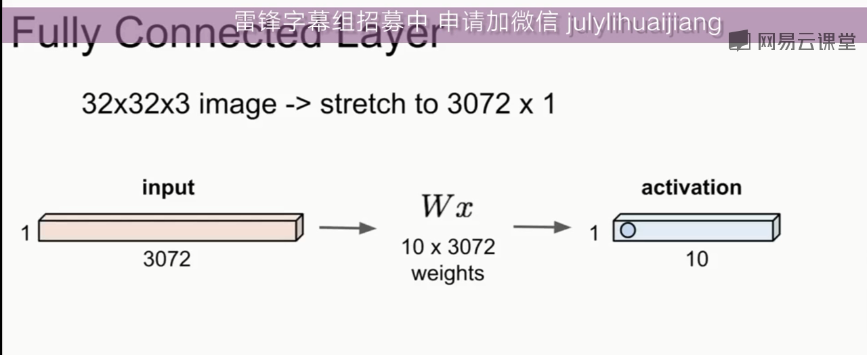

全连接

------------------------------------------------------------------------------------------------------------------------------

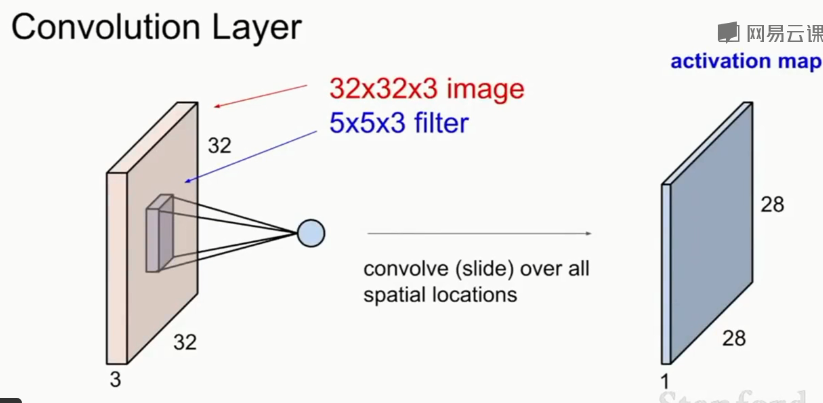

卷积

卷积通过卷积核的参数共享,减少了参数数量(非常有效)。

卷积核就是参数,需要反向传播学习得到。

卷积核与全连接的权重参数不同,它只关心局部特征。而fully connected NN的权重W关注了全部特征。

-------------------------------------------------------------------------------------------------------------------------

卷积也有激活函数,同样要RELU

---------------------------------------------------------------------------------------------------------------------------

由于需要每层结点足够多,原始图像多层卷积之后逐渐变得小而深(n_H,n_W减小,n_c增加)

---------------------------------------------------------------------------------------------------------------------------

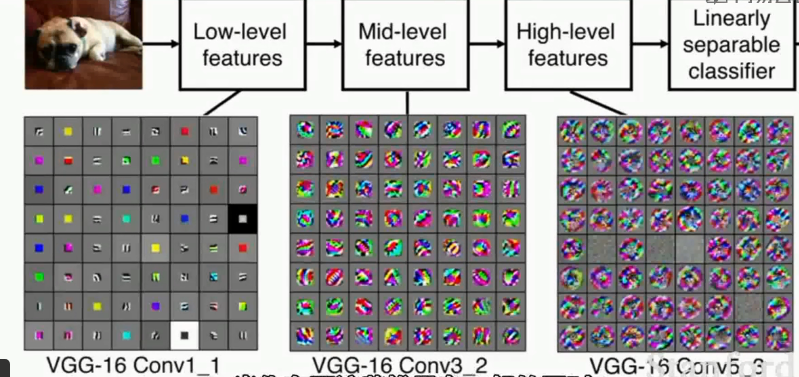

!注意,不论是全连接还是卷积,就是通过不断的特征转换,将图像特征变成线性可分的

---------------------------------------------------------------------------------------------------------------------------

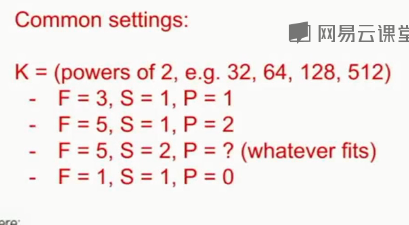

卷积后的大小

n_new = (n+2p-f)/s + 1

注意,卷积核尺寸需要与图像合适,不能空出来卷积不了的位置。即n_new需要是整数

---------------------------------------------------------------------------------------------------------------------------

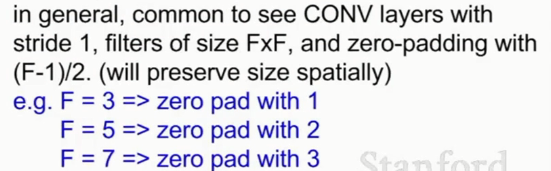

可以通过padding弥补corner的采样不足。同时可以使得图像大小(n_H,n_W)不变!

若s=1,卷积核 为 f*f ,则左右两边各采用 (f-1)/2的padding,可以使尺寸不变。

若不使用padding,尺寸会很快减小,这样的卷积神经网络的效果不会好的。

---------------------------------------------------------------------------------------------------------------------------

卷积核的数目k一般为2的指数倍