本篇的论文来自:Wang C, Blei D M. Decoupling sparsity and smoothness in the discrete hierarchical dirichlet process[C]//Advances in neural information processing systems. 2009: 1982-1989.

本博客作者:合肥工业大学 管理学院 钱洋 email:[email protected] 内容可能有不到之处,欢迎交流。

模型简介

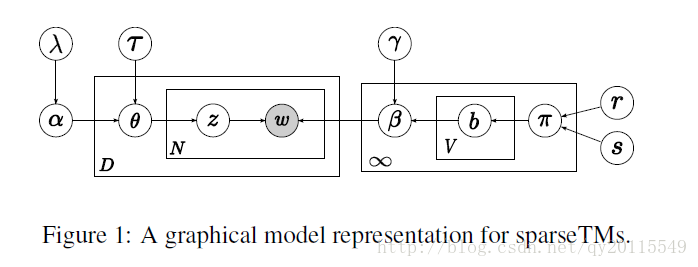

该篇文章,主要引入了“spike and slab” prior 来控住主题下词的稀疏性,即主题并不是包含所有的单词了。并且该篇文章使用的方式是非参方法,主题的数目通过学习确定。如下图所示,为sparseTM模型的概率图表示:

如下图所示为模型的生成过程:

相比较传统的LDA而言,这里的变化是每个主题包含的词的数量受到限制,这里通过贝努利分布实现词是否被分配到某一主题中。

公式推导难点

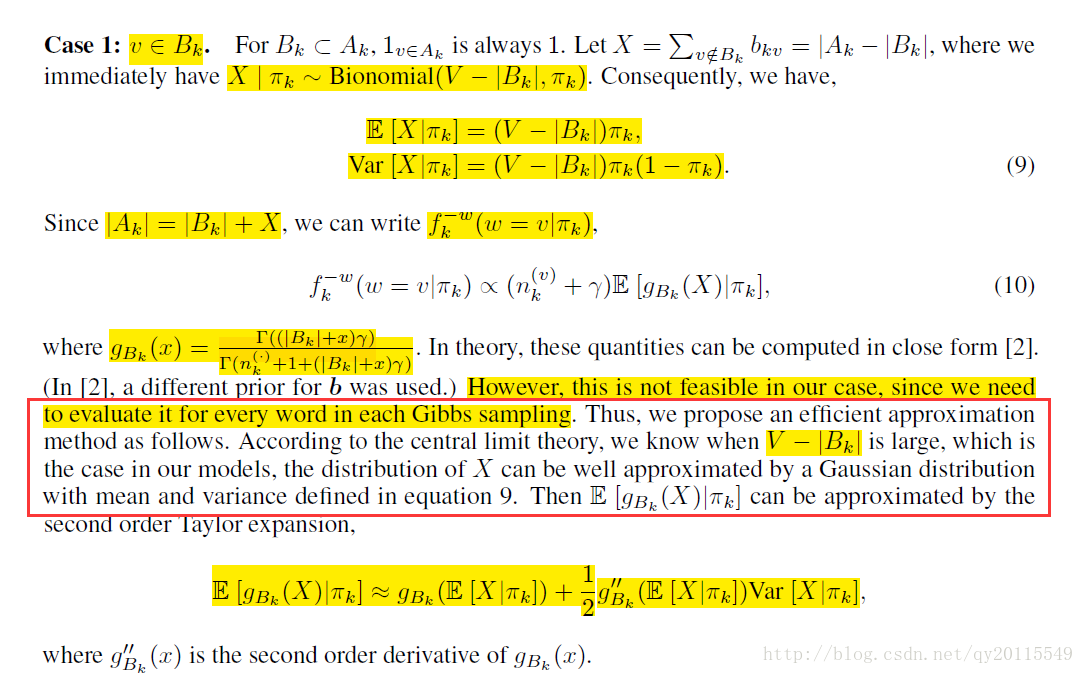

前面的公式按照,作者写的补充材料一步一步来,基本都能看懂,在推导到最后时,发现有些东西不太了解,找了资料才发现,原来是这样的。

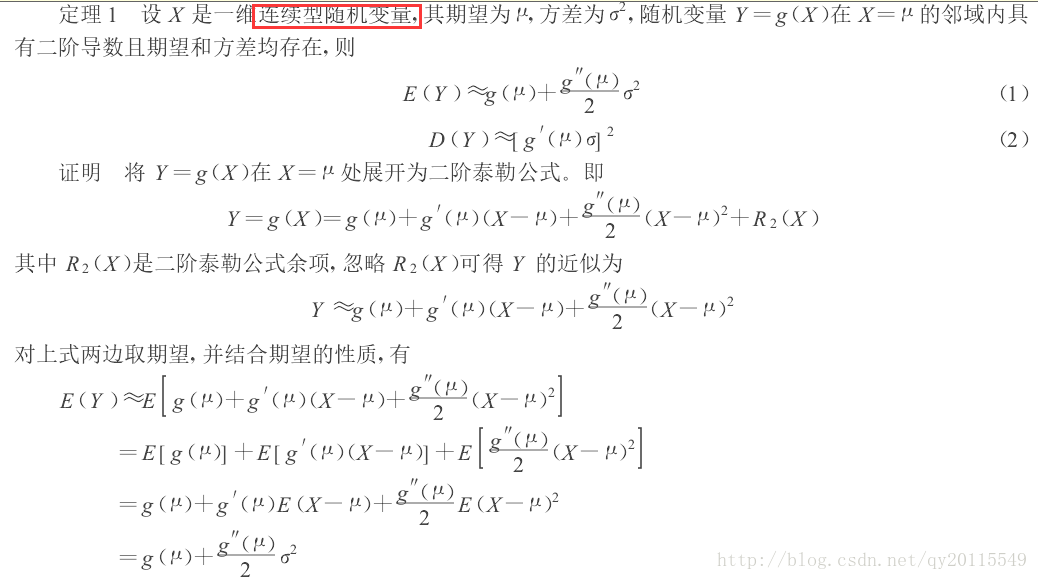

在这里求期望时,我没有弄明白。在泰勒级数近似时,为什么要使用高斯分布。这里就有一个小技巧。

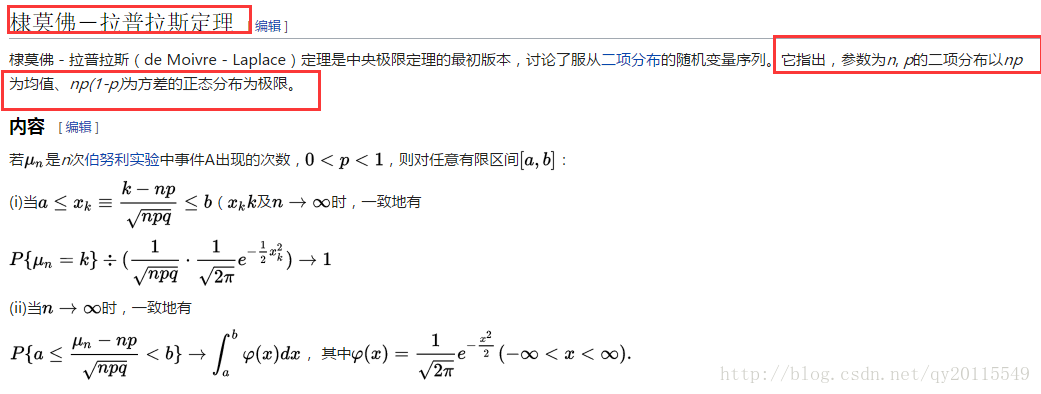

因为在使用泰勒展开时,x必须是连续性随机变量。而这篇文章的的X服从的是二项分布,而二项分布是离散型分布,为此,这篇文章在推导公式时,利用中心极限定理:正太分布是二项分布的极限分布。