来源:专知

本文为论文介绍,建议阅读5分钟这篇论文的结果是基于自适应采样文献中的技术。

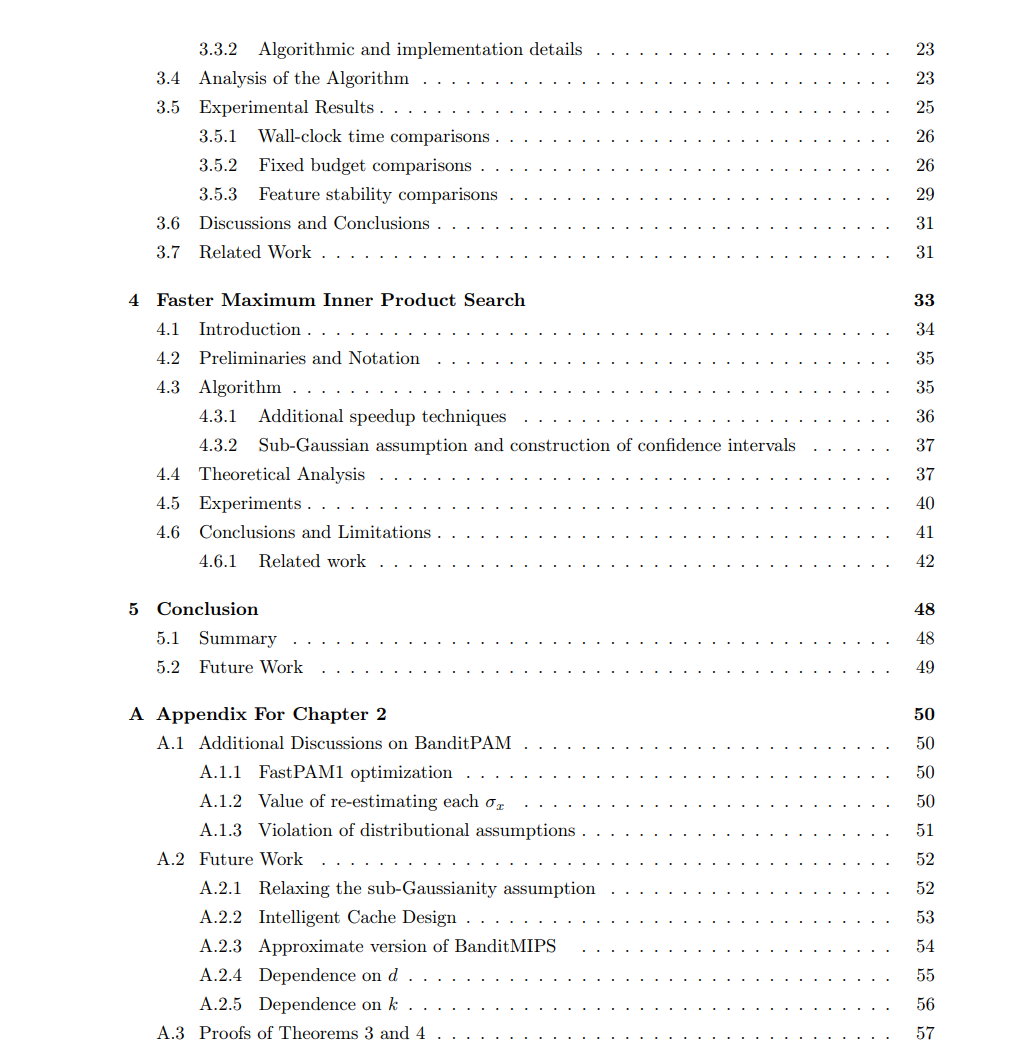

在海量数据的时代,高效的机器学习算法变得至关重要。然而,许多常见的机器学习算法依赖于在大数据集上计算成本过高的子程序。通常,现有的技术会对数据进行子采样或使用其他方法来提高计算效率,但这会以引入一些近似误差为代价。这篇论文表明,往往只需用一种特殊的随机化方法替代计算密集型的子程序,就能在几乎不降低质量的情况下获得足够的效果。这篇论文的结果是基于自适应采样文献中的技术。第1章以一个特定的自适应采样问题为引子:多臂老虎机中的最佳臂识别。我们首先提供了环境设定和最佳臂识别问题的正式描述。然后,我们介绍了一种名为“连续淘汰”的通用算法,用于解决最佳臂识别问题。在第2章,第3章和第4章,我们将把在第1章中开发的技术应用于不同的问题。在第2章,我们讨论了如何将k-medoids聚类问题简化为一系列的最佳臂识别问题。我们利用这一发现提出了一种基于连续淘汰的新算法,该算法在聚类质量上与先前的最新技术相当,但达到相同解的速度要快得多。在数据生成分布的一般假设下,我们的算法在样本复杂性上实现了 O( n logn ) 的降低,其中 n 是数据集的大小。

在第3章中,我们分析了训练基于树的模型的问题。这类模型的大部分训练时间都用在分割树的每个节点上,即确定在哪个特征和相应的阈值处分割每个节点。我们展示了节点分割子程序可以简化为一个最佳臂识别问题,并介绍了一种训练树的最新算法。我们的算法仅依赖于每个可能分割的相对质量,而不是显式地依赖于训练数据集的大小,并将数据集大小n的显式依赖从常用的先前算法的O(n)降低到O(1)。我们的算法通常适用于许多基于树的模型,如随机森林和XGBoost。在第4章中,我们研究最大内积搜索问题。我们注意到,与k-medoids和节点分割问题一样,最大内积搜索问题可以简化为一个最佳臂识别问题。有了这个观察,我们为高维数据集中的最大内积搜索问题提出了一个新颖的算法。在对数据的合理假设下,我们的算法将与数据集维数d的显式比例从O(√d)降低到O(1)。我们的算法具有几个优点:它不需要对数据进行预处理,能自然处理新增或删除的数据点,并包含一个超参数来权衡准确性和效率。第5章以总结本论文的贡献和未来工作的可能方向作为结论。

https://searchworks.stanford.edu/view/14783548