看了课程一周后发现忘光了,决定做一个笔记用作复习。如果涉及到侵权问题请联系我,我会立马删除并道歉。

同时,禁止任何形式的转载,包括全文转载和部分转载。如需使用请联系本人 [email protected]。如若发现侵权行为,我学过知识产权法的,嘿嘿

第三周 Logistic Regression

Classification

常见的分类问题有:

(1)spam(2)肿瘤(3)信用卡诈骗

例子:分类肿瘤良性与否

下图1表示良性,0表示恶性。我们有八个实例(X)分布如下。得到的hypothesis 为蓝色的这个(这只是一个假设,实际上线性回归在这里并不合适,举个例子,我们假设有几个outliers, 那线性回归就崩了)。

此时,我们使用threshold来进行分类:当x值大于threshold投影到的红点,我们预测y =1;当值小于threshold,我们认为y =0。

Logistic Regression Model

logistic regression是一个容易让人混淆的概念(因为其中带有regression字眼),但是其实它是应用于分类问题的,我们有: 0<=hθ(x)<=1(与之相比,regression的hypothesis是可以在任意范围的)

我们上周上上周讲的线性回归是A式,逻辑回归模型使用的是B式(两个x相同,大小不一是因为写第二个式子的时候控制不住麒麟臂了)。B中的g(z)被称为sigmoid function/logistic function。

例子:假设我们有hypothesis: hθ(x) = g(z), where z=θ^T*X。假设当肿瘤为良性时,y =1; 当肿瘤为恶性时, y=0。通过计算我们得到:hθ(x)=0.7=P(y=1|x:θ),即:该肿瘤有70%的概率为良性。通过计算1-hθ(x)=0.3=P(y=0|x:θ),我们也可以得到该肿瘤有30%的概率为恶性。

这里有一个疑惑,这个分类问题的结果应该是0 & 1 二项的,为什么会需要概率来阐释它的结果呢?

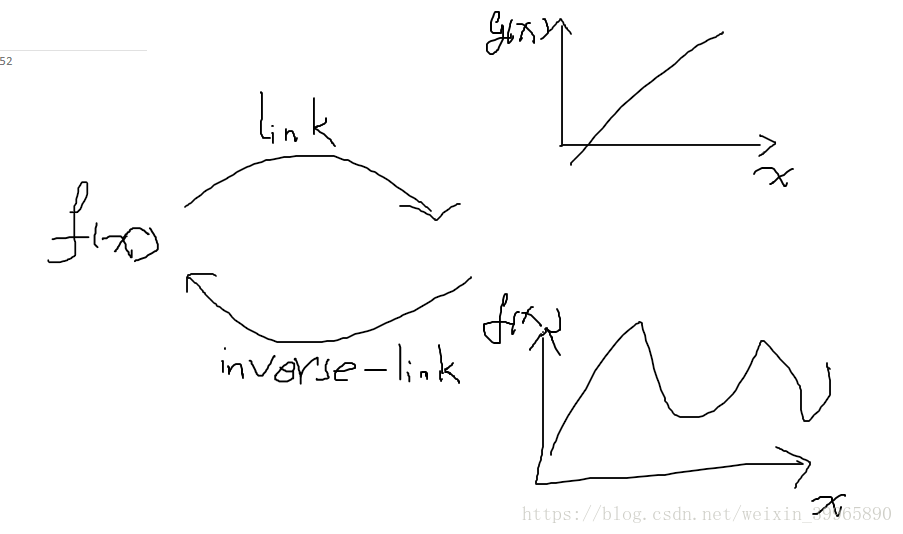

在我的课程《统计建模》中,有着同样的概念:link function(见下图)。在GLM中,我们的解释变量和反应变量存在着两层关系:对于反应变量f(x),解释变量x与其在response scale上存在着非线性关系;对于link function g(x),解释变量x与其在link scale上存在线性关系。个人感觉这个概念和上段逻辑回归提到的概念很相似。他们的关系应该就属于数据挖掘和机器学习的关系:数据挖掘和机器学习有着众多重复的概念,甚至是机器学习的监督学习和非监督学习,数据挖掘中都有着相似的理论,数据挖掘从更加偏向统计的角度来处理问题,而机器学习更偏向于计算机角度。但是这里要注意的是,我们对hypothesis使用逻辑回归是为了让其范围处于[0,1]之间;而我们对模型使用link function是为了更好的拟合模型或者处理模型假设中的一些问题。

Decision Boundary

这里我们将结合上面的知识用一个肿瘤的例子来解释什么是decision boundary。

下图黑色和绿色公式是我们将要使用的logistic function,蓝色曲线是其函数。我们使用threshold=0.5来分类良性肿瘤(y=1)和恶性肿瘤(y=0)。从蓝色曲线可知,当z>=0时,y =1;当z<0时,取y=0。此时z = θ0+θ1x1+θ2x2,即当-3+x1+x2>=0时,y=1;同理x1+x2<3时,y = 0。右下角坐标图中已标出黑色线性函数x1+x2=3,此线性函数表示z=0,被称作decision boundary。在decision boundary左下侧,是y=0分类,右上侧为y=1(这里最好不要靠现有的数据来理解,应该理解为函数的左右侧/上下侧)。当然,z的取值不可能永远都是线性的,面对非线性的问题时,我们可以结合高中学过的椭圆、圆等知识,构造“圆内(y=0)”、“圆外(y=1)”等概念来完成z>0, z<=0(我觉得等号随意放吧,在哪边都不是很重要)。

这里需要意识到的是

(1)通常给定的数据不会这么完美,良性、恶性肿瘤恰好清晰地分为两组。在未来的分析中,更多可能是混淆不清界限模糊的,要留意如何处理

(2)现实中的covariate/features数量往往远远超过了两个(x1,x2),现在理解可以依靠2D、3D坐标图来理解,但是当维度上升到难以用图标表示时,又该如何理解呢?所以要建立一个自己的知识体系:covariate的数量是可变的,但是游戏的应用规则不会改变,要将知识抽象出来。

(3)The decision boundary is a property, not decided by a trading set. (引用自吴恩达课上原话)界限并不是凭借训练集来定夺的,试想,如果训练集变了,那么界限也变了,这是不合理的。界限是依靠训练集确定的parameters来确定的,这样使其具有一定的稳定性。