来源:专知

本文为论文介绍,建议阅读5分钟

本论文专注于设计和评估用于人机交互的LMs。

https://searchworks.stanford.edu/view/14784050

尽管语言模型(LMs)在现实应用中无处不在(例如,网页搜索,文本自动完成和内容生成),但大多数LMs并没有针对人类用户与LMs的交互进行优化,也没有在这方面进行评估。为了解决这一缺口,本论文专注于设计和评估用于人机交互的LMs。我们首先关注作者在修订过程中遇到的一个特定需求:在给定周围环境的情况下提出内容。为了支持这种需求,我们提出了一种训练方法,使任何预先训练过的LMs都能完成填空任务,有助于更好地促进人机交互。其次,我们构建了一个平台,CoAuthor,用于捕获人机交互的交互痕迹。通过CoAuthor,我们展示了如何收集大规模交互数据集并分析这些痕迹,从而对LM在语言,思想发展和协作方面的能力提供独特的见解。最后,我们提出了一个新的评估框架,人工智能语言交互评估(HALIE),该框架定义了交互系统的组成部分以及超越写作任务的人机交互任务的度量标准。最后,我们讨论了这个领域的开放性挑战和未来的发展方向。

在飞速变化的环境中撰写论文是一种特殊的尝试。自然语言处理(NLP)领域正在经历一个不断变化和创新的时代,本论文旨在捕捉该领域的一个快照,并从这个不断变化的景观中研究一种永恒的质量:设计和评估用于人类交互的语言模型(LMs)。自我开始博士研究以来,LMs至少可以说发展迅猛。在2017年,构建LM的最常见方式是选择一个特定任务,收集一个定制的数据集,设计一个定制的模型,并从头开始训练定制的模型,正如我在我第一个项目中所演示的那样(Lee等人,2019)。到了2023年,即使没有NLP或编程的先前知识,我们也可以通过API或简单用户界面对预训练的LMs进行提示,快速“构建”并与LMs进行交互,以执行广泛的任务,正如我在后续项目中所演示的那样(Lee等人,2022a,b,Bommasani等人,2023)。

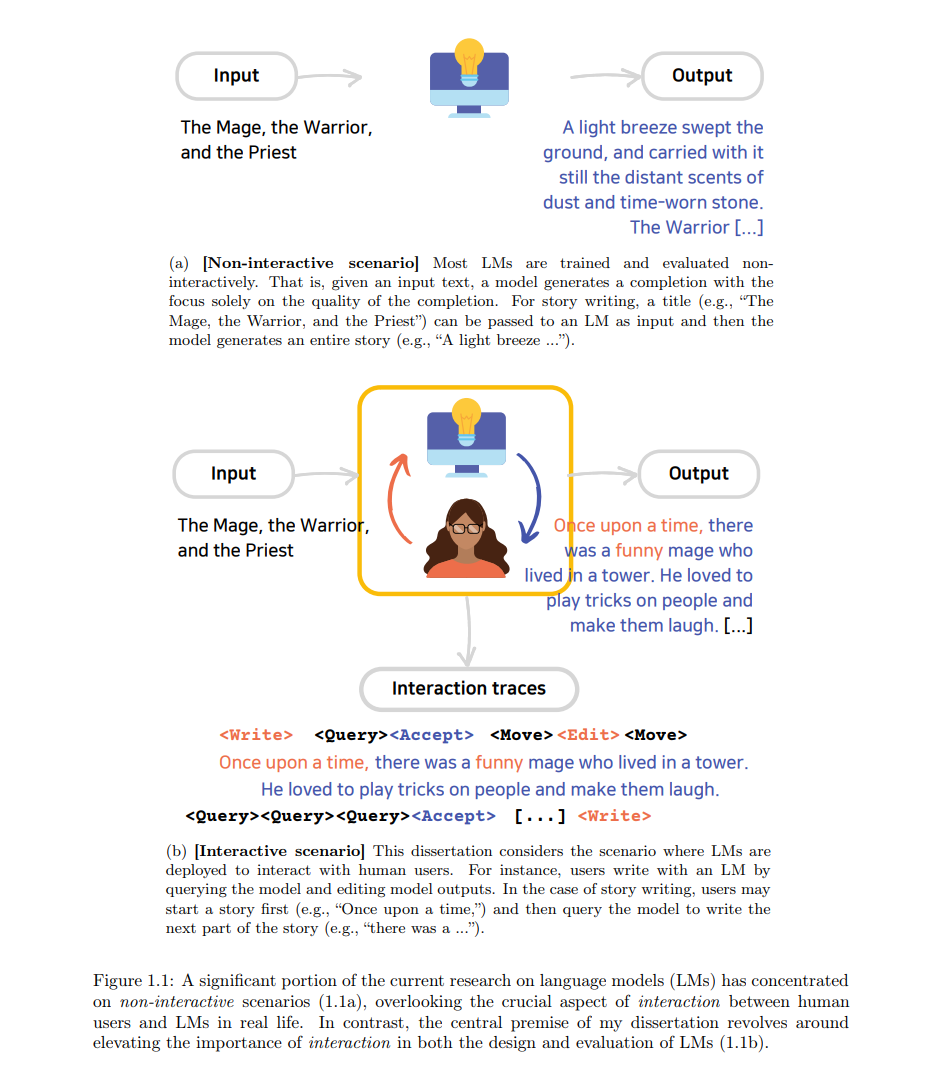

然而,尽管近期的语言模型(LMs)具有前所未有的能力和广泛的应用(Radford等人,2019; Brown等人,2020; Rae等人,2021; Zhang等人,2022; Chowdhery等人,2022; Lieber等人,2021; OpenAI, 2022, 2023),但在NLP领域的大部分现有LM研究主要侧重于非交互场景:给定一个输入文本,模型生成一个输出文本,只关注输出的质量。在这种情况下,人类的参与要么被忽视,要么限于特定的目的或形式,如对模型输出的人类评估(Ribeiro等人,2020; Kiela等人,2021)或像对话那样的严格交互(Paranjape等人,2020; Thoppilan等人,2022; Shuster等人,2022)。几乎所有的基准测试,即使是那些包含了多样任务的基准测试(Gehrmann等人,2021; Hendrycks等人,2021; Liang等人,2022),也都采取了这种非交互的视角。与此相反,我的工作的中心论点是将交互置于LM设计和评估的最前沿。以问答任务为例,与其构建一个孤立运作的模型(即,将预定义的问题作为模型输入,并将模型输出与静态基准中的预定义答案进行比较),我更注重交互场景。在这种场景下,用户参与到一个迭代的过程中,写下问题,询问(或查询)模型,解读并处理模型输出,根据输出调整他们的问题,并随着他们对模型的了解逐渐适应他们的策略。我在故事写作上的工作也遵循了类似的哲学(Lee等人,2022a)。我努力开发的LM并不是可以自行生成整个故事的模型(图1.1a),而是能够增强和支持我们的写作过程的模型(图1.1b),可能通过生成部分故事来让用户选择和调整。这种对LM的交互式使用与Engelbart(1962)、Skagestad(1993, 1996)、Shneiderman和Maes(1997)、Horvitz(1999)、Hassani等人(2020)、Brynjolfsson(2022)、Shneiderman(2022)的观点相吻合,其最终目标是增强人类能力,而不是自动化它们(即,智能增强)。

对于人机交互(HCI)社区来说,近期的语言模型(LMs)为新颖的交互设计提供了令人兴奋的机会。我们开始看到许多应用和原型利用LMs进行快速原型制作和设计新颖的自然语言交互(Calderwood等人,2020;Buschek等人,2021;Wang等人,2021;Chen等人,2021;Chakrabarty等人,2022;Ippolito等人,2022;Valencia等人,2023)。为了研究LMs的生成能力,HCI中最传统的方法是情境询问,邀请并访问用户(Calderwood等人,2020;Clark等人,2018b;Gero和Chilton,2019;Wu等人,2020, 2022;Yang等人,2019a)。然而,由于情境询问的时间和资源密集性,它在捕捉LM能力的主观解释方面更有效,而在涵盖多样化的上下文方面则较为欠缺。

我的研究核心是交互迹线,即在人类用户和LMs交互过程中展开的事件序列(图1.1b)。这些迹线包含了各种行为,包括按键操作,光标移动,系统查询,以及通过系统建议进行导航。它们包含丰富的信息,捕获了人机交互的动态性,提供了对LMs在交互场景中能力的深入了解。例如,通过检查用户查询的频率,我们可以量化用户对LMs的依赖程度,以及LM响应的帮助程度。此外,交互迹线还能让我们了解用户在与LMs交互时采取的策略,以及交互的时间属性。最后但同样重要的是,利用交互迹线可以覆盖各种上下文,因为设计者可以一次性大规模捕捉人机交互,并将其重复使用并多次回放以便于分析。

我相信,通过利用这些交互迹线,NLP和HCI社区可以设计出更有针对性和以用户为中心的LM开发和部署方法。

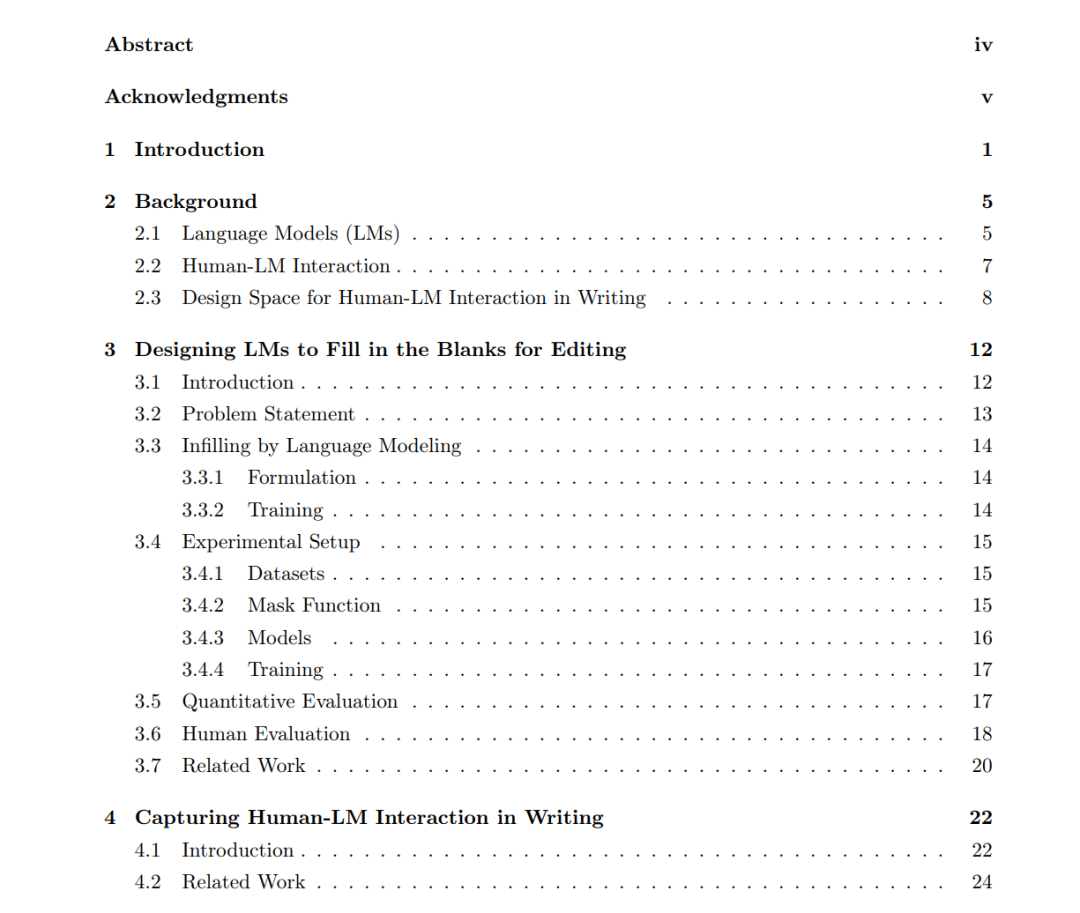

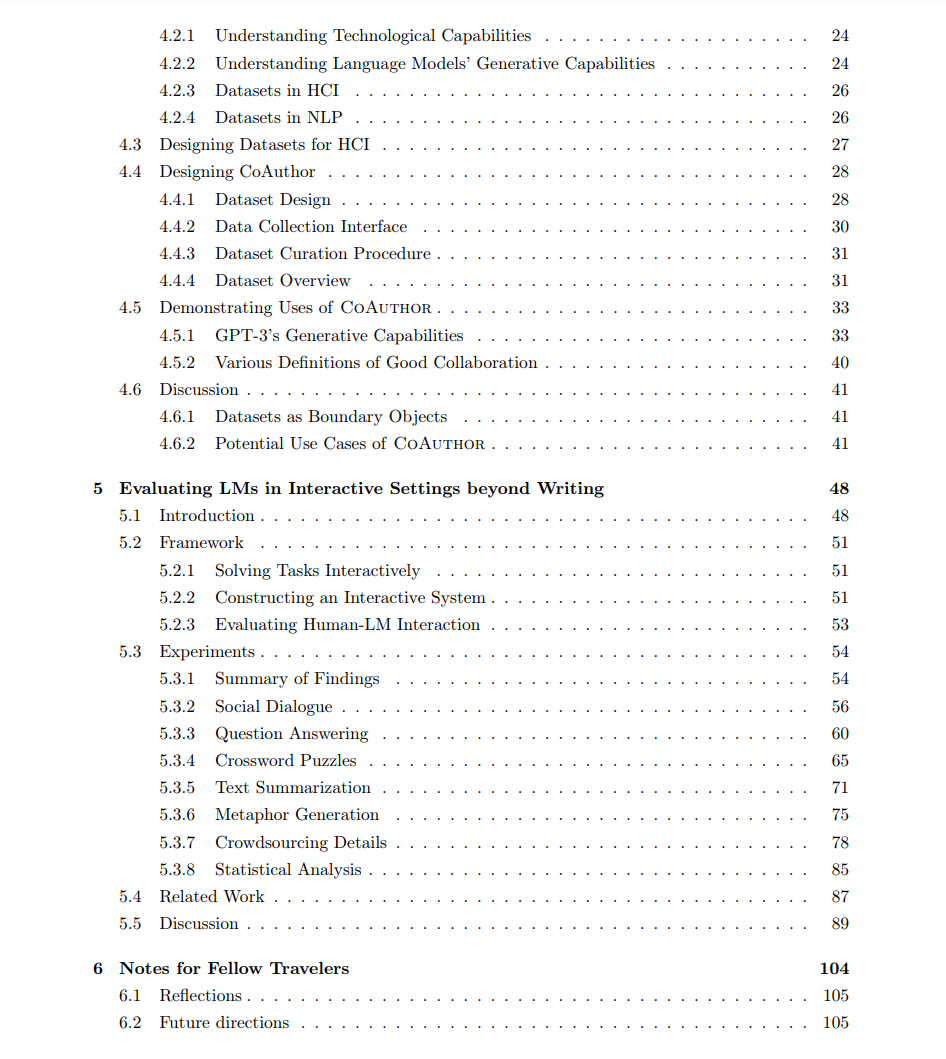

这篇论文包括以下章节:

• 第二章通过提供有关语言模型(LMs)、人机交互和人机交互在写作中的设计空间的背景,为后续章节建立基础理解。

• 第三章深入探讨了一个特定的交互环境,即写作的修订过程,并关注了大多数LMs无法直接解决的用户需求。具体来说,我们提出了一种训练方法,使LMs能够填补空白(即,文本填充)。

• 第四章介绍了CoAuthor,这是一个设计用来捕捉和分析协同写作中的人机交互的平台。该平台促进了交互迹线的收集,产生了一个丰富且可以重复分析的数据集。通过使用这个数据集,我展示了如何通过检查这些交互迹线,对LM在语言、创意和协作等方面的能力获得无比宝贵的见解。

• 第五章提出了一个新的评估框架,即人工智能基于语言的交互评估(HALIE),它定义了交互系统的基本组成部分,并引入了新的评估指标,用于评估人机交互超越写作相关任务的性能。这个框架涵盖了更广泛的交互场景,使得可以全面理解和评估LM在各种情境下的性能。

• 第六章讨论了人机交互领域内的开放性挑战,以激发更深入的研究和创新。

论文中的一部分工作已经在学术会议上发表。第三章基于Donahue等人的研究(2020),该研究在2020年的计算语言学协会(ACL)上发表。第四章基于Lee等人的材料(2022a),该材料在2022年的人机交互系统会议(CHI)上发表。第五章基于Lee等人的研究(2022b),该研究目前正在审查中。