ADVERSARIAL EXAMPLES IN THE PHYSICAL WORLD

物理世界中的对抗性例子

摘要

大多数现有的机器学习分类器极易受到敌对示例的攻击。一个敌对的例子是输入数据的样本,该样本经过了非常轻微的修改,旨在导致机器学习分类器对其进行错误分类。在许多情况下,这些修改可能非常细微,以至于人类观察者根本没有注意到修改,但分类器仍然会出错。对抗性示例会带来安全问题,因为它们可能被用来对机器学习系统进行攻击,即使对手无法访问底层模型。到目前为止,所有以前的工作都假设了一个威胁模型,在该模型中,对手可以将数据直接输入机器学习分类器。对于在物理世界中运行的系统来说,情况并非总是如此,例如那些使用摄像头和其他传感器的信号作为输入的系统。本文表明,即使在这样的物理世界场景中,机器学习系统也容易受到对抗性示例的攻击。我们通过将从手机摄像头获得的敌对图像输入ImageNet初始分类器并测量系统的分类精度来证明这一点。我们发现,即使通过摄像头观察到,也有很大一部分对抗性示例被错误分类。

一、引言

机器学习和深度神经网络的最新进展使研究人员能够解决图像、视频、文本分类等多个重要的实际问题(Krizhevsky et al., 2012; Hinton et al., 2012; Bahdanau et al., 2015).

然而,机器学习模型往往容易受到其输入的对抗性操纵,从而导致不正确的分类(Dalvi et al., 2004)。特别是,神经网络和许多其他类型的机器学习模型在测试时极易受到基于对模型输入的微小修改的攻击(Biggio et al., 2013; Szegedy et al., 2014; Goodfellow et al., 2014; Papernot et al., 2016b)。

这个问题可以总结如下。假设有一个机器学习系统M和输入样本C,我们称之为干净的例子。让我们假设样本C被机器学习系统正确分类,即M(C)=Ytrue。我们可以构建一个敌对的例子A,它在感知上与C无法区分,但分类错误,即M(A)!=Ytrue。即使噪声的大小远大于对抗性干扰的大小,但这些对抗性示例的错误分类频率也远高于受到噪声干扰的示例(Szegedy et al.,2014)。

对抗性示例对实际机器学习应用程序构成潜在的安全威胁。特别是,Szegedy et al.(2014)表明,设计用于被模型M1错误分类的对抗性示例通常也被模型M2错误分类。这种对抗性示例可转移性属性意味着,在不访问基础模型的情况下,可以生成对抗性示例并对机器学习系统执行错误分类攻击。Papernot等人(2016a)和Papernot等人(2016b)在现实场景中演示了此类攻击。

然而,之前所有关于神经网络对抗性示例的工作都使用了威胁模型,在该模型中,攻击者可以直接向机器学习模型提供输入。在这项工作之前,不知道如果在物理世界中构建并通过相机观察对抗性示例,是否会继续被错误分类。

这种威胁模型可以描述完全在计算机内发生攻击的一些场景,例如逃避垃圾邮件过滤器或恶意软件检测器(BBiggio et al., 2013; Nelson et al.)。然而,许多实用的机器学习系统都是在物理世界中运行的。可能的例子包括但不限于:机器人通过摄像头和其他传感器感知世界、视频监控系统以及用于图像或声音分类的移动应用程序。在这种情况下,对手无法依赖对输入数据进行细粒度每像素修改的能力。由此产生了以下问题:是否仍有可能对在物理世界中运行并通过各种传感器而不是数字表示感知数据的机器学习系统制作对抗性示例并执行对抗性攻击?

之前的一些工作已经解决了针对机器学习系统的物理攻击问题,但没有通过对输入进行非常小的扰动来愚弄神经网络。例如,Carlini et al.(2016)演示了一种攻击,该攻击可以创建音频输入,移动电话可以识别为包含可理解的语音命令,但人类可以听到无法理解的语音。基于照片的人脸识别系统容易受到重播攻击,在这种攻击中,授权用户之前拍摄的人脸图像会呈现给摄像头,而不是真实的人脸(Smith等人,2015)。敌对的例子原则上可以应用于这两个物理领域中的任何一个。语音命令域的一个对抗性示例包括一段对人类观察者似乎无害的录音(例如一首歌),但包含机器学习算法识别的语音命令。人脸识别领域的一个对抗性示例可能包括应用于人脸的非常细微的标记,以便人类观察者能够正确识别他们的身份,但机器学习系统会将他们识别为不同的人。与本文最相似的工作是Sharif等人(2016年),他们在我们的工作结束后公开发表,但在早些时候提交给了一次会议。Sharif et al.(2016)还将对抗性示例的图像打印在纸上,并证明打印的图像在拍照时会欺骗图像识别系统。他们的工作与我们的工作之间的主要区别在于:(1)我们在大多数实验中使用廉价的封闭式攻击,而Sharif et al.(2016)使用基于优化算法的更昂贵的攻击,(2)我们没有特别努力修改我们的对抗性示例,以提高他们在打印和摄影过程中生存的机会。我们只是做了一个科学的观察,很多敌对的例子在没有任何干预的情况下存活了下来。Sharif et al.(2016)引入了额外的功能,使其攻击尽可能有效地针对人脸识别系统进行实际攻击。(3) Sharif et al.(2016)限制了他们可以修改的像素数量(仅限于眼镜架上的像素),但可以大量修改这些像素;我们可以修改的像素数量有限,但可以自由修改所有像素。

为了调查对抗性示例在物理世界中存活的程度,我们使用预先训练的ImageNet初始分类器进行了一项实验(Szegedy et al.,2015)。我们为该模型生成了对抗性示例,然后通过手机摄像头将这些示例输入分类器,并测量分类精度。这个场景是一个简单的物理世界系统,它通过摄像头感知数据,然后运行图像分类。我们发现,为原始模型生成的对抗性示例中,有很大一部分仍然被错误分类,即使是通过摄像头感知到的。

令人惊讶的是,我们的攻击方法不需要做任何修改去解释摄像机的存在。使用为Inception模型精心制作的对抗性示例进行的最简单的攻击导致对抗性示例成功转移到摄像机和Inception的联合体。因此,我们的结果提供了一个攻击成功率的下限,可以通过更专门的攻击来实现,这些攻击可以在制作对抗性示例的同时显式模拟摄像头。

我们的结果的一个局限性是,我们假设了一个威胁模型,在此模型下,攻击者完全了解模型体系结构和参数值。这主要是为了我们可以在所有实验中使用单一的Inception v3模型,而无需设计和训练不同的高性能模型。对抗性示例传输属性意味着我们的结果可以简单地扩展到攻击者无法访问模型描述的场景(Szegedy et al.,2014;Goodfello et al.,2014;Papernot et al.,2016b)。虽然我们还没有进行详细的实验来研究物理对抗示例的可转移性,但我们能够构建一个简单的手机应用程序来演示物理世界中潜在的对抗性黑匣子攻击,见图1。

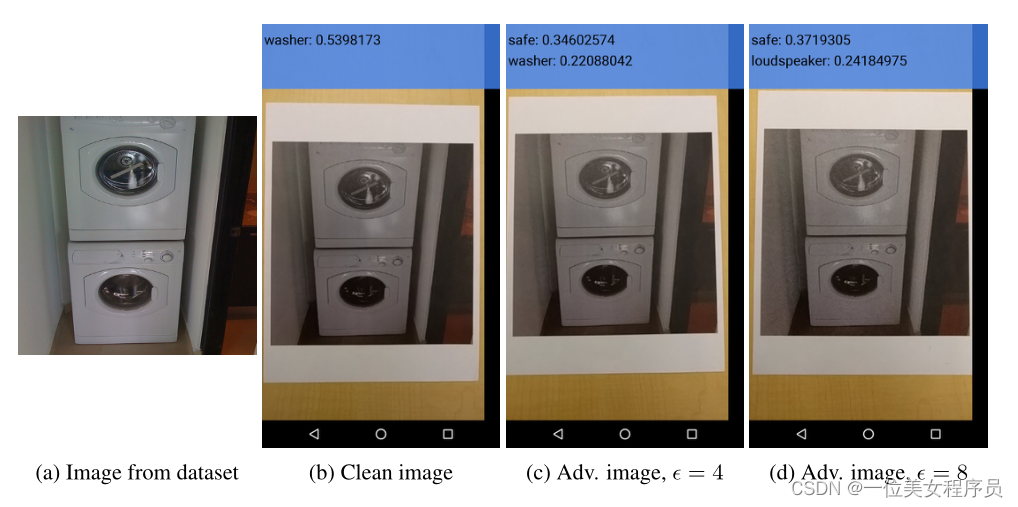

图1:在手机应用程序上演示黑盒攻击(攻击是在不访问模型的情况下构建的),用于使用物理对抗示例进行图像分类。我们从数据集(a)中获取了一张清晰的图像,并使用它生成了具有各种大小的敌对干扰的敌对图像。然后,我们打印出清晰的对抗性图像,并使用TensorFlow摄像头演示应用程序对其进行分类。当通过摄像头感知到干净的图像(b)时,可以正确地将其识别为“清洗器”,而敌对图像(c)和(d)则被错误分类。请参阅youtu上的完整演示视频 https://youtu.be/zQ_uMenoBCk.

为了更好地理解相机引起的非平凡图像变换如何影响对抗性示例的可传递性,我们进行了一系列额外的实验,研究了对抗性示例如何在几种特定类型的合成图像变换中传递。

本文的其余部分结构如下:在第2节中,我们回顾了生成对抗性示例的不同方法。第3节接着详细介绍了我们的“物理世界”实验装置和结果。最后,第4节描述了我们对各种人工图像变换(如改变亮度、对比度等)的实验以及它们如何影响对抗性示例。

二、生成对抗性图像的方法

本节描述了我们在实验中使用的生成对抗性示例的不同方法。需要注意的是,所描述的任何方法都不能保证生成的图像会被错误分类。然而,我们将所有生成的图像称为“敌对图像”。

在本文的其余部分中,我们使用以下符号:

- 图像,通常为三维张量(宽×高×深)。在本文中,我们假设像素的值是[0255]范围内的整数。

- 图像X的正确类。

- 神经网络的交叉熵代价函数,给定图像X和y类。我们有意在代价函数中省略网络权重(和其他参数)θ,因为我们假设它们在本文中是固定的(与机器学习模型训练产生的值相同)。对于具有softmax输出层的神经网络,应用于整数类标签的交叉熵代价函数等于给定图像的真实类的负对数概率:J(X,y)=− log p(y | X),此关系将在下面使用。

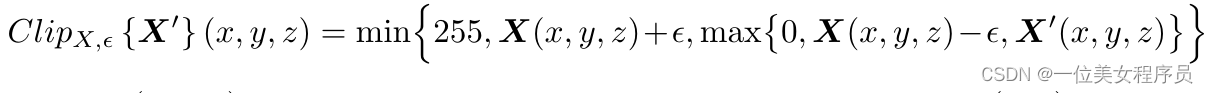

- 对图像X’执行逐像素剪裁的函数,因此结果将为L∞ ε-源图像X的邻域。精确的剪裁方程如下:

其中X(X,y,z)是图像X在坐标(X,y)处的通道z的值。

2.1 快速方法

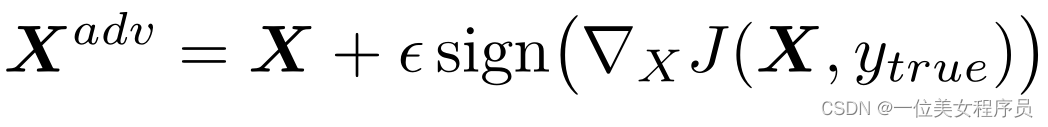

生成对抗性图像的最简单方法之一,如(Goodfello et al.,2014)所述,其动机是将成本函数线性化,并在L∞约束下求解使成本最大化的扰动。这可以以封闭形式完成,只需一次调用反向传播:

其中ε是要选择的超参数。

在本文中,我们将此方法称为“快速方法”,因为它不需要迭代过程来计算对抗性示例,因此比其他考虑的方法快得多。

2.2 基本迭代方法

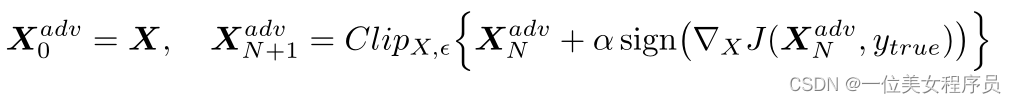

我们引入了一种简单的方法来扩展“快速”方法,我们以较小的步长多次应用该方法,并在每一步后剪裁中间结果的像素值,以确保它们位于原始图像的ε邻域中:

在我们的实验中,我们使用α=1,也就是说,我们在每一步上仅将每个像素的值更改1。我们选择迭代次数为min(ε+4,1.25ε)。这个迭代量是启发式选择的;对抗性示例足以到达ε最大范数球的边缘,但限制程度足以使实验的计算成本可控。

下面我们将此方法称为“基本迭代”方法。

2.3 迭代最小可能类方法

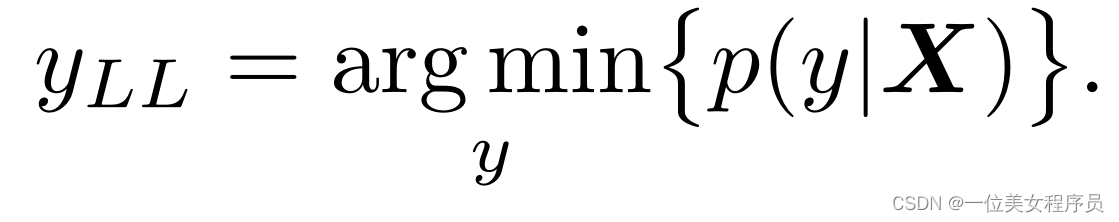

到目前为止,我们描述的两种方法都只是试图增加正确类的成本,而没有指定模型应该选择哪些不正确的类。此类方法足以应用于MNIST和CIFAR-10等数据集,这些数据集的类数量较少,且所有类彼此高度不同。在ImageNet上,由于类的数量要大得多,并且类之间的差异具有不同程度的显著性,这些方法可能会导致无趣的错误分类,例如将一种雪橇犬误认为另一种雪橇犬。为了产生更有趣的错误,我们引入了迭代的最小可能类方法。这种迭代方法试图生成一个敌对图像,该图像将被分类为特定的目标类。对于所需类别,我们根据图像X上训练网络的预测选择了最不可能的类别:

对于训练有素的分类器来说,最不可能的类通常与真实类非常不同,因此这种攻击方法会导致更有趣的错误,例如将狗误认为飞机。

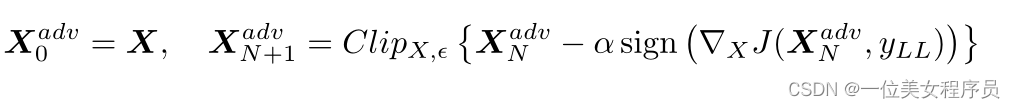

为了制作分类为yLL的敌对图像,我们通过在符号方向上进行迭代步骤,最大化log p(yLL | X){∇X log p(yLL | X)}。最后一个表达式等于号{−∇XJ(X,yLL)}用于具有交叉熵损失的神经网络。因此,我们有以下程序:

对于这个迭代过程,我们使用了与基本迭代方法相同的α和相同的迭代次数。

下面我们将此方法称为“最不可能类”方法或简称为“l.l.类”。

2.4 对抗性实例生成方法的比较

如上所述,不能保证敌对图像实际上会被错误分类——有时攻击者获胜,有时机器学习模型获胜。我们对对抗性方法进行了实验比较,以了解生成图像的实际分类精度以及每种方法所利用的扰动类型。

使用预先训练好的Inception v3分类器(Szegedy et al.,2015),对ImageNet数据集(Russakovsky et al.,2014)中的所有50000个验证样本进行了实验。对于每一张验证图像,我们使用不同的方法和不同的ε值生成对抗性示例。对于每对方法和ε,我们计算了所有50000张图像的分类精度。此外,我们还计算了所有干净图像的精度,并将其用作基线。

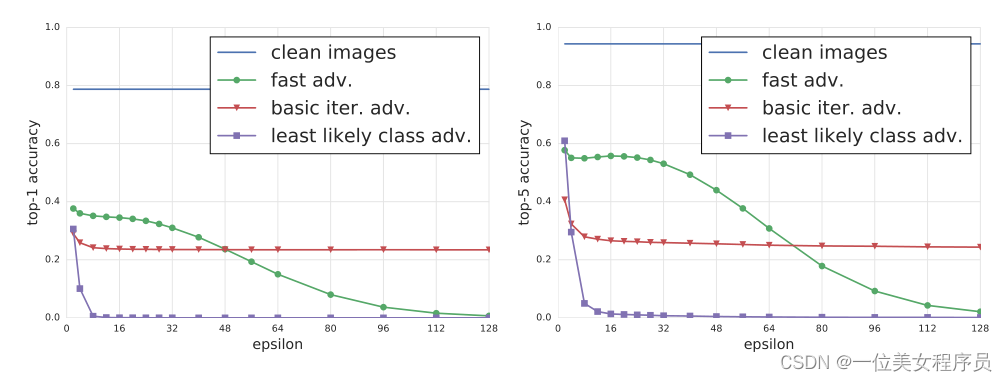

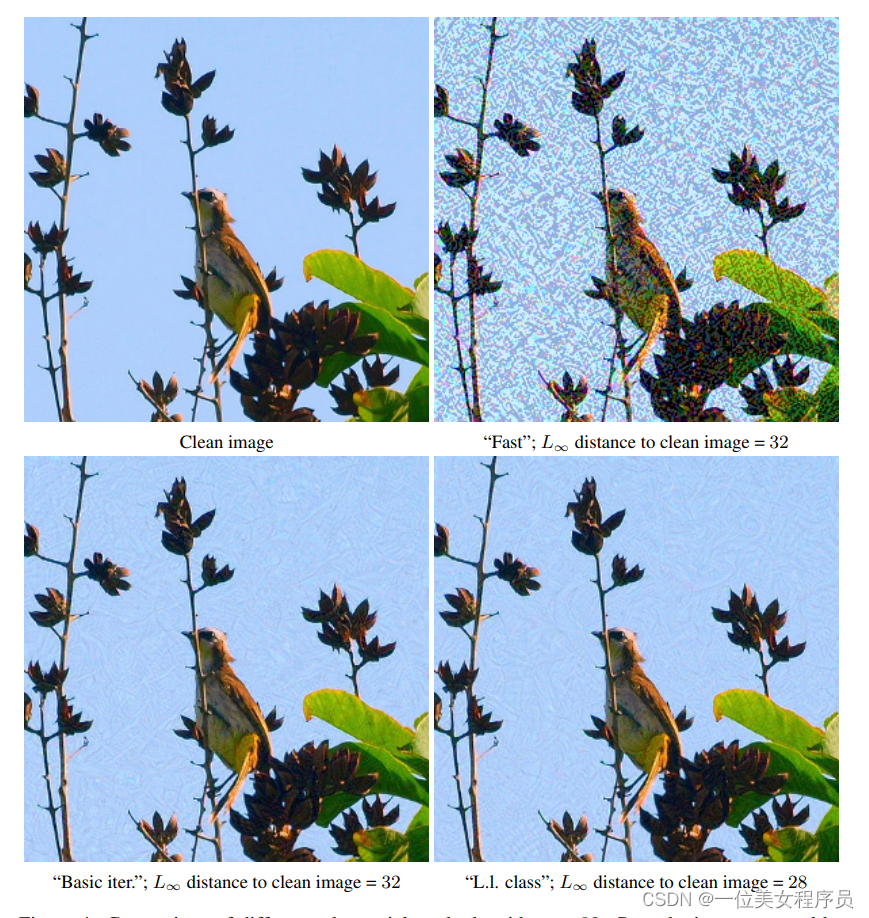

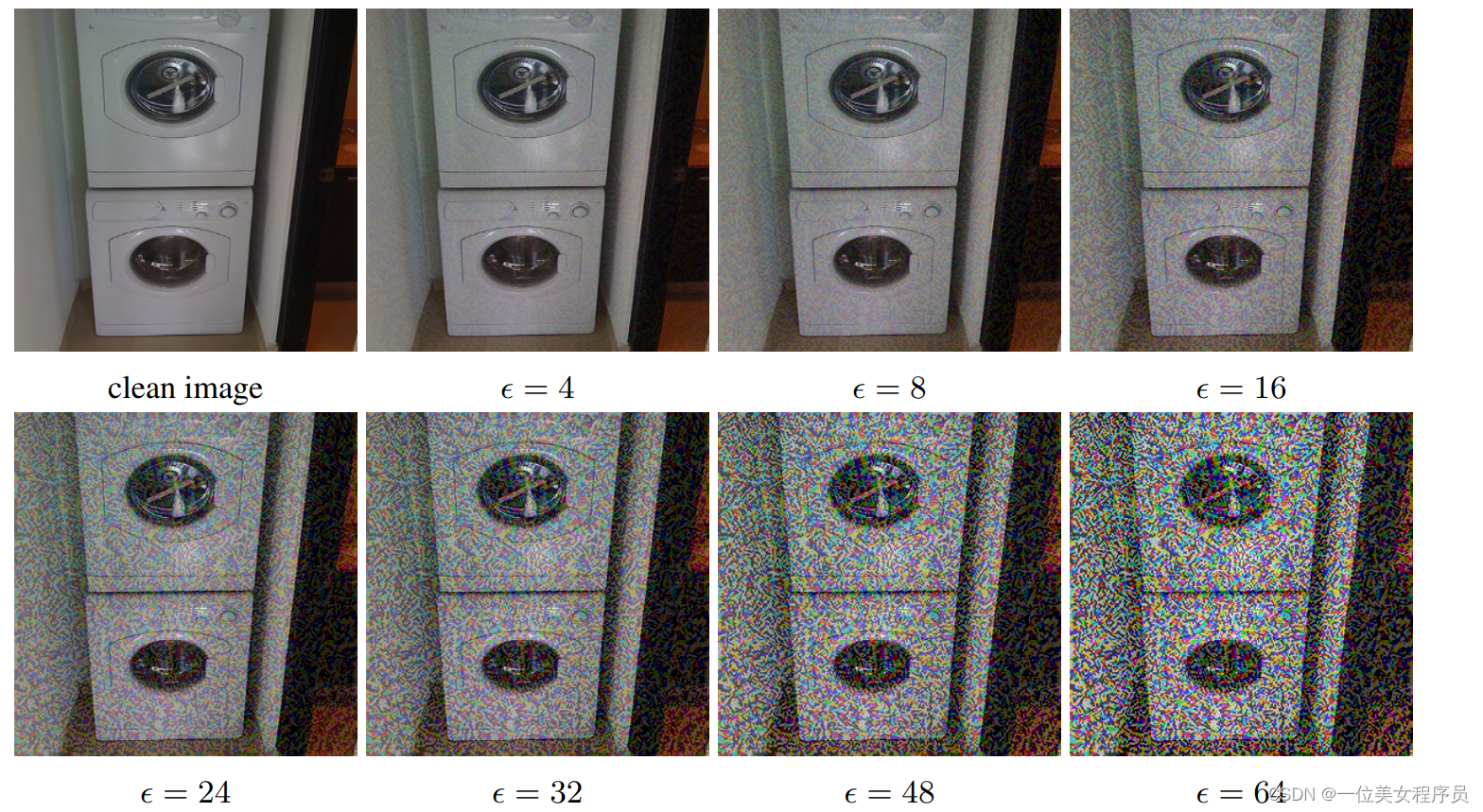

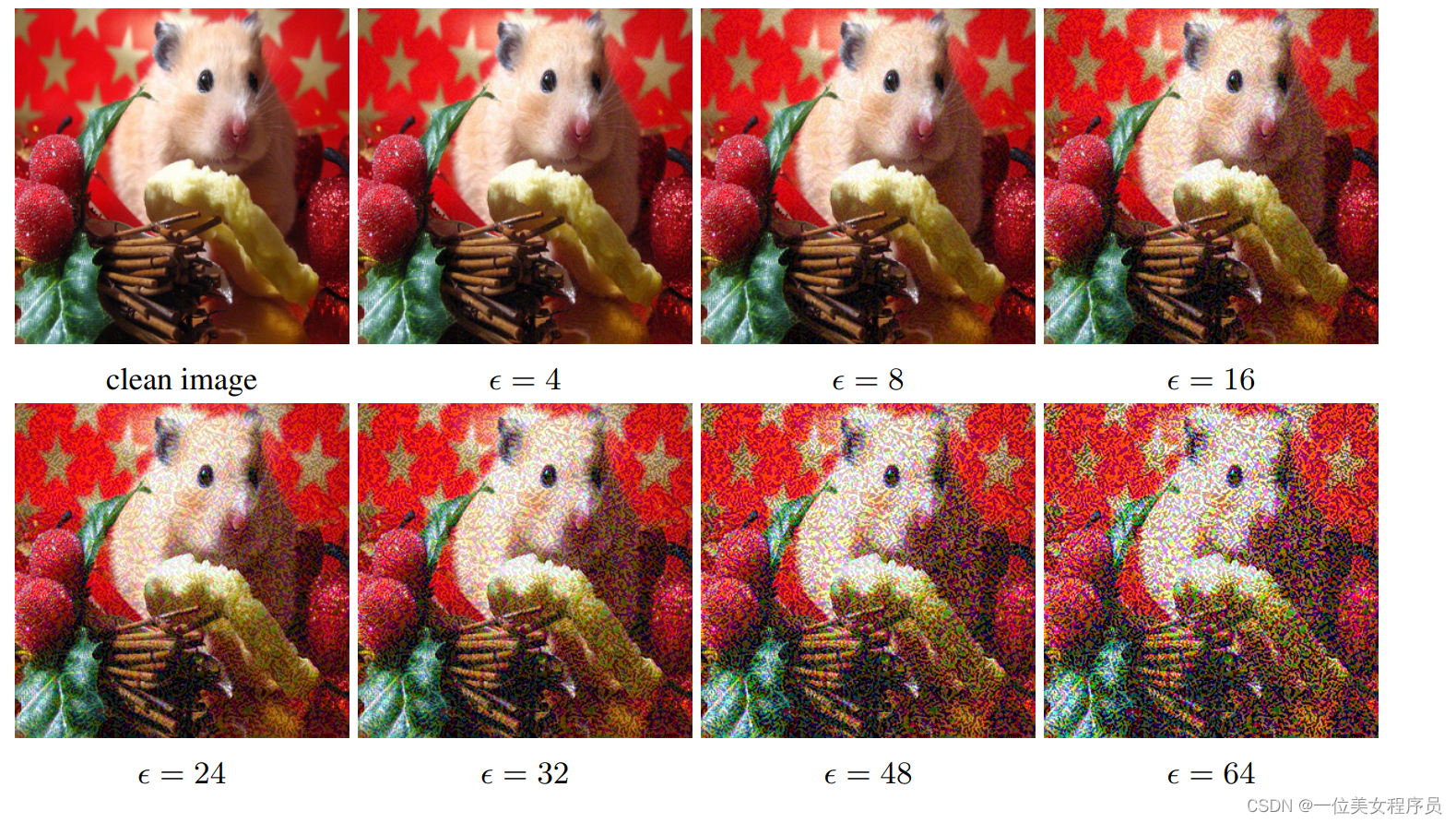

图2总结了各种对抗性方法在干净和对抗性图像上的Top-1和Top-5分类精度。图5和图4给出了生成的对抗性图像的示例。

图2:Inception v3的Top-1和Top-5准确性受到不同对抗方法和不同ε的攻击,与“干净的图像”(数据集中未修改的图像)相比。准确度是在ImageNet数据集中的所有50000张验证图像上计算出来的。在这些实验中,ε从2变化到128。

图4:ε=32的不同对抗性方法的比较。与快速方法相比,迭代方法产生的扰动更精细。此外,迭代方法并不总是选择ε-邻域边界上的一点作为对抗图像。

图5:使用不同大小扰动ε的“快速”方法对对抗性干扰产生的图像进行比较。上图是“洗衣机”,下图是“仓鼠”。在这两种情况下,对于所有考虑的ε,干净的图像被正确分类,而敌对的图像被错误分类。

如图2所示,即使ε值最小,快速方法也会将top-1精度降低2倍,top-5精度降低约40%。随着ε的增加,快速方法生成的对抗性图像的精度保持在大致相同的水平,直到ε=32,然后随着ε增加到128,精度慢慢降低到几乎为0。这可以通过以下事实来解释:快速方法将ε-缩放噪声添加到每个图像中,因此ε的较高值基本上会破坏图像的内容,使其即使是人类也无法识别,见图5。

另一方面,迭代方法利用更精细的扰动,即使ε更高,也不会破坏图像,同时会使分类器与更高的速率混淆。当ε<48时,基本迭代方法能够产生更好的对抗性图像,但随着ε的增加,它无法改善。即使ε相对较小,“最小可能类”方法也会破坏大多数图像的正确分类。

我们将所有进一步的实验限制在ε≤ 16因为这种扰动仅被视为一种小噪声(如果被察觉到的话),而对抗性方法能够在干净图像的ε邻域中产生大量误分类示例。

三、对抗性示例的照片

3.1 对抗图像的破坏率

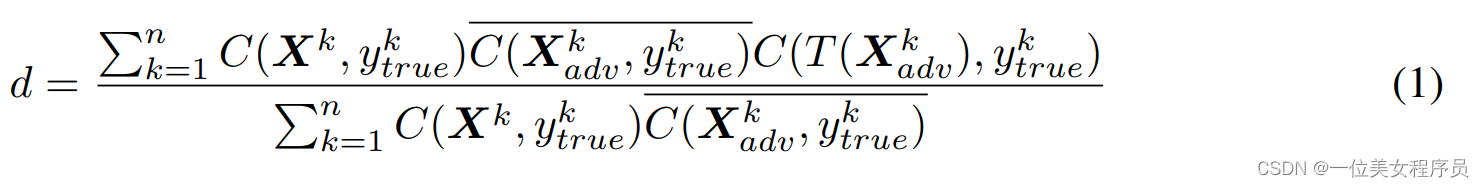

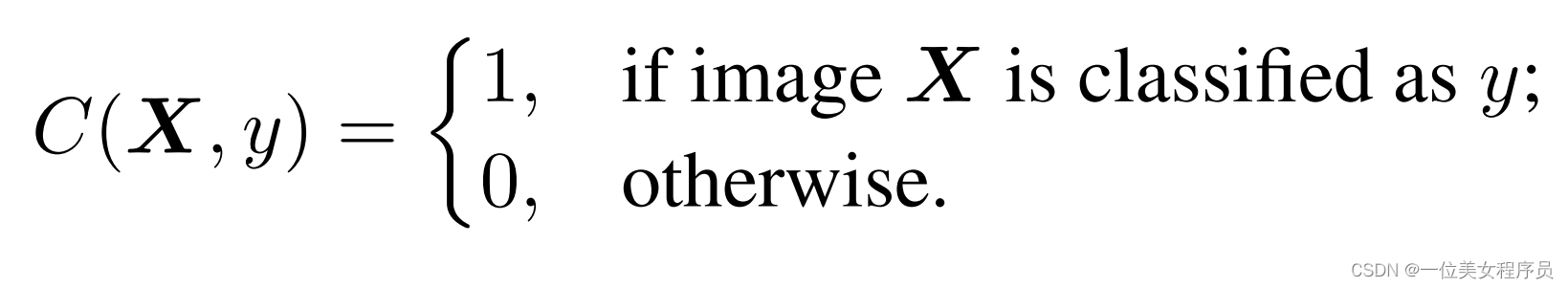

为了研究任意变换对敌对图像的影响,我们引入了破坏率的概念。它可以描述为在变换后不再被错误分类的敌对图像的分数。正式定义如下:

其中,n是用于计算破坏率的图像数,Xk是来自数据集的图像。

是该图像的正确类。

是相应的对抗图像。函数T(•)是一种任意的图像变换。在本文中,我们研究了各种变换,包括打印图像和拍摄结果。函数C(X,y)是一个指示函数,用于返回图像是否正确分类:

我们将该指示值的二元求反表示为

,计算为

3.2 实验装置

为了探索物理对抗性例子的可能性,我们用对抗性例子的照片进行了一系列实验。我们打印了干净和敌对的图像,对打印的页面进行了拍照,并从整页的照片中裁剪了打印的图像。我们可以将其视为黑箱变换,我们称之为“照片变换”。

我们计算了照片变换前后清晰和敌对图像的准确度,以及经过照片变换的敌对图像的破坏率。

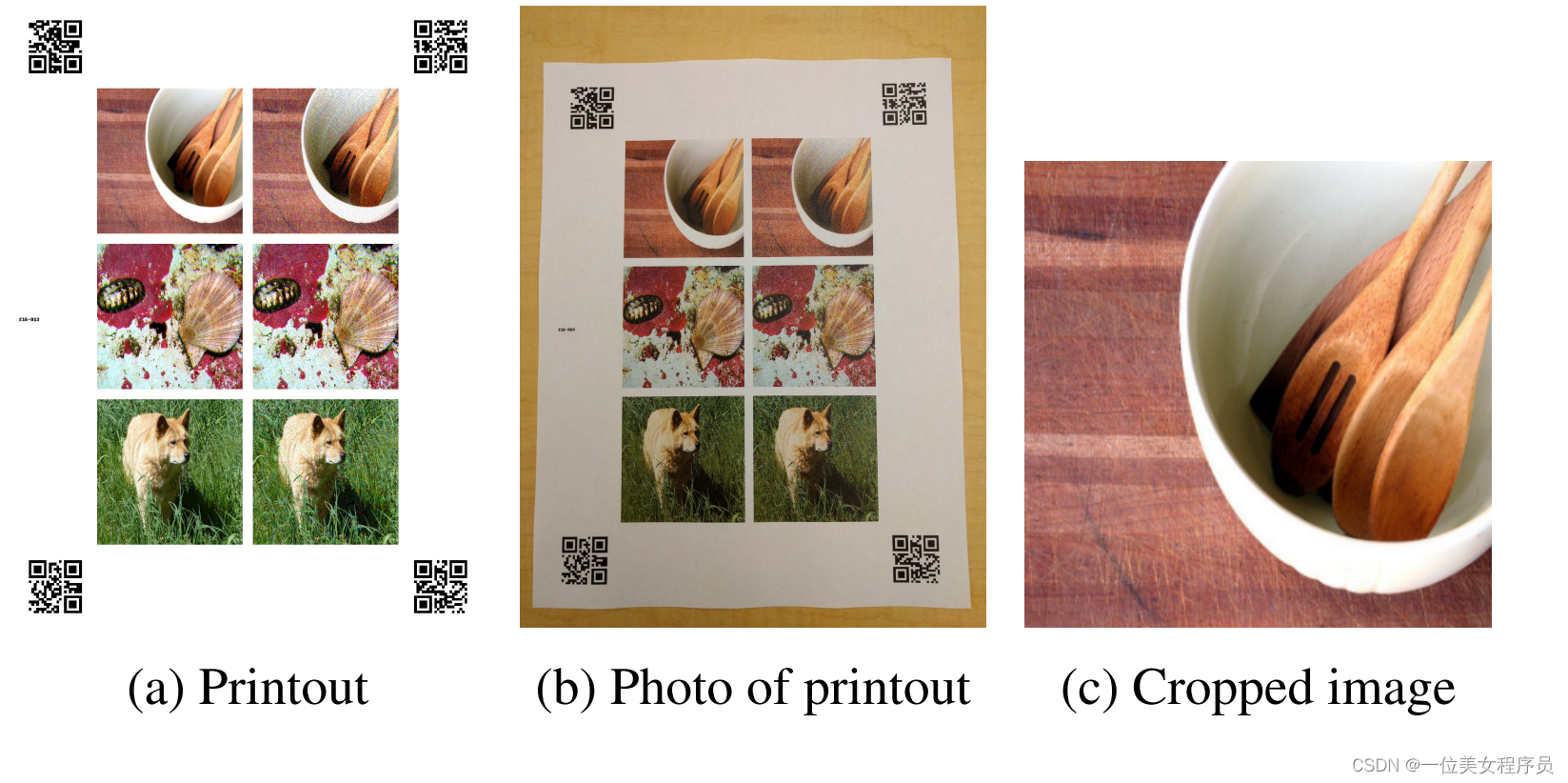

图3:实验设置:(a)生成的打印输出,其中包含成对清晰和敌对的图像,以及帮助自动裁剪的QR码;(b) 手机摄像头打印的照片;(c) 自动从照片中裁剪图像。

实验步骤如下:

- 打印图像,见图3a。为了减少手工工作量,我们在每张纸上打印了多对干净的和对立的示例。此外,QR码被放置在打印输出的角落,以便于自动裁剪。

(a) 所有生成的打印输出图片(图3a)均以无损PNG格式保存。

(b) 使用ImageMagick套件中的convert工具将成批PNG打印输出转换为多页PDF文件,默认设置为:convert *.png output.pdf

(c)生成的pdf文件使用理光MP C5503 office打印机打印。PDF文件的每一页都会使用默认的打印机缩放比例自动缩放,以适合整张纸。打印机分辨率设置为600dpi。 - 使用手机摄像头(Nexus 5x)拍摄打印图像,见图3b。

- 自动裁剪和扭曲照片中的验证示例,使其成为与源图像大小相同的正方形,见图3c:

(a) 检测照片角落中四个QR码的值和位置。QR码对照片上显示的验证示例批次进行编码。如果检测到任何一个角点失败,整个照片将被丢弃,并且照片中的图像不会用于计算精度。我们观察到,在任何实验中,丢弃的图像不超过所有图像的10%,通常丢弃的图像数量约为3%-6%。

(b) 使用透视变换扭曲照片,将QR码的位置移动到预定义的坐标中。

(c) 图像扭曲后,每个示例都有已知的坐标,可以很容易地从图像中裁剪出来。 - 对变换后的图像和源图像运行分类。计算对抗图像的准确性和破坏率。

该程序涉及手动拍摄打印页面的照片,而无需仔细控制照明、相机角度、到页面的距离等。这是有意的;它引入了令人讨厌的可变性,有可能破坏依赖于精确像素值的细微协同适应的对抗性干扰。也就是说,我们并没有故意寻找极端的相机角度或照明条件。所有照片都是在正常的室内照明下拍摄的,相机几乎笔直地指向页面。

对于对抗性示例生成方法和ε的每个组合,我们进行了两组实验:

- 普通情况。为了测量平均情况表现,我们随机选择102张图像,使用给定的ε和对抗性方法进行一个实验。这个实验估计了一个对手在随机选择的照片上成功的频率。世界随机选择一幅图像,而对手试图使其被错误分类。

- 预过滤情况。为了研究更具攻击性的攻击,我们进行了对图像进行预滤波的实验。具体来说,我们选择了102幅图像,所有干净的图像都能正确分类,而所有敌对图像(在照片变换之前)的分类都不正确(top-1和top-5分类)。此外,我们对顶部预测使用了置信阈值:p(ypredicted | X)≥ 0.8,其中ypredicted是网络对图像X预测的类别。此实验测量当对手可以选择原始图像进行攻击时,对手成功的频率。在我们的威胁模型下,对手可以访问模型参数和体系结构,因此攻击者可以始终进行推断,以确定在没有照片转换的情况下,攻击是否会成功。攻击者可能希望通过选择在此初始条件下成功的攻击来做到最好。然后,受害者为攻击者选择显示的物理对象拍摄一张新照片,照片转换可以保留攻击或摧毁攻击。

对抗性图像照片的实验结果

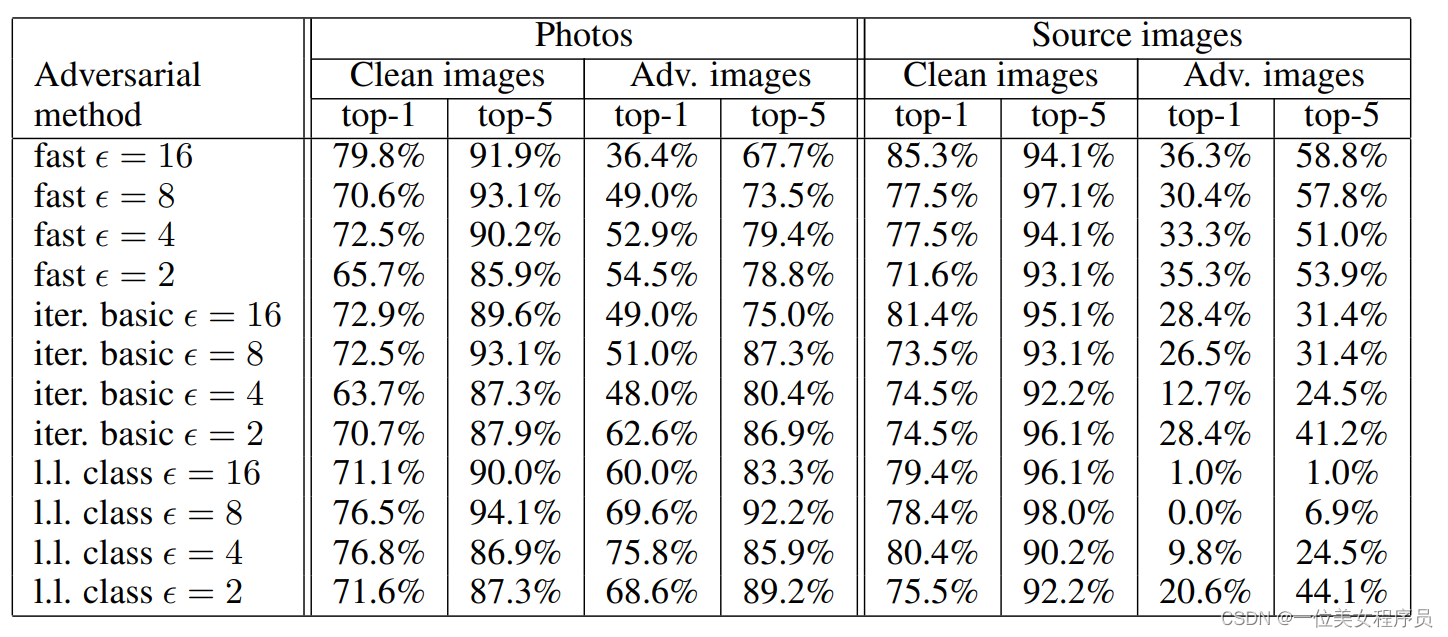

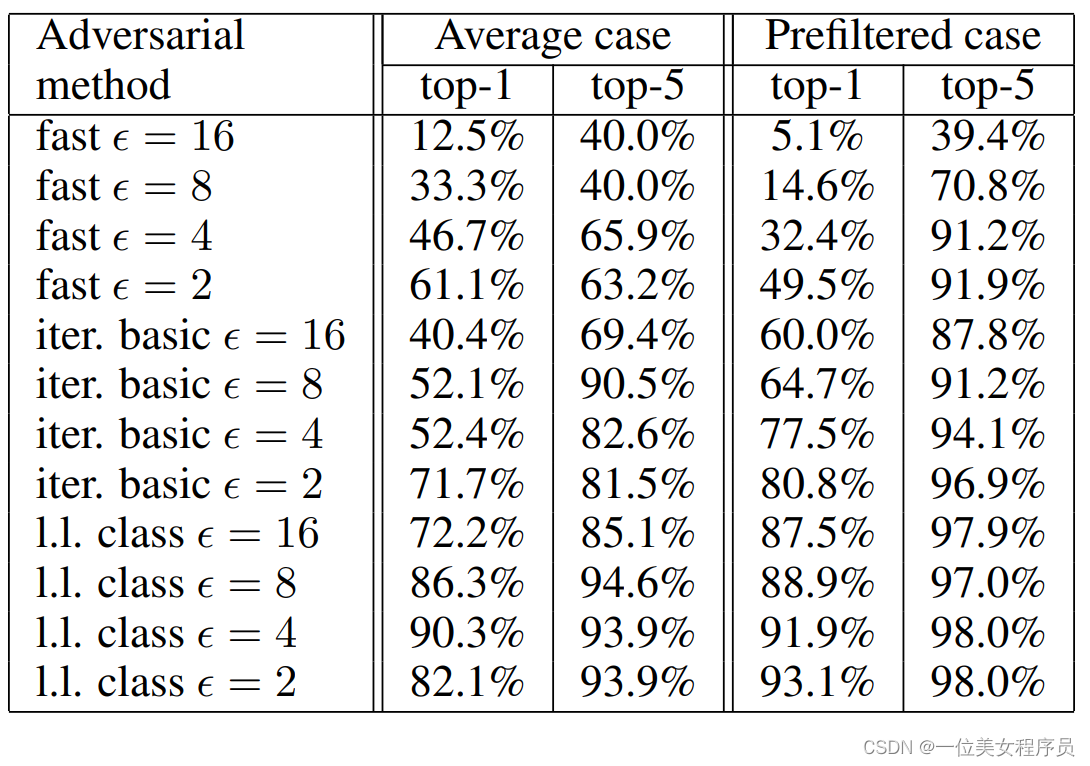

表1、2和3总结了照片转化实验的结果。

表1:一般情况下(随机选择的图像)敌对图像照片的准确性。

表2:预过滤案例中敌对图像照片的准确性(正确分类的干净图像,打印和拍摄的数字形式中错误分类的敌对图像)。

表3:带有照片的对抗性图像破坏率。

我们发现,与迭代方法相比,“快速”对抗性图像对照片变换更具鲁棒性。这可以通过以下事实来解释:迭代方法利用更细微的扰动,而这些细微的扰动更有可能被光变换破坏。

一个意外的结果是,在某些情况下,“预过滤案例”中的对抗图片破坏率高于“一般案例”。在迭代方法的情况下,预滤波图像的总成功率甚至低于随机选择的图像。这表明,为了获得非常高的置信度,迭代方法通常会进行细微的协同调整,而这些调整无法在照片变换中存活下来。

总的来说,结果表明,即使在经过一个非平凡的转换(照片转换)之后,一些对抗性示例仍然被错误分类。这证明了物理对抗示例的可能性。例如,使用ε=16的快速方法的对手可以预期,大约2/3的图像会被前1个错误分类,大约1/3的图像会被前5个错误分类。因此,通过生成足够多的敌方图像,敌方可能会造成比自然输入更多的错误分类。

3.4 演示物理世界中的黑箱对抗攻击

上述实验在假设对手完全可以访问模型(即,对手知道架构、模型权重等)的情况下研究物理对抗示例。然而,黑盒场景(攻击者无权访问该模型)是许多安全威胁的更现实模型。由于对抗性示例经常从一个模型转移到另一个模型,因此它们可能被用于Szegedy et al.(2014)和Papernot et al. (2016a)的黑盒攻击。作为我们自己的黑匣子攻击,我们证明了我们的物理对抗示例愚弄了一个不同于用于构建它们的模型。具体来说,我们展示了他们愚弄开源TensorFlow camera demo 2,这是一款手机应用程序,可以在设备上执行图像分类。我们向该应用程序显示了几个打印的清晰和敌对的图像,并观察到分类从真实标签到不正确标签的变化。带有演示的视频可在https://youtu.be/zQ_uMenoBCk上获得。我们还在2016年GeekPwn现场演示了这种效果。

四、人工图像变换

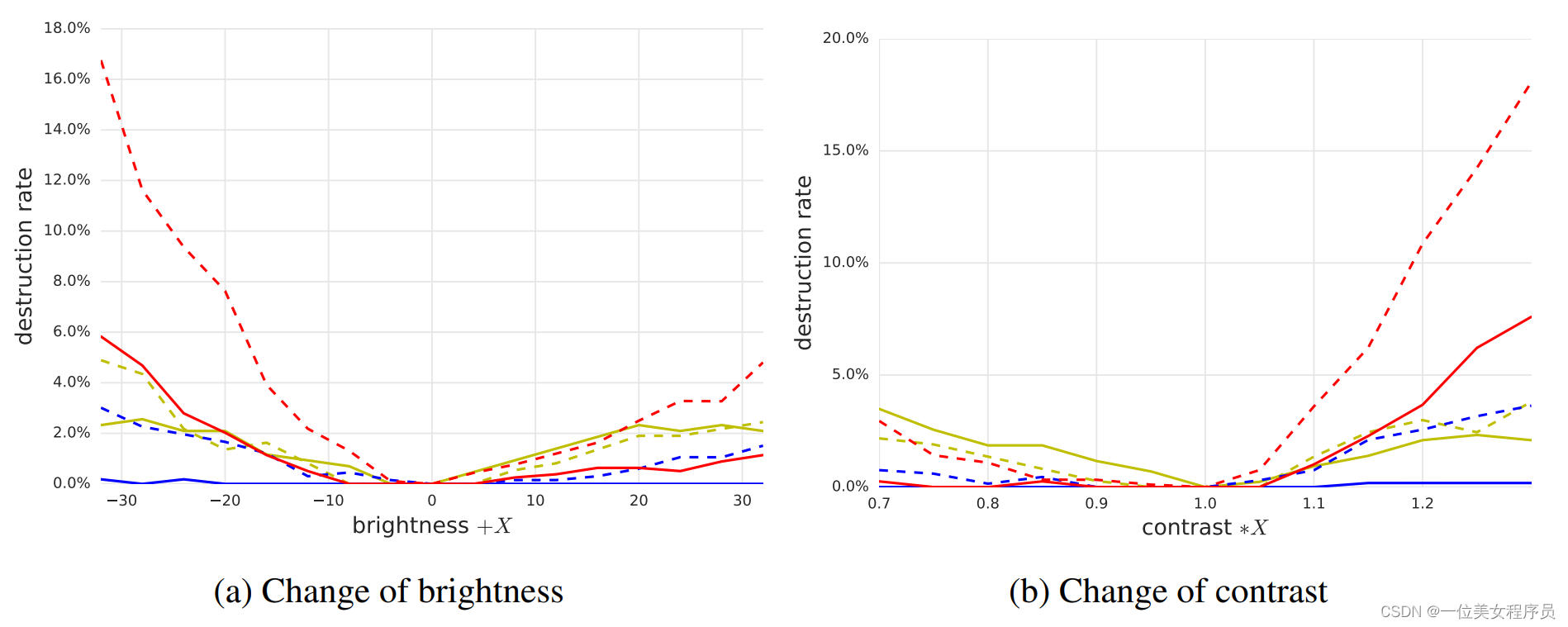

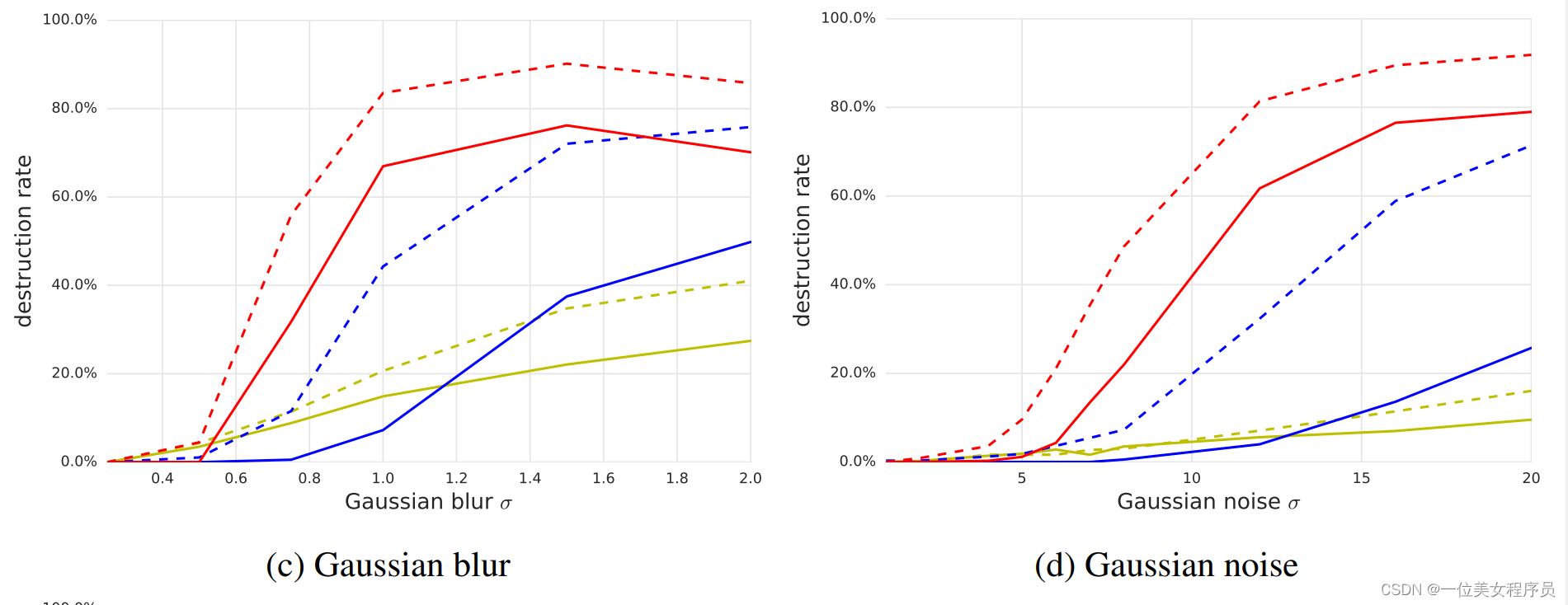

通过打印、拍摄和裁剪图像的过程应用于图像的变换可以视为更简单的图像变换的某种组合。因此,为了更好地了解正在发生的事情,我们进行了一系列实验来测量人工图像变换的对抗性破坏率。我们研究了以下变换集:对比度和亮度的变化、高斯模糊、高斯噪声和JPEG编码。

在这组实验中,我们使用了从验证集中随机选择的1000幅图像的子集。这1000幅图像的子集被选中一次,因此本节中的所有实验都使用相同的图像子集。我们对多对对抗性方法和转换进行了实验。对于每对给定的变换和对抗性方法,我们计算对抗性示例,将变换应用于对抗性示例,然后根据方程式(1)计算破坏率。

图6:各种对抗性方法和转换类型的对抗性破坏率比较。所有实验均以ε=16进行

ε=16的各种变换和对抗方法的详细结果可在图6中找到。从这些实验中可以得出以下一般观察结果:

- 快速方法生成的对抗性示例对转换的鲁棒性最强,迭代最小可能类方法生成的对抗性示例的鲁棒性最弱。这与我们关于照片变换的结果一致。

- 前5名的销毁率通常高于前1名的销毁率。这可以用这样一个事实来解释:为了“摧毁”前5个对抗性示例,转换必须将正确的类标签推到前5个预测中的一个。然而,为了摧毁排名第一的对抗性示例,我们必须将正确的标签推到排名第一的预测,这是一个严格的更高要求。

- 改变亮度和对比度对对抗性的例子影响不大。快速和基本迭代对抗示例的破坏率小于5%,迭代最小可能类方法的破坏率小于20%。

- 模糊、噪声和JPEG编码的破坏率高于亮度和对比度的变化。特别是迭代方法的破坏率可以达到80%− 90%. 然而,这些转变都没有100%摧毁敌对的例子,这与“照片转变”实验相吻合。

五、总结

在本文中,我们探讨了为在物理世界中运行的机器学习系统创建对抗性示例的可能性。我们使用手机摄像头拍摄的图像作为Inception v3图像分类神经网络的输入。我们发现,在这样的设置中,使用原始网络制作的对抗性图像中有相当一部分被错误分类,即使通过摄像头输入分类器。这一发现证明了物理世界中机器学习系统可能存在对抗性示例。在未来的工作中,我们希望能够演示使用纸张上打印的图像以外的其他类型的物理对象进行的攻击,针对不同类型的机器学习系统的攻击,例如复杂的强化学习代理,在没有访问模型参数和架构的情况下执行的攻击(可能使用传输属性),以及通过在对抗性示例构建过程中显式建模物理转换来实现更高成功率的物理攻击。我们还希望,今后的工作将制定有效的方法,防范此类袭击。