CV - 计算机视觉 | ML - 机器学习 | RL - 强化学习 | NLP 自然语言处理

Subjects: cs.CV

1.Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifold(SIGGRAPH 2023)

标题:拖动你的 GAN:生成图像流形上基于点的交互式操作

作者:Xingang Pan, Ayush Tewari, Thomas Leimkühler, Lingjie Liu, Abhimitra Meka, Christian Theobalt

文章链接:https://arxiv.org/abs/2305.10973

项目代码:https://vcai.mpi-inf.mpg.de/projects/DragGAN/

摘要:

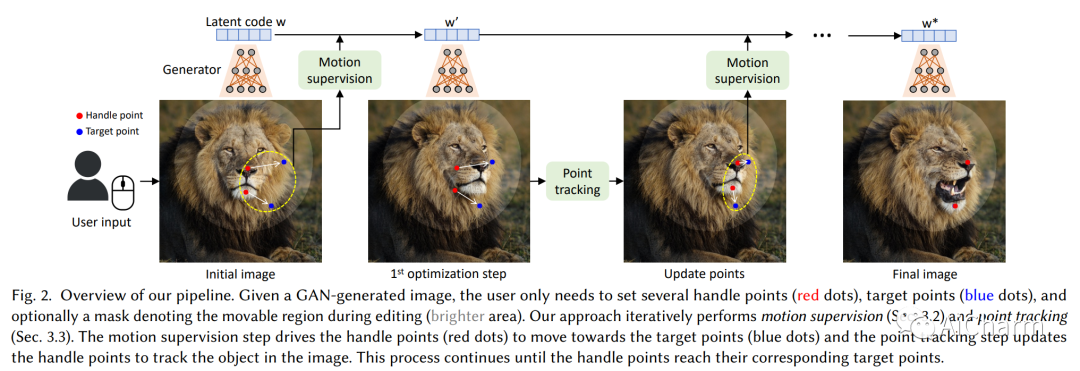

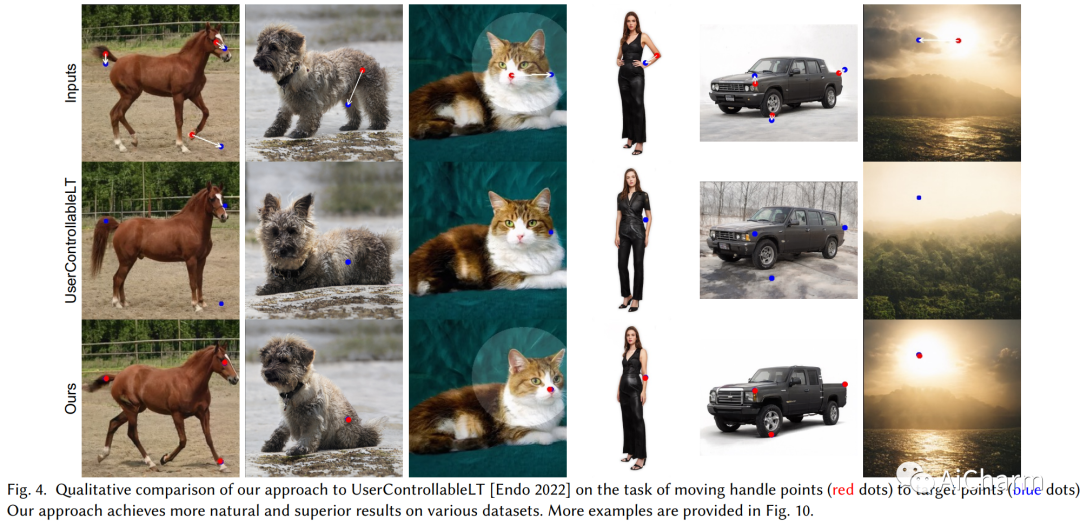

合成满足用户需求的视觉内容往往需要对生成对象的姿势、形状、表情和布局进行灵活和精确的控制。现有方法通过手动注释的训练数据或先前的 3D 模型获得生成对抗网络 (GAN) 的可控性,这通常缺乏灵活性、精确性和通用性。在这项工作中,我们研究了一种强大但探索较少的控制 GAN 的方法,即以用户交互的方式“拖动”图像的任何点以精确到达目标点,如图 1 所示。为实现这一目标,我们提出了 DragGAN,它由两个主要部分组成:1) 基于特征的运动监督,驱动手柄点向目标位置移动,以及 2) 一种新的点跟踪方法,利用判别生成器特征来继续定位手柄点的位置。通过 DragGAN,任何人都可以通过精确控制像素的位置对图像进行变形,从而操纵动物、汽车、人类、风景等不同类别的姿势、形状、表情和布局。由于 GAN 的生成图像流形,即使对于具有挑战性的场景,例如幻觉遮挡内容和始终遵循对象刚度的变形形状,它们也倾向于产生逼真的输出。定性和定量比较都证明了 DragGAN 在图像处理和点跟踪任务中优于先前方法的优势。我们还展示了通过 GAN 反演对真实图像的处理。

2.ONE-PEACE: Exploring One General Representation Model Toward Unlimited Modalities

标题:ONE-PEACE:探索一种通向无限模态的通用表示模型

作者:Peng Wang, Shijie Wang, Junyang Lin, Shuai Bai, Xiaohuan Zhou, Jingren Zhou, Xinggang Wang, Chang Zhou

文章链接:https://arxiv.org/abs/2305.11172

项目代码:https://github.com/OFA-Sys/ONE-PEACE

摘要:

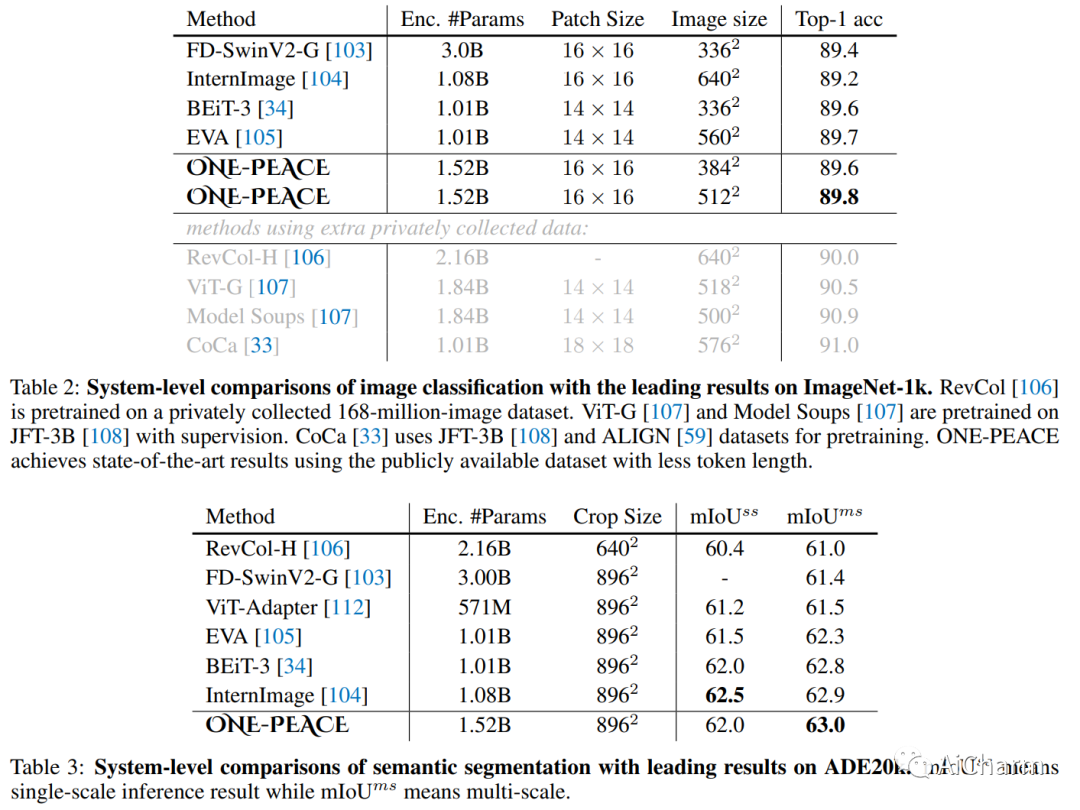

在这项工作中,我们探索了一种可扩展的方式来构建面向无限模式的通用表示模型。我们发布了 ONE-PEACE,这是一种具有 4B 参数的高度可扩展模型,可以跨视觉、音频和语言模式无缝对齐和集成表示。ONE-PEACE 的架构包括模态适配器、共享自注意力层和模态 FFN。这种设计允许通过添加适配器和 FFN 轻松扩展新模态,同时还可以通过自注意力层实现多模态融合。为了预训练 ONE-PEACE,我们开发了两个与模态无关的预训练任务,跨模态对齐对比和模态内去噪对比,它们对齐不同模态的语义空间并同时捕获模态内的细粒度细节。凭借易于扩展的架构和预训练任务,ONE-PEACE 具有扩展到无限模式的潜力。在不使用任何视觉或语言预训练模型进行初始化的情况下,ONE-PEACE 在广泛的单模态和多模态任务上取得了领先的结果,包括图像分类(ImageNet)、语义分割(ADE20K)、音频文本检索(AudioCaps) , Clotho)、音频分类(ESC-50、FSD50K、VGGSound)、音频问答(AVQA)、图文检索(MSCOCO、Flickr30K)、视觉接地(RefCOCO/+/g)。

3.Exploring the Space of Key-Value-Query Models with Intention

标题:有意探索键值查询模型的空间

作者:Marta Garnelo, Wojciech Marian Czarnecki

文章链接:https://arxiv.org/abs/2305.10203

摘要:

基于注意力的模型一直是深度学习近期许多突破的关键要素。Attention 的两个关键组成部分是其输入结构(由键、值和查询组成)以及将这三者组合在一起的计算。在本文中,我们探索了共享所述输入结构但不限于注意力计算的模型空间。我们将此空间称为键值查询 (KVQ) 空间。我们的目标是确定 KVQ 空间中是否存在 Attention 无法有效近似的任何其他可堆叠模型,我们可以使用我们当前的深度学习工具箱来实现这些模型并解决社区感兴趣的问题。也许令人惊讶的是,标准最小二乘问题的解决方案满足这些属性。能够计算该解决方案的神经网络模块不仅丰富了神经网络可以表示的计算集,而且可以证明是线性注意力的严格概括。更令人惊讶的是,该模块的计算复杂度与 Attention 完全相同,使其成为合适的替代品。通过建立经典机器学习(最小二乘)和现代深度学习(注意力)之间的这种新颖联系,我们证明了我们模型的一种变体,它以相同的方式概括了常规注意力。这两个新模块都接受了从小样本学习到政策提炼等广泛任务的测试,以确认它们在现实世界中的适用性。

更多Ai资讯:公主号AiCharm