吴恩达 机器学习课程笔记

学习视频

https://www.bilibili.com/video/BV164411b7dx?p=4

书籍:周志华 西瓜书

第1章

1-2什么是机器学习

- 机器学习:计算机程序从经验E(experience)中学习,解决某一任务T(task),进行某一性能度量P(performance),通过P测定在T上的表现因经验E而提高。

- 对于跳棋游戏,经验E就是程序与自己下几万次跳棋,任务T就是下跳棋,性能度量P就是与新玩手玩跳棋时赢的次数。

1-3 监督学习(supervised learning algorithm)

- 监督学习:对于数据集中的每个样本,想要“算法预测”并得出“正确答案”。例如房子的价格,肿瘤是良性的还是恶性的。

- 回归问题:目标值是预测一个连续值输出。

- 分类问题:目标值是预测一个离散值输出。

1-4 无监督学习(unsupervised learning algorithm)

- 无监督学习:对于给定的数据集,没有给出

正确答案的算法,计算机自动找出数据集的数据结构。 - 聚类算法:在给定的数据集中,将数据集分成两个或者多个不同的簇。例如,谷歌新闻(news.goole.com)。

- 鸡尾酒算法:

第2章

2-1 模型描述

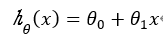

- 单变量线性回归:

2-2 代价函数

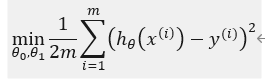

- 为求出与数据集拟合度最好的假设函数,必须求出假设函数中最合适的θ_0和θ_1的值。

- 当假设函数与数据集最拟合的时候,就是所有数据集到假设函数的距离的平均值最小,反之,当假设函数到所有数据集的距离的平均值最小的时候,就是最拟合的时候。则可以如下定义:

使用1/2m主要是为了接下来的梯度下降求解比较方便。称上述函数为代价函数(均方误差函数)。 - 本节课所提及函数总结如下:

2-3 代价函数(一)

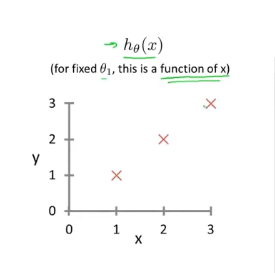

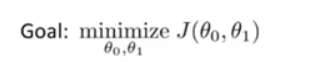

为了了解代价函数,将假设θ_0=0,即假设函数中只有参数θ_1。同时,给出数据集为(1,1)(2,2)(3,3),将这三个坐标值在假设函数中的图像标注出来,如下所示

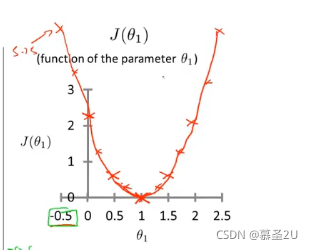

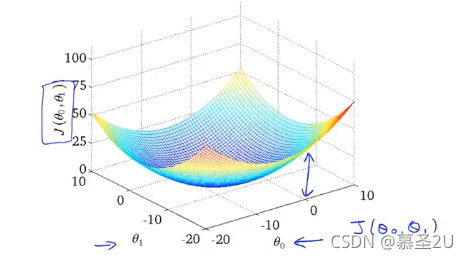

假设θ_1=-0.5、0、1、1.5时,作出拟合曲线,并计算出对应的J(θ_1)的值;画出J(θ_1)函数的图像,如下图所示,可知J(θ_1)函数是一个开口向上的凸函数:

由上节课可知,我们要优化的目标函数是:

由J(θ_1)函数图像可知,当θ_1=1时,目标函数取最优值,此时h_θ(x)函数与数据集拟合度最好:

2-4 代价函数(二)

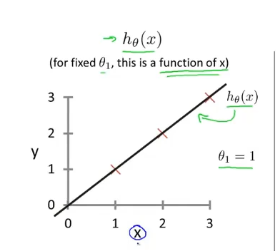

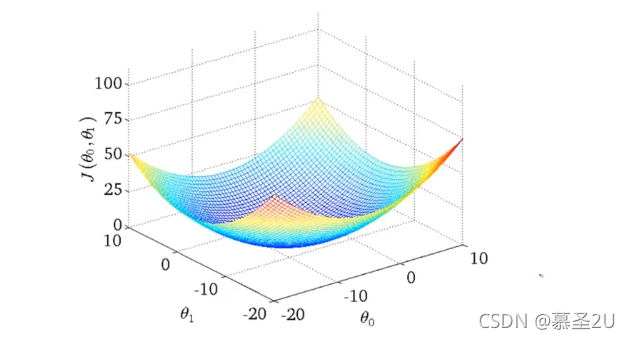

不再假设θ_0=0时,根据代价函数作出的代价函数图像是一个3D曲面,如下图所示:

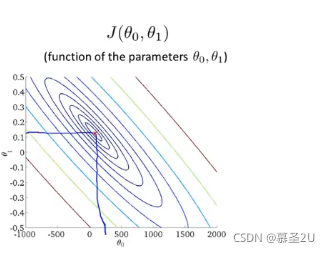

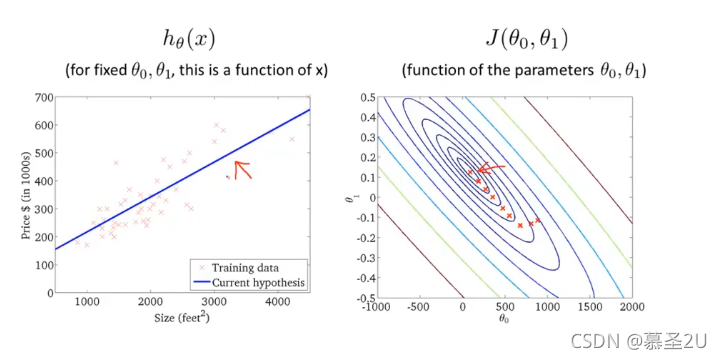

利用等高线图展示上述3D曲面,如下图所示:

所有椭圆的中心点就是目标函数所找的最优值θ_0和θ_1的值。例如,上述图像中所指的点对应的假设函数图像为:

这个(θ_0,θ_1)可能不是最优值,但是已经很接近了。

但是,我们不可能作出图像后手动寻找最优值,并且有些图像难以可视化,所以,我们需要软件来自动寻找最优值。

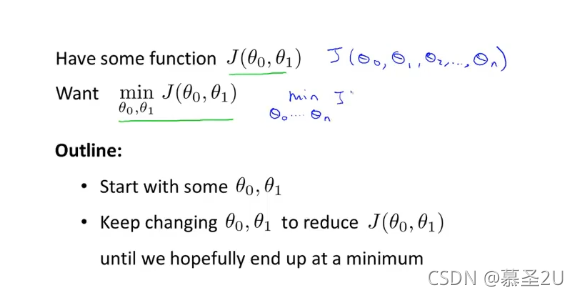

2-5 梯度下降

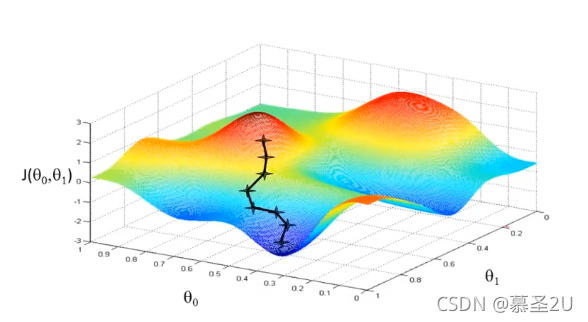

1. 梯度下降的定义:为了求出给定函数的最小值,以任意坐标为起点,接着不断改变坐标值,直至找到J(θ_0,θ_1)函数的最小值。

2-6 梯度下降知识点总结

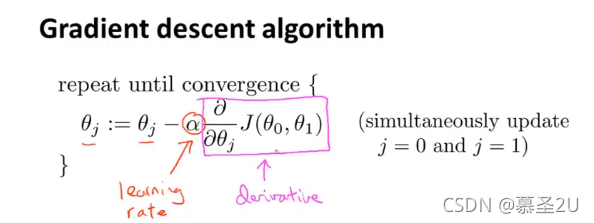

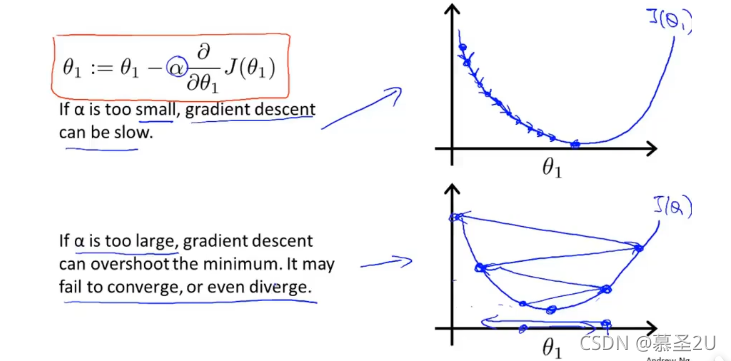

- 在下图中的等式中,α表示学习率,控制以多大的幅度更新θ_j;后边一项是偏导数,接下来,将学习这两部分的作用。

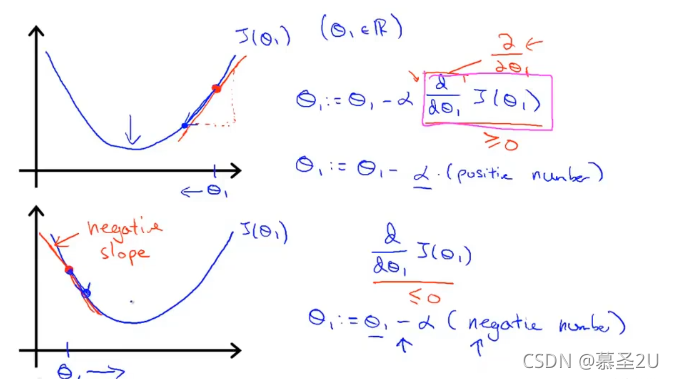

- 仍然假设只有参数θ_1时,此时求偏导变为了求导数,即某一点处的斜率,

当导数大于0或者小于0,θ_1都会向最低点移动。已知:α永远是正数。 - 当α很小时,更新θ_j的幅度较小,趋向最优点的速度较慢;当alpha很大时,更新θ_j的幅度很大,但是逐渐远离最优点。

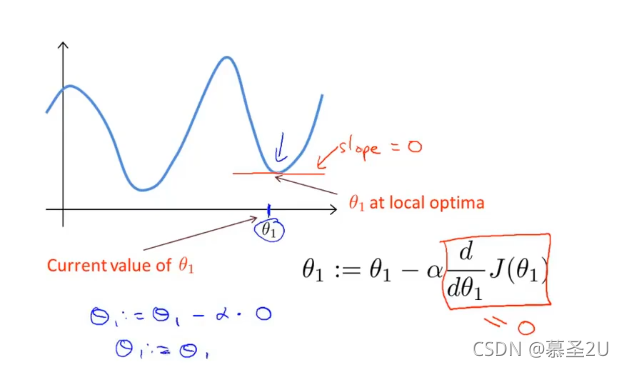

- 一个思考题:当θ_j已经更新到最优点时,下一步梯度下降会怎么办?

当θ_j处于最优点时,此时的偏导数值=0,再次更新之后,θ_j的值没有变化。

所以,当θ_j已经更新到最优点时,梯度下降算法实质上没有做什么。

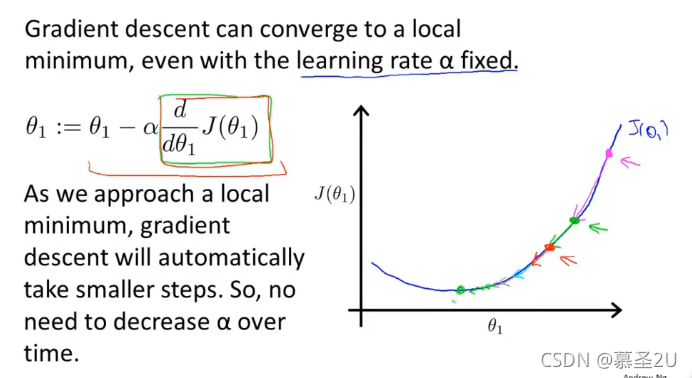

- 即使学习率α不变,梯度下降也会在趋近最优点的过程中,由于导数的减小,自动缩小步伐,直至到达最优点

2-7 线性回归的梯度下降

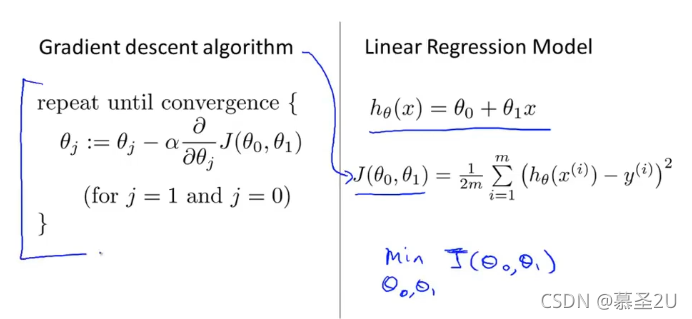

- 在线性回归函数中,运用梯度下降算法求解最小化代价函数,最关键的问题是写好更新θ_j的算法。

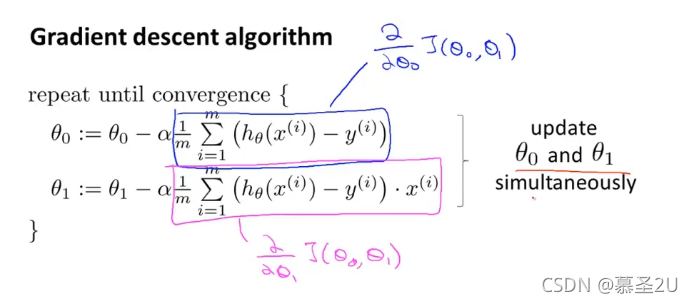

- 在梯度下降算法中带入线性回归函数函数,得到如下图所示的赋值等式:

第一次介绍梯度下降算法时,介绍了梯度下降算法容易陷入局部最优解,如下所示:

但是,在线性回归的代价函数中,只有一个最优解。

计算这种代价函数时,只要使用线性回归函数,它总是能收敛到全局最优。 - 当θ_0,θ_1逐步向中心点靠近,假设函数h(θ_x)找到最优拟合曲线。

- 刚刚所使用的梯度下降算法又名Batch算法:在每一步的梯度下降中,使用了所有的训练样本。

3-3 矩阵向量乘法

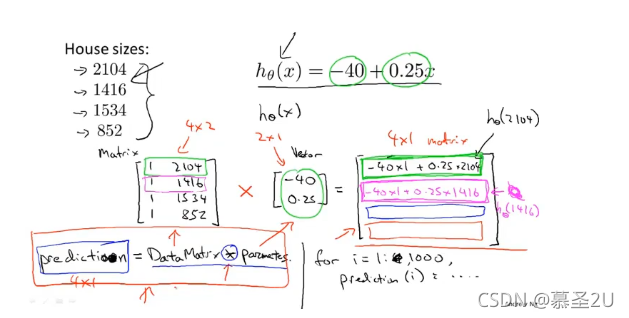

利用矩阵向量乘法,简化预测房子价格的代码: