注:本章的内容作为补充插曲,大家可以选看,不过还是建议把最后一个使用蒙特卡洛近似求期望稍微看一下

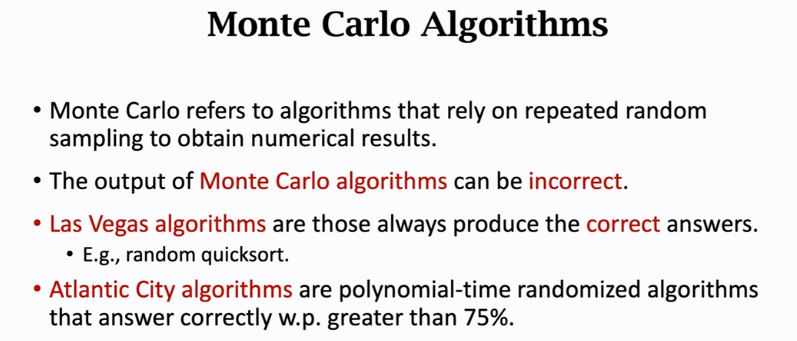

蒙特卡洛是一大堆随机算法,通过随机样本来估算真实值

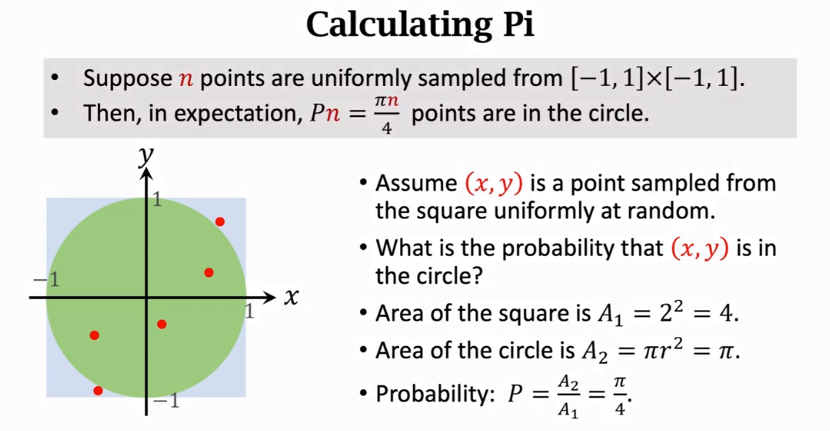

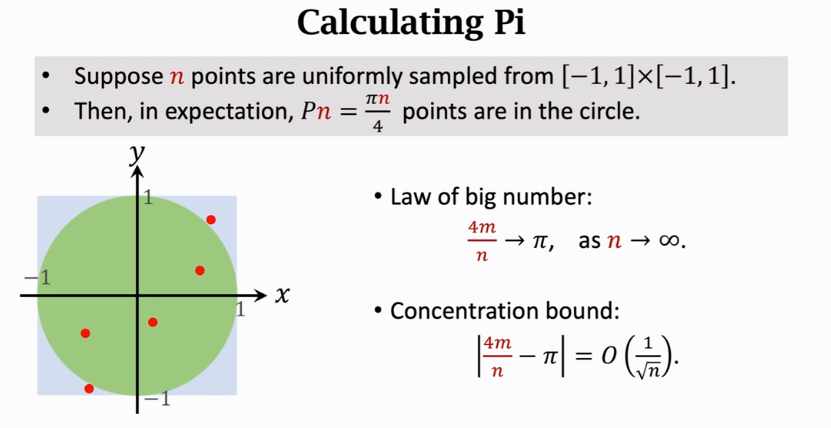

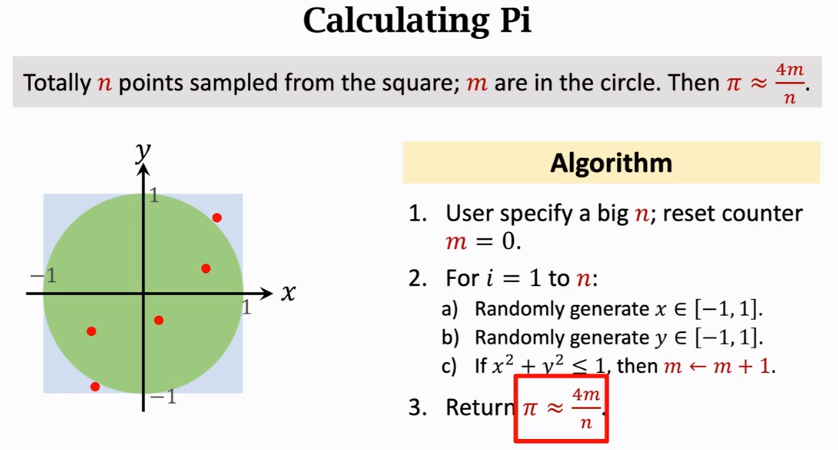

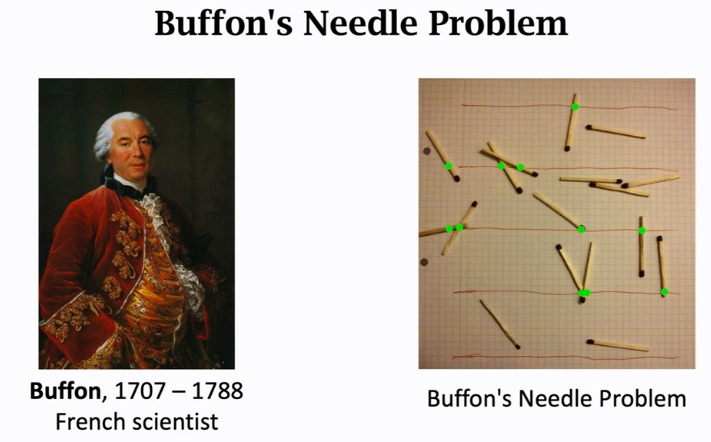

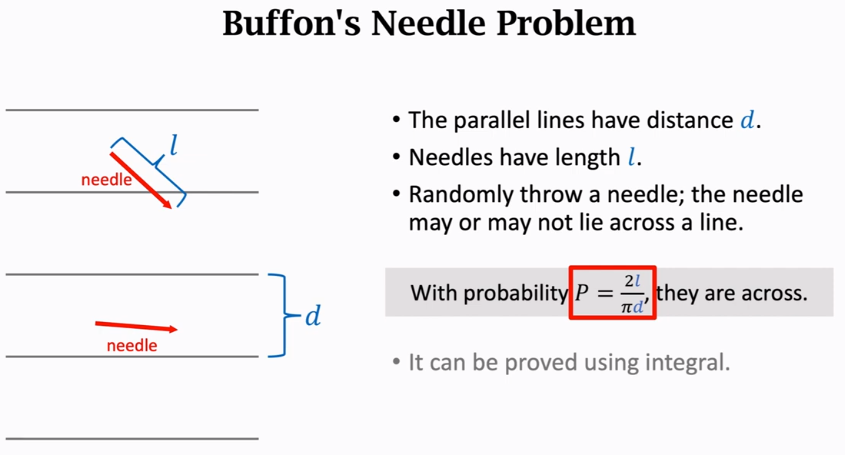

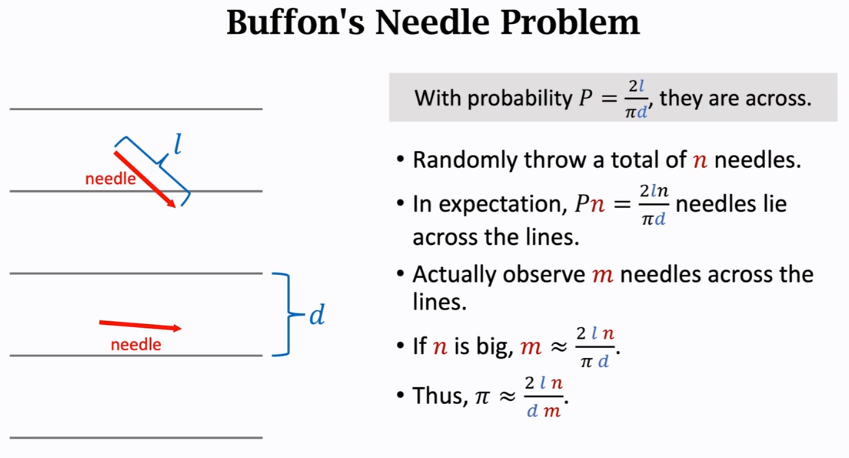

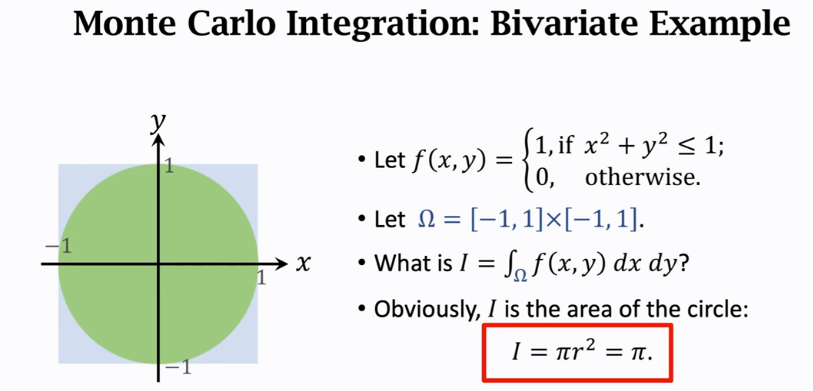

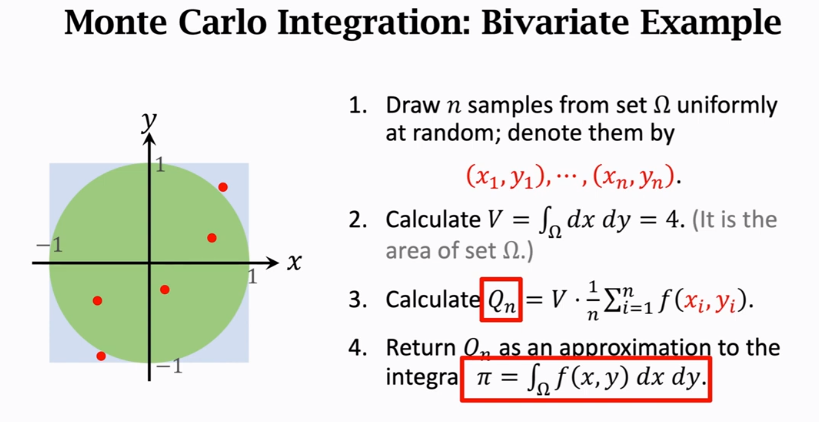

使用随机样本来近似Π

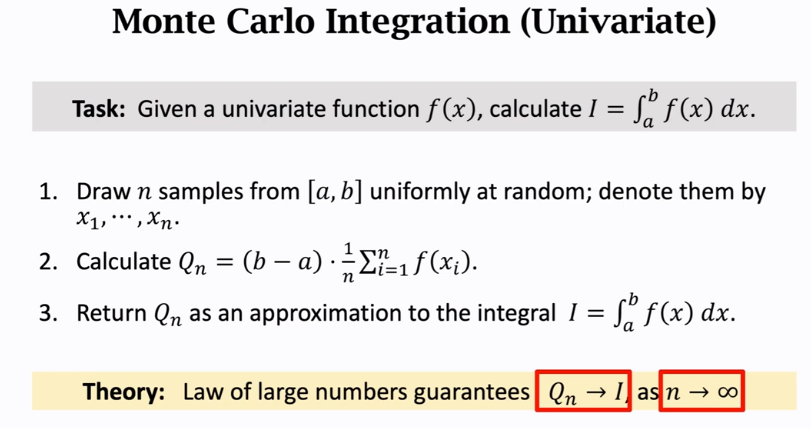

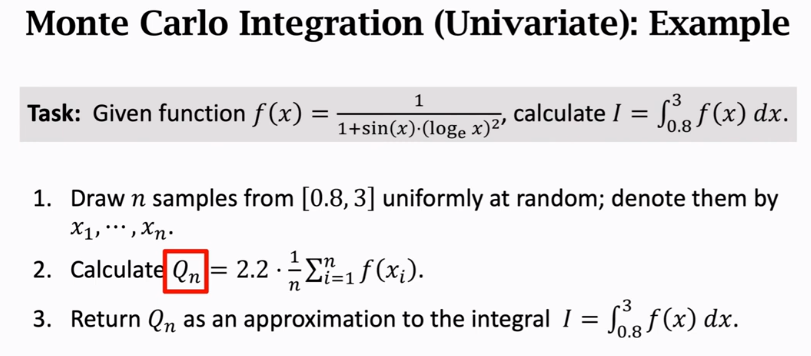

1、在[a,b]做随机均匀抽样,抽出n个样本

常用的编程语言都有随机数生成器,全都支持均匀抽样

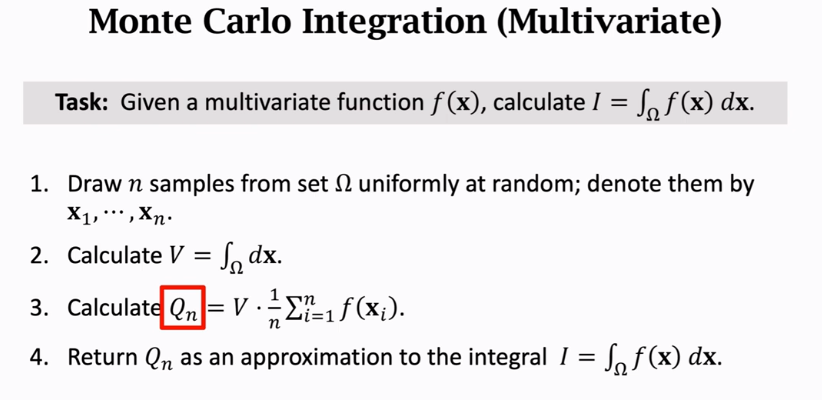

多元蒙特卡洛积分:

集合Ω必须是简单的形状,否则不好计算他的面积或者体积

使用蒙特卡洛来近似期望:

使用蒙特卡洛来近似期望:

这对统计学和机器学习特别有用:

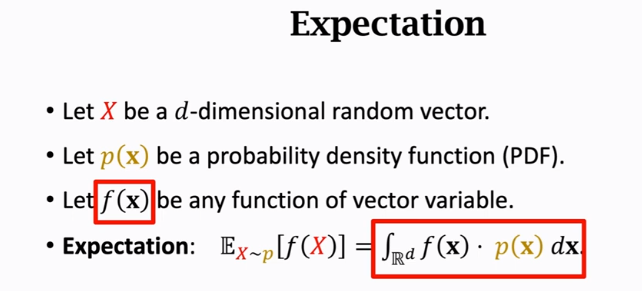

随机变量大写,观测值小写

函数px是一个概率密度函数,他描述变量x在某个取值点附近的可能性

来复习一下函数的期望:

f(x)是任意的函数,他的参数是b维的向量

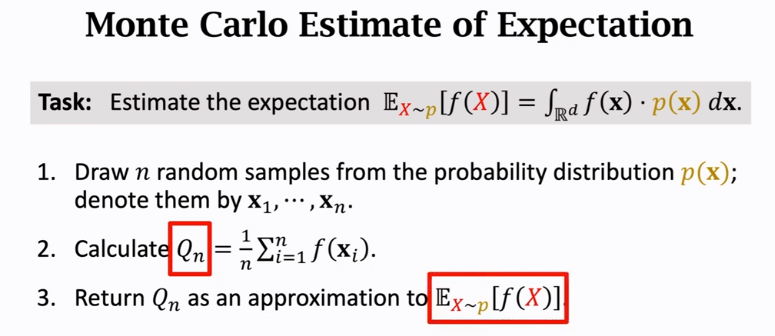

直接求这个定积分并不容易,尤其是变量X是高维向量的时候

所以使用蒙特卡洛近似求期望:

1、不再均匀抽样,而是根据概率密度函数p(x)来对样本进行抽样,对于高斯分布等常见的概率分布,都有现成的抽样函数

3、使用Qn作为对期望的估计

Mark:机器学习和统计中低精度能大幅降低计算量已经够用了,例如随机梯度下降算法也是一种MC算法