一、前言

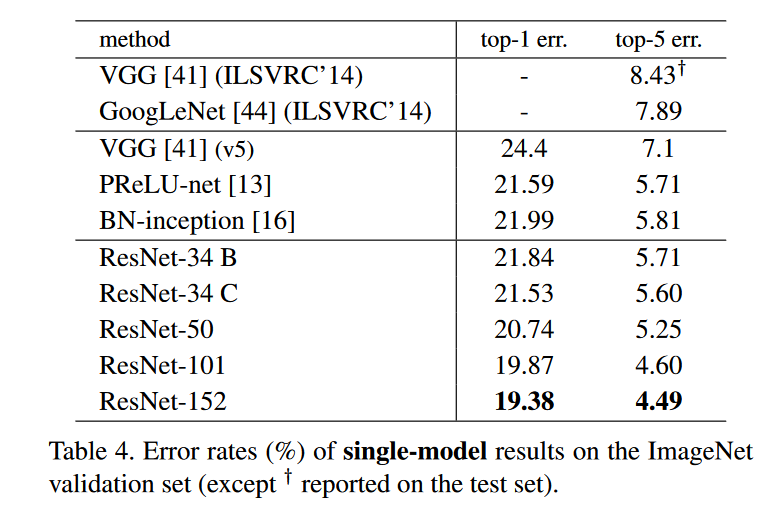

在看论文里面提到Top-5和top-1错误率,看了有点懵,所以去了解了一下

二、什么是Top-5和Top-1准确率与错误率

举个例子:

我们在训练完某个分类网络后,假设我们需要分类的数量为50类,我们需要评估它的分类性能。输入测试集的每张图片,会得到它的50个类别的的概率。

Top-5准确率就是:在这张测试的图片50的类别中,取出概率最大的前五个类别,如果真实类别在这五个类别中,则预测正确,否则预测错误,再测完全部测试集。

t o p − 5 A c c u r a c y = 真实类别在预测的五个类别中的数量 所有测试集的数量 top-5 Accuracy=\frac{真实类别在预测的五个类别中的数量}{所有测试集的数量} top−5Accuracy=所有测试集的数量真实类别在预测的五个类别中的数量

同理:Top-1准确率其实就是平常我们评估预测的准确性指标

T o p − 1 A c c u r a c y = 预测正确的数量 所有测试集的数量 Top-1 Accuracy=\frac{预测正确的数量}{所有测试集的数量} Top−1Accuracy=所有测试集的数量预测正确的数量

而Top-5错误率与Top-1错误率恰好与top-5准确率和top-1准确率相反,他们的和为1

个人见解:Top-5准确率相对于Top-1是更为宽松的评估指标,显然Top-5 Accuracy >= Top-1 Accuracy

有一点就是如果对于预测的类别数多的数据集,预测的类别数越大,Top-5与Top-1更接近