Kmeans聚类算法

Kmeans算法类型:

Kmeans算法属于无监督学习的聚类算法.无监督学习是指没有明确的标签,这类问题没有标准的答案.

Kmeans算法原理

什么是聚类?

所谓聚类问题,就是给定一个数据集D,其中每个样本具有n个属性,使用某种算法将D划分成k个子集,要求每个子集内部的元素之间相似度尽可能的高,而不同子集的元素相似度尽可能低。其中每个子集叫做一个簇。

聚类目的:类内相似、类间相异

Kmeas原理

1、从数据集D中随机取k个元素,作为k个簇的各自的中心(质心)。

2、分别计算剩下的元素到k个簇中心的相似度,并将其归属为和其做相似的簇。

3、根据聚类结果,重新计算k个簇各自的中心,计算方法是取簇中所有元素各自维度的算术平均数。

4、重复2-3,直到满足停止条件。

停止条件通常为:聚类结果几乎不再发生变化,或者达到一定的迭代次数。

Kmeans 算法特点

-

需要自定义K值

-

数据如果量纲的影响,需要进行标准化

-

受异常值的影响(如果存在异常点,通常会自成一类)

-

会收敛于局部最优(随机初始化的聚类中心,导致结果无法达到全局最优)

衡量聚类效果:观察每个样本到各自聚类中心的距离的和

k-mean算法之前 考虑 是否有异常值、是否需要数据标准化

Kmeans算法sklearn中的api

def __init__(self, n_clusters=8, init='k-means++', n_init=10,

max_iter=300, tol=1e-4, precompute_distances='auto',

verbose=0, random_state=None, copy_x=True,

n_jobs=None, algorithm='auto'):

参数n_clusters ---K值 最小值是2

参数 init 聚类中心初始化的方法 k-means++

参数 max_iter 最大迭代次数 如果后期无法收敛(收敛 convergence) 调大max_iter

参数random_state 随机种子

Kmeans算法基于sklearn实现

from sklearn.cluster import KMeans

from sklearn.preprocessing import MaxAbsScaler # 小数定标标准化

from sklearn.preprocessing import MinMaxScaler # 离差标准化

from sklearn.preprocessing import StandardScaler # 标准差标准化

# 评估指标-----轮廓系数

from sklearn.metrics import silhouetee_score

# 由于是聚类算法,数据可能存在量纲,需要标准化,在使用算法之前

# 实例化

sca = MaxAbsScaler()

sca = MinMaxScaler()

sca = StandardScaler()

# 拟合

sca.fit( 训练集特征 )

# 处理数据

X_train = sca.transform( 训练集特征 )

# 实例化

km = KMeans()

# 参数:

# n_clusters=3,表示k=3,也就是随机三个聚类中心,最小值是2

# init,聚类中心初始化方法,默认k-means++

# max_iter,最大迭代次数,默认300,如果后期无法收敛可以尝试增加迭代次数

# random_state=1,随机种子,默认是None

# 拟合

km.fit( 训练集特征 )

# 查看聚类中心

print('聚类中心:', km.cluster_centers_)

# 查看预测结果

# 可以直接传入训练集,也可以传入自定义二维数组

y_pred = km.predict( 训练集特征 )

print('整个数据的类别:', y_pred)

# 查看SSE---误差平方和

# 默认是取反操作,大多数情况得出来的是负值【-inf, 0】

# 绝对值越小越好

score = km.score(X_train, y_pred)

print('SSE', score)

# 评估指标----轮廓系数(-1, 1),越大越好

print('轮廓系数:', silhouetee_score(X_train, y_pred))

Kmeans与KNN的异同

相同:

- 都有K值这个超参数

- 都使用距离衡量(表征)相似度

不同:

- KNN中的K代表选取测试点周围距离最近点的个数.

- Kmeans中的K代表将数据聚为K类.

- KNN是有监督学习的分类和回归算法

- K-mean无监督的聚类算法

k-means如何选择最优的K值

-

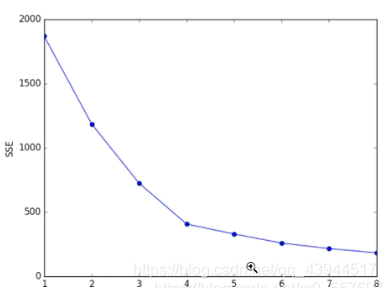

手肘法:设置一些列K值,统计不同K值的SSE(误差平方和)----选择拐点的位置

SSE 范围【–inf,0】

-

设置一些列K值、统计不同K值的轮廓系数

范围【-1,1】

选取k值实现过程

1.计算不同k值的SSE,绘制图像,选择图像拐点的k值相对是比较好的,由于图像画出来类似于手肘,所以叫手肘法,选取手肘拐点即可。手肘法选取的就是相对较好的点,也就相当于一个折中效果,使预测结果不会太差,防止过拟合现象的发生。

2.获取最优轮廓系数

如果想要最优的点,还是要选取最高的点。

设置不同的k值进行测试计算轮廓系数,就能得到最优的k值对应的最优的轮廓系数,也可以绘图进行观察,选取最高。但是为了防止过拟合的现象,也可以通过手肘进行选取最优k值