- 线性回归用来拟合连续的y效果很好,但是用来做分类却效果很差。

- 逻辑回归虽然名字是回归但是却是用于分类

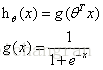

- 逻辑回归模型:

模型的输出值表示结果为1的概率多少,一般当概率>0.5则认为结果为1,<0.5则认为结果为0. - 决策面:

从上可知,决策面大于0,则认为结果为1;决策面小于1,则认为结果为0.决策面可以是线性的,也可以是非线性的,如线性回归中所述

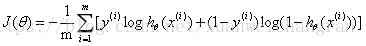

- 代价函数(代码函数最好为凸函数,以求得全局最优解):

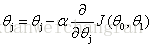

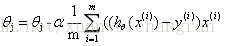

- 采用梯度下降法最小化代价函数:

代入代价函数后,求得:

次梯度下降的解似乎与线性回归一样,但是其实h函数是不一样的。 - 求解θ更优的方法:Conjugate gradient,BFGS,L-BFGS。这些方法会自动选择α值,并做一些其他的优化。

- 多元分类:以其中一个类别为1,其余类别为0,依次求出对于各类的分类器,然后选择分类结果最高的那个,作为最终结果。

机器学习理论之逻辑回归

猜你喜欢

转载自blog.csdn.net/xuanweichangran/article/details/80249003

今日推荐

周排行