Non-Deep Network拜读

本文是普林斯顿大学的Jia Deng团队的最新力作ParNet。它凭借12层的深度网络在ImageNet上达到了80.7%的top-1精度。所提ParNet以RepVGG的模块为出发点,同时提出了针对非深度网络设计的SSE模块构建了一种新型的模块RepVGG-SSE 。所提方案凭借非常浅的结构取得了非常高的性能,比如:ImageNet的80.7% ,CIFAR10的96%,CIFAR100的81%,MS-COCO的48%。此外,作者还分析了该结构的缩放规则并说明了如何不改变网络提升提升性能。最后,作者还提供了一份证明:非深度网络如何用于构建低延迟识别系统

0、摘要Abstract

Depth(深)是深度神经网络的标志。但是,更深意味着更多的计算量、更高的推理延迟。这就引出了一个问题——是否有可能构建高性能的“non-deep”神经网络呢?

基于此,Jia Deng团队设计出用“ 并行parallel subnetworks”代替串行网络,这在保持高性能的前提下,有效的降低了网络深度。

通过利用并行子结构,首次以深度为12的网络在ImageNet数据集上达到了80.7%性能,在CIFAR10上达到了96%,在CIFAR100达到了81%。与此同时,在MS-COCO数据集上达到了48%AP指标。

1、Introduction介绍

这篇文章中,作者研究是否可能存在低深度non-deep,而实现高性能的神经网络呢,特别是10层左右的网络。经过研究发现是可能的,他们取名这种网络叫做ParNet,全程是Parallel Network。

首次以深度为12的神经网络,在图像分类中,准确率:

ImageNet 80%

CIFAR10 96%

CIFAR100 81%

同时,在图像识别只能够,MS-COCO数据集上,也能达到48%AP。

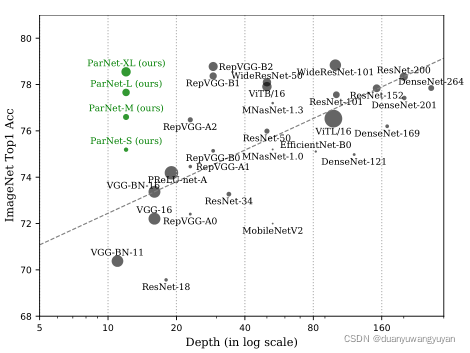

下图是ParNet和最流行模型相比的结果:

1)优点/作用

值得注意的是,我们的平行结构不同于 通过增加层中的神经元数量来“扩大”网络。

科学回答了神经网络层数是否有必要更多;

可以有效地跨多个并行化处理器

2、相关工作(这部分可以不用关注)

分析深度的重要性、缩放DNN、浅层网络和Multi-stream网络

3、Method方法

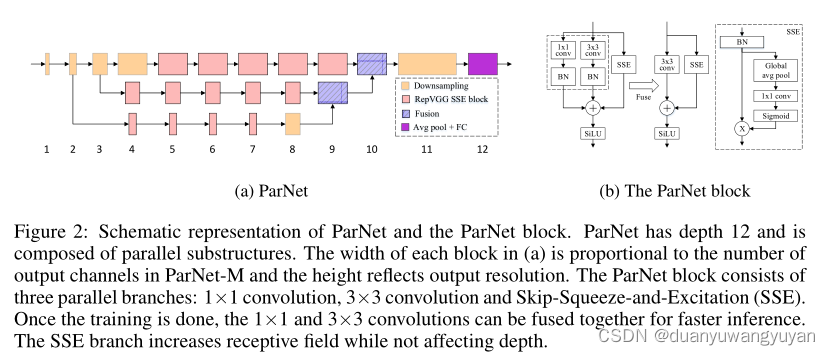

ParNet由处理不同分辨率特征的并行子结构组成。并行的子结构称为流,来自不同流的特征在网络的后期阶段进行融合,这些融合的特征用于后面网络层。

上图(a)是ParNet网络结构;(b)是ParNet Block,也称作为 RepVGG-SSE Block。 ParNet Block由三个并行分支组成:1×1 卷积、3×3 卷积和SSE(Skip-Squeeze-and-Excitation)。训练完成,为更快的推理,1×1 卷积和3×3 卷积融合在一起。SSE分支增加感受野,而不影响深度。

3.1 PARNET BLOCK

使用VGG块比ResNet块更合适,对低深度网络是否能达到更好的效果。推理过程中降低延迟,是重新参数化技术(Ding,2021)或者融合的功劳。

- ParNet Block在以Rep-VGG block为基础前提下,进行修改而成。

- 感受野:构建Skip-Squeeze-Excitation (SSE) 层,避免因3*3卷积非深度网路带来的感受野受限。

- SiLU激活函数:代替了ReLU。因为非深度网络可能没有足够的非线性,从而限制了其表示能力

3.2 Network 介绍

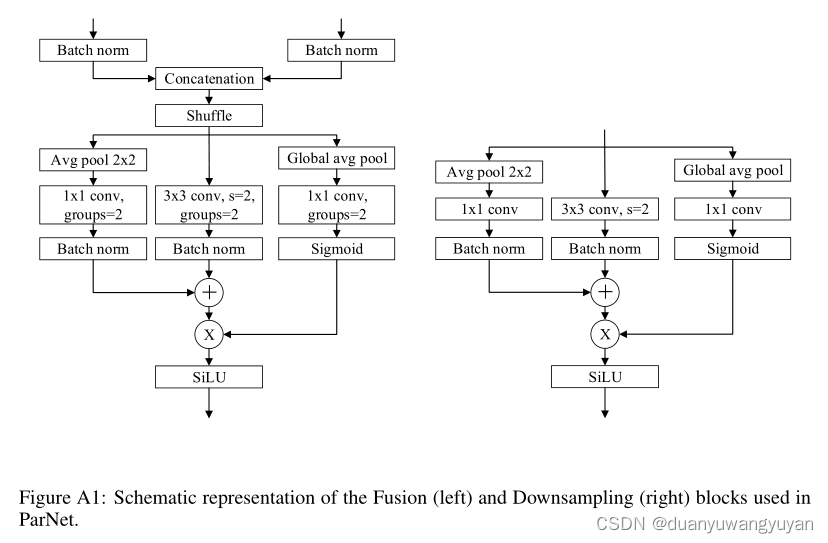

根据上图(a),ParNet Network由Downsampling、RepVGG SSE block、Fusion 和 Avg Pool以及FC组成。

- Downsampling

降低分辨率并增加宽度,使其进行多尺度处理。增加单层SE模块与卷积层并行。同时,在1x1卷积分支中增加了二维均值池化。 - Fusion

与下采样类似,但是额外包含了一层串联层。