线性回归

为什么叫h(x)

为什么用θ表示参数

θ是向量还是矩阵?

为什么用x表示特征

为什么X是一个来表示的向量

为什么在表格添加一列1 ?便于矩阵计算

为什么用表示误差?

K-means

基础概念:

1.要得到簇的个数,需要指定K值

2.质心:均值,即向量各维取平均即可

3.距离的度量:常用欧几里得距离和余弦相似度(先标准化)

4.优化目标: 就是每个簇内每个样本点到簇中心的距离之和最小

就是每个簇内每个样本点到簇中心的距离之和最小

必须掌握的技巧

1.提出常数和取对数

2.只关注含变量的部分

3.用向量表示数组

4.转置符号的处理

5.与对称阵求偏导的相关公式

是对称矩阵

对于式子 对θ求偏导结果是两倍的对称阵乘变量(2

)

6.矩阵求导公式

都是对θ求导:我转你不转,你转我不转

7.如何消去一个矩阵

-> θ 需要左乘

8.如何理解梯度下降 是沿梯度的反方向

因为梯度一般是上升的 为了下山,应该往梯度的反方向走

9.如何理解分别对每个参数分别优化

因为所有的前提是独特征立的,既然特征是独立的,那么特征的系数(参数)也可以认为是独立的

10.只关注需要求偏导的变量的部分

对 求偏导,那么其他

的结构都是常数项,只有

和

有关

必须记住的表示方法

1.用求和形式表示多项式,偏置项合并到关于θ的向量里

2.让损失函数越小越好

3.是独立并且具有相同的分布 服从均值为0,方差为θ^2的高斯分布

为什么是独立的? 误差是由样本产生的,而样本之间是独立的

为什么是同分布的?因为默认样本是同批产生的

为什么服从的是高斯分布?

θ是矩阵还是数值?

高斯分布和正态分布的关系?

为什么用高斯分布来表征?因为偏离均值特别多的值很少出现

4.高斯分布与多元高斯分布的数学表现形式

高斯分布

是均值

是方差

5.多元高斯分布

线性回归误差的高斯分布

得到线性回归误差的高斯分布是

p(y|x;θ)越大越好

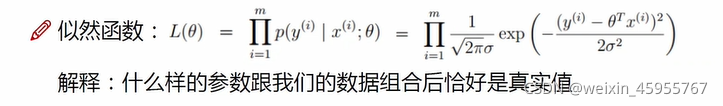

6.似然函数

似然函数有什么用?就是描述什么样的参数和特征值组合后是真实值,所以似然函数都是越大越好

为什么似然函数是连乘的形式?因为默认误差是独立同分布的,所以联合概率分布是可以拆成各自概率分布连乘