Abstract

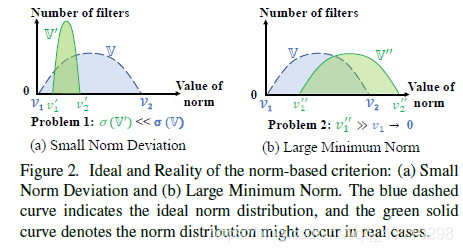

- 解释了以前的工作中用的“基于范数的准则”,它需要在两个条件下才可以有效:

1.范数的方差要大

2.范数的最小值要比较小 (我倒是觉得这个还是比较容易满足的) - 提出了:Filter Pruning via Geometric Median (FPGM),

- 在Cifai10 上取得了好成绩(感觉有点low)

Introduction

-

现在的剪枝可以由两类:

1.weight pruning (导致非结构化稀疏)- learning compression algorithms for neural net pruning.

- Learning both weights and connections for efficient neural network.

2.filter pruning (文章想说的)

- Pruning networks using neuron importance score propagation.

- Pruning filters for efficient ConvNets.

-

现在的一些基于大小准则的剪枝方法(如图1a):

1.Pruning filters for efficient ConvNets.

2.Rethinking the smaller-norm-less-informative assumption in channel pruning of convolution layers

3.Soft filter pruning for accelerating deep convolutional neural networks.

如果这样做有效的话,那么所有层的剪枝后对整体的影响就一样了,此外他这个还需要一个阈值,这个阈值也可以根据层改变,阈值确定的标准也可以依据层变化。

-

本文提出的 FPGM 剪枝算法不选择最大范数准则,选择计算所有filter 的 GM ,来找到最容易被替代的 filter。原理:某个卷积核可以被相似的线性替代。

RelatedWorks

- Weight Pruning

- learning compression algorithms for neural net pruning[11].

一种基于迭代的方法,每次去掉小于阈值的weight - Learning both weights and connections for efficient neural network.

最小化损失函数

- Data Dependent Filter Pruning

- 从下一层的统计结果出发,进行剪枝

- Data Independent Filter Pruning

Methodology

- 一般而言真实的分布与假设的分布是不同的。

其实这里所谓的真实分布也是想象出来的,没有做实验,此外你如何保证每层都服从单峰而不是双峰,或者长尾分布呢?

此外,对于不同模型、模型的不同层、甚至是不同的输入都会导致分布的变化