提出了一种利用骨骼序列进行三维动作识别的新方法。,人体骨骼关节的三维轨迹)。该方法首先将每个骨架序列转换为三个片段,每个片段由若干帧组成,然后利用深度神经网络进行时空特征学习。每个剪辑由骨架序列的柱坐标的一个通道生成。所生成的片段的每一帧代表了整个骨架序列的时间信息。并结合了关节之间的特定空间关系。整个剪辑包含多个具有不同空间关系的帧,为人体骨骼提供了有用的空间结构信息。我们建议使用深卷积神经网络学习的长期时间信息骨架序列帧的生成的片段,然后使用一个多任务学习网络(MTLN)共同并行处理所有帧生成的片段将采取行动的空间结构信息识别。实验结果表明,该方法在三维动作识别中是有效的。

3D骨骼数据记录了人体骨骼关节的轨迹,对光照变化具有鲁棒性,对摄像机视图[14]不变性。随着高精度、廉价设备的普及,基于3D骨骼序列的动作识别越来越受到关注[49,42,6,37,54,26,22,46,19]。在本文中,我们主要研究基于骨架的三维动作识别。为了识别视频动作,需要利用序列的时间信息来理解人体姿态的动态[29,9,44,8,20]。为骨架数据中,人体骨骼的空间结构也是[54]动作识别的重要线索。每个骨骼序列只提供人体骨骼关节的轨迹。关节的时间序列可用于具有长-短期记忆(Long-ShortTermMemory, LSTM)神经元的递归神经网络(RNNs)[11,12],探索骨骼序列的空间结构和时间结构,用于动作识别[6,41,54,37,26],虽然LSTM网络的设计是为了探索长期的时间依赖性问题,但LSTM仍然很难记住具有多个时间步长的整个序列的信息[48,13]。此外,构造深层LSTM来提取高级特征也很困难[35,30]。卷积神经网络(CNNs)[24]在图像分类中取得了巨大的成功[2,3,23, 38, 39, 50, 21]。但是对于视频动作识别,它缺乏对整个视频[45]的长期时间依赖性建模的能力。

在这篇文章中,而不是直接从骨架序列中挖掘长期时间信息,我们首先将骨架序列表示为只有几帧的剪辑。利用生成的片段,可以有效地学习骨骼序列的长期时间结构CNNs来处理生成的剪辑的帧图像。此外,人体骨骼的空间结构信息可以从整个片段中挖掘出来。更具体地说,对于每个骨架序列,我们生成三个剪辑对应于骨架序列柱坐标的三个通道。每个剪辑由四帧组成,通过计算关节与四个参考关节的相对位置来生成。片段的每一帧描述了整个骨骼序列的时间信息,并包含了关节之间的一个特定的空间关系。整个夹具集合了多个具有不同空间关系的框架,提供了重要的骨架关节空间结构信息。

由于骨骼序列的时间信息被包含在生成的视频片段的帧中,因此可以通过从生成的视频片段帧中提取特征来学习骨骼序列的长期时间结构。更具体地说,生成的每一帧剪辑都被输入到一个深度的CNN中,以提取一个CNN特征。然后将三个剪辑在同一时间步长的三个CNN特征(见图1)连接成一个特征向量。因此,从所有时间步长中提取四个特征向量。每个特征向量代表时间信息,关节之间的空间关系。不同时间步长的特征向量表示不同的空间关系,它们之间具有内在的关系。提出利用不同特征向量之间的内在关系进行多任务动作识别学习网络(MTLN)。多任务学习的目的是通过联合训练多个相关任务并利用它们的内在关系[1]来提高泛化性能。在MTLN中,每个特征向量的分类被视为一个独立的任务,而MTLN则被视为一个独立的任务,向量和输出多个预测,每个预测对应一个任务。同一骨架序列的所有特征向量与骨架序列具有相同的标签。在训练过程中,每个任务的损失值都是使用它自己的类分数单独计算的。然后将所有任务的损失值相加,确定网络的总损失,并用于学习网络参数。在测试期间,对所有任务的类分数取平均值,形成对action类的最终预测。多任务学习以sharin为权重,同时解决多个任务,哪些可以提高单个任务的效果。

本文的主要贡献总结如下。(1)我们提出将每个骨架序列转换为一种新的表示,即:,通过使用深度cnn从帧图像中学习层次特征,允许对骨骼序列进行全局长期时序建模。(2)我们引入一个MTLN来处理生成的剪辑中帧的所有CNN特征,从而学习骨架序列的空间结构和时间信息。MTLN利用产生的剪辑的不同帧之间的内在关系来提高性能。我们的实验结果表明,MTLN的性能优于连接或池帧的特征4.3)。(3)提出的方法在三个骨架数据集上取得了最先进的性能,包括大规模的NTU RGB+D数据集[37]。

在这一节中,我们涵盖了使用手的基于骨架的动作识别方法的相关文献,精心设计的特性或使用深度学习网络。手工制作的特征在[17]中,关节位置轨迹的协方差矩阵在分层的时间层次上计算来建模骨架序列。在[43]中,通过计算各关节与其他关节的成对相对位置来表示骨架序列的每一帧和傅立叶时间金字塔(FTP)用于建模时态模式。在[51]中,关节的两两相对位置也被用来表征姿态特征、运动特征、以及骨架序列的偏移特征。然后将主成分分析(PCA)应用于归一化特征,计算特征关节作为表征。在[49]中,计算关节位置的三维直方图来表示骨骼序列的每一帧,并使用HMMs对时间动力学进行建模。在[42]中,身体各部分之间的旋转和平移被用作表示,骨架序列被建模为李群中的曲线。时间动力学模型与FTP。

深度学习方法在[6]中,骨骼关节被分成5个集合对应身体的5个部位。将它们送入5个LSTMs进行特征融合和分类。在[54]中,骨骼关节被送入深度在每个时间段进行LSTM,学习骨骼关节固有的共现特征。在[37]中,通过感知部件的LSTM学习身体部件的长期上下文表示。在[26]中,利用时空LSTM学习骨架序列的时空信息。还提出了一种可信赖的闸门,以消除嘈杂的接缝。该方法在NTU RGB+D数据集上达到了最先进的性能。

该方法所提方法的总体架构如图1所示。该方法首先生成骨架序列的片段。一个任意长度的骨架序列被转换成三个剪辑,每个剪辑由几个灰度图像组成。然后将生成的剪辑输入到深度CNN模型中提取CNN特征,用于MTLN的动作识别。

图1所示。所提议的方法的架构。给定一个骨架序列(a),生成三个卡子(b),对应于柱坐标的三个通道。使用深度CNN模型(c)和时间平均池(TMP)层(d)从每一帧剪辑中提取一个紧凑的表示(详见图3)。将三个剪辑在同一时间步长的输出CNN表示进行拼接,得到四个特征向量(e),每个特征向量代表骨架序列的时间信息以及特定的骨骼关节空间关系。拟议中的MTLN (f)包括一个完全连接(FC)层,解决线性单元(ReLU),另一个FC层和一层Softmax共同并行流程的四个特征向量和输出类分数(g)的四组,每个对应一个任务使用一个特征向量分类。在训练时,将四个任务的损失值相加,定义用于更新网络参数的网络的损失值。对于测试,将四个任务的类分数取平均值,以生成action类的最终预测

与由多帧图像组成的RGB视频相比,骨架序列只提供三维坐标的轨迹。本文提出将原始骨架序列转换为一组包含多幅图像的剪辑,从而实现深度神经网络的时空特征学习。直观地将骨架序列中每一帧的内容表示为图像,生成视频。但是,如果骨架序列有很多帧,这种方法将导致长视频的时间动态将难以学习。另外,每个帧都生成了视频也会非常稀疏,因为骨骼关节的数量很少。为了解决这一问题,我们提出在一帧图像中表示骨骼序列的时间动态,然后使用多帧来包含关节之间的不同空间关系。这种方法的一个优点是,对于任何长度的骨架序列,生成的剪辑包含相同帧数的帧,通过对生成的剪辑中帧图像的强大的CNN表示,可以有效地捕捉到原始骨架序列的长期时间信息。

如图2所示,对于骨架序列,首先将身体各部分的关节串联起来,将每一帧的骨架关节排列成一条链。考虑到关节之间的相对位置比它们的绝对位置(如“推”时手与肩膀的相对位置)提供更有用的信息,参考关节有四个,即左肩、右肩、左髋关节和右髋关节分别用于计算其他关节的相对位置,从而结合关节之间的不同空间关系,提供有用的骨架结构信息。选择这四个关节作为参考关节是因为它们在大多数动作中是稳定的。因此,它们可以反映其他关节的运动。虽然脊柱的底部也很稳定。

图2。剪辑生成一个骨架序列。每一帧的骨架关节首先通过连接身体各部分的关节(即1-2-3 -…-16)。绿色显示的四个参考关节(即分别用左肩5、右肩8、左髋关节11、右髋关节14)计算其他关节的相对位置,考虑关节之间的不同空间关系。因此将骨架序列中所有帧的相对位置组合在一起,得到四个二维数组。每个关节的相对位置二维数组用柱坐标描述。对应于坐标的相同通道的四个二维数组被转换为四个灰度图像并作为一个剪辑。因此,因此,从四个二维数组的柱坐标的三个通道生成三个剪辑。

靠近左臀和右臀。因此它被丢弃以避免信息冗余。对所有帧的相对关节进行梳理,生成四个维数为m−1×t的二维数组(m为每帧的骨骼关节数,t为骨骼序列的帧数)。关节的相对位置二维数组最初是用三维笛卡尔坐标描述的。考虑到柱坐标对分析每个人体的运动更有用利用关键的关节运动来执行一个动作,3D在骨架序列的表示中,将笛卡尔坐标转换为柱面坐标。在[47]中,柱面坐标被用来提取视不变的运动特征用于动作识别。通过线性变换,将坐标值在0 - 255之间缩放,将与三维柱坐标相同通道对应的4个二维数组变换为4个灰度图像。然后用这四张灰色图像构建一个剪辑。因此,y,三个剪辑是由三个通道的三维坐标的四个

二维数组。

帧学习:

所生成的片段的每一帧描述了骨架序列的所有帧和一帧的时间动态特定的空间关系的骨骼关节在一个通道的柱坐标。生成的视频片段的不同帧描述了不同的空间关系,它们之间存在着内在的关系。一个深首先利用CNN从生成的剪辑的每一帧中提取一个紧凑的表示,以利用骨骼序列的长期时间信息。然后利用多任务学习,将生成的剪辑的所有帧的CNN特征联合并行处理,从而利用它们的内在关系来学习三维动作识别的时空信息。

CNN Feature Maps的时间池::

为了学习生成的剪辑的特征,首先使用一个深度的CNN来提取每一帧剪辑的紧凑表示。由于每一帧描述了骨架序列的时间动态,因此空间不变量因此,每一帧的CNN特征可以代表骨架序列的鲁棒时间信息对于生成的剪辑,使用预先训练好的VGG19[38]模型提取每一帧的CNN特征。使用ImageNet[34]预训练的模型提取的CNN特征非常强大,因此可以将预训练的CNN模型用作特征提取器已成功应用于许多跨域应用[5,10,33,15]。此外,目前的骨架数据集要么太小,要么太吵,无法适当地训练深度网络。虽然生成的剪辑帧不是自然图像,但仍可将其输入ImageNet[34]预训练的CNN模型进行特征提取。自然图像和生成的帧之间的相似之处在于它们都是具有一定模式的矩阵。在大型图像数据集上训练的CNN模型可以用作特征提取器,以提取矩阵中的模式表示。学习的表示法具有普遍性,可以从原来的任务转移到新的任务中。

图3。CNN feature maps的时间平均池化。(a)生成的剪辑的输入框,其中行对应骨架序列的不同框,列对应关节生成的不同向量。(b)输出conv5_1层的feature map。尺寸为14×14x512. feature map的每次激活(红色显示)都是一个对应于原始图像局部区域的feature(红色方块显示)。(c)骨骼序列各关节的时间特征,在行(时间)维上对各特征图应用均值pooling得到。(d)输出feature,通过将(c)中的所有feature map连接起来实现。

预训练的VGG19[38]模型包含5组卷积层conv1, conv2,…,conv5。每个集合包括一个由2或4个卷积层组成的堆栈,具有相同的内核大小。该网络共有16个卷积层和3个完全连接层。虽然深度神经网络能够学习功能强大、通用性强的特征并将其应用于其他新领域,但从不同层次提取的特征具有不同的可移植性。特别是,较早的层中的特性更通用,而在较晚的层中,特性更特定于任务,主要依赖于原始的类和数据集。因此,与早期层相比,后期层的特征不太适合转移到其他领域(52,27)。因此,本文采用卷积层激活而得到的紧凑表示来挖掘骨架序列的时间信息。卷积层中的feature map已经成功应用于动作识别和图像检索[31,32]。具体来说,丢弃网络的最后3个卷积层和全连接层。三个剪辑的每帧图像缩放为224×224,然后被复制三次以形成一个彩色图像,以便它可以被馈给网络。使用卷积层的输出conv5_1作为输入帧的表示,输入帧是一个大小为14×14×512的三维张量,即。, 512幅大小为14×14的feature maps。

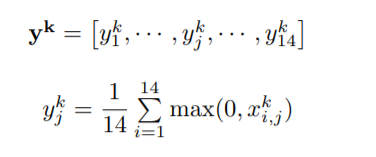

所生成的帧的行对应于一个骨架序列的不同帧。因此,生成的图像的行特征的动力学代表了骨骼序列的时间演化。同时,conv5_1层中每个feature map的激活都是与原始输入图像[31]中局部区域对应的局部特征。序列的时间信息可以从特征图的行特征中提取出来,具体来说,对feature map进行时间平均pooling处理,kernel size为14×1,即。时,池应用于时间维度或行维度,从而从骨架序列的所有时间阶段生成一个紧凑的融合表示。设第k个feature map的第i行和第j列的激活为xki,j。经过时间平均pooling后,第k张feature map的输出为:

将所有特征图(512)的输出串联起来,形成一个7168D(14×512 = 7168)特征向量,表示柱坐标的一个通道内骨架序列的时间动态。

多任务学习网络(MTLN):

如图1(e)所示,将三个剪辑在同一时间步长的三个7168D特征拼接成一个特征向量,总共得到四个特征向量。每个特征向量代表了骨骼序列的时间动态,并在三个柱面坐标中包含了关节之间的特定空间关系,四个特征向量之间存在内在的关系。然后提出了一个MTLN来联合处理这四个特征向量,利用它们的内在关系来进行动作识别。每个特征向量的分类被视为一个独立的任务,具有与骨架序列相同的分类标签。

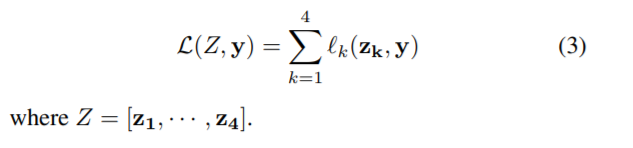

网络架构如图1(f)所示。它包括两个完全连接(FC)层和一个Softmax层。在两个FC层之间有一个整流线性单元(ReLU)[28]来引入额外的非线性。给定这四个特征作为输入,MTLN生成四个帧级预测,每个帧级预测对应一个任务。在训练期间,每个任务的班级分数被用来计算一个损失值。然后是所有任务的损失值,最后汇总产生的网络损耗用于学习网络参数。在测试期间,对所有任务的类分数取平均值,形成对action类的最终预测。第k个任务的损失值(k = 1,···,4)如式2所示。

zk的位置向量美联储将Softmax层产生的k阶输入功能,m是action类的数量和彝语是我的真实的标签类。网络的最终损失值计算的总和四个人损失,如方程3所示:

实验与分析:

该方法在NTU RGB+D数据集[37]、SBU kinect交互数据集[53]和CMU数据集[4]三个骨骼动作数据集上进行了测试。提出的方法主要思想是Clips + CNN+ MTLN 1)生成三个片段(每个片段包含四个帧)从骨架序列,2)使用CNN全球长期学习时间信息框架序列的每一帧生成的片段,和3)使用MTLN共同训练的CNN特性的四个帧剪辑将行动的空间结构信息的认可。

我们还进行了以下基线,以展示所提出方法的优点:在此基线中,将Fourier Temporal Pyramid (FTP)[43]应用于骨骼序列的3D坐标,提取时间特征用于动作识别。这个基线用于显示使用cnn对骨骼序列进行长期时间建模的好处。在这个基线中,动作识别使用的是单帧的CNN特征,而不是生成的整个剪辑。换句话说,只使用图1(e)所示的一个特征向量训练神经网络进行分类。因此,网络的损失值如式2所示。给出了四个特征的平均精度。这个基线用于显示使用整个产生的剪辑合并空间结构信息的动作识别。这个基线中的剪辑+ CNN +连接在执行动作识别之前,将生成的剪辑的所有帧的CNN特征连接起来。换句话说,将图1(e)所示的四个特征向量拼接后,送入神经网络进行分类。此基线用于显示使用的好处MTLN来并行处理整个剪辑的特征。

在这个基线中,在执行动作识别之前,对生成的剪辑的所有帧的CNN特征应用max Pooling。一样的视频+ CNN +连接,这个基线也用来显示使用MTLN的好处。

Datasets:

NTU RGB+D数据集[37]就我们所知,这个数据集是迄今为止最大的骨架为基础的人类动作数据集,有超过56000序列和400万帧。共有40个不同的实验对象进行60类动作,包括单人日常动作(如鼓掌、阅读、写作)和两人互动(如握手、拥抱、指点)。这些动作由三个摄像机捕捉,它们被放置在不同的位置和视点上。这个数据集总共有80个视图。在这个数据集中,每个骨骼有25个关节。的提供了关节的三维坐标。由于视图大,类内和序列长度变化,数据集非常具有挑战性。

SBU Kinect交互数据集[53]该数据集是使用Microsoft Kinect传感器采集的。它包含282个骨架序列,6822帧。在此数据集中,每个框架包含两个执行交互的人员。互动包括接近,离开,踢,拳,推,拥抱,握手和交换。每个骨骼有15个关节。这个数据集是具有挑战性的,因为关节坐标显示低精度[53]。

CMU数据集[4]该数据集包含2235个序列,约100万帧。对于每个骨架,提供了31个关节的三维坐标。数据集被分为45个类[54]。所有的操作都是由一个人执行的。由于大的序列长度变化和类内多样性,数据集具有很大的挑战性。

实现细节

对于所有的数据集,在不经过归一化、时间下采样或噪声滤波等预处理的情况下,用原始骨架序列的所有帧生成剪辑。所提出的方法是使用的MatConvNet工具箱[40]。FC第一层隐藏单元的数量设置为512。对于第二个FC层(即。,则单元的数量与每个数据集中action类的数量相同。网络的训练使用随机梯度下降算法。学习率设置为0.001,批大小设置为100。训练在35个时代之后停止。并将该方法与现有方法在相同测试协议下的性能进行了比较。

结果

NTU RGB+D Dataset在[37]中,对该数据集的评估是通过两个标准协议执行的,即。、交叉学科评价、交叉视角评价。在交叉主体评价中,使用20个被试的序列进行训练,使用其他20个被试的数据进行测试。在交叉视点评估中,两个摄像机捕获的序列用于训练,其余的用于测试。

结果如表1所示。可以看出,无论在跨主题协议还是跨视图协议上,该方法的性能都明显优于其他方法。该方法的准确性是79.57%时,与交叉学科的协议测试。与之前的先进方法(ST-LSTM +信任门[26])相比,性能提高了10.37%。在使用cross-view协议测试时,准确率从77.7%提高到84.83%。

该方法的改进主要是由于采用了新的视频片段表示和特征学习方法。如表1所示,Frames + CNN对两种测试协议的准确率分别约为75.73%和79.62%。性能比coordinate + FTP要好得多。与使用FTP和本地三维坐标提取骨骼序列的时间特征相比,使用CNN从生成的帧中学习骨骼序列的时间信息对卷积和池化操作引起的噪声和时间变化具有更强的鲁棒性,从表1还可以看出,Frames + CNN也比之前的art方法有更好的表现。它清楚地显示了所提出的视频片段表示的CNN特征的有效性。通过使用CNN和MTLN(即,剪辑+ CNN + MTLN)。两种测试协议分别改进了约4%和5%。还可以看出,拟议的MTLN(即MTLN),剪辑+ CNN

+ MTLN)的性能优于特性连接,剪辑+ CNN +连接)和池(即。剪辑+CNN +池)。框架+ CNN,剪辑+ CNN +连接和剪辑+ CNN +池可以被视为一个单一任务的方法,在使用MTLN并行处理多个帧生成的片段利用其内在关系和包含了空间结构信息,使单一的性能。

动作识别的任务方法。

SBU Kinect交互数据集在[53]中,这个数据集的评估是一个5倍交叉验证,与提供的训练/测试分割。骨骼序列的每一帧包含两个单独的人类骨架。在这种情况下,我们将两种骨骼视为两个数据样本,分别对两种骨骼进行clip的生成和feature extraction。测试时,对两个样本的分类分数进行平均,得到动作的预测。

考虑到该数据集中的样本数量太少,我们进行了数据扩充来增加样本数量。具体来说,将生成的剪辑中的每一帧图像调整为250×250,然后从原始图像中裁剪出大小为224×224的随机patch,利用CNN进行特征学习。对于该数据集,裁剪了20个子图像,将数据样本总数扩展到11320。

与其他方法的比较如表2所示。类似于NTU RGB+D数据集,CNN特性在学习时间信息方面优于FTP。可以看出,在使用时

CNN以单帧为特征,准确率为90.88%,类似于深度LSTM +共现[54]方法。当使用连接和池化方法合并整个剪辑的CNN特征时,性能提高了约2%。当学习整个剪辑时,性能提高到93.57%,MTLN。它清楚地显示了使用MTLN学习CNN功能的整个剪辑的好处。由于该数据集的关节位置[53]不是很精确,现有的方法包括HBRNN[6]和Cooccurrence LSTM[54],通过使用Svaitzky-Golay滤波器平滑每个关节的位置来去除关节噪声[36]。在[26]中,引入了信任门来消除噪声。

关节,这将准确率从88.6%提高到93.3%。我们的方法没有对有噪声的关节进行任何预处理,但性能仍然优于其他方法。

结果表明,由于深网的卷积和共用算子的存在,从生成的片段中学习到的特征对噪声具有较强的鲁棒性。

与[54]一样,对于该数据集,我们既对包含2235个序列的整个数据集进行评估,也对包含664个序列的子集进行评估。这个子集包括8类操作,即。比如,篮球,侧手翻,起床,跳跃,拾取,跑步,坐着然后走回去。对于整个数据集,测试协议是4倍交叉验证,对于子集,它是评估3倍交叉验证。不同褶皱的训练/镶嵌分割由[54]提供。

与SBU kinect交互数据集类似,CMU数据集也进行了数据扩充。对于整个数据集,利用每一帧图像多生成5幅图像,将数据样本总数扩展到11175,对于子集,将样本总数扩展到13280,是原始样本数的20倍。结果如表3所示。可以看出,该方法在子集和整个子集上的性能都比现有的方法好得多。

该方法的结果约为93.22%,比[54]方法好5%左右。整个数据集的性能从81.04%提高到88.3%。

讨论

三个灰色剪辑还是一个彩色剪辑?如图所示1、生成的三个剪辑帧均为灰度图像,每一帧仅对应圆柱坐标的一个通道。每一帧被复制三次以形成一个彩色图像用于CNN feature学习。输出三个频道的CNN特征被连接在一个特征向量中,用于动作识别。一个简单的替代方法是生成一个颜色剪辑与三个通道的圆柱坐标,然后从颜色框架中提取单个CNN特征进行动作识别。当这个被测试CMU数据集,性能为84.67%,也就是大约比提出的方法差4%。这可能是由于生成的三个通道的关系不同于自然彩色图像的RGB通道。RGB通道是按顺序排列的,3D坐标和没有匹配顺序RGB通道。

帧数越多,性能越好?本文仅使用四个参考关节来生成剪辑,每个参考关节有四帧。当多选取6个关节时,生成更多的框架,即,头部、左手、右手、左脚、右脚和臀部,表现没有提高。在CMU数据上进行测试时,该算法的性能为86.01%,比提出的算法差约2%。这是由于其他关节不像所选的四个关节那样稳定,可能会引入噪声。

笛卡尔坐标还是柱坐标?如3.1节所述,将参考关节与其他关节之间的向量的三维笛卡尔坐标转换为柱面坐标,生成剪辑。我们发现,当使用原始的笛卡尔坐标进行剪辑生成和动作识别时,性能下降。在CMU数据集上的测试结果表明,该方法的精度达到了86.21%,比传统方法低了2%左右。圆柱坐标比笛卡尔坐标更适用于分析运动,因为每个人体骨骼利用关键的关节运动来执行一个动作。

在不同层次的特征,如章节所述3.2.1、预训练的conv5_1层feature map每个输入图像的表示采用CNN模型。我们发现使用早期层中的特性会降低性能。利用conv4_1层的特征,在CMU数据集上的精度为84.59%,比本文方法差约4%。这可能是由于早期层中的特征不够深,无法捕获突出的信息输入图像的调整。我们还发现,使用后面的层中的特性会使性能变差。当使用fc6层的特征时,CMU数据集上的准确率为83.52%,比本文方法差约5%。这是因为后面的层中的特性更加特定于任务,它们很大程度上依赖于原始的类和数据集。因此,与早期层相比,后期层的特征不太适合转移到其他区域[52,27]。

结论

在本文中,我们提出了将一个骨架序列转换成三个视频片段来进行鲁棒的特征学习和动作识别。我们建议使用预先训练好的

CNN模型后跟一个时间池层来提取每一帧的紧凑表示。将三个视频在同一时间步长的CNN特征串联在一个特征向量中,描述了整个骨骼序列的时间信息和关节之间的一种特定的空间关系。然后我们建议MTLN共同学习所有时间步的特征向量,利用它们的内在关系,提高动作识别的性能。我们在NTU RGB+D数据集、SBU kinect交互数据集和CMU数据集上测试了该方法。实验结果表明了该方法的有效性。