From Word Embeddings To Document Distances

M. J. Kusner, Y. Sun, N. I. Kolkin, K. Q. Weinberger, From Word Embeddings To Document Distances, ICML (2015)

摘要

词嵌入(word embedding):根据单词在语句中的局部共存性,学习单词语义层面的表示(semantically meaningful representations for words)。

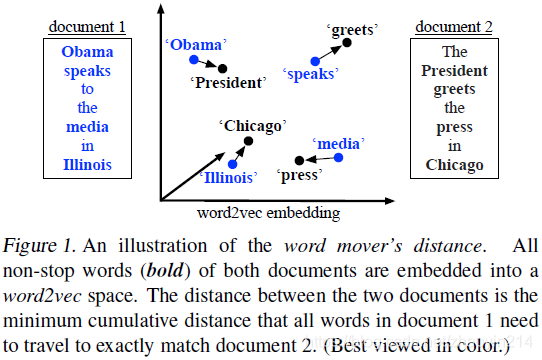

单词移动距离(Word Mover’s Distance,WMD):基于词嵌入,衡量文本文档(text documents)间距离的函数。WMD以一个文档的嵌入词移动至另一个文档的嵌入词的最小距离(the minimum amount of distance that the embedded words of one document need to “travel” to reach the embedded words of another document)作为两个文本文档间不相似度(dissimilarity)的度量。

WMD测度不包含超参数(hyperparameters)。

1 引言

文档表示的最常用的两种方法:

- 词袋模型(bag of words,BOW);

- 词频逆文档频率(term frequency - inverse document frequency,TF-IDF)。

由于各文档的BOW(TF-IDF)表示通常近似正交性(frequent near-orthogonality),二者并不适于度量文档距离;另外,二者无法表示不同单词间的距离(not capture the distance between individual words)。

文档的低维隐含变量表示(a latent low-dimensional representation of documents):

- 隐含语义索引(Latent Semantic Indexing,LSI):对BOW特征空间(feature space)进行特征分解(eigendecompose);

- 主体模型(Latent Dirichlet Allocation,LDA):将相似词按概率分配到不同的主题(probabilistically groups similar words into topics),并将文档表示这些主题的分布(represents documents as distribution over these topics)

通常,语义关系体现在词向量的运算上(semantic relationships are often preserved in vector operations on word vectors),即嵌入词向量间的距离能够表示语义(distances between embedded word vectors are to some degree semantically meaningful)。本文将文本文档表示为嵌入词的加权点云(a weighted point cloud of embedded words),文本文档 和 间的单词移动距离(Word Mover’s Distance,WMD)定义为:为匹配(match)文档 的点云(point cloud),文档 中的单词(words from document )所需移动(travel)的最小累积距离(minimum cumulative distance),Fig. 1。

WMD最优问题是最短测地距离(Earth Mover’s Distance,EWD)运输问题(transportation problem)的特例。本文给出几个下界距离(lower bounds)用于近似WMD或对查询范围剪枝(approximations or to prune away documents that are provably not amongst the

-nearest neighbors of a query)。

WMD特性:(1)无超参(hyper-parameter free);(2)可解释性强(highly interpretable),文档距离可解释为少量不同单词间的稀疏距离(the distance between two documents can be broken down and explained as the sparse distances between few individual words);(3)高检索准确率(high retrieval accuracy)。

2 相关工作

Okapi BM25

LDA

LSI

TextTiling-EMD

Stacked Denoising Autoencoders (SDA)、mSDA

Componential Counting Grid

3 Word2Vec词嵌入(Word2Vec Embedding)

word2vec:词嵌入过程(word-embedding procedure),使用(浅层)神经网络语言模型(a (shallow) neural network language model)学习单词的向量表示(vector representation)。

skip-gram模型:由输入层、投影层(a projection layer)和输出层组成,用于预测相邻单词(nearby words)。通过最大化语料库(corpus)中相邻单词(neighboring words)的对数概率(log probability),训练各单词词向量(word vector),即给定单词序列(a sequence of words) :

其中, 表示单词 的相邻单词集合、 表示相应词向量(associated word vectors) 和 之间的层级归一化指数(hierarchical softmax)。由于结构简单和层级归一化指数,skip-gram能够使用台式机在数十亿单词上训练(due to its surprisingly simple architecture and the use of the hierarchical softmax, the skip-gram model can be trained on a single machine on billions of words per hour using a conventional desktop computer),因此能学到复杂的单词关系。

4 WMD距离(Word Mover’s Distance)

表示 个单词的word2vec嵌入矩阵(a word2vec embedding matrix),其第 列 表示第 个单词在 维空间中的词嵌入。假设文本文档表示为归一化词袋模型(normalized bag-of-words,nBOW)向量 ,即如果单词 出现 次,则 。通常,nBOW向量 非常稀疏(very sparse)。

BOW( BOW representation)

向量 为 维单纯形(simplex),包含不同唯一词的两文档(different unique words)位于单纯形不同的区域中,但这两个文档的语义确可能相近(semantically close)。

词映射损失(word travel cost)

本文将单词对(individual word pairs)间的语义相似度(document distance metric)包含进文档距离度量(document distance metric)。单词不相似度通常采用在word2vec嵌入空间(the word2vec embedding space)中的欧氏距离(Euclidean distance)度量。单词 和 之间的距离为: ,表示一个单词移动到另一个单词的代价(the cost associated with “traveling” from one word to another)。

文档距离(document distance)

(1)令 、 表示两个文档在 维单纯形(simplex)上的 BOW表示。

(2)假定 中的每个单词 都可以全部或部分映射到 中的任意单词(each word in to be transformed into any word in in total or in parts)。

(3)令 表示(稀疏)流矩阵(a (sparse) flow matrix),其中 表示 中单词 到 中单词 的流量(how much of word in travels to word in )。

(4)为将 完全转移至 , 中单词 的流出量为 ,即 ;同时 中单词 的流入量为 ,即 (to transform d entirely into we ensure that the entire outgoing flow from word equals , i.e. . Further, the amount of incoming flow to word must match , i.e. )。

则两个文档间的距离定义为:将 中所有单词迁移至 中的最小加权累积代价(the distance between the two documents as the minimum (weighted) cumulative cost required to move all words from to ),即:

运输问题(transportation problem)

给定约束,将 移至 的最小加权累积代价为如下线性规化(linear program)的解:

■ ■

WMD距离(word mover’s distance)即为方程(1)的解。由于 是一个测度(metric),可以证明WMD也是一个测度。

可视化(visualization)

4.1 快速距离计算(Fast Distance Computation)

WMD优化问题的最佳平均计算时间复杂度(best average time complexity)为 ,其中 表示文档中唯一词(unique words)的数量(the number of unique words in the documents)。■即 为 BOW向量长度■

WMD运输问题的下界距离:

词质心距离(word centroid distance)

根据三角不等式(triangle inequality),文档 和 之间的质心距离(centroid distance) 为其WMD距离的下界(lower bound),

■■

■

由于每个文档都用其加权平均词向量表示(each document is represented by its weighted average word vector),本文称之为词质心距离(Word Centroid Distance, WCD)。WCD距离的计算时间复杂度为 (it is very fast to compute via a few matrix operations and scales )。

对于最近邻(nearest-neighbor)问题,WCD能够缩小候选点范围(promising candidates),以加速WMD搜索。

WCD易于计算,但不够紧致(not very tight)。

松弛词移动距离(relaxed word moving distance)

通过放松WMD优化问题(relaxing the WMD optimization problem)并移除一个约束条件(removing one of the two constraints respectively),可以更紧致的下界(much tighter bounds)。

若移除第二个约束条件,优化问题为:

由于WMD最优问题的解需要满足两个约束条件,移除一个后,解的可行域变大,因此松弛问题的解必为WMD距离的下界(this relaxed problem must yield a lower-bound to the WMD distance, which is evident from the fact that every WMD solution (satisfying both constraints) must remain a feasible solution if one constraint is removed)。

最优流矩阵 为:

令 为松弛问题的任意可行解(feasible solution), 单词 ,其最近词为 ,则

因此, 必能生成最小损失(a minimum objective value)。计算该解仅需确定 (identification),可在欧氏word2vec空间中做最近邻搜索(a nearest neighbor search in Euclidean word2vec space)。对文档 中的每个词向量 ,需要找到文档 中的最相似的词向量 。

若移除第一个约束,最近邻搜索过程相反,即对文档 中的每个词向量 ,需要找到文档 中的最相似的词向量 。

令两个松弛解分别为 、 ,通过取二者中的最大值(taking the maximum of the two),可得到更紧致的下界,称为松弛WMD(Relaxed WMD,RWMD):

预读取与减枝(prefetch and prune)

查找查寻文档(a query document)的 近邻:

(1)根据与查寻文档的WCD距离对所有文档进行排序,并计算前 个文档的WMD距离;

(2)遍历(traverse)其余文档,首先检查各文档的RWMD下界是否大于当前 近邻文档的WMD距离,如果条件为真则剪枝(check if the RWMD lower bound exceeds the distance of the current -th closest document, if so we can prune it);否则计算其WMD距离,并更新 近邻文档。

由于RWMD近似(RWMD approximation)的极其紧致,在一些数据集上, 的文档能被剪枝。

5 实验

5.1 数据集

SMART停用词(stop word)列表

比较7种文档表示基线(baseline):词袋(bag-of-words,BOW)、TFIDF(term frequency-inverse document frequency)、BM25 Okapi、LSI(Latent Semantic Indexing)、LDA(Latent Dirichlet Allocation)、mSDA(Marginalized Stacked Denoising Autoencoder)、CCG(Componential Counting Grid)

欧氏距离 近邻,超参使用贝叶斯优化(Bayesian optimization)

5.2 文档分类(Document classification)

5.3 词嵌入(Word embeddings)

5.4 词嵌入(Word embeddings)

RWMD距离与WMD距离极其接近,WCD距离与WMD距离相差较远。