本文是对《Continuous-Time Dynamic Network Embeddings》一文的浅显翻译与理解,原文章已上传至个人资源,如有侵权即刻删除。

文章目录

前言

相比以前的不关注时间的算法,该算法可以在时序网络上学习网络表示。将先前的算法定义为A,该算法定义为B,那么有如下区别:

对A,定义网络为G=(V,Et),V为顶点集,Et为边集,定义边为e=(u,v),u为起点,v为终点;而B,定义网络为G=(V,Et,T),T为计算时间的函数,定义边为e=(u,v,t),t为每条边对应的时间。

B算法更多地考虑到了网络中时间的重要性,将每条边所占的时间仅限制在最小值w和最大值L之间,增加了其变化的可能性。

在选取初始点和边时,可以定义一个时间t,通过在分布中采样,选择一条初始边,其起点就是初始点。分布包括有偏置和无偏置两种,对无偏置而言,采样中的每条边被选中的概率都是一样的。有偏置的情况下,可以通过指数或线性函数,来使得与t时间最接近的边概率更大。

在选定初始边之后,进行时序随机游走的方法,仍然分为有偏置和无偏置两种分布选择以后每一次的节点,其方法同上。

总而言之,该算法更加注重时间在动态网络中的重要地位,并通过与一些经典算法的性能比较,证明了其有效性和优越性。

Title

《连续时间动态网络嵌入》(201804)

——Third International Workshop on Learning Representations for Big Networks

Authors:Ryan A. Rossi;Nesreen K. Ahmed

Abstract

网络在对节点和边界的增添、删除和改变中不断发展。尽管很多网络包含着时序类型的信息,然而对网络表示学习的研究,还多数集中于图像的静态快照上,并且很大程度上忽略了网络的时序动态。本文介绍了一个将时序信息结合到网络嵌入方法中的综合框架。该框架给出了从连续时间动态网络中学习时间依赖嵌入的方法。总的来说,本实验在所有方法和图像中均达到了11.9%的平均增益,进而证明了所述框架和动态网络嵌入算法的性能。这一结果表明图的建模时序依赖性,对学习合适且有意义的网络表示比较重要。

CCS Concepts

Computing methodologies→Machine learning; Artificial intelligence; Logical and relational learning;

计算方法——机器学习;人工智能;逻辑和关系学习

Mathematics of computing→Graph theory; Graph algorithms;

计算数学——图理论;图算法

Theory of computation→Streaming, sublinear and near linear time algorithms;

计算理论——流体、亚线性和近线性时间算法

Information systems→Data mining;

信息系统——数据挖掘

Keywords

动态网络嵌入;时序节点嵌入;动态网络;网络表示学习;时序随机游动;连续时间动态网络;图流;特征学习;时序网络;

1 Introduction

近年来,网络(图/关系)数据所占比率大幅增长,其在领域中的呈现形式包括:因特网和万维网、科学引用与协作、流行病学、通信分析、新陈代谢、生态系统、生物信息学、诈骗与暴力分析等。在这些网络数据中,连接通常代表引用、友谊、关联、变化函数、通信、协同定位、共享设备等诸多明确或潜在的关系。

这些现实世界的大部分网络都是动态地添加、删除和修改那些,随着时间推移自然演化的节点与连接。网络中的时序信息因对于精确模型、预测以及理解网络数据的重要性被人所熟知。尽管动态是重要的,但在早先的大多数工作中却忽视了网络数据中的时序信息。

在此,我们提出了从连续时间动态网络中学习合适网络表示的问题,从而提高预测模型的准确性。我们描述了将动态依赖性结合到网络嵌入方法中的综合框架,该框架作为基础可以将时序依赖,结合到现行节点嵌入和基于随机游走的深度图模型中。成果非常适用于时间依赖网络表示,它抓住了连续时间动态网络的重要时序性能。因此,该框架允许现行嵌入算法能轻易地适应,从连续时间动态网络中学习更适合的网络表示,通过确保时间在学习及通过避免虚假或不可能事件来减少噪声的过程中是被重视的。

所述算法从连续时间动态网络中学习了更合适的网络表示,抓住了最佳的自然粒度(如秒或毫秒规模)下网络的重要时序依赖性。这与将动态网络表示成为静态快照图序列形成对比,该序列中每张静态快照图表示着所有边界,这些图出现在用户指定离散时间间隔之间(如日或周)。这可以看作是现实连续时间动态网络的一个非常粗糙与嘈杂的近似值。除信息的损失外,还有很多其他的问题如选出合适的粒度集合,这些问题因自身有某些重要且具有挑战的困难而广为人知,从而会导致预测性能微弱或错误性结果。此外,我们的方法天然支持在边界达到连续时间变化(如每秒或毫秒)的图流中学习,因而产生能被用于各类应用需求的实时性能。

我们证明了所述框架的有效性,并将动态网络嵌入算法推广到各类应用领域的几种现实网络中的时间链接预测中。总的来说,提出的方法在所有的方法和图里均达到了11.9%的平均增益。结果显示,图的建模时间依赖性对学习合适且有意义的网络表示比较重要。此外,任何运用了随机游走的现行嵌入方法或深度图模型都能从本框架中受益,因其充当了结合重要时序依赖到现行方法中的基础。通过框架推广的算法能够学习更多有意义且准确的,抓住了连续时间动态网络重要性的时间依赖网络嵌入。

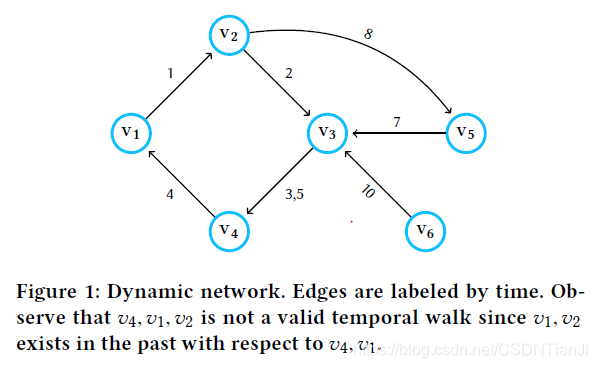

早先的网络嵌入方法与深度图模型使用随机游走搜索在G上的随机游动空间S,而所述方法则通过搜索,整个遵循时间进行时序随机游走的ST,学习时序嵌入。通俗地说,一个随机游动的St从节点Vi1到节点Vil+1被定义为一个边的序列{(Vi1,Vi2,Ti1),(Vi2,Vi3,Ti2),…,(Vil,Vil+1,Til)},其中Ti1<=Ti2<=…<=Til。一次时序游走代表了一个按时间增序遍历边的有效时序序列,因此重视时间。例如,假设每条边都代表了一条两实体间的联系(如邮件、电话、距离),那么一次时序游走就代表了一条消息通过动态网络的可行路线。显而易见,忽略时间的现行方法从随机游走集中学习嵌入,其中绝大多数随机游走捕获的时间序列在考虑时间的情况下是无效的。换言之,许多曾使用这些方法为节点派生嵌入的随机游走,在重视时间的情况下实际上并不可靠。例如,假设我们有两封邮件,ei=(v1,v2)指从v1发送到v2,ej=(v2,v3)指从v2发送到v3,并设T(v1,v2)为邮件ei的发送时间。当T(v1,v2)<T(v2,v3)时,邮件ej(v2,v3)可能会反映来自邮件ei(v1,v2)通讯的信息。反之,当T(v1,v2)>T(v2,v3)时,邮件ej(v2,v3)就不包括任何来自邮件ei(v1,v2)通讯的信息。这只是个简单的例子,用来说明对现实事件序列(邮件通讯)建模的重要性。嵌入方法忽略时间容易引发大量问题,如学习不适当节点嵌入,就不能准确捕获现实世界交互或节点间信息流之类的网络动态。下图是另一个因不重视时间导致信息丢失的例子。

该方法有以下预期的特性:

通用且统一的框架 我们提出一个概括性的框架,将时序依赖结合到利用随机游走的节点嵌入和深度图模型中。

连续时间动态网络 学习连续时间动态网络的时间依赖网络表示。该算法避免了由于从图的连续时间表示中创建离散快照图序列,而导致的信息的问题与损失。

有效性 所述算法被证明是学习动态网络表示的有效方法。我们在各类应用领域的所有方法和图像中,均达到了11.9%的平均增益目标。

2 Framework

本章叙述了从连续时间动态网络学习时间依赖嵌入的总体框架。

2.1 Temporal Model

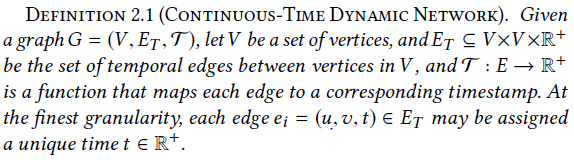

在此,我们没有将动态网络建模为一系列被定义为G1到Gt的有向快照,其中Gi=(V,Et),Et是在(ti-1,ti)时间间隔中活跃的边。而是仿照连续时间动态网络的正式定义,对时序交互进行了如下建模:

大意可以理解为:图G=(V,Et,T),V是顶点集,Et是定点间的动态边集,T是函数,可以将每条边映射到对应的时间戳。在最佳时间间隔下,每条边ei都能被映射到一个唯一的时间。

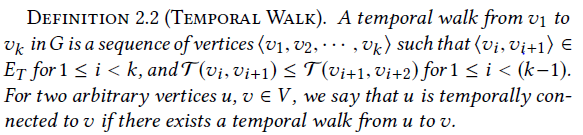

在连续时间动态网络(即时序网络)中,事件被出现在时间域中某个间隔里的边所表示。在这些网络中,一次有效的游走用一系列由非递减时间戳的边所连接的节点表示。换言之,如果每条边捕获到了两实体间的联系,那么一次有效的时间游走就代表着,一条信息的可行路径。更为正式的定义如下:

大意可以理解为:一次从v1到v2的时间游走,是顶点集<v1…vk>中<vi,vi+1>(其中1<=i<k,且1<=i<=(k-1)时,T(vi,vi+1)<=T(vi+1,vi+2),即时间间隔的先后)的顶点序列。对任意两个顶点u和v,只要存在从u到v的一次时序游走,就认为u与v存在时序连接。

关于时序游走的定义仿照了静态图中游走的标准定义,但附加了约束:游走需要遵照时间,即必须遵照边递增的顺序遍历边。就其本身而言,时间游走天生就是不对称的。

我们现在将连续时间动态网络的学习时间嵌入问题定义为:给出一个动态网络G=(V,Et,T),以学习函数f为目标,该函数将G中的节点用多维时间依赖特征表示,从而适合下游的机器学习任务(如时序链接预测)。所述连续时间动态网络嵌入框架有两个主要的可替换部分,允许用户对时间依赖网络表示的学习存在时间偏差,接下来将分别介绍两个组件。

2.2 Initial Temporal Edge Selection

给出一个连续时间动态网络G=(V,Et,T),如何挑选节点开始一次时序随机游走?通过对大多数现存方法的观察,它们都只将图中每条边的随机游走时间简单定义为一个不变的数字。但是,回想上文从v1到vk的随机游走,注意到除节点v之外,一次时间随机游走还需要开始时间t。在连续时间动态网络(定义2.1)中,每条边ei=(v,u)都与一个时间t相关联。因此,我们可以从均匀分布或加权分布的F中对初试时间t取样,找到距离t最近的边ei,或从对任意分布(均匀或加权)F的取样中,选取一条初始边ei=(v,w)和与之相关的时间t=T(ei)。选择时序随机游走的起始点是我们的优势,这是一种对时序随机游走进行时间偏置的方法。因此,当时间依赖嵌入被用于下游时间序列回归或分类任务时,能够提高预测性能。这是本文所述的使用时序随机游走的动态网络嵌入框架,与现行在静态图中使用随机游走的算法之间,最为重要且根本的差别。

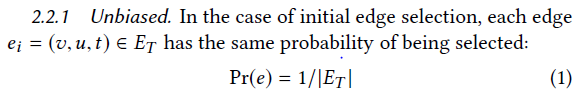

一般来说,每次时序游走开始于,在取样于分布F的时间t上的一条时序边ei。用于选取首条动态边的分布,可以是没有时间偏差的均匀分布,或是存在时间偏差的任意加权分布。例如,学习用于时序链接预测任务的节点嵌入时,我们可能更想从与当前时间点联系紧密的边开始更多的时序游走,因为在遥远过去发生的事件或关系可能对当前系统状态的预测或指示性较差。以无偏差方式选择初始动态边的策略2.2.1,和以时间偏置方式选择的策略2.2.2,将在下文先后进行讨论。

这与从均匀分布中对初始动态边取样相一致。

2.2.2 Biased. 我们提出了两种对决定时序随机游走起始点的初始边,进行时序偏置选择的技术。特别地,我们用基于指数和线性函数的时序加权分布对初始时序边取样。此外,连续时间动态网络嵌入框架比较灵活,且能便捷支持用于选取初始时序边的其他时间加权分布。

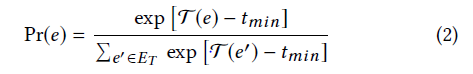

Exponetial: 我们可以用指数分布来偏置初始边选取,在这种情况下,每条边e都对应一个概率:

tmin是动态图中一条边所分配的最小时间,这定义了一个分布,很大程度上倾向于晚出现的边。

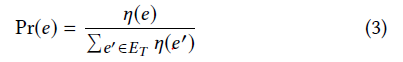

Linear: 当两条时间连续的边出现大的时间偏差时,将边映射到离散的时间点上可能有所帮助。设η:E->Z+是以时间升序方式将数据集中的边进行分类的函数,换言之,η将每条边映射为一个对初始边e有η(e)=1的索引。在这种情况下,每条边e属于η(Et)都对应一个概率:

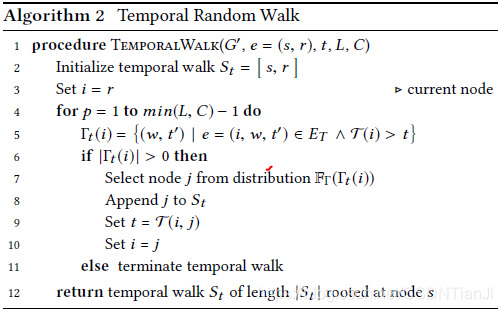

2.3 Temporal Random Walk

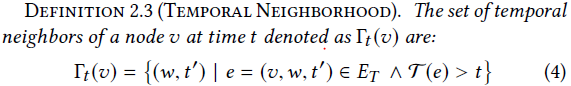

选择了t时间的初始边ei=(u,v,t)进行时序随机游走后,如何从边开始执行一次时序随机游走呢?我们定义了一个节点v在t时间的邻居集合如下:

值得注意的是,有可能同一个邻居w会多次出现在Γt(v)中,因为同一对节点中会出现多条时序边。例如,在一段时间进程里,两个人可能会有多次邮件信息交流。时序随机游走的下个节点可以在Γt(v)中选择,我们使用二次分布对邻居的选择进行时间偏置。同样,该分布既可以是无偏置的均匀分布,也可以更直观地倾向于考虑时间。例如,对于连续的边,我们可能希望将采样策略偏向于显示更短的差值(in-between)时间的游走。即是说,在随机游走中每对相连的边(u,v,t)和(v,w,t+k),我们都希望k的值更小。对于一个动态社交网络上的时间链接预测而言,限制差值时允许我们采用不同时间段朋友不聚集在一起的游走。例如,如果k较小,我们倾向于取样随机游走序列(v1,v2,t)(v2,v3,t+k),意义在于v1和v3很可能彼此认识,因为v2近期与两者都进行了交互。另一方面,如果k较大,我们就不倾向于对序列取样。这有助于将v2在非常不同的时间段(如高中和研究生院)进行交互的人区分开,他们不太可能彼此了解。

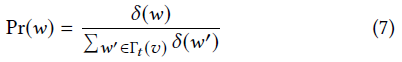

2.3.1 Unbiased. 对于无偏置时间的邻居选择,给出一条任意边e=(u,v,t),v在时间t的每个邻居w都遵照如下概率被选择:

2.3.2 Biased. 我们描述了两种通过指数和现行函数的时间加权分布,对一次时序游走中的下个节点进行采样,从而偏置时序随机游走的技术。此外,连续时间动态网络嵌入框架比较灵活,且能便捷用于其他应用或域依赖的时间偏置函数。

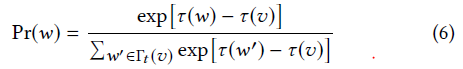

Exponential: 当使用指数式衰减时,我们将概率用公式表示如下。给出任意一条边e=(u,v,t),每次时间邻居w被选取的概率都遵照如下表示:

要注意的是,我们在这里略微地滥用了符号τ,并用它来表示对相应时间的映射。这与在计算机病毒和蠕虫的传播中,观察到的连续接触的指数式衰减概率很相像。

Linear: 在此,我们定义函数δ:V × R+ ->Z+按照时间降序对时间邻居进行排序,v在t时间的每个邻居w的概率被定义如下:

该分布偏向于选择时间上与当前节点更紧密的边。

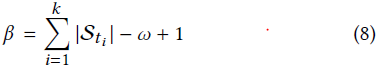

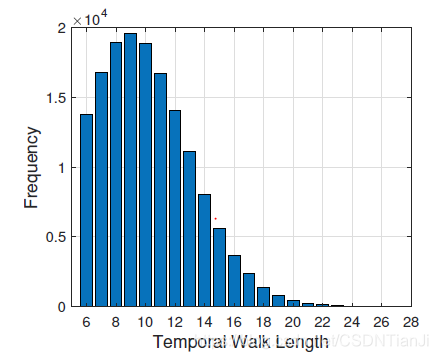

2.3.3 Temporal context windows. 由于时序游走是保存时间的,就有可能出现一次游走遍历耗尽时序有效边的情况。因此,我们在取样时序游走时,并不严格规定长度。与之相反,我们仅仅需要每次时序游走有一个最小长度w(在此,w相当于连续跳跃的上下界窗口大小)。可以提供最大长度L,来适应较长的游走。因此,当生成一个时序游走集合时,任何长度在w到L之间的时间游走Sti都认为是有效的。给出一个时间随机游走集合{St1…Stk},我们定义了一个能够从时序随机游走中得到上下界差值计数的β,来计算w大小的上下界差值总数。其正规定义如下:

当对时序游走集进行采样时,我们通常设β为N=|V|的倍数。

2.4 Learning Time-preserving Embeddings

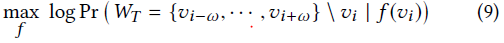

给出一个时序游走St,我们如今可以将,学习保存有时间的节点嵌入到一个CTDN(Continous-Time Dynamic Network)中的任务,公式化为最优化问题:

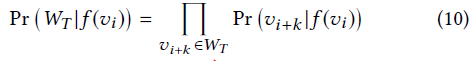

其中f:V -> R^D是节点嵌入函数,w是上下界差值的最佳长度,WT = {vi−ω…vi+ω }就如T(vi−ω,vi−ω+1)<…<T(vi+ω−1,vi+ω)一般,是一个任意时序游走上下界差值。当对源节点vi进行观测时,我们为节点间的时间上下界差值设定补充依赖如下:

给出一个图G,设S为G上包含所有可能随机游走的空间,设ST为G上包含所有时序随机游走的空间。显然,时序随机游走空间ST包含于S,且ST仅表示S中一小部分可能的随机游走。现行算法从S中采样一个随机游走的集合s,而本工作集中于从属于S的ST中取样一个时间随机游走集合。通常,现行算法随机从S中取样一次时序随机游走的的概率非常之小,且绝大部分靠这些方法采样的随机游走,都代表了节点间的一系列事件,这些事件在重视时间的情况下是无效(不可能)的。例如,假设每条边表示两人间的一次交互/事件(如邮件、电话和空间上的接近等),那么一次时序随机游走可能表示,动态网络上一条可行的信息路径,或者是一条传染病传播的时序有效路径。

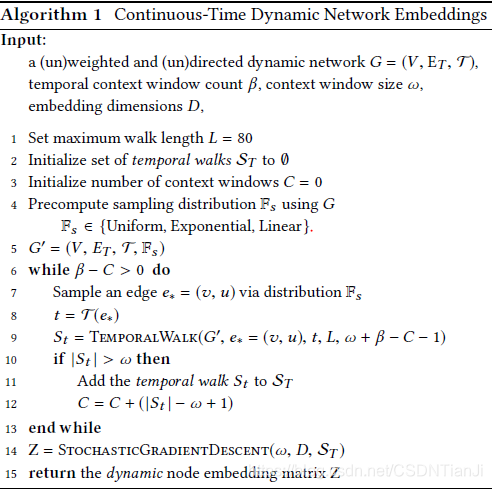

我们概括了Algorithm 1中学习CTDNs时间保存嵌入的步骤,该步骤将连续跳跃框架推广到连续时间动态网络中去。此外,该框架能便捷地用于其他利用随机游走的深度图模型,因为时序游走可以作为神经网络的输入向量。

2.5 Hyperparameters

相比其他方法像node2vec有许多超级参数需要调试,该框架仅有一个超级参数需要调试。

2.5.1 Arbitrary length walk. 本工作中,我们允许时序游走具有任意长度,仅是简单地限定在区间[w,L]中。我们认为w到L之间任意长度的游走能够更准确地表示节点行为。例如,一次开始于u的游走能够在经历长为L的边后再次返回u,呈现了一个封闭的循环。另一方面,又一次从v开始的游走,只要达到最小长度w就可以快速结束,无论是否返回v。这是两种相差甚远的情况,如果施加一个固定的随机行走长度,就会产生误解。注意到w和L之间的敏感性,并不会影响实验所用的大幅图像整体的性能。然而,对于更大的图而言,他们的值对数据的依赖更多,并可能会被用户所修改。

2.5.2 Exponential base. 假设指数函数用于偏置随机游走(等式6),或是为开始时序游走偏置对初始边的选择(等式2),从而允许用户为指数分布选择指数函数的基数b。在这种情况下,初始化时间边的选择(等式6),一个大的基数b可能会导致函数增长过快。值得注意的是,如果对动态网络时间交互(如边)的观测经历了大的时间跨度,选择一条近期边的概率就远大于其他边。从而导致在取样游走时,就更倾向于近期的边。

2.6 Model variants

所述的连续时间动态网络嵌入(CTDNE)框架包括两个主要的可互换部分,从而产生了各种有用的模型。本节,我们将讨论少量将于第三章研究的变体。上文我们使用一种分布Fs来选择一条时序随机游走的初始边e(2.2节),此外还用另一种分布Ft来偏置对一次时序随机游走中每条后续边的选择(2.3节)。因此,不同的分布Fs和Ft都能用于偏置随机游走的取样策略。特别地,我们研究了三种从Fs中对初始时间边e的不同方法,以及在Ft中一次时序随机游走的每条后续边。在2.2及2.3节的讨论中,通过进行偏置与未偏置分布的所有可能组合,产生了九种不同的模型变体。

3 Experiments

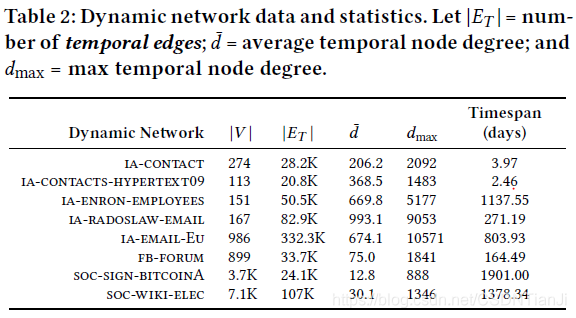

实验的目的在于,用各类应用领域中拥有不同结构和时间特征的大量图,研究所述的CTDNE框架的效果。表2提供了用于评估的动态网络及其统计数据的摘要。

所有网络都是连续时间动态的,在这些动态网络中,边的时间规模为秒或毫秒级,也就是说,边的时间戳在秒或毫秒水平下记录了边的产生时间(以细粒度输出)。本方法用最佳时间规模进行输出,所有数据都从NetworkRepository中得到。

特别地,我们在时序链接预测任务中,评估了所述框架的性能。为生成链接预测的标签化样本集合,我们首先对每张图中的边以时间升序进行排序,并将前75%用于表示学习。剩余的25%被认为是正链,我们随机抽取等量的负边作为样本,进而对这些正边和负边的标签化数据X进行链接预测。

3.1 Experimental setup

我们根据以下基于线性的方法,对在第二章提出的学习动态表示的框架进行评估:node2vec,DeepWalk及LINE。对node2vec,我们用相同的参数(D=128,R=10,L=80,W=10),并在p,q属于node2vec所提出的{0.25,0.50,1,2,4}的范围内进行网格搜索。对于DeepWalk同样用相同的参数,但令p=q=1从而与node2vec区别开来。至于本文方法,令w=10,L=80,D=128。对LINE,令二阶距离D=128,样本数T=6千万。

在从每个节点学习过嵌入后,我们遵循node2vec的方法学,并用如下操作之一:ops{权重L1,权重L2,平均数,哈达玛积(即两同阶矩阵对应位相乘)},结合已学习相应节点的嵌入向量,对一条边计算特征向量。

追溯每个数据集,我们为链接预测生成了一个标签化的数据集X。我们使用逻辑回归,对该数据集的25%提供验证。对10颗随机种子进行了重复实验,并记录了平均性能。除非另有说明,否则我们使用AUC来评估模型。

3.2 Comparsion

出于公平比较,我们令D为所有比较方法的相同值。此外,我们确保所有基于线性的方法中,用于学习的信息数量相同。特别地,时间上下界窗口的数量B如下表示:

R表示每个节点游走的数量,L表示线性方法中一次随机游走需要的长度。

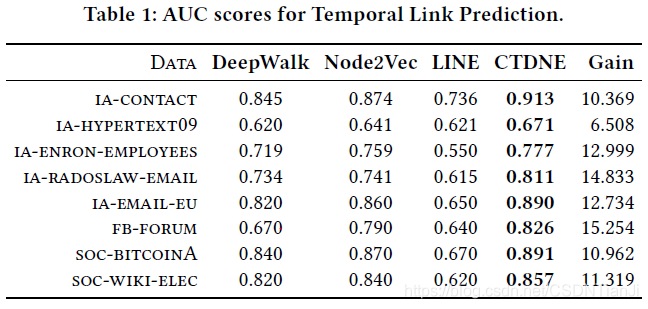

表1给出了所有比较方法在时序链接预测任务上的性能。对该实验,我们使用所述框架的简单变体,并对选择策略没有任何附加偏置。换言之,Fs和Ft建立在均匀分布上。我们注意到,不管怎样,由于我们的时序游走是服从时间的(定义2.2),取样已经倾向于出现更晚的边,就像随机游走遍历不会及时返回一样。在此我们看到,所述算法要比DeepWalk,node2vec以及LINE一贯执行得更好。这表明当忽略时间信息时,有重要信息丢失了。引人注目的是,我们的模型并未利用node2vec中所介绍的偏置,但其仍然要比这一模式的表现更好。我们可以用第二章中所述的框架,以类似的方式推广

node2vec。显然,我们可以期望通过,使用连续时间node2vec概述得到的嵌入,达到更好的预测性能。

表1的最后一行给出了每个动态网络的平均AUC在所有嵌入方法上的平均增益。在所有情况下,所述算法都能显著胜过所有动态网络中的其他嵌入算法。尤其是,在所有嵌入算法和图中,我们在AUC上达到了11.9%的总增益。这些结果表明,对图中时间依赖的建模与结合,对于学习合适且有意义的网络表示而言相当重要。

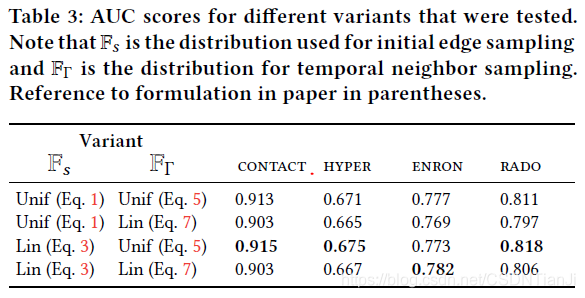

同样值得注意的是,通过所述框架,其他很多利用随机游走的算法也能够被扩展,同未来的任何先进嵌入算法一样。我们还发现,对大多数数据集,对比均匀分布,使用有偏置的分布(无论线性还是指数)确实改进了在AUC方面的预测性能。但对其他算法而言,却没有显著的性能增益。这很可能归因于绝大多数动态网络研究都只有较短时间间隔(最多三年以上)的事实,表3给出了小部分其他框架变体的结果。特别地,表3显示了对初始化边缘选择策略Fs,和时序随机游走中邻居选择策略Ft,使用偏置分布的差异。有趣的是,对Fs使用偏置分布似乎大大改进了测试数据集。无论如何,对ia-enron-employees而言,当两种分布都有偏置时,可以观测到最佳结果。

4 Related work

近年来,节点嵌入问题得到了研究社群的广泛关注。在该问题中,一次低维编码是从图里的每个节点学来的。其目标是学习编码(如嵌入),捕捉每个节点的关键性能,如它们在图中的位置,或是他们本地的社区结构。由于节点分享它们相似的性能,从而在嵌入空间中彼此紧密地聚集在一起,能够用来便捷地从诸如排序、社区挖掘、链接预测和节点分类等任务中学习嵌入。

许多最初被提出时,用来解决节点嵌入问题的技术,是基于图的因式分解。最近,连续跳跃模型被引入了自然语言处理领域,来学习单词的连续向量表示。受到连续跳跃在语言模型的成功启发,各种各样的方法都开始提出通过将图训练为“文件”,从而用连续跳跃学习节点嵌入。最为著名的两种方法,DeepWalk和node2vec,使用随机游走来取样图中节点的有向序列,连续跳跃模型于是能在这些序列中被用于学习节点嵌入。

研究者也解决了在非常复杂的图中进行节点嵌入的问题,包括推荐网络和异构网络等。然而,该领域的大部分工作仍然未能考虑随时间演变的图(即时序图)。值得注意的是,该工作中所述的框架能够被用来推广这些方法,从而学习更适合的时间依赖嵌入,因为它们都基于随机游走。

少部分工作开始探索时序网络中的节点嵌入问题。然而,本工作在几个关键问题上不同于先前的工作,尤其是具有更一般的性质。早先工作通常都基于使用时序网络的离散快照,我们提出的框架能够将时序依赖结合到,基于时序网络连续表示的时序随机游走的节点嵌入中。此外,本工作还介绍了一个通用框架,能够作为推广其他基于深度学习的随机游走和嵌入方法的基础,来学习更适合时序网络的时间依赖嵌入。比较起来,其他大多数工作都只是简单地介绍了关于时序网络的新算法,因此比起本工作对问题的关注有显著不同,本工作给出的是一个通用框架,能够被其他非时序算法利用获得提升,进而能够对时间依赖的网络建模。

对图的随机游走已有数十年的研究,那些基于随机游走及其与图中特征值和其它基本性能联系的理论,较为容易理解,本工作也与图上的均匀和非均匀随机游走相关。随机游走是很多重要应用的核心,诸如排序、社区挖掘、推荐、链接预测、影响建模、检索引擎、局部图像分析、无线传感器网络路径以及时间序列预测等。这些应用与技术可能也得益于时序随机游走的概念。

最近,在开发用于时序网络建模的网络分析和机器学习算法方面,出现了大量研究。时序网络被近期研究所关注,包括时序网络中的节点分类、时序链接预测、动态社群挖掘,以及动态混合成员角色模型、动态网络的异常监测、影响建模和在线广告、在动态网络中寻找重要实体、时序网络中心和度量等,时间网络分析综述见引文1-29。

5 Conclusion

我们描述了一个用于将时序信息结合到网络嵌入算法中的通用框架,该框架为现行基于随机游走嵌入算法的推广提供了基础,这些算法从连续时间动态网络中学习动态(时间依赖)网络嵌入。本成果非常适用于时间依赖的网络表示,抓住了连续时间动态网络时序性能的重要性。我们证明了该框架的有效性,并将动态网络嵌入算法推广到了对一些现实网络的时序链接预测中。总的来说,所述方法在所有方法和图中均达到了11.9%的平均增益。我们的成果指出对图中时间依赖的建模与结合,对于学习合适且有意义的网络表示来说是比较重要的。未来的工作将研究使用连续时间动态网络框架,来推广异构网络嵌入方法、属性网络嵌入方法以及其他方法。