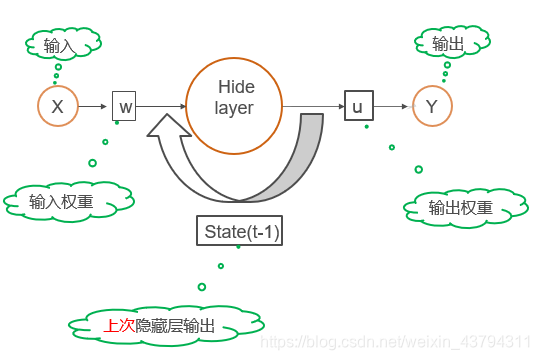

RNN图解

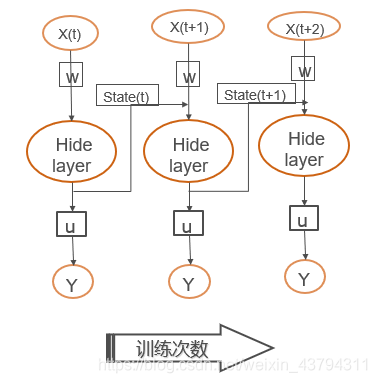

这是网络结构,但和时间有关,为了更好显示可以按时间展开

按训练次数展开

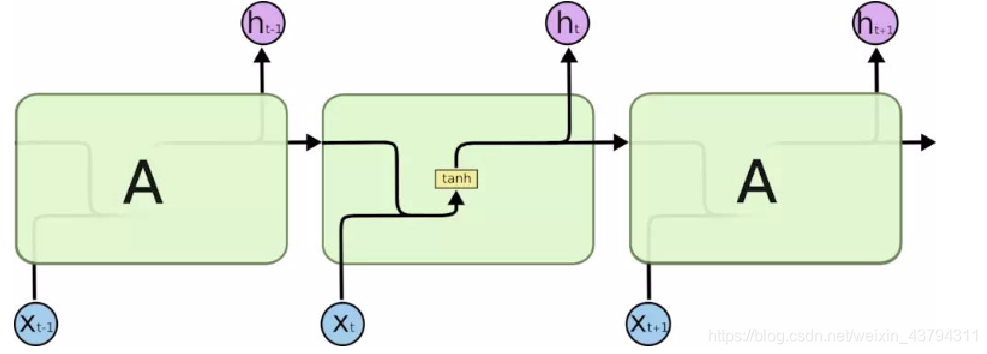

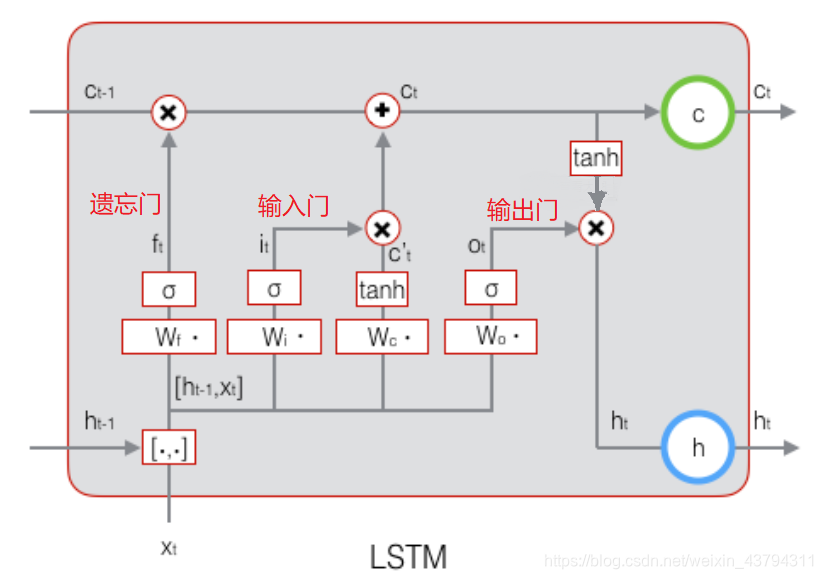

LSTM

参考:参考1、参考2、参考3

为什么使用tanh?

为了克服梯度消失问题,我们需要一个二阶导数在趋近零点之前能维持很长距离的函数。tanh是具有这种属性的合适的函数。

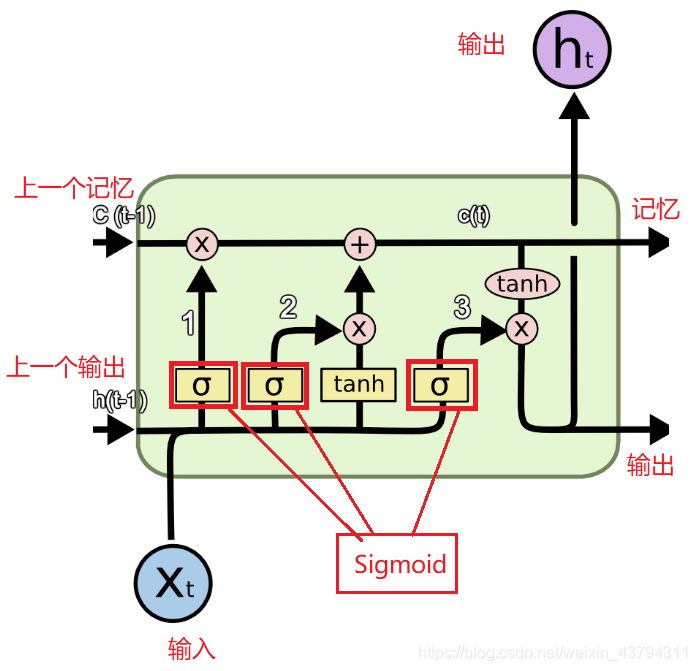

为什么要使用Sigmoid?

由于Sigmoid函数可以输出0或1,它可以用来决定忘记或记住信息。

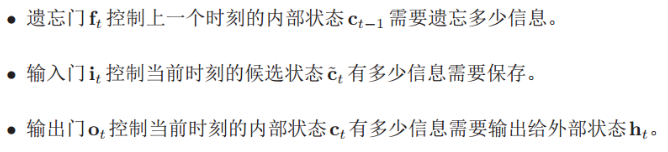

三个门的作用:

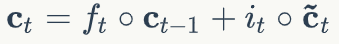

当ft=0,it=1时,包含历史信息的内部状态ct-1被丢弃,历史信息被清空,此时的内部状态ct只记录了t-1时刻的信息,也就是候选状

当ft=1,it=0时,内部状态ct只复制了前一个内部状态ct-1中的历史信息,而不写入由xt带来的新信息。

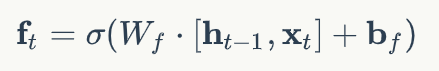

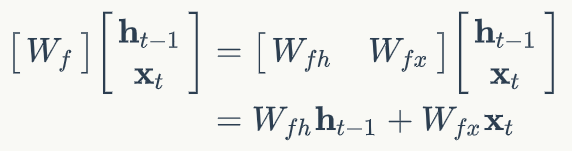

遗忘门公式:

其中Wf*[h,x]可写做以下形式,

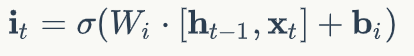

输入门:

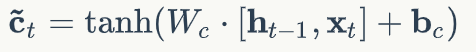

记忆单元状态:

输出门:

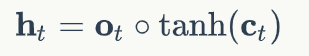

最终输出:

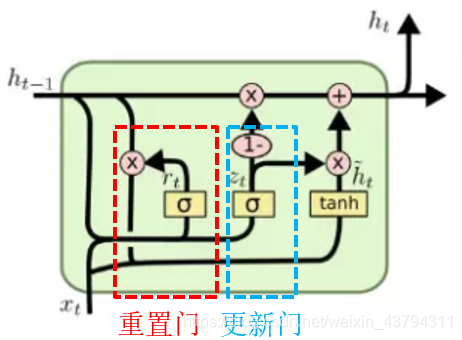

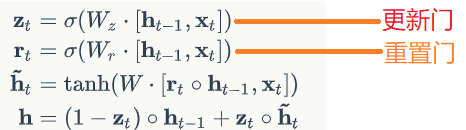

GRU

公式:

将输入门、遗忘门、输出门变为两个门:遗忘门和输入门合并为一个更新门(Update Gate)和重置门(Reset Gate)。

将单元状态与输出合并为一个状态:。