深度学习三大模型

CNN卷积神经网络

RNN循环神经网络

DBN深度信念网络

灵感

CNN卷积神经网络:人脑视觉皮层对外界感知

RNN循环神经网络:人脑记忆机制

RNN循环神经网络优势

RNN每个输出与前面的输出建立关联

能够很好地处理序列化数据(音乐、文章等)

能以前面的是序列化对象为基础,来生成新的序列化对象

RNN循环神经网络局限性

步数增多会导致梯度消失或者梯度爆炸(反向传播过程中)

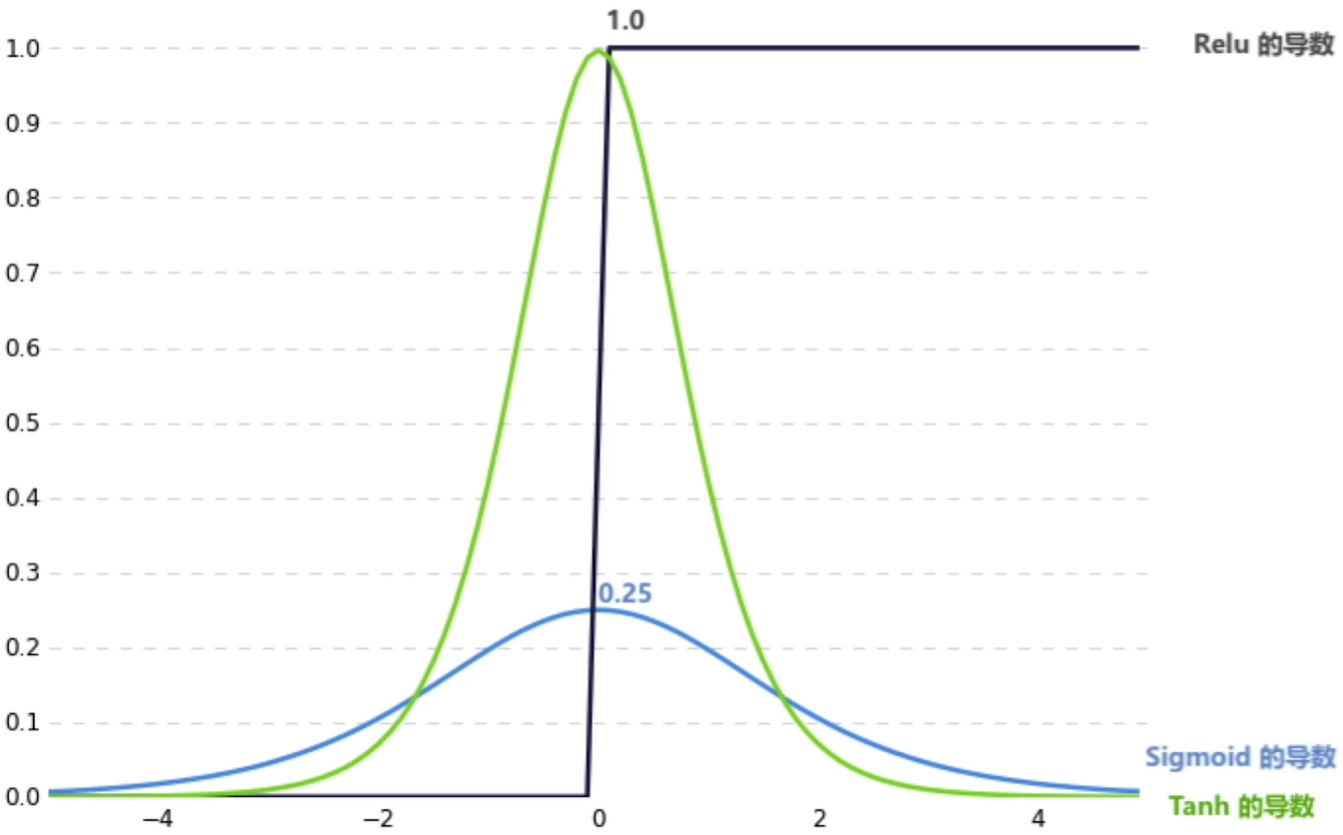

梯度消失于所用激活函数有很大关系

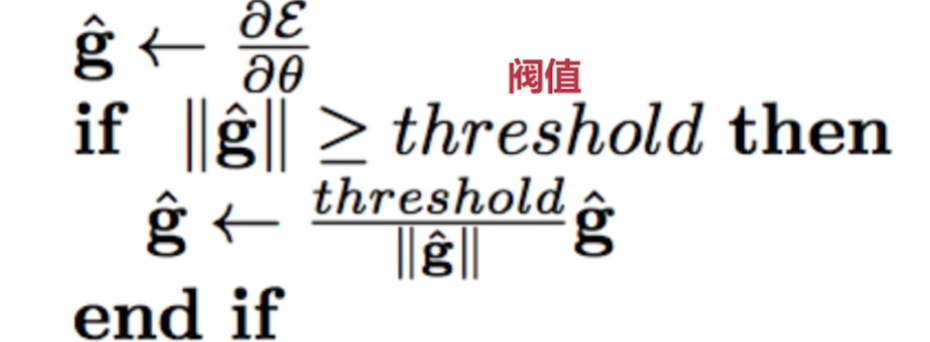

梯度爆炸解决:Gradient Clipping(梯度裁剪)

梯度消失解决:

梯度消失类似记忆消散

可以用一种特殊的RNN:LSTM(长短期记忆Long short-Term Memory)

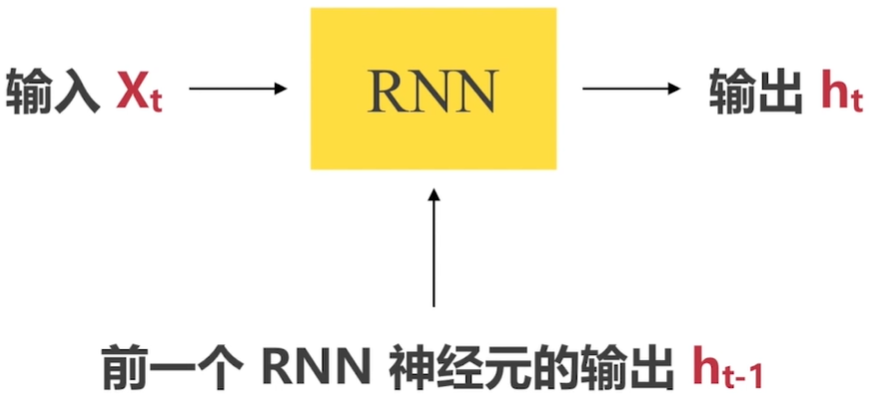

传统RNN神经元:

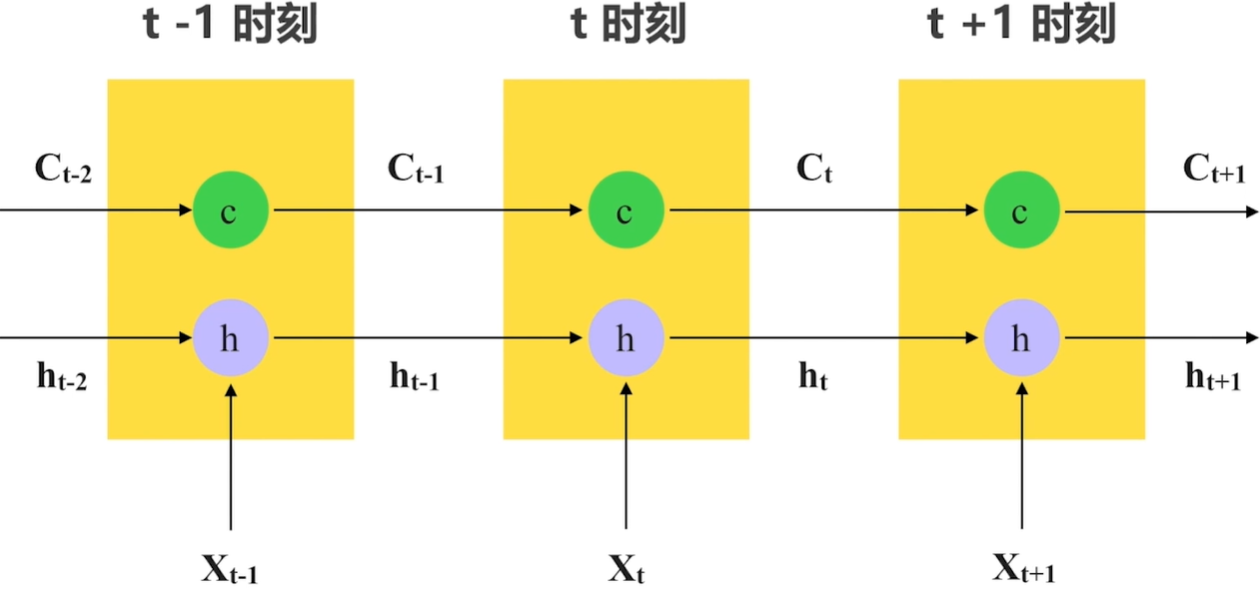

LSTM的时间维度展开(三个输入、两个输出):

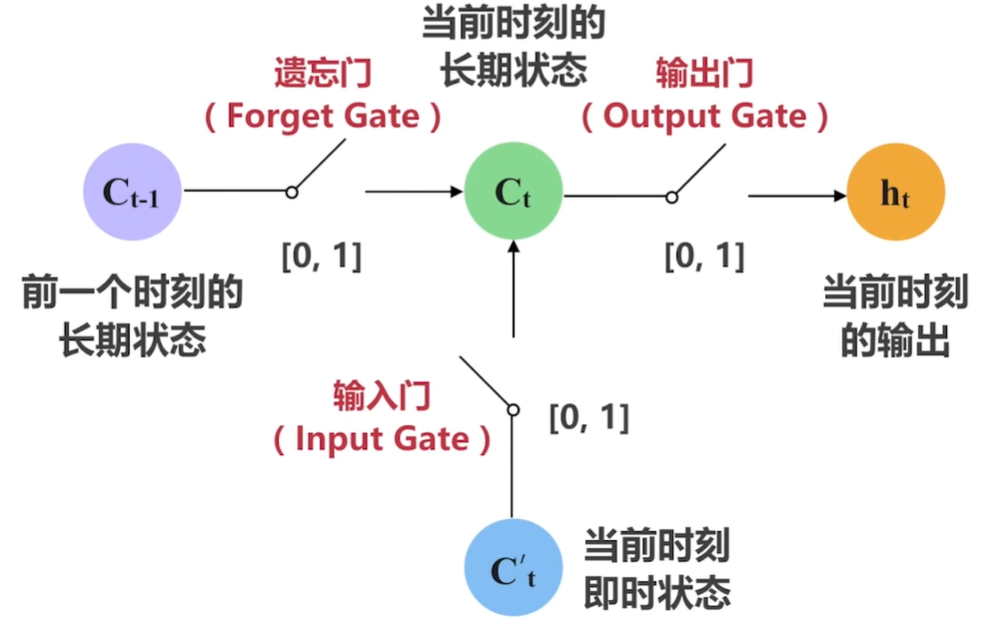

LSTM神经元的三重门机制(重要性:遗忘门、输入们、输出门):

案例中不再使用one-hot编码,因为one-hot编码数据量很大时效率低

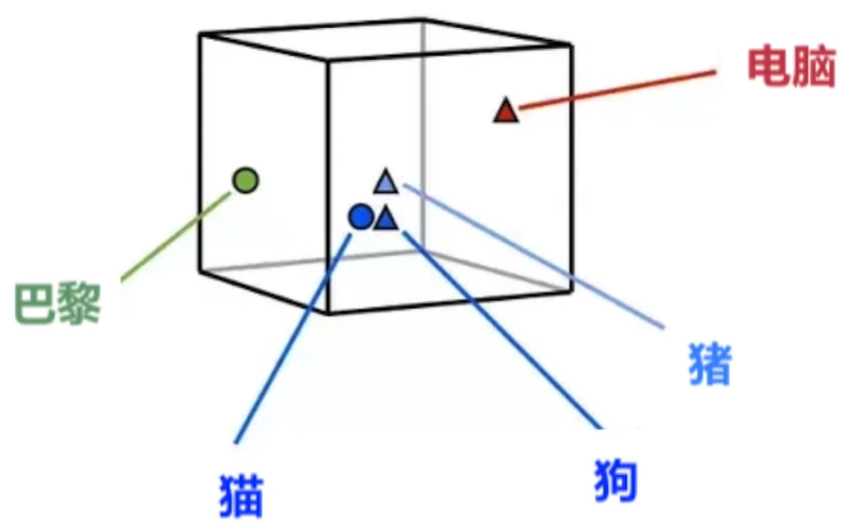

词向量编码(Word Embedding)在数据量大时表现比较好(这两种编码可以相互转化):

词向量编码类似于聚类,距离近则相关性强:

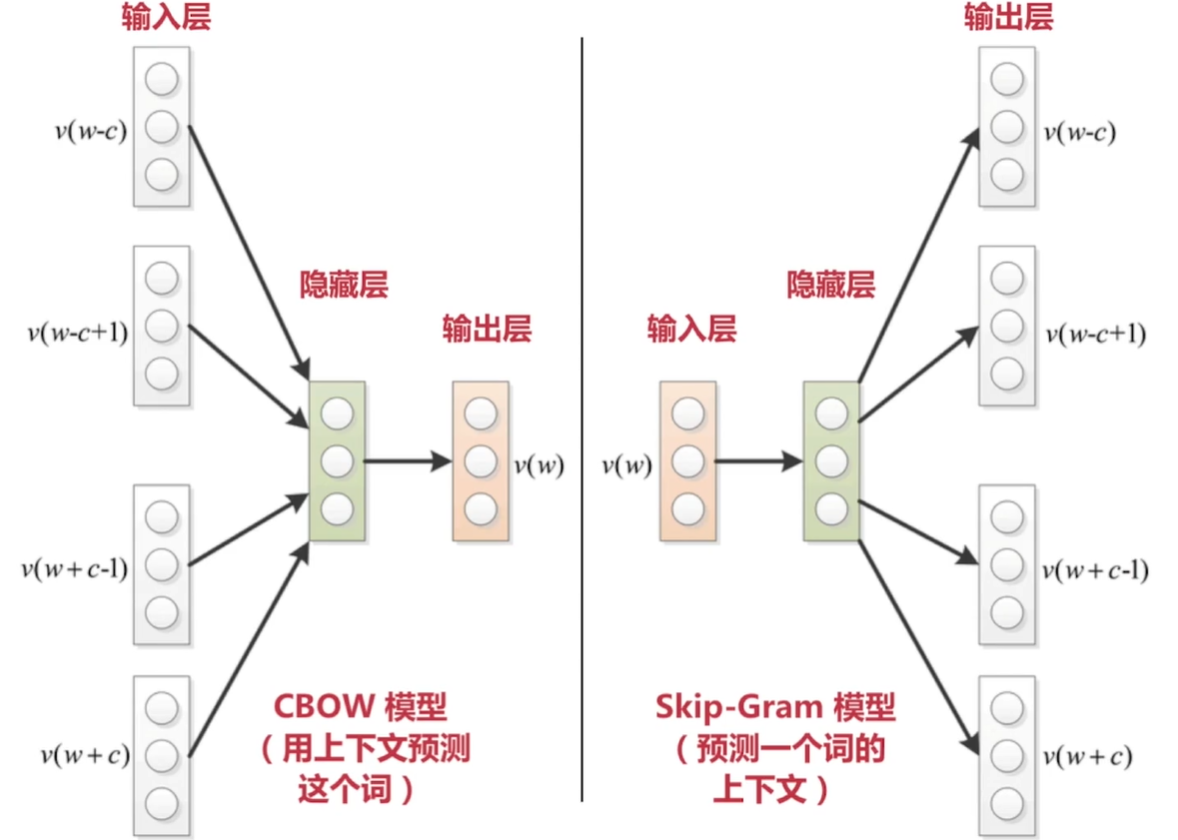

词向量两种模型: