Related works

1. visual relationships

2. Neural networks on a graph

3. Memory augmented neural network

文章方法上值得关注的地方

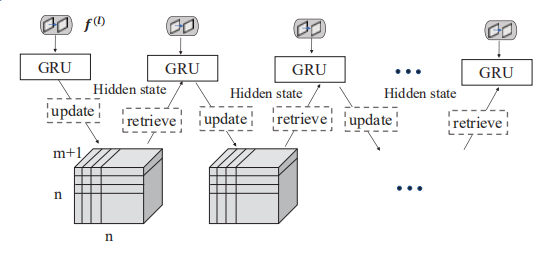

This paper propose a dynamic adjacency tensor memory (DATM) for the DGGN to store information about the relationships among the elements in a diagram.

将graph的边与动态的memory network结合在一起,蛮创新的。基础框架仍然是DGGN,但结合进memory network不仅能在节点之间传递消息(message-passing between nodes) ,而且能在线地构建图的边(build the edges of a graph online),为图的生成和推理提供了很大的潜力。

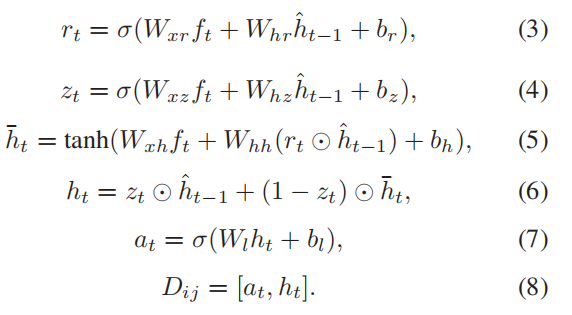

dynamic adjacency tensor memory(DATM)其实是一个

的三维矩阵,该三维矩阵由两部分拼接而成,一部分是邻接矩阵

,另一部分是对应的隐单元H,其

元素

是GRU的m维隐向量,与节点

和

之间的连接有关。邻接矩阵A表示有向图中n个节点之间的连接状态。对于每个GRU 单元的输入就是

即

,

表示两个object特征之间的拼接。

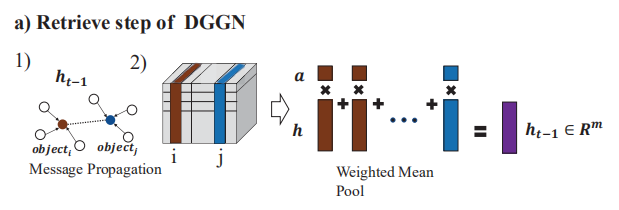

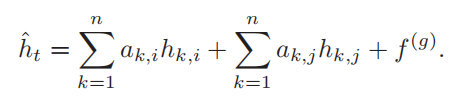

对于Retrieval而言,就是用边的存在概率

加权了

和

的相邻向量

, 并且添加全局特征

以反映图表的全局形状, 形成

时刻的GRU隐层向量

。

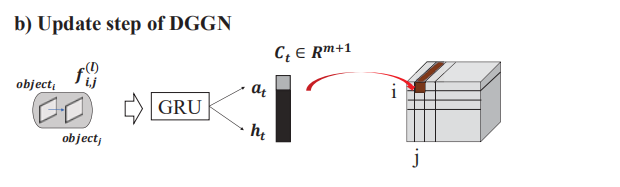

对于Update而言,其中memory里面的一个cell

是由一个GRU cell的输出

与隐层单元

拼接而成。

为了得到隐藏状态

,使用了向量

和

作为标准GRU的先前隐藏状态和输入向量。

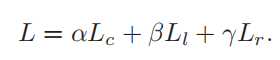

这是包含detection与graph generation的多任务学习,因此其loss包含三项,目标检测分支的分类损失

和位置回归损失

,图生成网络的关系分类损失

。