大数据技术之Hadoop(伪分布搭建)

1.1 Hadoop是什么?

1.2 Hadoop三大发行版本

Hadoop三大发行版本:Apache、Cloudera、Hortonworks。

Apache版本最原始(最基础)的版本,对于入门学习最好。

Cloudera在大型互联网企业中用的较多。

Hortonworks文档较好。

1. Apache Hadoop

官网地址:http://hadoop.apache.org/releases.html

下载地址:https://archive.apache.org/dist/hadoop/common/

2. Cloudera Hadoop

官网地址:https://www.cloudera.com/downloads/cdh/5-10-0.html

下载地址:http://archive-primary.cloudera.com/cdh5/cdh/5/

(1)2008年成立的Cloudera是最早将Hadoop商用的公司,为合作伙伴提供Hadoop的商用解决方案,主要是包括支持、咨询服务、培训。

(2)2009年Hadoop的创始人Doug Cutting也加盟Cloudera公司。Cloudera产品主要为CDH,Cloudera Manager,Cloudera Support

(3)CDH是Cloudera的Hadoop发行版,完全开源,比Apache Hadoop在兼容性,安全性,稳定性上有所增强。

(4)Cloudera Manager是集群的软件分发及管理监控平台,可以在几个小时内部署好一个Hadoop集群,并对集群的节点及服务进行实时监控。Cloudera Support即是对Hadoop的技术支持。

(5)Cloudera的标价为每年每个节点4000美元。Cloudera开发并贡献了可实时处理大数据的Impala项目。

3. Hortonworks Hadoop

官网地址:https://hortonworks.com/products/data-center/hdp/

下载地址:https://hortonworks.com/downloads/#data-platform

(1)2011年成立的Hortonworks是雅虎与硅谷风投公司Benchmark Capital合资组建。

(2)公司成立之初就吸纳了大约25名至30名专门研究Hadoop的雅虎工程师,上述工程师均在2005年开始协助雅虎开发Hadoop,贡献了Hadoop80%的代码。

(3)雅虎工程副总裁、雅虎Hadoop开发团队负责人Eric Baldeschwieler出任Hortonworks的首席执行官。

(4)Hortonworks的主打产品是Hortonworks Data Platform(HDP),也同样是100%开源的产品,HDP除常见的项目外还包括了Ambari,一款开源的安装和管理系统。

(5)HCatalog,一个元数据管理系统,HCatalog现已集成到Facebook开源的Hive中。Hortonworks的Stinger开创性的极大的优化了Hive项目。Hortonworks为入门提供了一个非常好的,易于使用的沙盒。

(6)Hortonworks开发了很多增强特性并提交至核心主干,这使得Apache Hadoop能够在包括Window Server和Windows Azure在内的Microsoft Windows平台上本地运行。定价以集群为基础,每10个节点每年为12500美元。

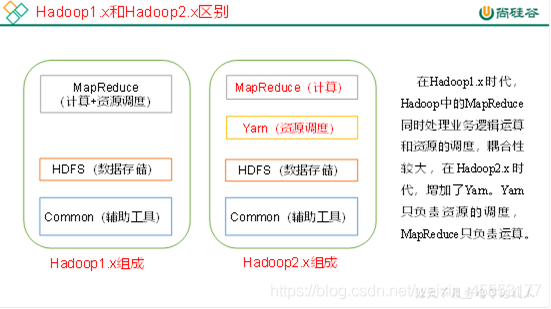

1.3 Hadoop组成

1.3.1 HDFS架构概述

HDFS(Hadoop Distributed File System)的架构概述,如图所示。

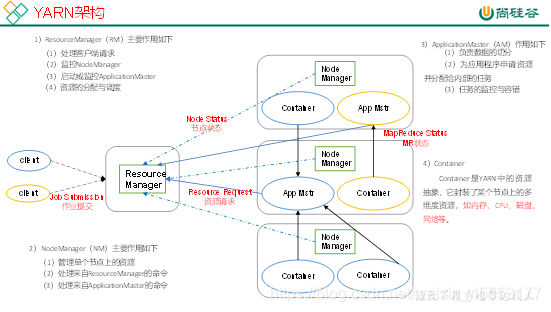

1.3.2 YARN架构概述

YARN架构概述,如图所示。

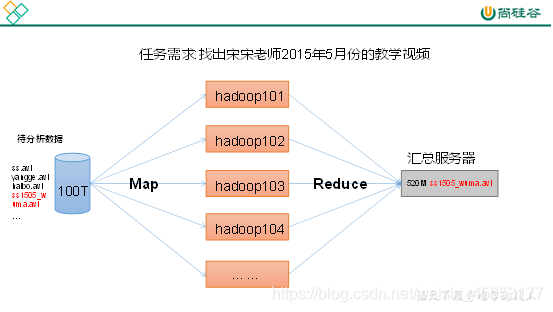

1.3.3 MapReduce架构概述

MapReduce将计算过程分为两个阶段:Map和Reduce,如图所示

1)Map阶段并行处理输入数据

2)Reduce阶段对Map结果进行汇总

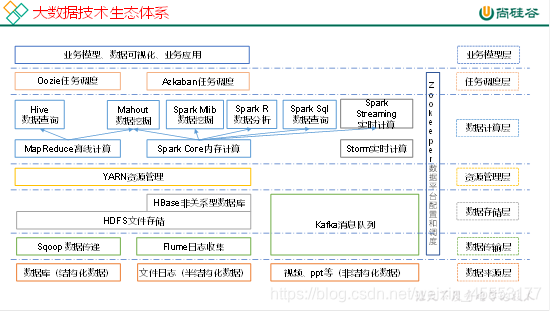

1.4 大数据技术生态体系

图中涉及的技术名词解释如下:

1)Sqoop:Sqoop是一款开源的工具,主要用于在Hadoop、Hive与传统的数据库(MySql)间进行数据的传递,可以将一个关系型数据库(例如 :MySQL,Oracle 等)中的数据导进到Hadoop的HDFS中,也可以将HDFS的数据导进到关系型数据库中。

2)Flume:Flume是Cloudera提供的一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的系统,Flume支持在日志系统中定制各类数据发送方,用于收集数据;同时,Flume提供对数据进行简单处理,并写到各种数据接受方(可定制)的能力。

3)Kafka:Kafka是一种高吞吐量的分布式发布订阅消息系统,有如下特性:

(1)通过O(1)的磁盘数据结构提供消息的持久化,这种结构对于即使数以TB的消息存储也能够保持长时间的稳定性能。

(2)高吞吐量:即使是非常普通的硬件Kafka也可以支持每秒数百万的消息。

(3)支持通过Kafka服务器和消费机集群来分区消息。

(4)支持Hadoop并行数据加载。

4)Storm:Storm用于“连续计算”,对数据流做连续查询,在计算时就将结果以流的形式输出给用户。

5)Spark:Spark是当前最流行的开源大数据内存计算框架。可以基于Hadoop上存储的大数据进行计算。

6)Oozie:Oozie是一个管理Hdoop作业(job)的工作流程调度管理系统。

7)Hbase:HBase是一个分布式的、面向列的开源数据库。HBase不同于一般的关系数据库,它是一个适合于非结构化数据存储的数据库。

8)Hive:Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供简单的SQL查询功能,可以将SQL语句转换为MapReduce任务进行运行。 其优点是学习成本低,可以通过类SQL语句快速实现简单的MapReduce统计,不必开发专门的MapReduce应用,十分适合数据仓库的统计分析。

10)R语言:R是用于统计分析、绘图的语言和操作环境。R是属于GNU系统的一个自由、免费、源代码开放的软件,它是一个用于统计计算和统计制图的优秀工具。

11)Mahout:Apache Mahout是个可扩展的机器学习和数据挖掘库。

12)ZooKeeper:Zookeeper是Google的Chubby一个开源的实现。它是一个针对大型分布式系统的可靠协调系统,提供的功能包括:配置维护、名字服务、 分布式同步、组服务等。ZooKeeper的目标就是封装好复杂易出错的关键服务,将简单易用的接口和性能高效、功能稳定的系统提供给用户。

2.1 Hadoop运行环境搭建

2.1.1 虚拟机环境准备

1.安装VMware Workstation Pro

下载网址:https://my.vmware.com/en/web/vmware/downloads

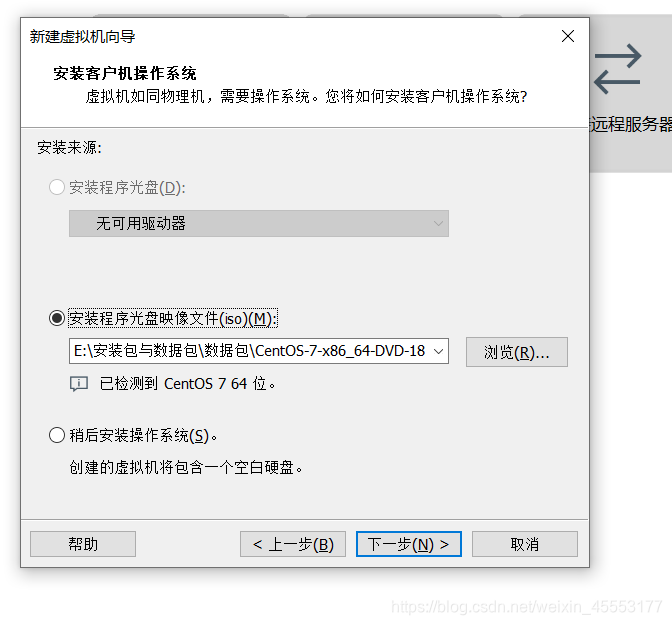

2.下载镜像源centos7

下载网址:http://isoredirect.centos.org/centos/8/isos/x86_64/CentOS-8.1.1911-x86_64-dvd1.iso

3.创建新的虚拟机

2.1.2 虚拟机网络配置

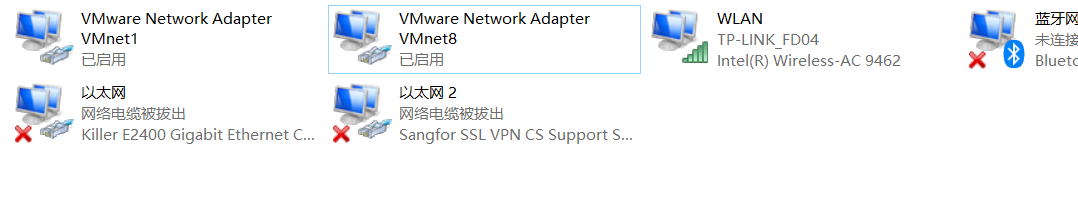

1.外部网络配置

1.1控制面板\网络和 Internet\网络连接

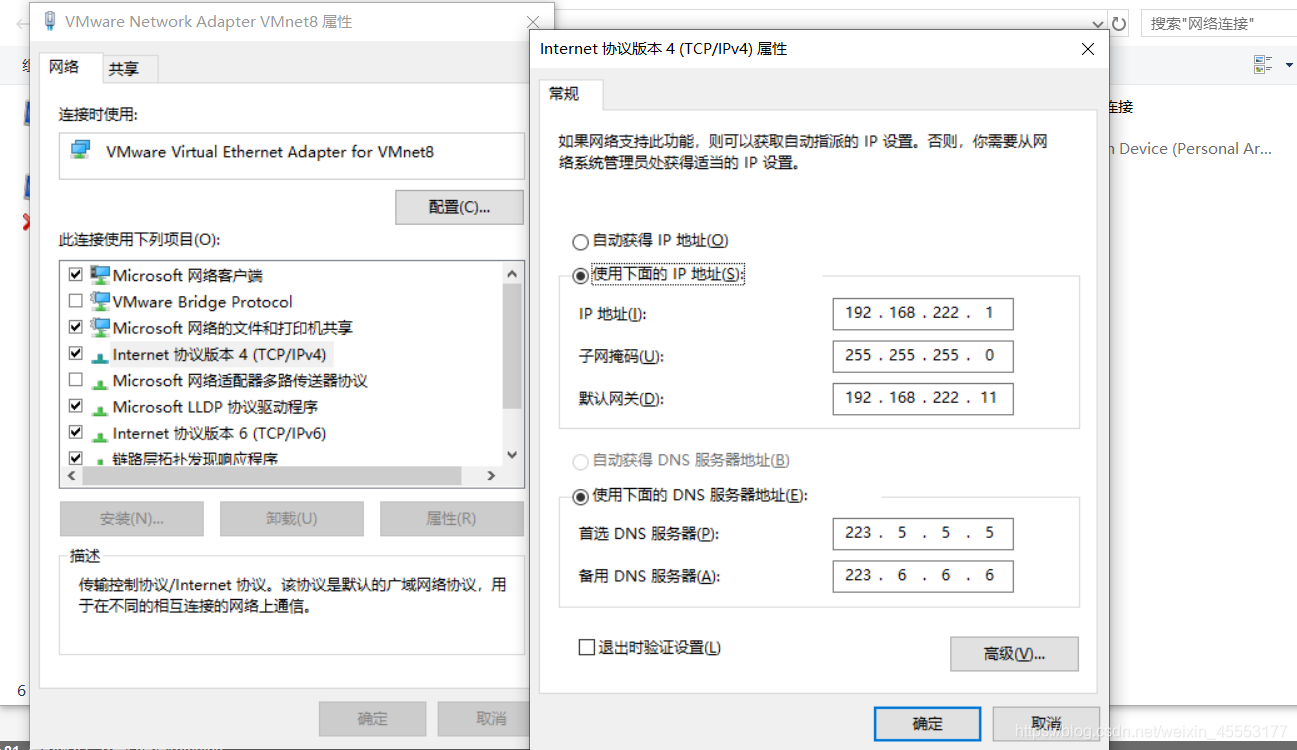

1.2打开VMware Network Adapter VMnet8属性

1.3找到internet协议版本4(TCP/Pv4)进行设置,如下图所示。

1.3找到internet协议版本4(TCP/Pv4)进行设置,如下图所示。

2.虚拟机网络配置

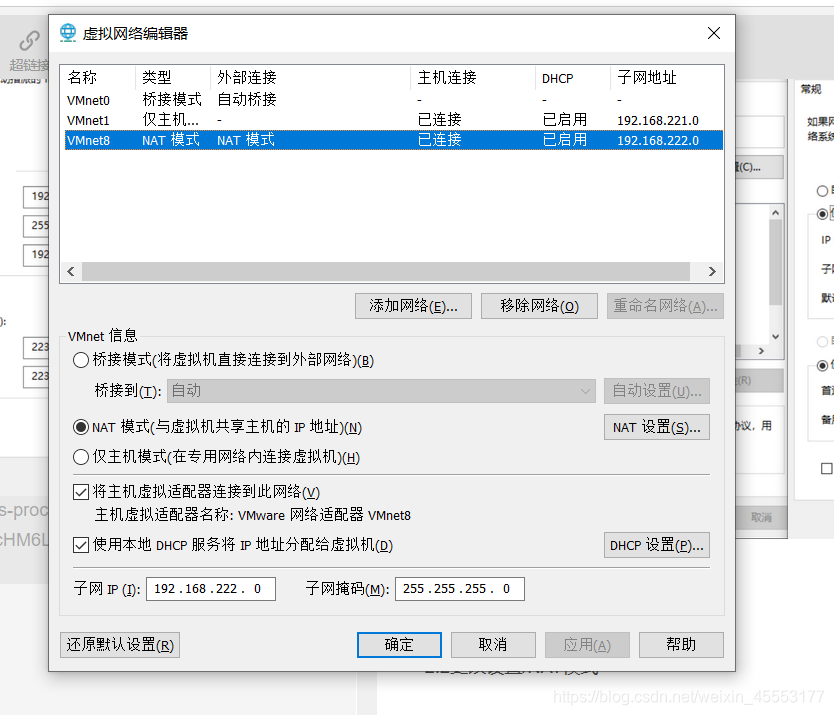

2.1编辑/虚拟机网络编辑器

2.2更改设置/NAT模式(注意子网ip在最后一位写0,NAT设置里网关与外部对应)

3.内部网络配置

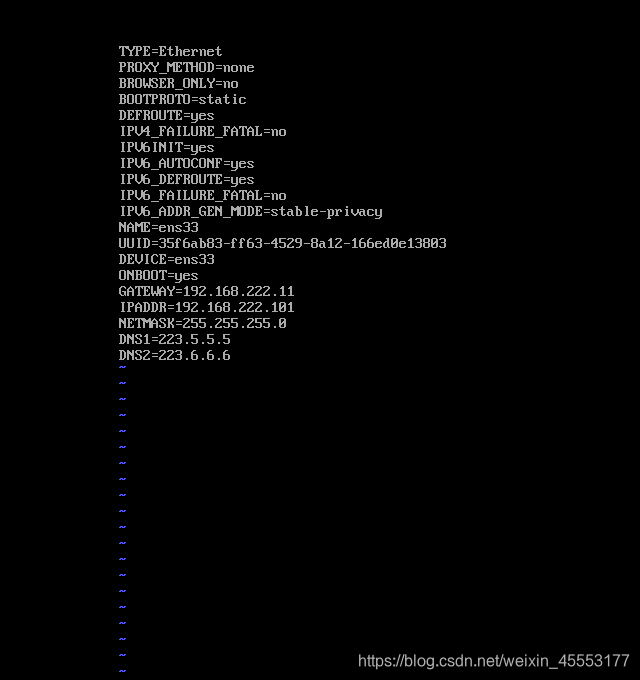

3.1 vi /etc/sysconfig/network-scripts/ifcfg-ens33

3.2 service network restart(网络生效)

3.3 ping www.baidu.com(检测网络连接)

2.1.3 HADOOP伪分布搭建

1. 打开Xshell 6

填写主机名、链接、用户名、密码

2. 进入界面先下载vim

下载vim:yum install vim

3. 开始配置

3.1

cd /usr/local (进入目录)

ll (查看目录信息)

mkdir hadoop

mkdir java (创建目录)

3.2 拖文件

3.2.1 Hadoop架包hadoop -2.9.2.tar.gz 下载网址:https://hadoop.apache.org/releases.html

3.2.2 Java架包 jdk-8uzll-linux-x64.tar.gz 下载网址:https://www.oracle.com/technetwork/java/javase/downloads/index.html

cd hadhoop/ (切换到Hadoop目录下)

ll (查看目录信息)

tar –zxvf hadoop -2.9.2.tar.gz (解压Hadoop)

rm –rf hadoop -2.9.2.tar.gz (删除Hadoop解压包)

cd ../java (到java目录下)

tar –zxvf jdk-8uzll-linux-x64.tar.gz解压java)

rm –rf jdk-8uzll-linux-x64.tar.gz (删除java解压包)

3.4配置环境变量

vim /etc/profile (进入vim编辑器改路径)

export JAVA_HOME=/usr/local/java/jdk1.8.0_211

export HADOOP_HOME=/usr/local/hadoop/hadoop-2.9.2

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

配置文件生效:source /etc/profile

3.5 配置Hadoop环境变量

cd /usr/local/hadoop/hadoop -2.9.21/etc/hadoop/ (进入Hadoop目录下)

1.第一个配置

vim hadoop –env.sh

第25行改Java路径

export JAVA_HOME=/usr/local/java/jdk1.8.0_211/

2.第二个配置(注意主机IP和Hadoop版本)

vim core –site.xml

<!-- 指定HADOOP所使用的文件系统schema(URI),HDFS的老大(NameNode)的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.222.101:9000</value>

</property>

<!-- 指定hadoop运行时产生文件的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/hadoop-2.9.2/tmp</value>

</property>

3.第三个配置

vim hdfs –site.xml

<!-- 指定HDFS副本的数量 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

3.6进行格式化并启动

hadoop namenode –format

start-dfs.sh(输3遍yes和密码)

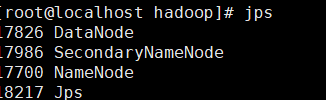

3.7输入jps验证是否配置成功

4. 关闭防火墙

systemctl stop firewalld.service(临时)

systemctl disable firewalld.service(开机时关闭)

5. 免密

ssh-keygen -t rsa(一直按回车)

拷贝密钥(开启时不要输三次密码)

ssh-copy-id 192.168.222.101

6.谷歌访问:http://192.168.222.101:50070/