Hadoop伪分布安装

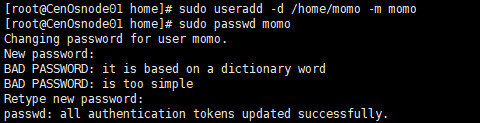

1.创建用户与用户组

创建一个用户,名为momo,并为此用户创建home目录,此时会默认创建一个与momo同名的用户组。

> sudo useradd -d /home/momo -m momo

为momo用户设置密码,执行下面的语句

> sudo passwd momo

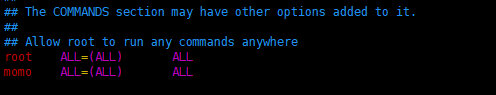

给普通用户加超级用户权限的方法

- 进入超级用户模式。即输入"su",系统会让你输入超级用户密码,输入密码后就进入了超级用户模式。

- 添加文件的写权限。

> chmod u+w /etc/sudoers

- 编辑/etc/sudoers文件。即输入命令"vim /etc/sudoers",找到这一行:“root ALL=(ALL) ALL"在起下面添加"xxx ALL=(ALL) ALL”(这里的xxx是要改的用户名),然后保存

root ALL=(ALL) ALL

momo ALL=(ALL) ALL

切换到momo用户下操作

> su - momo

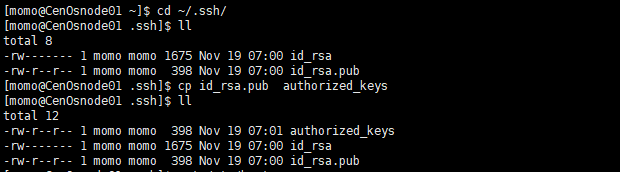

2.配置SSH免密码登录

SSH免密码登录需要在服务器执行以下命令,生成公钥和私钥对

> ssh-keygen -t rsa

接下来都回车操作

此时SSH的公钥和私钥已经生成完毕,且放置在~/.ssh目录下。

切换到~/.ssh目录下创建一文本为authorized_keys,内容与id_rsa.pub一样。

>cd ~/ssh

>cp id_rsa.pub authorized_keys

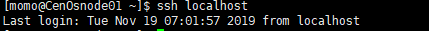

测试:

> ssh localhost

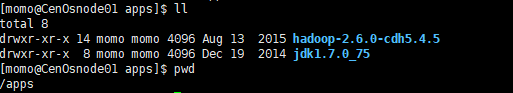

3.解压安装包

创建两个目录,用于存放安装程序及数据,并更改目录的用户及用户组

> sudo mkdir /apps

> sudo mkdir /data

> sudo chown -R momo:momo /apps

> sudo chown -R momo:momo /data

解压

> tar -zxvf hadoop-2.6.0-cdh5.4.5.tar.gz -C /apps

> tar -zxvf jdk-7u75-linux-x64.tar.gz -C /apps

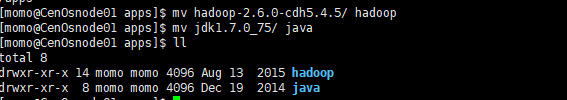

重命名

> mv hadoop-2.6.0-cdh5.4.5/ hadoop

> mv jdk1.7.0_75/ java

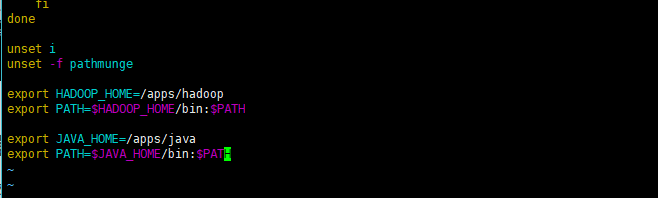

4.配置环境变量

修改/etc/profile文件

添加如下代码:

export HADOOP_HOME=/apps/hadoop

export PATH=$HADOOP_HOME/bin:$PATH

export JAVA_HOME=/apps/java

export PATH=$JAVA_HOME/bin:$PATH

使配置生效

source /etc/profile

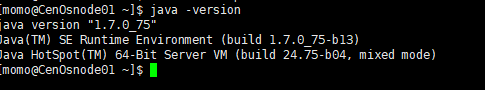

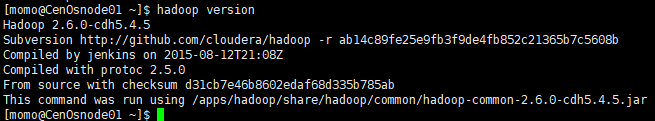

测试

5.修改hadoop本身相关的配置

切换到hadoop的安装路径/apps/hadoop下

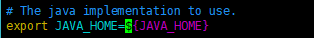

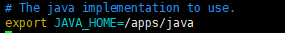

5.1修改hadoop安装路径下的etc/hadoop/hadoop-env.sh文件

由:

改为:

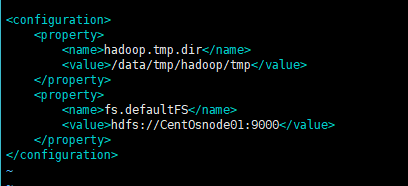

5.2修改core-site.xml配置文件

> vim /apps/hadoop/etc/hadoop/core-site.xml

添加如下内容:

<property>

<name>hadoop.tmp.dir</name>

<value>/data/tmp/hadoop/tmp</value>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://CentOsnode01:9000</value>

</property>

创建数据存放路径:

mkdir -p /data/tmp/hadoop/tmp

5.3修改hdfs-site.xml配置文件

> vim /apps/hadoop/etc/hadoop/hdfs-site.xml

添加内容如下:

<property>

<name>dfs.namenode.name.dir</name>

<value>/data/tmp/hadoop/hdfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/data/tmp/hadoop/hdfs/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

创建数据存放目录

mkdir -p /data/tmp/hadoop/hdfs/name

mkdir -p /data/tmp/hadoop/hdfs/data

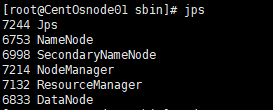

6.格式化HDFS文件系统,启动Hadoop

//格式化命令

hdfs namenode -format

//启动命令

$/apps/hadoop/sbin/start-all.sh

查看进程数:

jps