Abstract

SRCNN把低分辨率先进行双三次插值是不合适的,我们希望在LR空间上进行特征映射。和FSRCNN一样。那我们怎么办?提出这一种亚像素卷积层,(这是什么呀?)用一系列放大滤波器来放大在LR特征空间到SR输出空间。可以用于照片和视频。

就是用了一个放大滤波器而不用那个双三次插值了。更快了。减少计算复杂度。

Introduction

全局SR的基本假定:低分辨率图像=高分辨率图像的低通滤波+下采样+加噪声。

低分辨率到高分辨率是一个一对多的映射是一种不适定问题。

原因:不可逆的低通滤波和二次采样操作过程中会发生高频信息的丢失 此外,SR操作实际上是从LR到HR空间的一对多映射,该映射可以具有多个解决方案。

结果:其中确定正确的解决方案并非易事。 一个LR有多个HR

问题:这样有不同的结果还可以重建么?

答案:关键假设是,许多高频数据是冗余的,因此可以从低频分量中准确地重建出来。 因此,SR是一个推理问题,依赖于我们所讨论图像统计的模型。(啥是推理问题)

由于不可逆的低通滤波和二次采样过程中发生的高频信息丢失。(什么意思就是说高频的信息损失了,所以产生的低分辨率图像就是多种吗)

explicit redundancy显示冗余(没有找到意思,是说图像是高频冗余的吗)

implicit redundant 隐式冗余,即存在于自然数据中以恢复丢失的HR信息从一个LR实例。

其他人的做法:

假定可以使用多个图像,具有不同视角的同一场景的LR实例,即具有唯一的先验仿射变换。(这是啥东西)多图像SR利用通过限制不适定问题来实现显式冗余与其他信息并尝试将下采样过程。但是,这些方法通常需要计算复杂的图像配准,并且融合阶段,其准确性直接影响结果的质量。emmmm…

另一种方法是单图像超分辨率(SISR)技术。这些技术试图学习隐式冗余。这通常以以下形式出现图像和其他时间的局部空间相关性视频中的相关性。在这种情况下,需要重构约束的形式来限制重建的解空间。

稀疏编码基于稀疏性的技术。假设任何自然图像都可以稀疏的机制在转换域中表示。(什么是稀疏编码啊?不明白)这个变换域通常是图像原子的字典,可以通过尝试发现的训练过程来学习LR和HR补丁之间的对应关系。要嵌入必要的先验知识限制,解决看不见的不适定问题。缺点是通过非线性重建的稀疏约束是通常在计算上昂贵。

在网络第一层就进行超分辨是不合适的:1.计算量大2.增加了无关的信息。

没有输出大小大于输入大小的卷积层的有效实现,以及诸如convnet [21]之类的优化优化实现,都不会轻易允许这种行为。

本文中在最后一层从低维的LR特征映射到HR空间,不需要在高维上进行操作。提出了一种亚像素卷积层。

较小的过滤器尺寸以集成相同的信息,同时保持给定的上下文区域。可以用较小的滤波器较小的过滤器尺寸以集成相同的信息,同时保持给定的上下文区域。

对于具有L层的网络,我们学习nL-1升频nL-1特征图的滤波器,而不是一个输入图像的放大滤波器。

2.Method

用高斯滤波模拟照片散焦。我们用了l层卷积神经网络。然后应用一个亚像素卷积层放大LR的特征映射来产生SR。

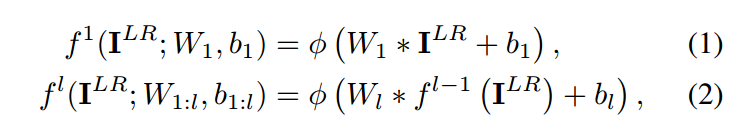

L层,前L-1层

Wl bl l∈(1,L-1)

Wl的大小 nl-1 nl kl kl,

nl是l层的特征数,kl是l层的滤波器大小,

bl的大小nl

在LR空间中以步长为1/r的卷积和大小为ks的权重为1/r的滤波器Ws进行卷积。激活Ws的不同部分以进行卷积。 介于像素之间的权重根本不会激活不需要计算。 激活数模式恰好是r2。 每个激活方式,根据到其位置,最多【ks/r】^2的。 这些模式在卷积过程中定期激活图像上的滤镜取决于不同的子像素位置:mod(x,r),mod(y,r)其中x,y是输出

HR空间中的像素坐标。 在本文中,我们提出

一种有效的方法来实现以上操作

mod(ks,r)= 0:

3 Experiments

Datasets:

Set5 and Set14 BSD300 and BSD500 ImageNet

Xiph database Ultra Video、Group database

训练时,可以将输入的训练数据,预处理成重新排列操作前的格式,比如将21×21的单通道图,预处理成9个通道,7×7的图,这样在训练时,就不需要做重新排列的操作。另外,ESPCN激活函数采用tanh替代了ReLU。损失函数为均方误差。

ESPCN的核心概念是亚像素卷积层(sub-pixel convolutional layer)。如上图所示,网络的输入是原始低分辨率图像,通过两个卷积层以后,得到的特征图像大小与输入图像一样,但是特征通道为(是图像的目标放大倍数)。将每个像素的个通道重新排列成一个r x r的区域,对应于高分辨率图像中的一个r x r大小的子块,从而大小为 x H x W的特征图像被重新排列成1 x rH x rW大小的高分辨率图像。这个变换虽然被称作sub-pixel convolution, 但实际上并没有卷积操作。通过使用sub-pixel convolution, 图像从低分辨率到高分辨率放大的过程,插值函数被隐含地包含在前面的卷积层中,可以自动学习到。只在最后一层对图像大小做变换,前面的卷积运算由于在低分辨率图像上进行,因此效率会较高。

方法

SISR的任务是从相应的原始HR图像下采样后的LR图像中估计出HR图像。下采样操作是确定性和已知的:为了从高分辨率图像中产生低分辨率图像,我们首先使用高斯滤波器对高分辨率图像进行卷积操作,然后以r为单位对图像进行下采样。我们将把r称为升序比例。通常,HR和LR都可以具有C色通道,因此它们分别表示为大小为H×W×C和rH×rW×C的实数张量。

在网络输出层才进行上采样的框架,与在输入层利用bicubic上采样的SRCNN相比,在训练和测试时都降低了复杂度。测试时,进入卷积的图像比SRCNN方法小r×r个尺度,r为上采样尺度,所以速度快r×r,这是因为大部分时间花销都在输出层之前的卷积上。训练时,可以将输入的训练数据,预处理成shuffling操作前的格式,比如将21×21的单通道图,预处理成9个通道,7×7的图,这样在训练时,就不需要shuffling操作。另外值得一提的是,该文采用tanh替代了relu。

4 Conclusion

固定的滤波器不能提供额外的信息,采用亚像素,代替去卷积层。

第一个能适应视频的网络。速度变快准确率变高了。

去卷积层有什么不好的。

5 Future work

时空神经网络

4h56min