&论文概述

论文地址: https://arxiv.org/abs/1711.06897

代码地址:https://github.com/sfzhang15/RefineDet

&总结与个人观点

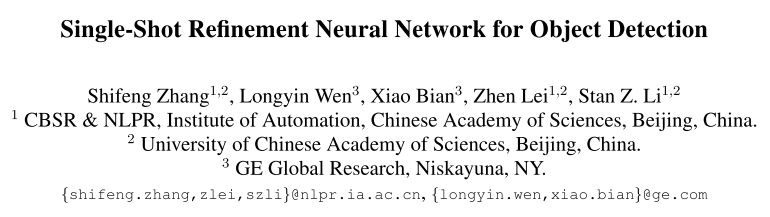

本文提出基于single-shot refinement neural network的检测器,由ARM与ODM组成。ARM用于过滤负anchor以减少分类器的搜索空间,同时对粗略地调整anchor的位置以及大小为后续的回归器提供更好的初始化;ODM将从前面的ARM得到的精修的anchor作为输入来回归精确的目标位置以及大小,同时预测多响应的多类别标签。整个网络使用多任务损失进行端到端的训练。RefineDet在PASCAL VOC 2007, PASCAL VOC 2012以及MS COCO数据集上均取得了最优的检测精度同时高效。之后计划使用RefineDet来检测其他特定的目标,如行人,车辆以及面部,同时引入注意力机制获得更好的效果。

通过对整体结构的观察,本文提出的RefineDet与FPN的结构相似,与FPN的主要区别在于,FPN在bottom-top方向的特征图中没有进入分类以及回归的子网,而RefineDet则通过这种方式得到了Refined anchor,此外则是TCB模块的使用与FPN中的特征融合过程有些差别。

&贡献

1、 提出使用ARM以及ODM的one-stage目标检测框架;

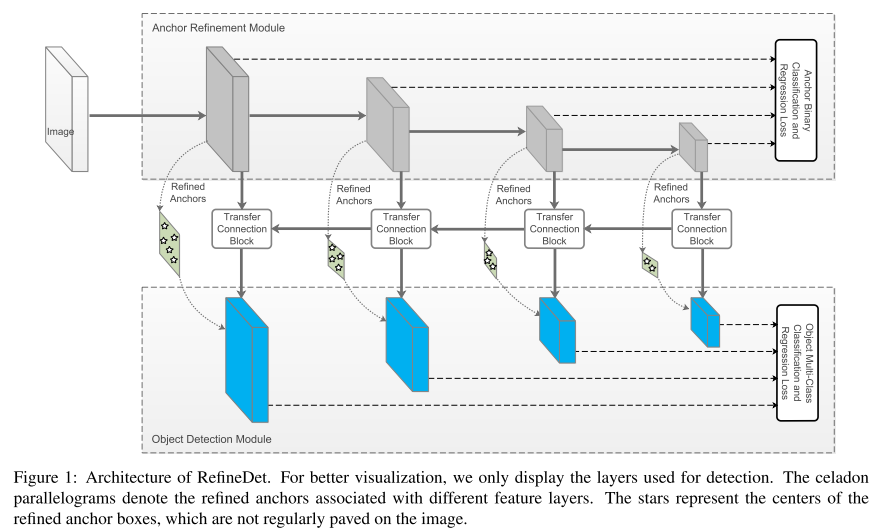

2、 设计TCB将ARM中的特征传递到ODM中,以解决预测精确的目标定位,大小以及类别标签等挑战性任务;

3、 RefineDet在PASCAL VOC2007,PASCAL VOC2012以及MS COCO数据集中取得了最优的性能。

&拟解决的问题

问题:实现优于two-stage方法的精度以及保持one-stage方法相较的效率。

分析:

One-stage方法的检测精度普遍低于two-stage方法,其中一个主要的原因是类别不平衡问题。

而近期用于解决该问题的方法诸如:Kong等人在卷积特征上使用目标先验限制来减少目标的搜索空间;Lin等重定义标准交叉熵损失使得训练更注重难例同时降低能够很好分类的样本的权重;Zhang等设计max-out标签机制来减少样本不平衡带来的false positive。

本文观点认为two-stage方法相比于one-stage方法主要有3个优势:

- 使用带有启发式采样的two-stage结构来解决类别不平衡问题

- 使用两步级联回归目标box参数

- 使用two-stage特征描述目标

&框架及主要方法

1、 Main Architecture:

整个网络主要有两个部分组成,ARM以及ODM,其中ARM通过前景背景的得分过滤一些negative anchor以及使用回归损失粗略调整anchor的位置以及大小,得到相对refined anchor。ODM将refined anchor作为输入进行精确的分类与回归操作。其中使用到TCB将ARM中的特征传递到ODM中。

2、 TCB(Transfer Connection Block)

主要是为了将上层特征融合到当前层中,对high_level特征使用deconv得到与当前层相同的维度,使用element-wise sum方法,之后将结果输入到一个卷积层中(文中提到:此卷积层的作用是为了确保用于检测的特征的分辨力?)。

3、 Two-step Cascade Regression

当前的one-stage方法使用的都是一步回归,即基于不同尺度的不同特征层来预测目标的location以及size,而这种方式在挑战性场景中尤其是检测小目标时是不精确的。本文提出two-step级联回归策略:在ARM中初次对anchor的location以及size进行调整,以对ODM的回归进行更好的初始化。

每个特征图cell上定义n个anchor boxes,对每个特征图cell预测refined anchor相对于原始anchor的4个偏移以及2个置信得分用于表示前景类的概率。在获得refined anchor后,将其传入ODM的对应响应特征图中以进行分类以及精确定位。

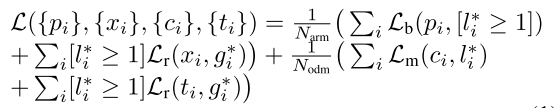

4、 Loss Function

其中i表示anchor的下标,pi以及xi分别是第i个anchor是目标的概率以及ARM中该anchor的refined坐标,ci以及ti分别是ODM中预测的类别以及对应坐标。li*是ground truth类别,gi*是其location以及size。Narm与Nodm分别是ARM与ODM中正anchor的数量。Lb是交叉熵损失或log损失,Lm是softmax损失。当Narm或Nodm为0时,对应的项为0。

5、 Experiment

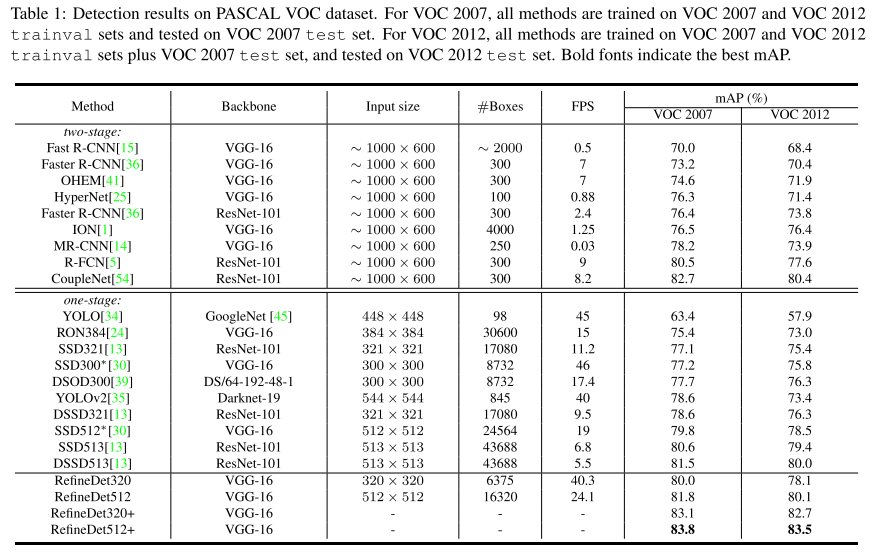

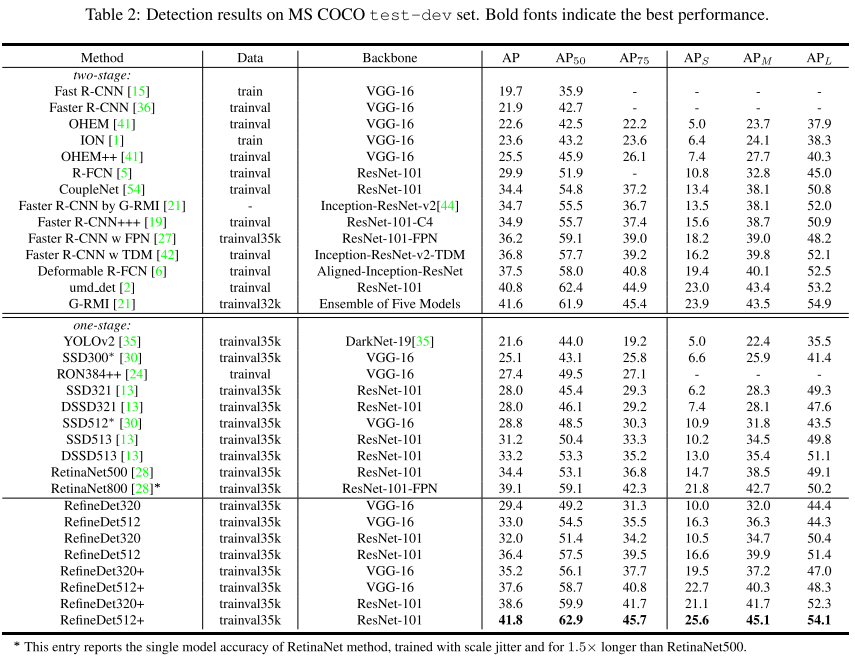

(1) RefineDet在PASCAL VOC 2007、PASCAL VOC 2012以及MS COCO数据集上与其他方法的对比。

结果显示RefineDet的最优性能超过表中枚举的方法。

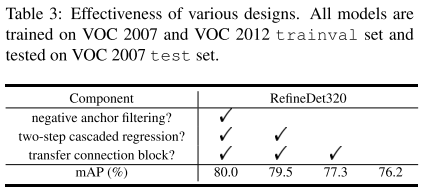

(2) 消融实验:对文中提到的三个方法分别是negative anchor filtering、two-step cascade regression、transfer connection block的作用对比。

&思考与启发

整体说来,这篇论文的主要创新点在前向传播的阶段使用了two-step cascade regression方法,能够对原始的anchor进行refine操作。整体结构还是与FPN神似。