神经网络的学习(一)

#第二代神经网络之ANN——

十分简洁易懂的: https://blog.csdn.net/leiting_imecas/article/details/60463897

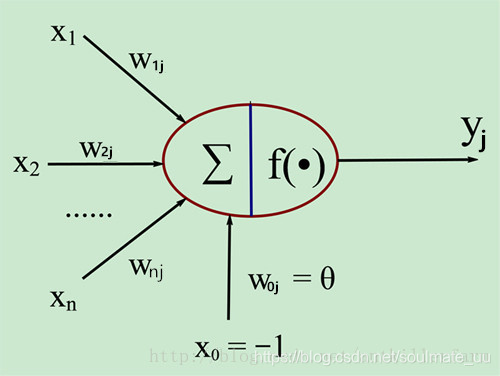

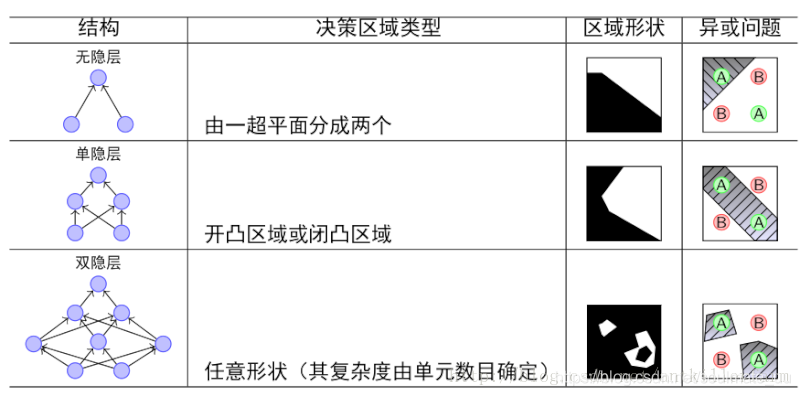

- 单层感知器(M-P神经元模型),解决LR逻辑回归问题

- 多层感知器,单层感知器的基础上加入了隐层,以解决非线性分类等问题

- BP(误差反向传播)算法

核心思路:

- 利用前向传导公式,计算第n层输出值。

- 计算输出值和实际值的残差。

- 将残差梯度传递回第n−1,n−2,…,2层,并修正各层参数。(即所谓的误差逆传播)

- 神经元激活函数

常见的有四种:阶跃函数、Sigmoid函数(常用)、双曲正切函数(tanh函数)、ReLU激活函数。 - ANN在生物合理性方面较差,并且计算量大,转而实现第三代神经网络SNN。

#第三代神经网络之SNN——

1. 神经元模型:

-

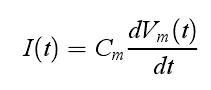

IF模型( integrate-and-fire模型):

实际上是电导 Q = CV 对时间的导数。当施加输入电流时,膜电位随时间增加, 直到其达到固定阈值 Vth ,在这一时刻发放一个 delta 函数形式的脉冲,且电压重置到静息电位。模型的发放频率随输入电流的增加而增加,且没有上限。通过引入不应期,即限制神经元在一定时间内不再发放,可限制神经元的发放频率。 -

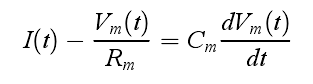

LIF模型( leaky integrate-and-fire模型):

其中 Rm是膜上电阻。这一设定需要输入电流超过阈值 Ith= Vth/R m 才能使神经 元发放,否则电压上积累的变化会逐渐消失。

2. 突触可塑性学习规则(调整神经元模型之间的权重)

BP算法不再适用,因为信息靠离散的脉冲传播,不可导,必须研究新的突触可塑性学习算法。

以下都是无监督学习算法。

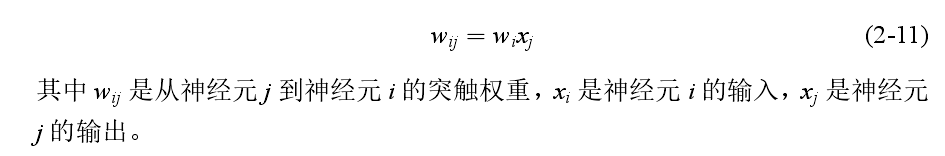

- Hebb learning rule:

Hebb learning rule 描述了如何修改神经元模型之间的权重。当两个神经元同时发放脉冲时,神经元之间的权重增加,当它们分开发放时,神经元之间的权重降低。

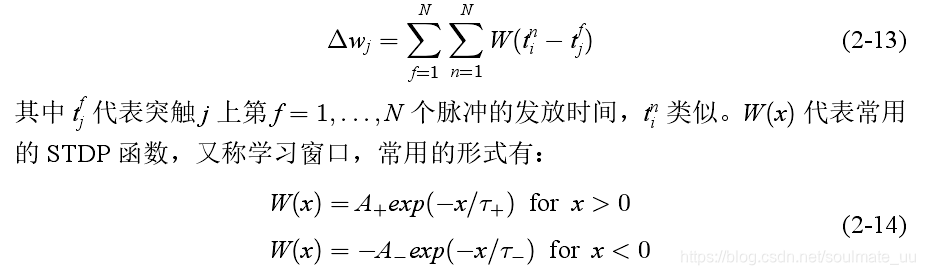

- Spike-Timing Dependent Plasticity:STDP

在STDP中,由神经元 j 延伸出的突触的权重变化 ∆wj依赖于突触前神经元和突触后神经元的脉冲的发放时间差。

3. 存在的问题

https://blog.csdn.net/Uwr44UOuQcNsUQb60zk2/article/details/79060595

既然理论上 SNN 比第二代网络更强大,那么我们很自然会想到为什么它们没有得到广泛应用。主要问题在于:

(1) SNN 的训练。尽管我们有无监督生物学习方法,如赫布学习(Hebbian learning)和 STDP,但没有适合 SNN 的有效监督训练方法能够 通过提供优于第二代网络的性能。由于脉冲训练不可微,我们无法在不损失准确时间信息的前提下使用梯度下降来训练 SNN。因此,为了正确地使用 SNN 解决真实世界任务,我们需要开发一种高效的监督学习方法。

(2)正常硬件上模拟 SNN 需要耗费大量算力。因为它需要模拟微分方程。但是,神经形态硬件,如 IBM TrueNorth,旨在使用利用神经元脉冲行为的离散和稀疏本质的专门硬件模拟神经元,进而解决该问题。