https://www.jianshu.com/p/9526f944ca6f

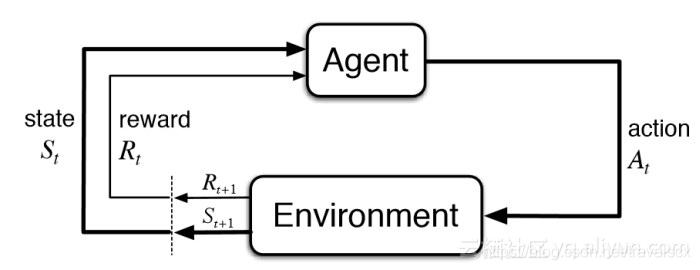

强化学习是一种机器学习方法,它使Agent能够在交互式环境中年通过试验并根据自己的行动和经验反馈的错误来进行学习。

虽然监督学习和强化学习都使用输入和输出之间的映射关系,但强化学习与监督学习不同,监督学习提供给Agent的反馈是执行任务的正确行为,而强化学习使用奖励和惩罚作为积极和消极行为的信号。

- 增强学习的特点是:从现有的状态出发,不断的优化自己的策略。

- 使用神经网络对状态进行估算:整个系统在运作过程中,通过现有的策略产生了一些数据,获得的这些数据在计算回报值Reward的时候,会有所修正,我们把修正的值和状态,作为神经网络的输入,再进行训练,最后的结果显示,这样做是可以收敛的。神经网络的运用包括训练和预测两部分,训练的时候输入的是状态和这个状态的value值,预测时候输入时状态,输出的是估算的value值。

**Q-learning **

https://blog.csdn.net/itplus/article/details/9361915

deep Q network

DQN与Qleanring类似都是基于值迭代的算法,但是在普通的Q-learning中,当状态和动作空间是离散且维数不高时可使用Q-Table储存每个状态动作对的Q值,而当状态和动作空间是高维连续时,使用Q-Table不动作空间和状态太大十分困难。

所以在此处可以把Q-table更新转化为一函数拟合问题,通过拟合一个函数function来代替Q-table产生Q值,使得相近的状态得到相近的输出动作。因此我们可以想到深度神经网络对复杂特征的提取有很好效果,所以可以将DeepLearning与Reinforcement Learning结合。这就成为了DQN

也就是说,将 状态 和 动作 当成神经网络的输入,然后经过神经网络分析后得到动作的 Q 值,这样我们就没必要在表格中记录 Q 值,而是直接使用神经网络生成 Q 值。