ICCV2017论文“Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks”

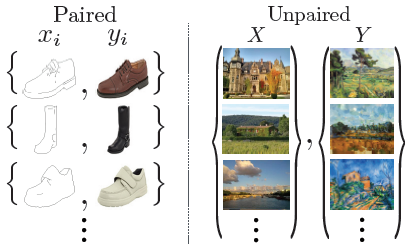

此文章的提出主要是为了解决一个问题—— image-to-image translation中一对一的训练数据较难获得。一般的训练,生成图像总是要与某个gound truth完全相等(pair),而这种gound truth在某些场合中很难获取(例如风格迁移)。因此,作者希望在不借助paired example情况下,实现图像转换。

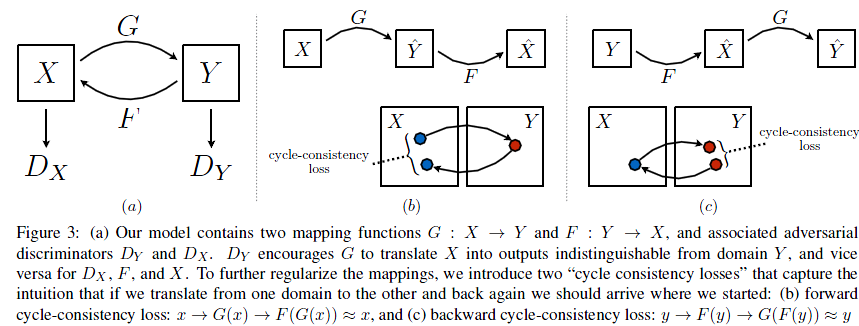

作者希望能学到一个映射Maping G,将域A中的图片转换到域B中的图片,将域B中的图片转换到域A中的图片,而两个域中的图片并不是成对出现。为使得生成的图片和原来真实的图片无法分辨,因为从A到B的映射出来的图片可能有很多中,为加强转换的约束性,同时为避免GAN中常见的mode collapse问题,将GAN的结构扩展为![]() :

:

![]()

![]()

模型:

模型的Loss函数分为两部分

(1)X->Y的映射:

同样的,Y->X也有类似的loss

(2)循环一致性损失

扫描二维码关注公众号,回复:

6543234 查看本文章

因此最终的目标函数:

CycleGAN本质上是两个镜像对称的GAN,构成了一个环形网络。

两个GAN共享两个生成器,并各自带一个判别器,即共有两个判别器和两个生成器。一个单向GAN两个loss,两个即共四个loss。