logistics regression

首先明确参数模型和非参数模型的概念: 在参数模型中 通常假设总体服从某一分布,这些分布由某些参数所决定 (例如正态分布由均值和方差所决定),在此基础上构建的模型 称为参数模型

Logistics Regression 便是一个参数模型,假设总体服从伯努利分布,通过极大似然的方法 利用梯度下降求得参数,得到的二值分类模型。

对于线性回归模型 我们通过<w,x>的内积,并设置阈值作为分类的规则,此时<w,b>内积结果是实数域上的,Logistics regression 在此基础上引入了Sigmod函数 将实数域结果压缩到[0,1]范围 。

LR目标函数 :h(x) =g(wTx)

其中g(z) 为sigmod函数 等于 1/(1+e-z)

因此:

logistics regression的表达形式为 P(y=1|w,x)=1/(1+e-wx)

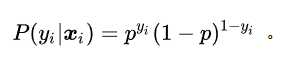

我们希望随机数据点被正确分类的概率最大,对于任意的xi,yi P(yi=1|w,xi)= 1/(1+e-wxi) 我们使用字母p来表示 那么等于0的概率为1-p ,综合起来即为

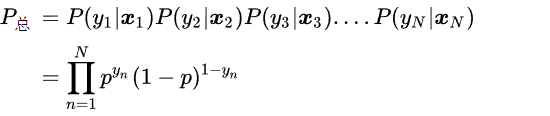

因为我们想要所有的数据点每一个的正确分类概率都尽可能大 因此可以将这些概率全部相乘

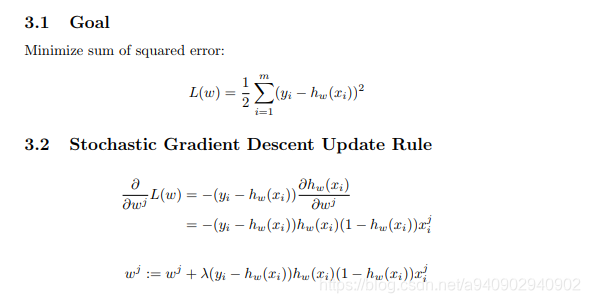

通过取对数进一步化简 可以得到logistics regression的目标函数

L(w)=∑i yilog p+(1-yi)(log (1-p))

此时这个式子中唯一的变量就是w,我们通过寻找w使得L(w)取到最大值

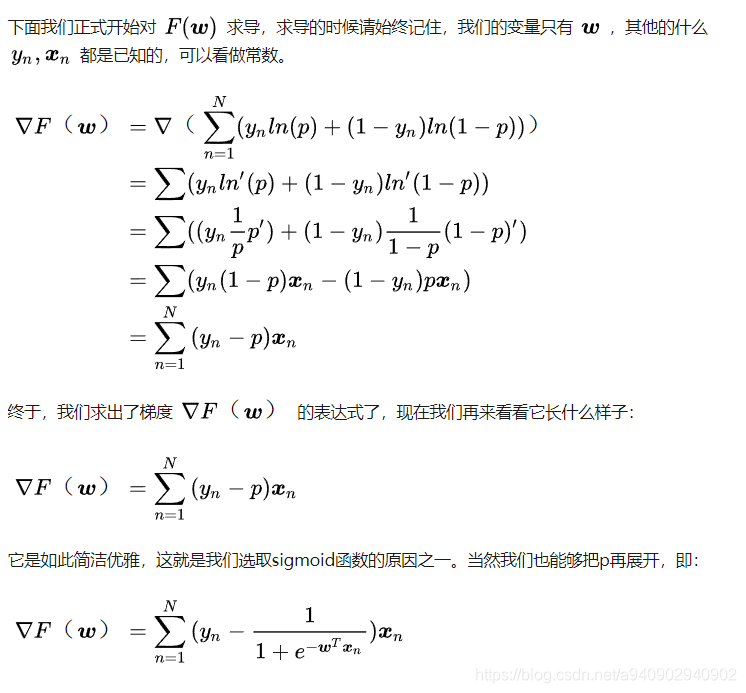

这时需要做的就是求L对于w的导数

(注:一定要记住sigmod函数求导的特性 p对于w的导数等于 p(1-p)x (1-p)对于w的导数等于)

因为是求最大 所有使用梯度上升法 wt+1 =wt+η▽F(w)

Question 1:

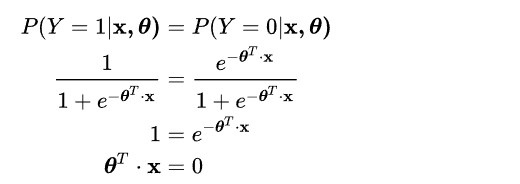

Logistics regression 为什么说是线性模型

对于Logistics Regression 而言出去将结果通过sigmod函数映射之外 其余过程和线性回归完全一致。

对于Logistics Regression 而言决策的边界是线性的 即

P(y=1|w,x)=P(y=0|w,x)

Question 2

Logistics Regression 为什么使用sigmod函数 作为映射函数

sigmoid函数连续 单调递增

p’=p(1-p) 导数简单易求导

Question 3

为什么使用对数损失作为损失函数 为什么不适用最小二乘损失

通过最大化似然估计并取log得到的就是对数损失

对于最大似然损失而言 当预测值和真实值越接近时更新速度越慢 越远离更新速度越快

而对于最小二乘损失在预测值在0附近时几乎不会更新 当h=1/3时更新速度最快

Question 4

为什么正则化可以减轻过拟合

在经验风险最小化(训练误差最小化)的同时 采用尽可能简单的模型以提高泛化能力

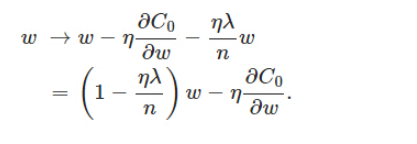

L2正则是在原始的损失函数后增加一项 (权重衰减 weight decay)

C=C0+λ/2n ∑ i ||w|| 2

对于C求偏导

因为n λ η 都是正数 所以和未经正则时相比具有缩小w的趋势

那么为什么使得w缩小就有正则化的效果呢

因为在过拟合的时候 为了拟合到每一个样本点 拟合曲线在较小的范围内震荡较为激烈 从而函数对于x的导数就会很大 即有些w就会变大 增加L2正则项 通过约束使得w不要过大 因此具有防止过拟合的效果

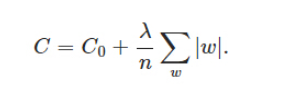

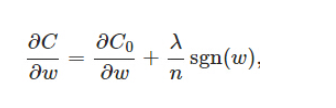

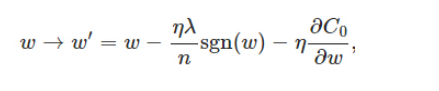

对于L1正则项

当w为正时 更新后变小 w为负时更新后变大 有向0靠拢的趋势

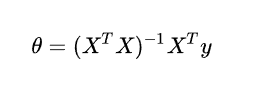

Question 5 线性回归和逻辑回顾的区别 以及线性回归的闭式解 以及线性回归的推导

线性回归处理回归问题 逻辑回归处理分类问题

逻辑回归中因变量是一个二元分别 学习到的结果为因变量的期望,基于此期望来处理预测分类问题

而线性回归是对真实关系的近似 处理回归问题

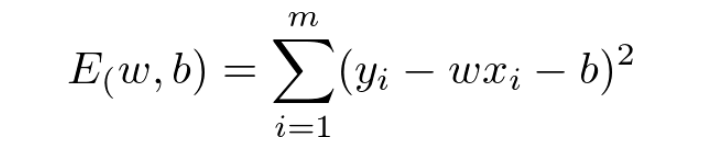

损失函数是一个凸函数 关于 w和b的导数都为0的时候可以取到最小值

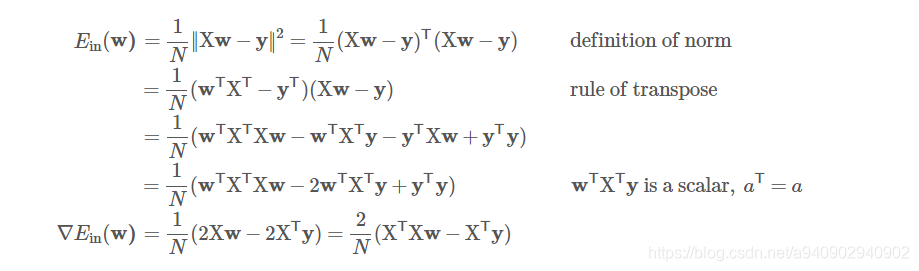

将上述方程写成矩阵形式(Y-Xw)T (Y-Xw) 求它对w的偏导数 在偏导数等于0的时候取得最小值

将上述矩阵形式展开可得 (YT - wTxT)(Y-Xw)

可得 YT Y-wTXTY-YTXw+wTXTXw

可以将上述式子看做w的二次方程

XTX是w的二次项

又因为wTXTy是一个标量 标量的转置和它本身一样

又因为是对w求导 所以写成wT的格式其参数就是导数

Question 6 LR处理多分类问题

Question 7 L1正则 坐标轴下降法

https://blog.csdn.net/a940902940902/article/details/84666746

https://blog.csdn.net/qq_32742009/article/details/81735274