目录

0 原理 1 OpenCV 中的 Harris 角点检测 2 亚像素级精确度的角点

0 原理

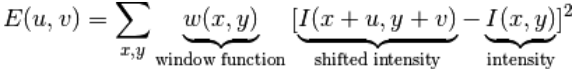

在上一节我们已经知道了角点的一个特性:向任何方向移动变化都很大。Chris_Harris 和 Mike_Stephens 早在 1988 年的文章《A Combined Corner and Edge Detector》中就已经提出了焦点检测的方法,被称为 Harris 角点检测。他把这个简单的想法转换成了数学形式。将窗口向各个方向移动(u,v)然后计算所有差异的总和。表达式如下:

窗口函数可以是正常的矩形窗口也可以是对每一个像素给予不同权重的高斯窗口

角点检测中要使 E (µ, ν) 的值最大。这就是说必须使方程右侧的第二项的取值最大。对上面的等式进行泰勒级数展开然后再通过几步数学换算(可以参 考其他标准教材),我们得到下面的等式:

其中

这里 Ix 和 Iy 是图像在 x 和 y 方向的导数。(可以使用函数 cv2.Sobel()计算得到)。

然后就是主要部分了。他们根据一个用来判定窗口内是否包含角点的等式进行打分。

![]()

其中

λ1 和 λ2 是矩阵 M 的特征值

所以根据这些特征中我们可以判断一个区域是否是角点,边界或者是平面。

当 λ1 和 λ2 都小时,|R| 也小,这个区域就是一个平坦区域。

当 λ1≫ λ2 或者 λ1≪ λ2,时 R 小于 0,这个区域是边缘

当 λ1 和 λ2 都很大,并且 λ1~λ2 中的时,R 也很大,(λ1 和 λ2 中的最 小值都大于阈值)说明这个区域是角点。

可以用下图来表示我们的结论:

所以 Harris 角点检测的结果是一个由角点分数构成的灰度图像。选取适当的阈值对结果图像进行二值化我们就检测到了图像中的角点。我们将用一个 简单的图片来演示一下。

1 OpenCV 中的 Harris 角点检测

Harris 角点检测函数:

cv2.cornerHarris(src, blockSize, ksize, k, dst, borderType)

- src:数据类型为float32的输入图像

- blockSize:角点检测中要考虑的领域大小

- ksize:Sobel求导中使用的窗口大小

- k:Harris 角点检测方程中的自由参数,取值参数为 [0,04,0.06].

- dst:目标图像

- borderType:边界类型

例如:

import cv2

import numpy as np

from matplotlib import pyplot as plt

def plot(img, n):

filename = img

img = cv2.imread(filename)

gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)

gray = np.float32(gray)

# 输入图像必须是 float32,最后一个参数在 0.04 到 0.05 之间

dst = cv2.cornerHarris(gray, 2, 3, 0.04)

# result is dilated for marking the corners, not important

dst = cv2.dilate(dst, None)

# Threshold for an optimal value, it may vary depending on the image.

img[dst > 0.005*dst.max()] = [255, 0, 0]

plt.subplot(1, 3, n), plt.imshow(img, cmap='gray'),

plt.title('dst'), plt.axis('off')

plot('test30.jpg', 1)

plot('test30_1.jpg', 2)

plot('test30_2.jpg', 3)

plt.show()

结果如下:

2 亚像素级精确度的角点

有时我们需要最大精度的角点检测。OpenCV为我们提供了函数cv2.cornerSubPix(), 它可以提供亚像素级别的角点检测。下面是一个例子。首先我们要找到 Harris 角点,然后将角点的重心传给这个函数进行修正。Harris 角点用红色像素标出,绿色像素是修正后的像素。在使用这个函数是我们要定义一个迭代停止条件。当迭代次数达到或者精度条件满足后迭代就会停止。我们同样需要定义进行角点搜索的邻域大小。

ret, labels, stats, centroids = cv2.connectedComponentsWithStats(image, connectivity, ltype)

- image:8位单通道图像

- labels:输出标签

- stats:Nx5的矩阵(CV_32S):[x0, y0, width0, height0, area0; ... ; x(N-1), y(N-1), width(N-1), height(N-1), area(N-1)]

- centroids:Nx2 质心矩阵(CV_64F ): [ cx0, cy0; ... ; cx(N-1), cy(N-1)]

- connectivity:默认为8,4- or 8-connected components

- ltype:默认为CV_32S,标签类型 (CV_32S or CV_16U)

cv2.cornerSubPix(image, corners, winSize, zeroZone, criteria)

- image:输入图像

- corners:角点的初始坐标

- winSize:搜索窗口边长的一半

- zeroZone:搜索区域中间的dead region边长的一半

- criteria:迭代过程的终止条件

例如:

import cv2

import numpy as np

filename = 'test30_3.jpg'

img = cv2.imread(filename)

gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)

gray = np.float32(gray)

dst = cv2.cornerHarris(gray, 2, 3, 0.04)

dst = cv2.dilate(dst, None)

ret, dst = cv2.threshold(dst, 0.01*dst.max(), 255, 0)

dst = np.uint8(dst)

ret, labels, stats, centroids = cv2.connectedComponentsWithStats(dst)

# 定义一个标准去停止迭代

criteria = (cv2.TERM_CRITERIA_EPS + cv2.TERM_CRITERIA_MAX_ITER, 100, 0.001)

# 返回值由角点坐标组成的一个数组(而非图像)

corners = cv2.cornerSubPix(gray, np.float32(centroids), (5, 5), (-1, -1), criteria)

res = np.hstack((centroids, corners))

# np.int0 可以用来省略小数点后面的数字(非四舍五入)。

res = np.int0(res)

img[res[:, 1], res[:, 0]] = [0, 0, 255]

img[res[:, 3], res[:, 2]] = [0, 255, 0]

cv2.imwrite('subpixe.png', img)结果如下:

可以看出绿色比红色更加精确