下面都是我目前的理解,可能有不正确的地方,欢迎指正。

方差----数据分散程度----区分度

Linear Discriminant Analysis, LDA,线性判别分析

LDA降维的目标:将带有标签的数据降维

出处:https://blog.csdn.net/liuweiyuxiang/article/details/78874106LDA的思想可以用一句话概括,就是“投影后类内方差最小,类间方差最大”

出处:http://www.cnblogs.com/pinard/p/6244265.html

也是用于降维,与PCA的区别是PCA不考虑类别信息,他要找的基是特征的协方差最大的方向,通过协方差矩阵按特征向量特征值分解;线性判别分析需要考虑类别信息,一个类别求一个平均值,不同类别投影到的基,通俗点说,就是不要重叠,要有区分,另一方面就是同一类向量投影到基后要尽量聚合。(具体推到过程要另写一篇)

参考:http://www.cnblogs.com/pinard/p/6244265.html

Latent Dirichlet Allocation,LDA,隐含狄利克雷分布,属于文档主题模型

to do

我目前知道的一点东西是:隐含Dirichlet分布是基于贝叶斯模型的,现在有的是M篇文档,分词后,可以得到文档-词对应的矩阵,最后是要把这个矩阵‘分解’为两个矩阵,都是概率矩阵,文档-主题矩阵和主题-词概率矩阵。

贝叶斯模型是先对参数做一个先验假设,这里参数的概率假设是Dirichlet分布,然后根据文档中词(这就是事实)对假设进行修正,最后得出文档属于某个主题的概率,和每个主题下有什么词的概率。

(我目前只知道这些,具体如何对参数修正我还没看明白,to do)

PCA

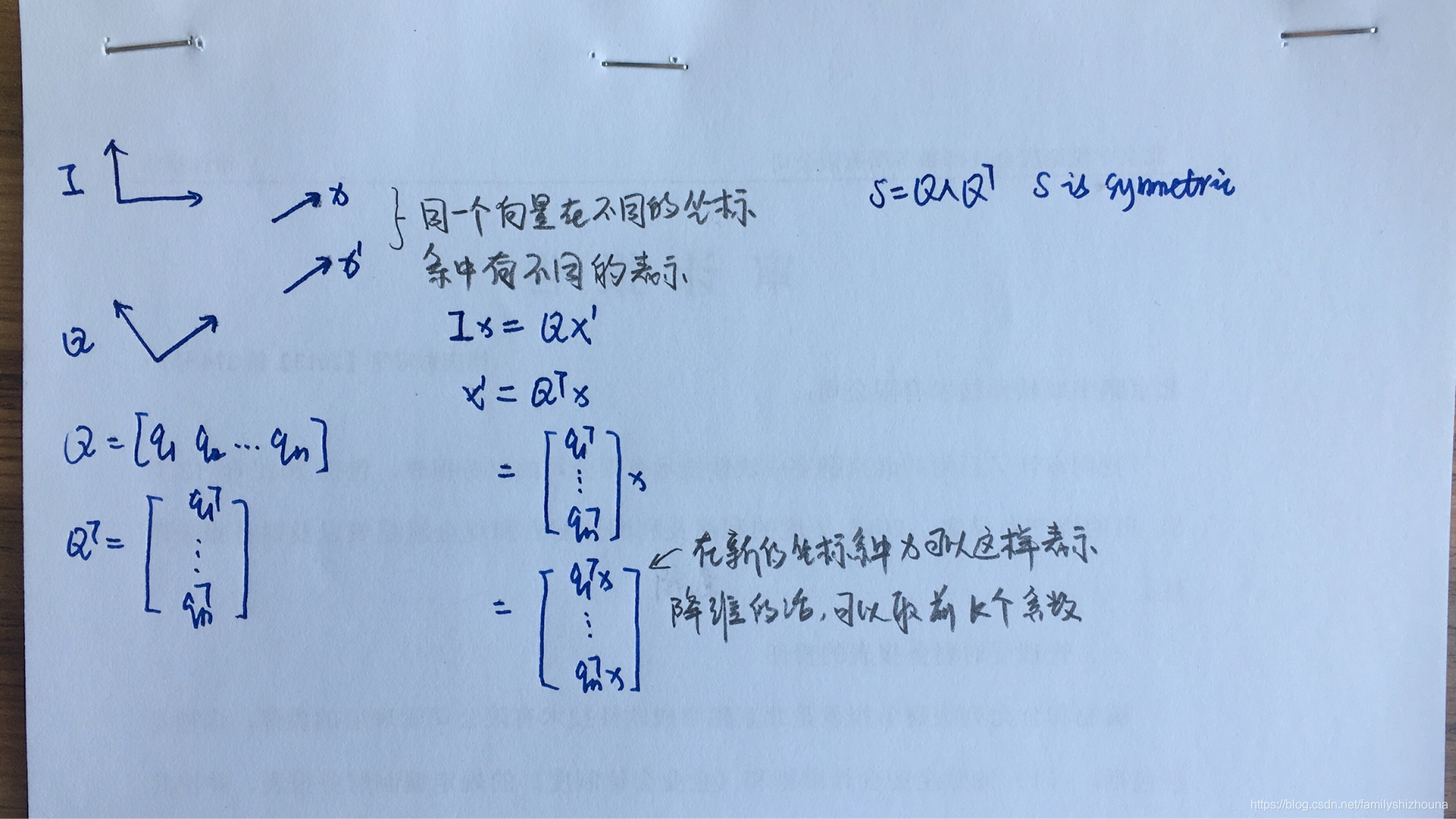

PCA是Principle Component Analysis,主成分分析。可以用于对向量降维。他降维的原理,并不是说从目前的几个维度中选择几个维度。而是按特征值,特征向量进行矩阵分解后,选择几个特征值大的维度(特征向量的方向)。也就是选择另外一组基,然后按照变量在这组基上变换大小,选取basis。被分解的矩阵是目前变量的协方差矩阵,协方差矩阵是对称的,他一定可以分解为这样的形式:

为什么可以这样降维,我的理解是矩阵

是根据你的数据,也就是特征的协方差矩阵来的,他代表了特征的性质,特征在哪些维度上比较活跃,前几个维度最能代表特征的变化,有的维度,特征值特别小,那投影到这个维度的值也很小。也可以在原来的标准基上取一些维度,但在标准基上,各个方向(basis)变化幅度是一样的,信息量是一样的。但在特征值大的特征向量上他含的信息是多的。(好像说的也不是很清楚,暂时就这样吧)。

scikit-learn中有实现。

参考:https://blog.csdn.net/HLBoy_happy/article/details/77146012

PCA降维的目标:将数据投影到方差最大的几个相互正交的方向上。

这句话摘自:https://blog.csdn.net/liuweiyuxiang/article/details/78874106

说到这里顺便说一下图像压缩,一张图片可以用一个矩阵表示,如果要对图像进行压缩,简单的压缩可以取一块小矩阵用一个值表示,这样压缩的坏处是,丢失信息,图像看起来blockly,比较好的压缩方式是通过奇异值分解SVD,原理同PCA差不多,也是变换基,然后取特征值比较大基,这样能尽量少的丢失信息量。

图片所有的信息存在A中,用

个数表示,现在可以用

表示,用

个数表示。

SVD

(上面已经顺便说了一部分)

我看吴军老师的《数学之美》里面15章 矩阵运算和文本处理中的两个分类问题,这一章是讲奇异值分解的应用,老师讲的我没完全看明白,我自己的理解是,词-文章的矩阵进行奇异值分解后,第一个矩阵是关于词的,第二个矩阵是关于文章的,词向量本来是m维的,与PCA思想是一样的,没有什么高深的玄学,就是按特征向量把词进行了压缩,词由原来的m维变为了r维,同理文章由n维,变为两r维,近义词就可以基于向量相似度用聚类算法来计算,同理文章也是。这就是书中的结论“只要对关联矩阵A进行一次奇异值分解,就可以同时完成近义词分类和文章的分类”。

参考:https://www.cnblogs.com/LeftNotEasy/archive/2011/01/19/svd-and-applications.html