1.Classification

Logistic Regression其实就是Classification,但是由于历史原因名字被记作了逻辑回归。它与线性回归的区别在于

其中:

此时我们的假设函数

2.Cost Function

线性回归中的损失函数是:

其中:

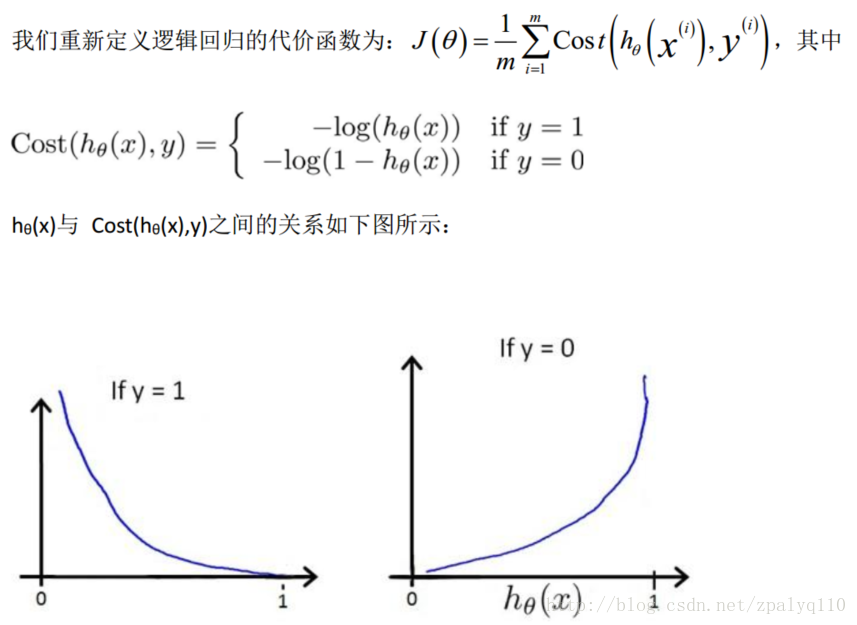

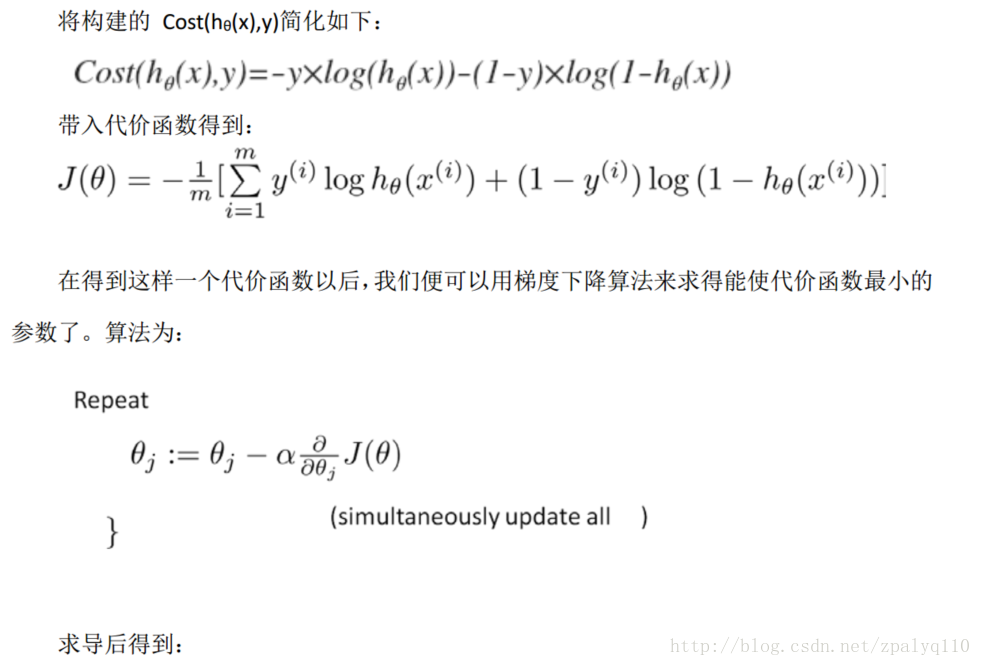

线性回归损失函数有很明显的实际意义,就是平方损失。而逻辑回归却不是,它的预测函数

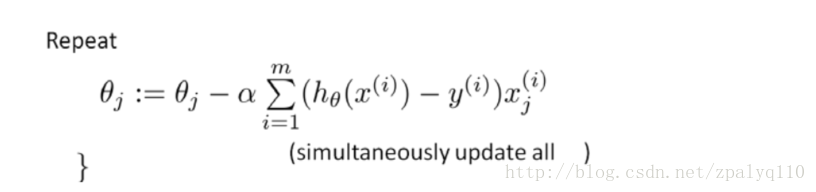

注: 虽然得到的梯度下降算法表面上看上去与线性回归的梯度下降算法一样, 但是这里的

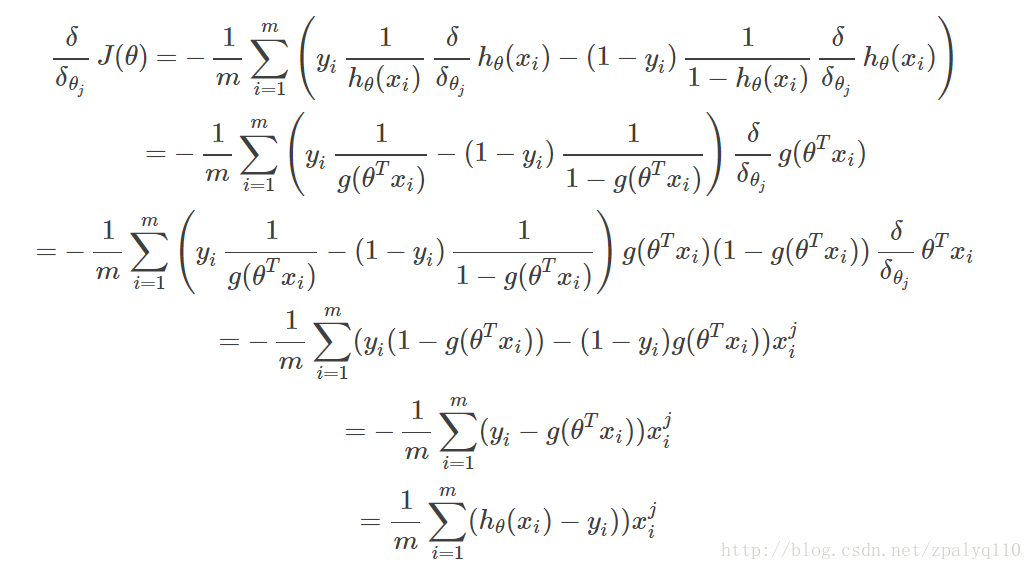

具体求导公式的推导:

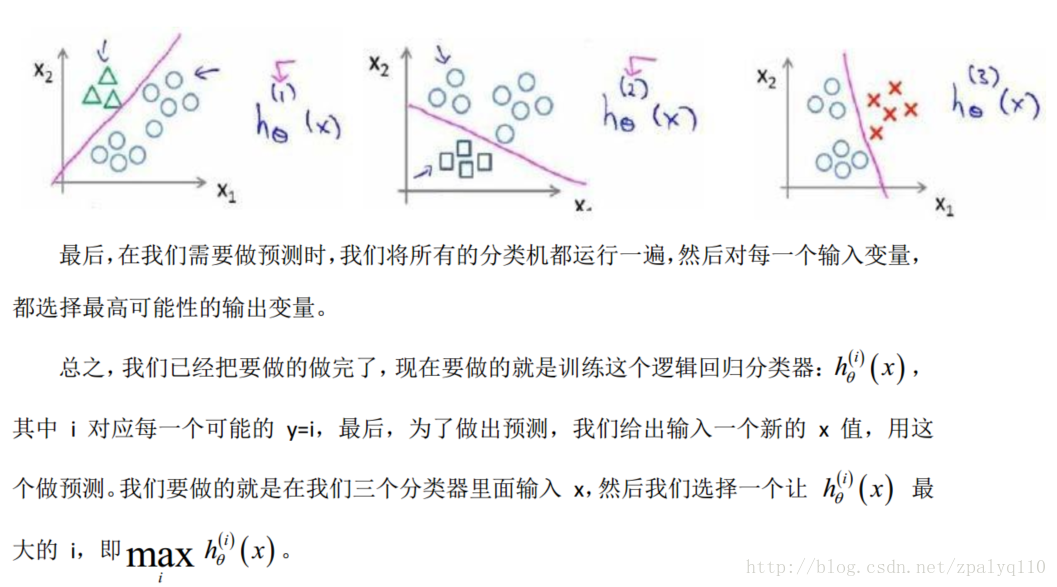

3.Multiclass Classification-One-vs-all

4.Regularization

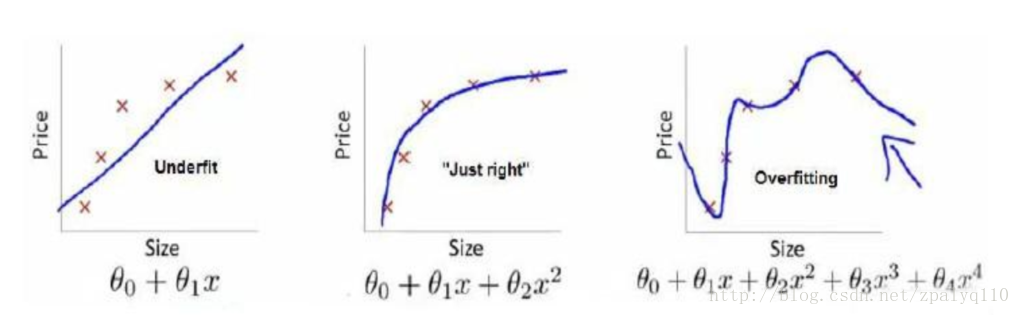

线性回归中的Overfitting与Underfitting:

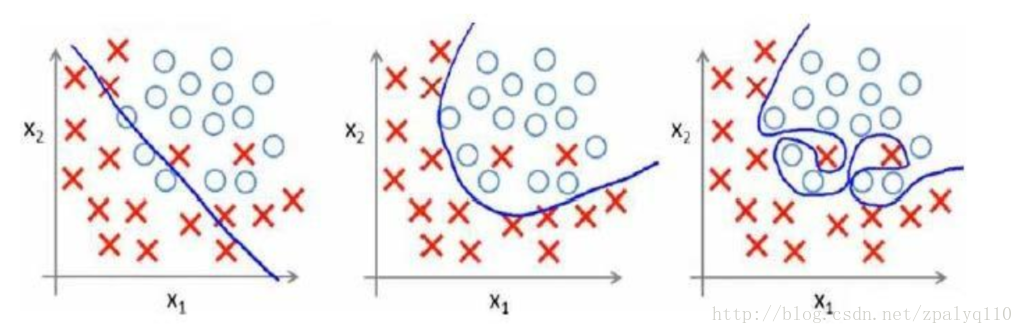

逻辑回归中的Overfitting与Underfitting:

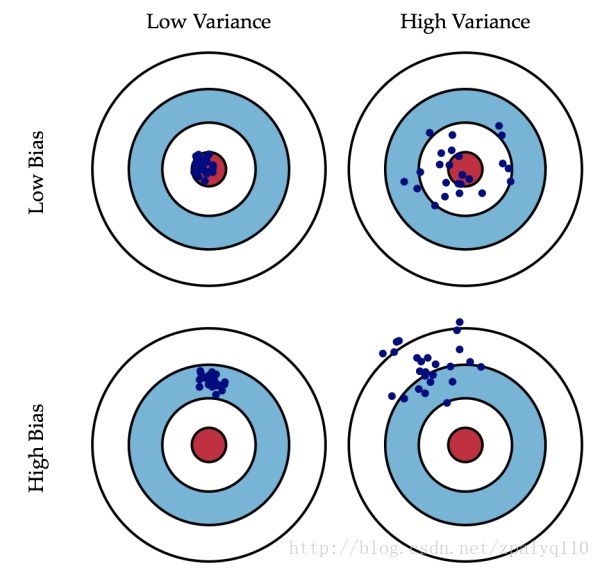

Overfitting:高偏差

Underfitting:高方差

下图很直观的展现出偏差与方差的区别:

怎么来解决过拟合的问题?简单来说造成过拟合是因为次数高的项存在,那么只要减小相应的系数

对于线性回归:

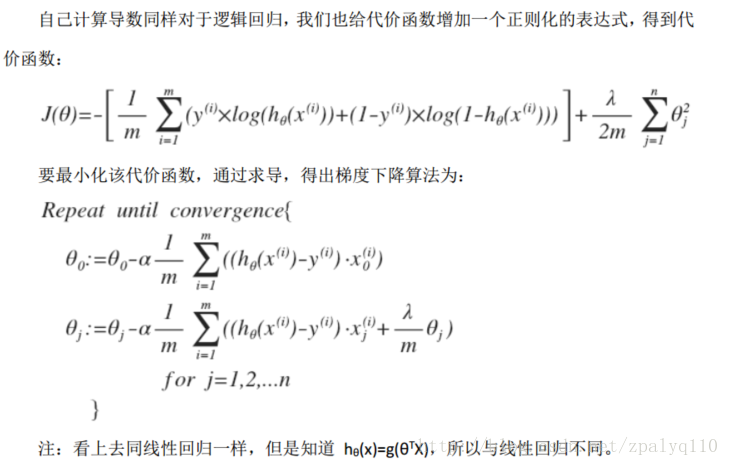

对于逻辑回归: