第1课__神经网络和深度学习__第2周__神经网络基础

=======================

目录

2.1 二分分类

2.2 logistic回归

2.3 logistic回归代价函数

2.4 梯度下降法

2.5 导数

2.6 更多导数的例子

2.7 计算图

2.8 计算图的导数计算

2.9 logistic回归中的梯度下降

2.10 m个样本的梯度下降

2.11 向量化

2.12 向量化的更多例子

2.13 向量化logistic回归

2.14 向量化logistic回归的梯度输出

2.15 python中的广播

2.16 关于Python/numpy向量的说明

2.17

=======================

2.1 二分分类

logistic回归一般用来解决二分分类问题。二分分类问题的输出y有两个值是{0,1}。下面以图像识别猫为例来说明:

- 输入:x=图片

- 输出:是否是猫,y=1是猫,y=0不是猫

简单以见,假设输入图片宽高是64pixels * 64pixels。在计算机中,一张彩色图片是怎样存储的呢?

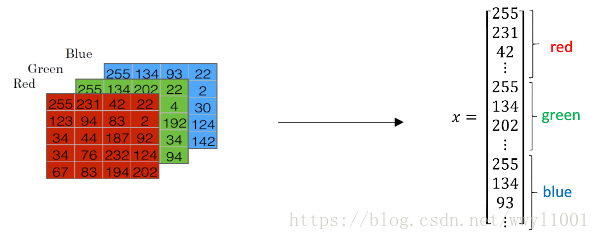

一张彩色图片包含RGB3个色彩通道。以上图为例,该图片尺寸为64 * 64 * 3。在神经网络中,通常是将输入图片转换成一维特性向量来表示,转换过程如下图:

转换后的特性向量维度是(12288,1),它是列向量,维度一般记为nx,nx=12288

如果训练样本有m张图片,那么将整个训练样本组成输入矩阵,维度是(nx,m)。这里m表示样本数目,nx表示一个样本中特性个数。输出矩阵y的维度是(1,m)。

2.2 logistic回归

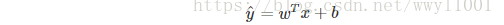

二分分类的输出y取值{0,1},logistic回归的预测值

引入参数:权重w,维度是(nx,1); 偏置常量b

logistic回归的线性预测可以表示为:

上式的输出范围是整个实数集,而logistic回归的输出是在区间[0, 1],可以用sigmoid函数把输出“压缩”在[0, 1]区间内。

综上,logistic回归的预测输出可以表示为:

其实,logistic回归就是线性回归的“逻辑化”。

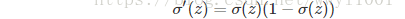

Sigmoid函数有一个非常好的特性:它的一阶导数可以用其自身表示:

2.3 logistic回归代价函数

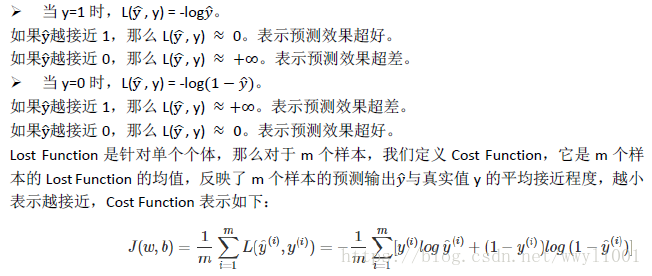

在神经网络中,我们的目标是学习一个关于参数w和b的预测模型。怎样确定参数w和b呢?我们需要定义一个cost function(它表示预测值与真实值的差距),当cost function取最小值时,就确定了参数w和b。

对于m个训练样本,(x(i),y(i))表示第i个样本。

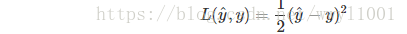

先来看一下单个样本的代价函数,一般损失函数(Lost function)。我们希望预测值与真实值非常接近,对于回归问题的损失函数,通过用平方差来表示:

对于逻辑回归,一般不用平方差做为损失函数,因为它是非凸的(non-convex),非凸函数存在多个极小值,所以在运用梯度下降时,易达到局部最优,我们的目标是全局最优。

逻辑回归的损失函数一般用下式表示:

。